Table of Contents generated with DocToc

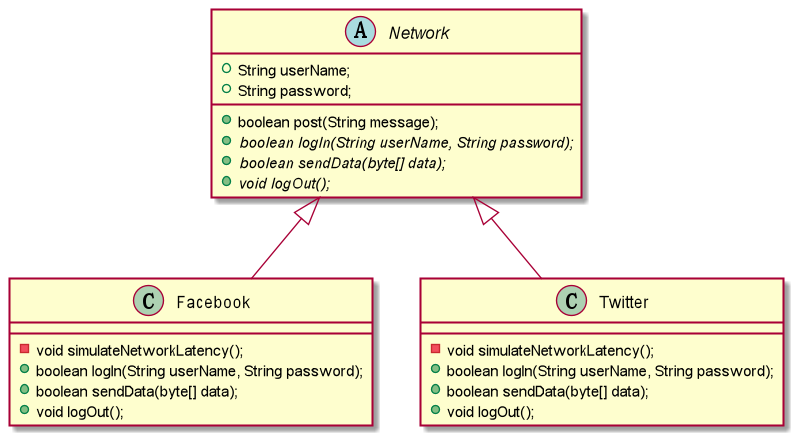

- 1 设计模式

- 2 多线程

- 2.1 多线程基础

- 2.2 JUC

- 2.2.1 基础巩固

- 2.2.2 JUC生产者消费者

- 2.2.3 Condition精准通知和唤醒

- 2.2.4 锁的本质

- 2.2.5 集合类不安全

- 2.2.6 Collable多线程

- 2.2.7 常用辅助类

- 2.2.8 ReadWriteLock读写锁

- 2.2.9 阻塞队列

- 2.2.10 线程池

- 2.2.11 四大函数式接口

- 2.2.12 Stream流式计算

- 2.2.13 ForkJoin

- 2.2.14 异步回调

- 2.2.15 JMM

- 2.2.16 volatile

- 2.2.17 单例模式

- 2.2.18 深入理解CAS

- 2.2.19 原子引用解决ABA问题

- 2.2.20 各种锁的理解

- 2.2.21 关于中断

- 2.3 并发编程实战

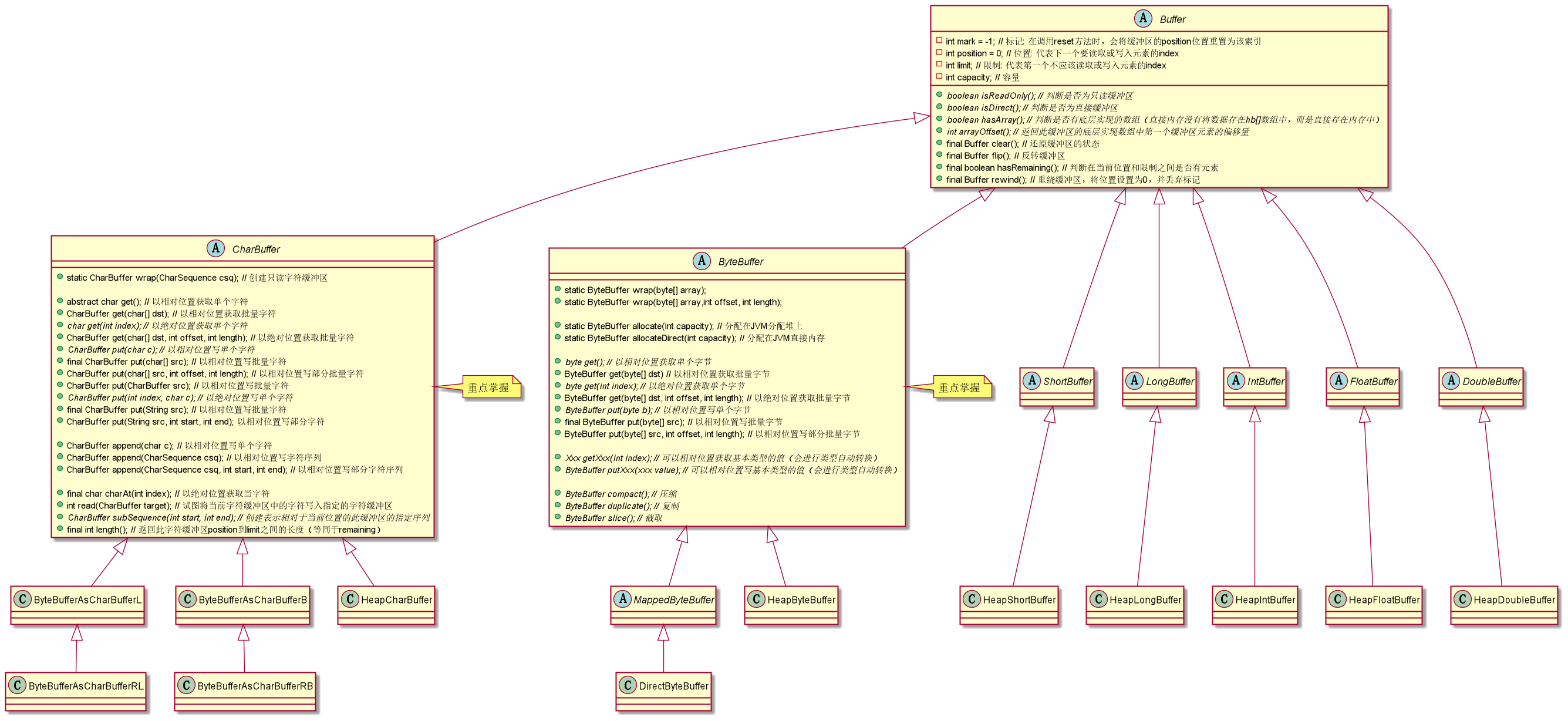

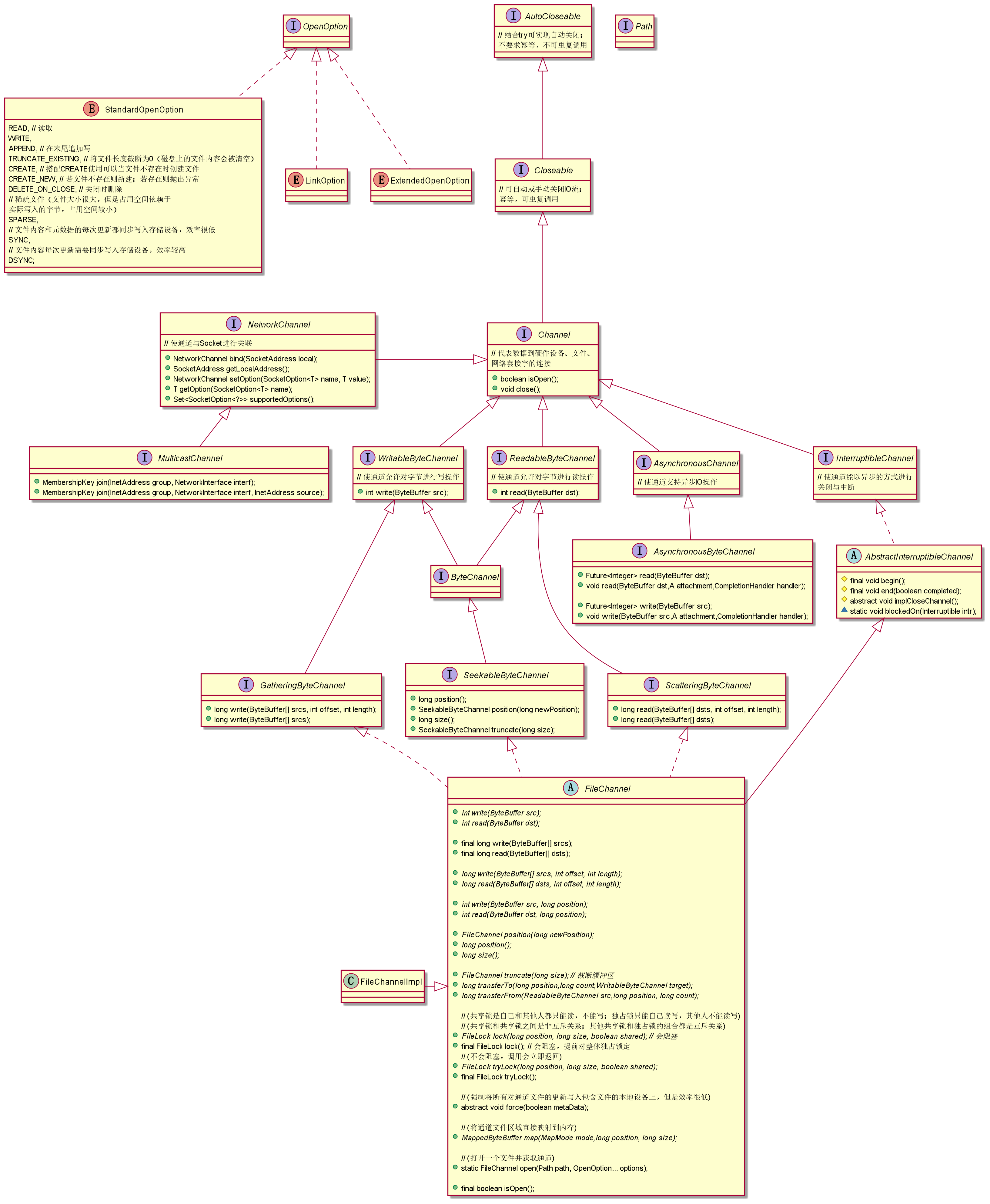

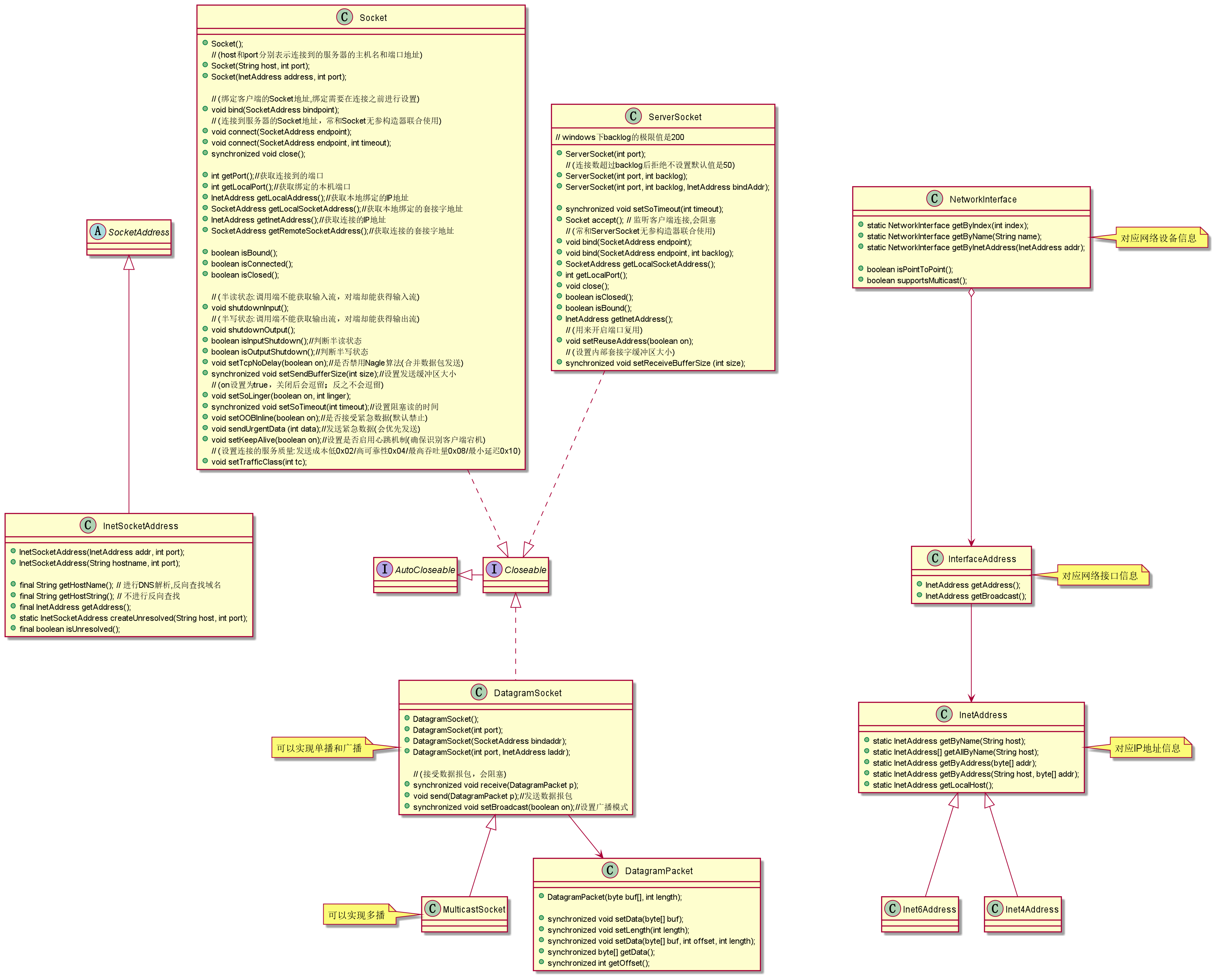

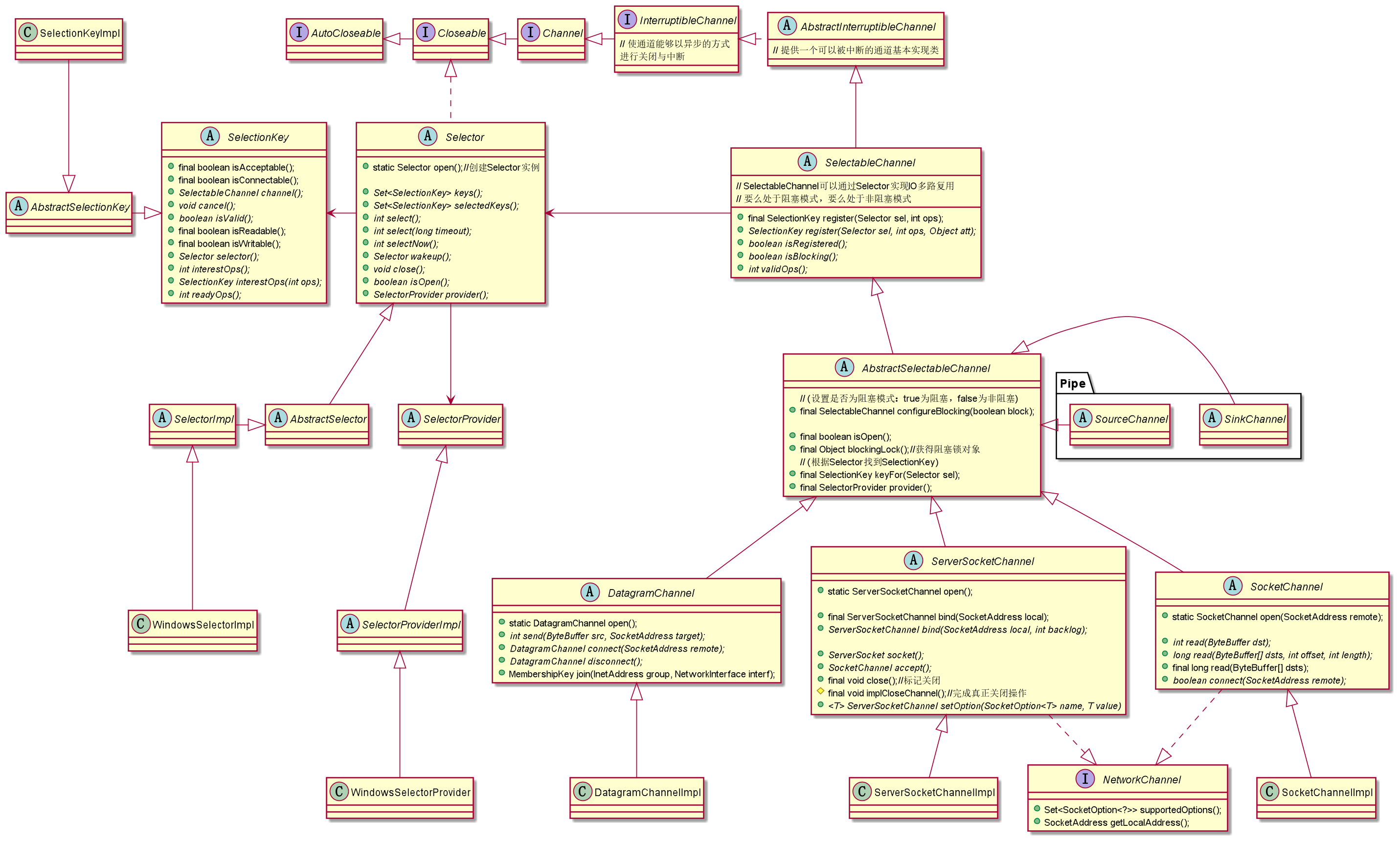

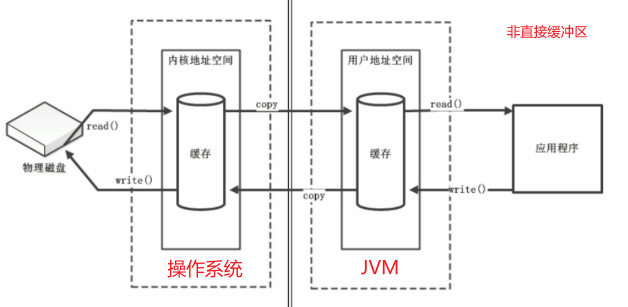

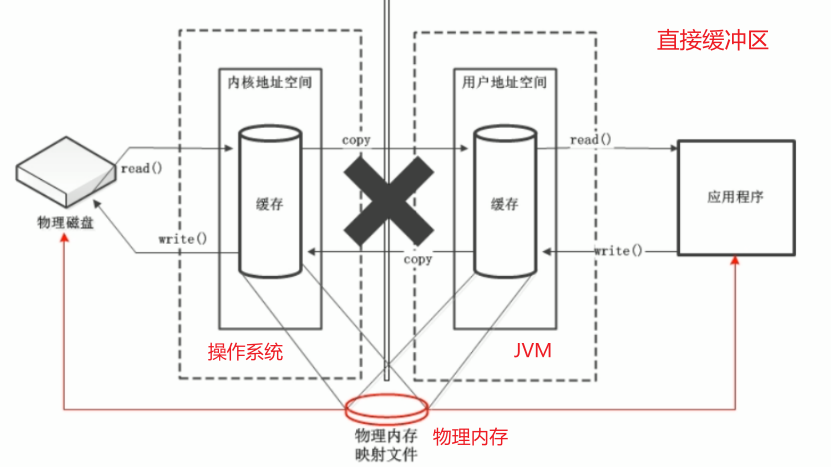

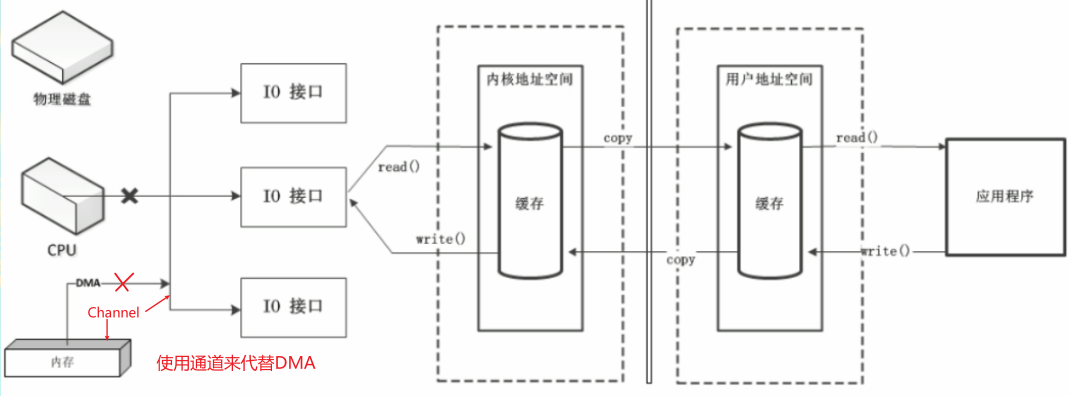

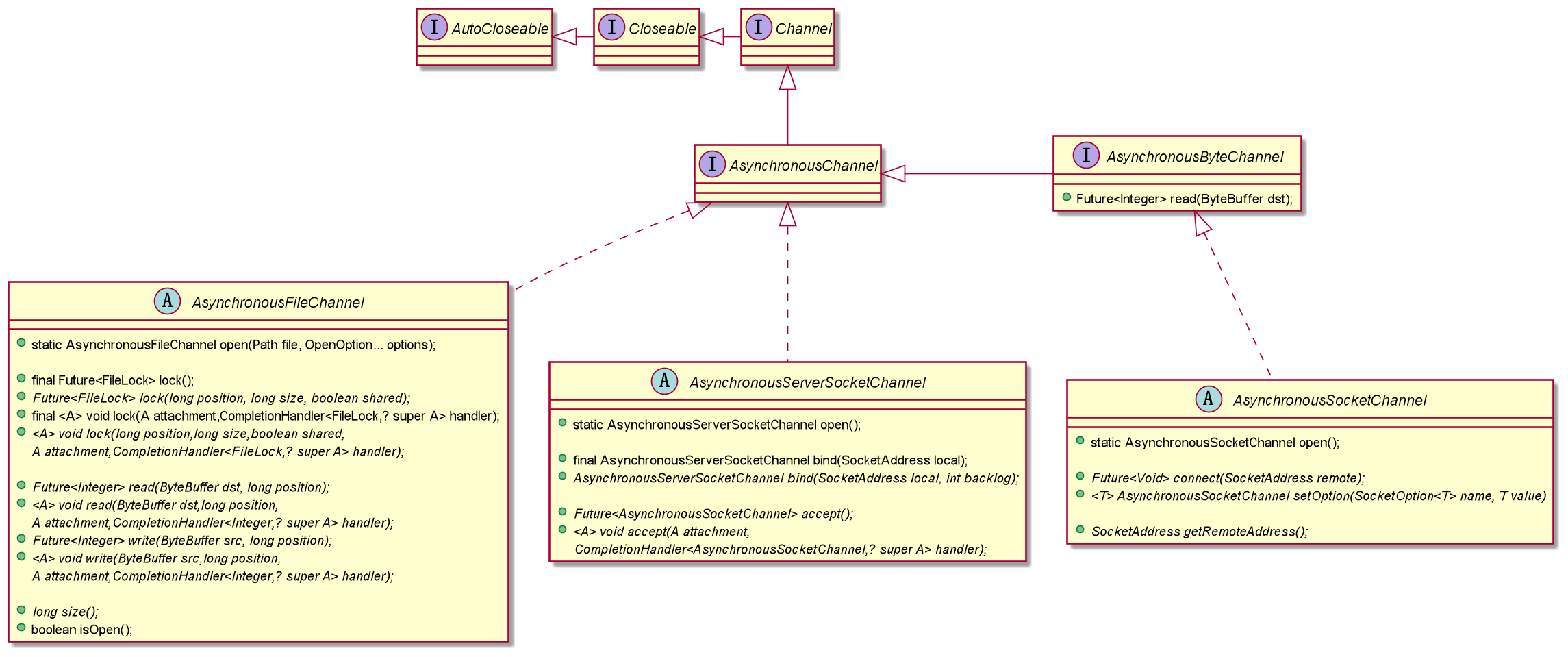

- 3 BIO/NIO/AIO

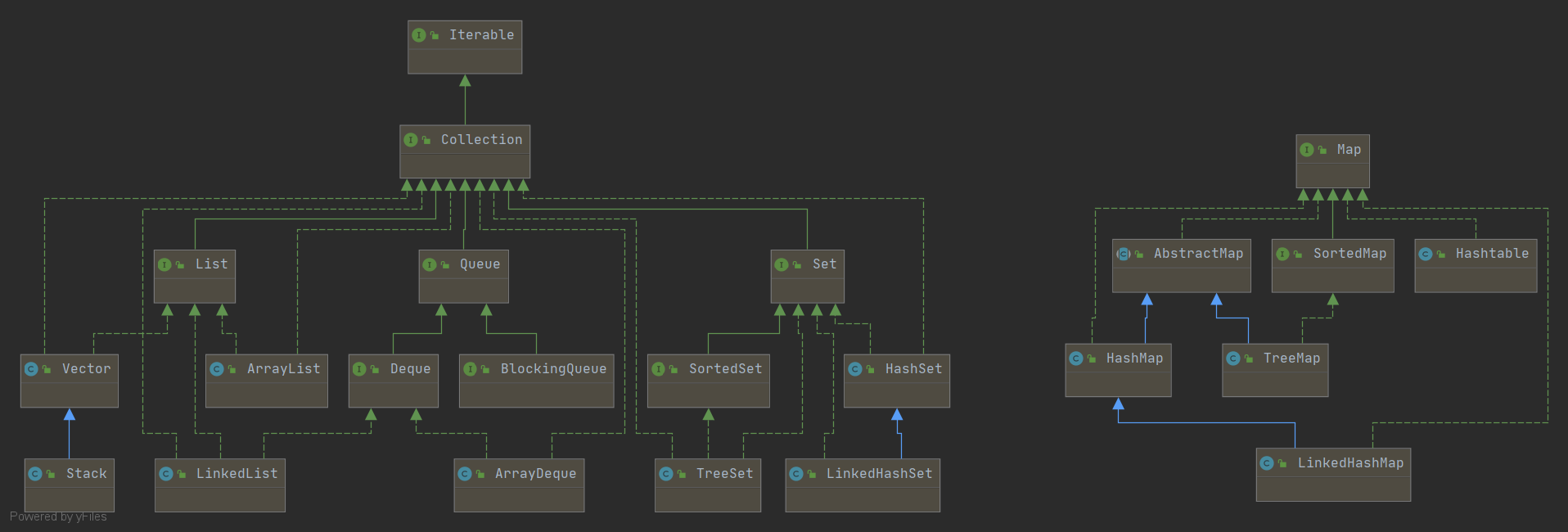

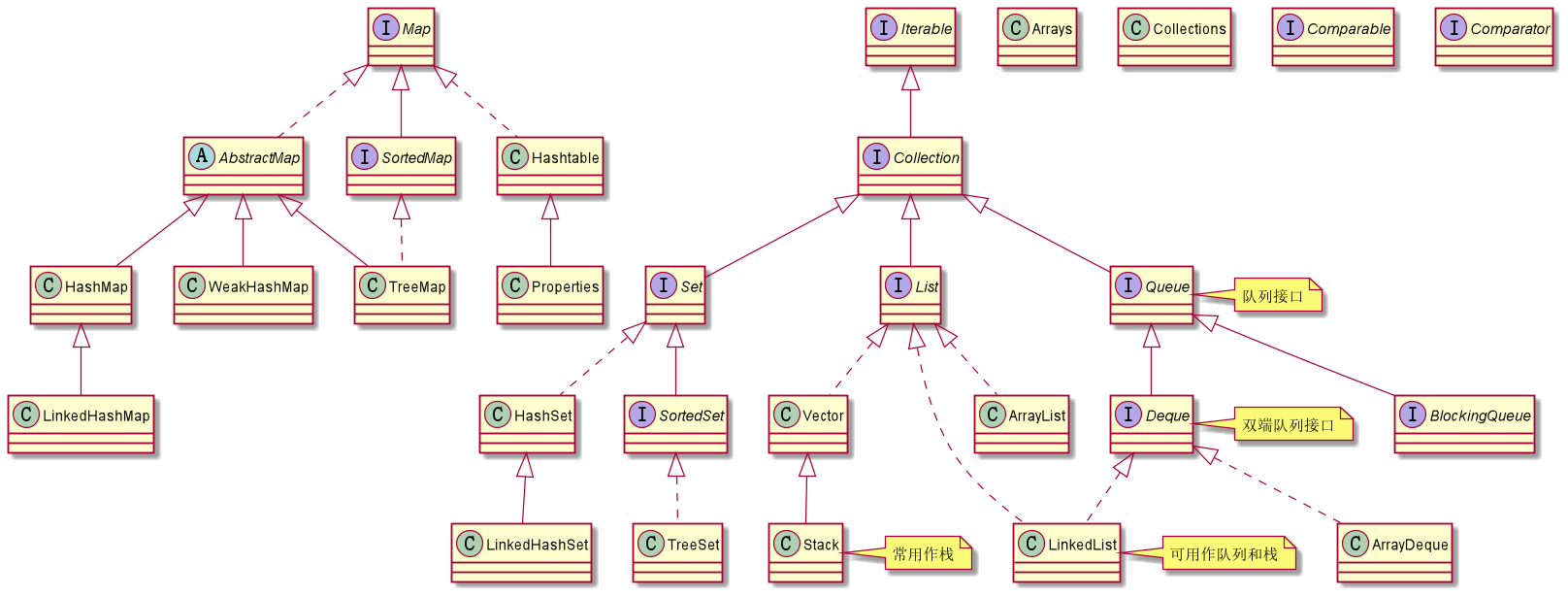

- 4 集合源码

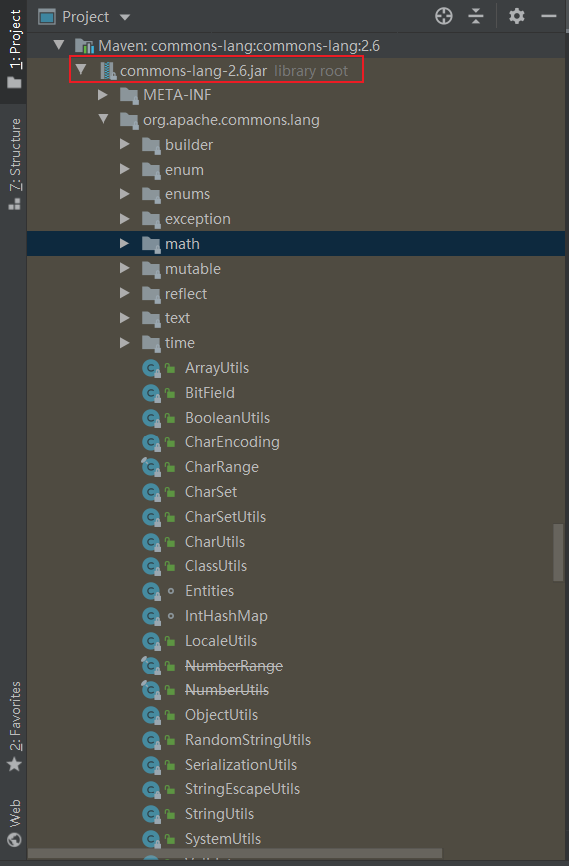

- 5 常用的工具类/包

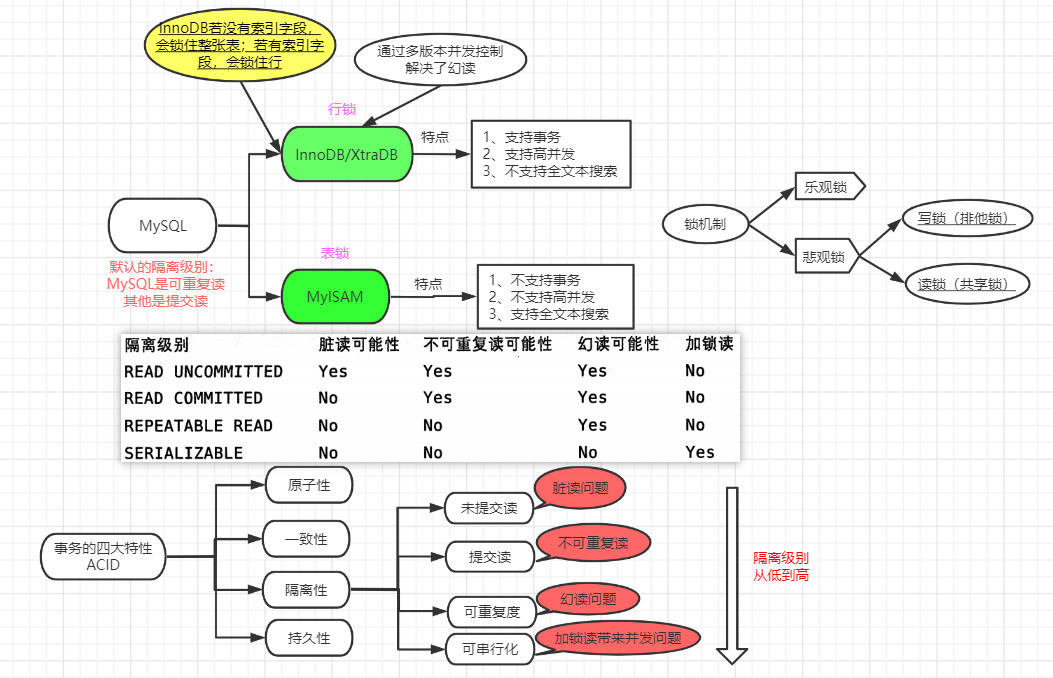

- 6 MySQL提高

- 6.1 MySQL基础巩固

- 6.1.1 DISTINCT

- 6.1.2 LIMIT

- 6.1.3 完全限定.

- 6.1.4 ORDER BY

- 6.1.5 where过滤

- 6.1.6 LIKE+通配符

- 6.1.7 正则表达式搜索

- 6.1.8 计算字段

- 6.1.9 使用数据处理函数

- 6.1.10 汇总函数

- 6.1.11 分组数据

- 6.1.12 使用子查询

- 6.1.13 联结表

- 6.1.14 组合查询

- 6.1.15 全文本搜索("索引")

- 6.1.16 插入数据

- 6.1.17 更新和删除数据

- 6.1.18 创建和操作表

- 6.1.19 使用视图("虚拟表")

- 6.1.20 使用存储过程("函数")

- 6.1.21 使用游标

- 6.1.22 使用触发器

- 6.1.23 管理事务

- 6.2 MySQL性能优化

- 6.2.1 并发控制的锁策略

- 6.2.2 事务的ACID

- 6.2.3 事务的隔离级别

- 6.2.4 多版本并发控制(MVCC)

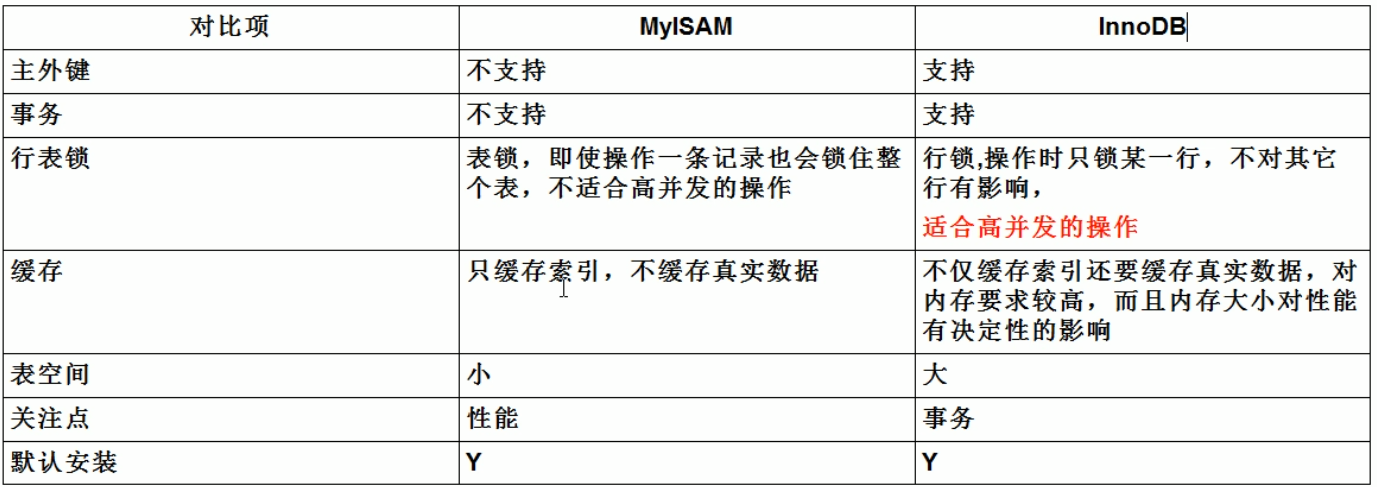

- 6.2.5 MySQL的存储引擎

- 6.2.6 库表结构优化

- 6.2.7 索引优化

- 6.2.8 查询优化

- 6.3 SQL笔试题

- 6.4 中间件MyCat

- 6.1 MySQL基础巩固

- 7 分布式微服务

- 7.1 SpringCloud

- 7.1.1 项目模块的创建

- 7.1.2 RestTemplate

- 7.1.3 Hutool工具包

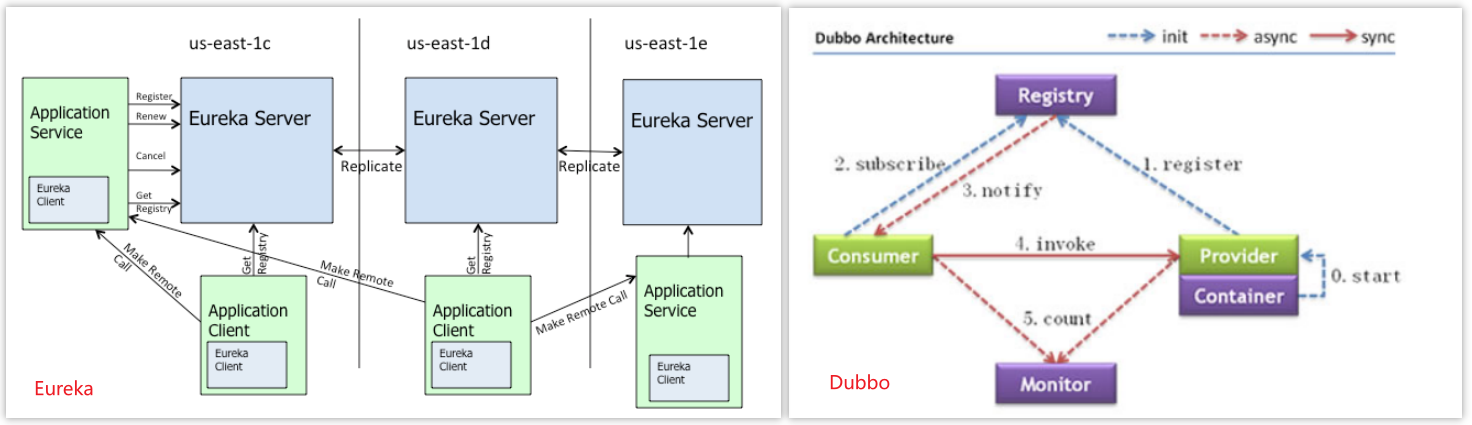

- 7.1.4 Eureka服务注册与发现

- 7.1.5 Zookeeper服务注册与发现

- 7.1.6 Consul服务注册与发现

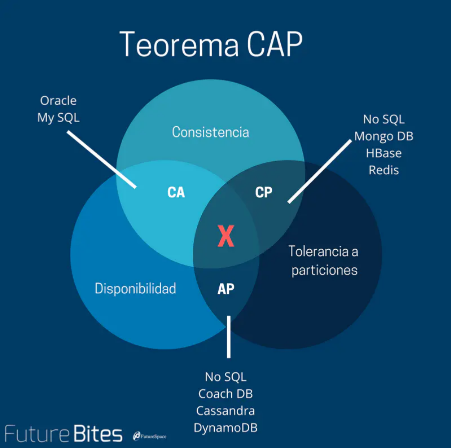

- 7.1.7 三个注册中心的异同点

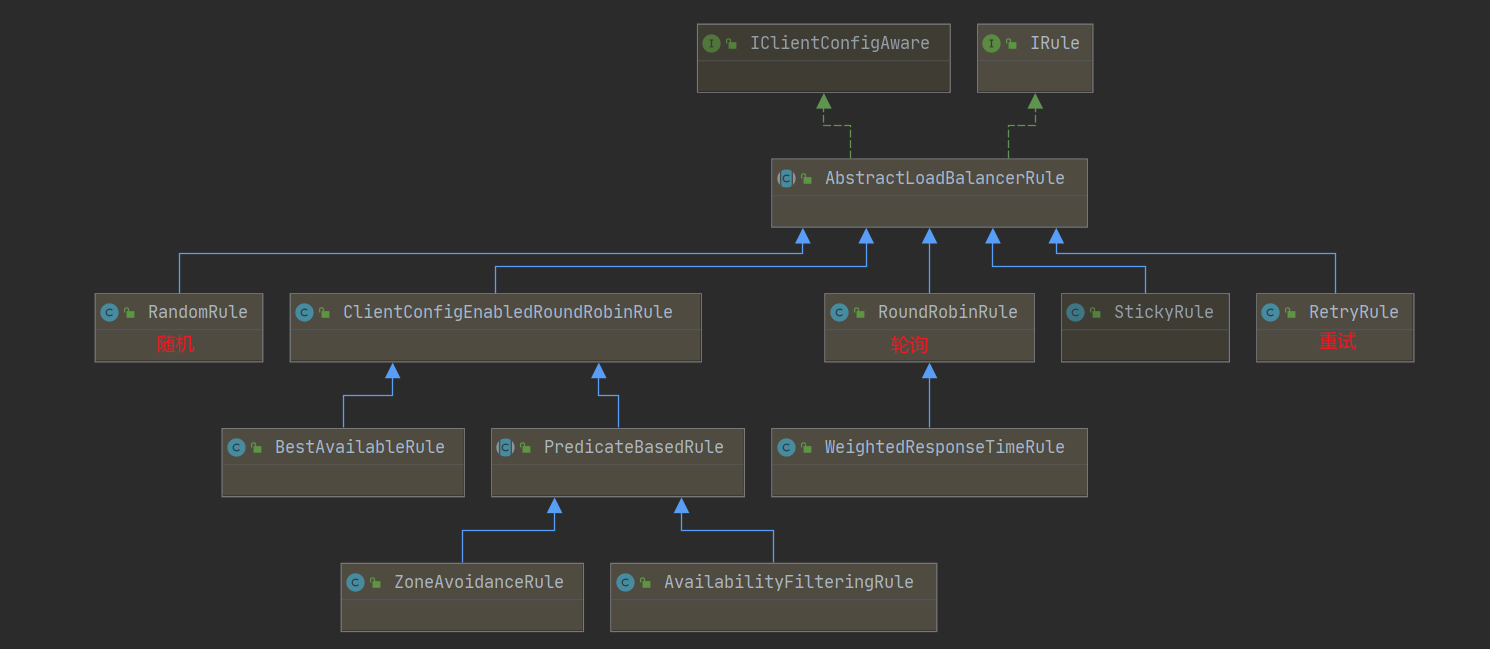

- 7.1.8 Ribbon负载均衡服务调用

- 7.1.9 OpenFeign服务调用

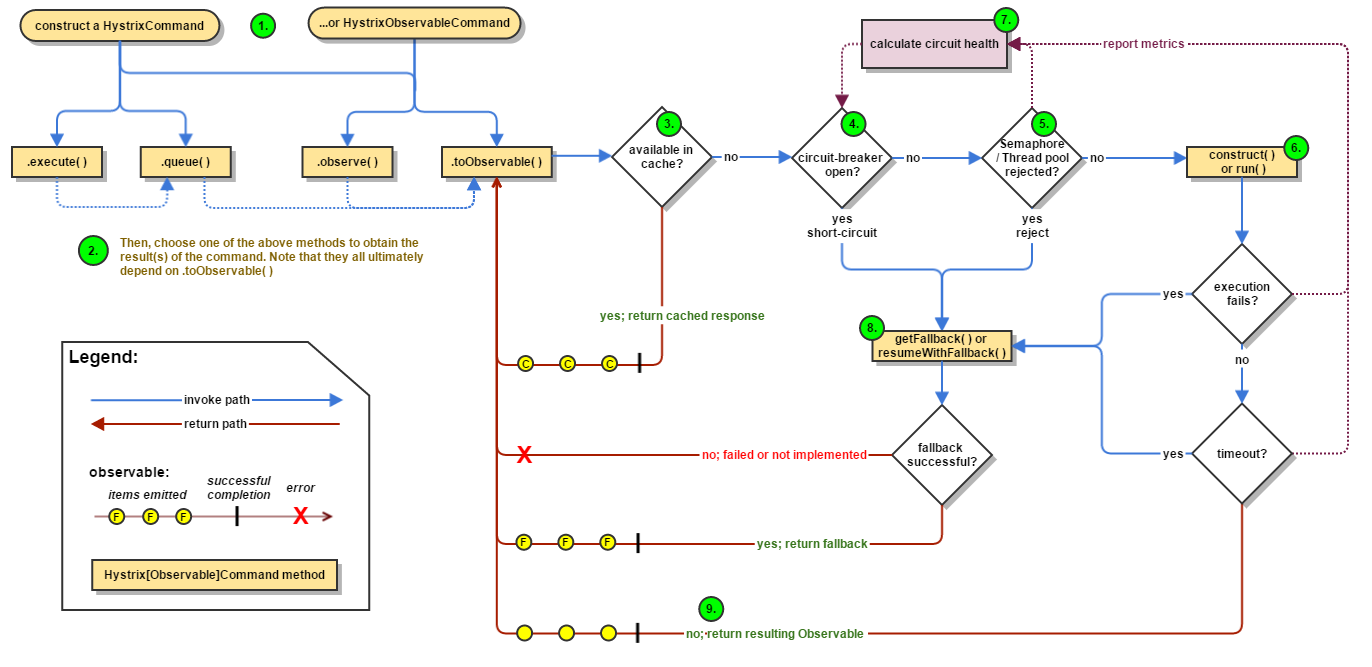

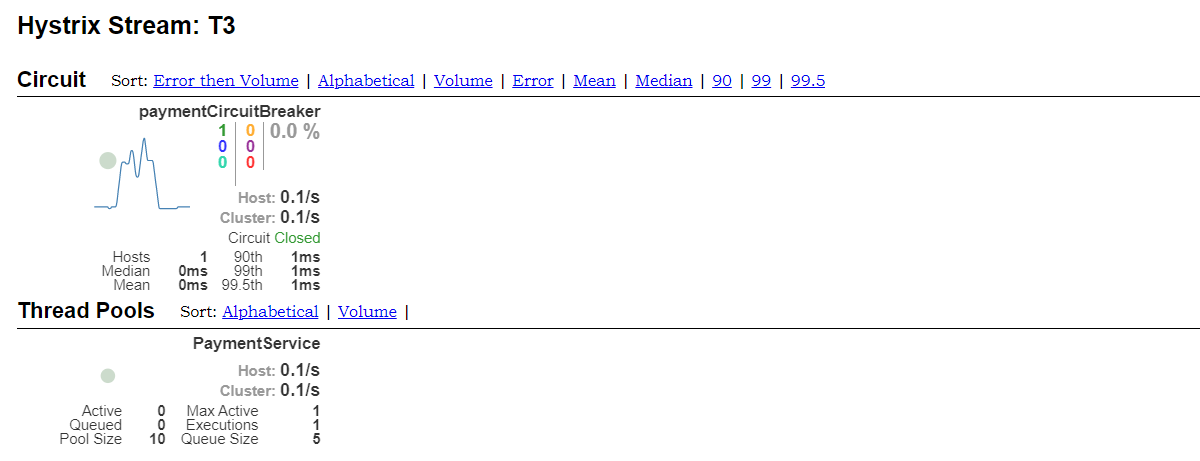

- 7.1.10 Hystrix服务降级/熔断/限流

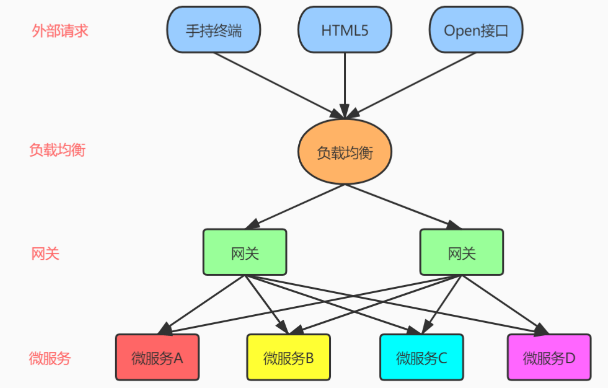

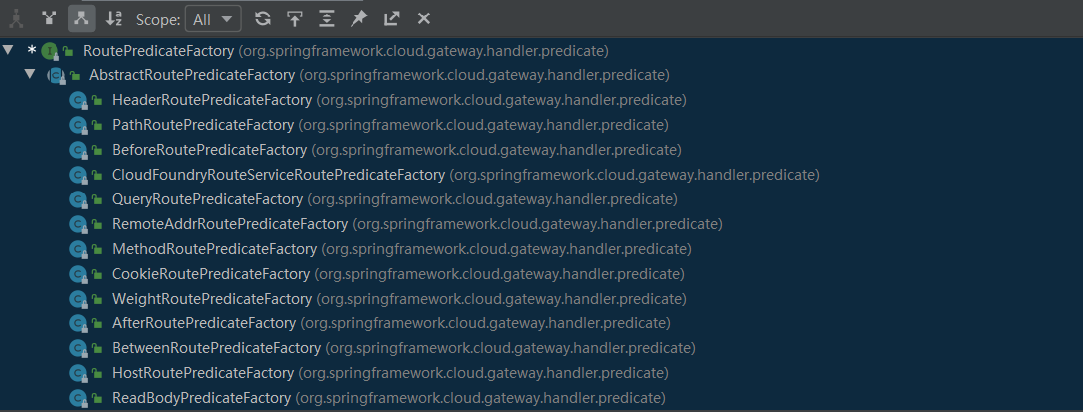

- 7.1.11 Gateway网关

- 7.1.12 Config分布式服务配置

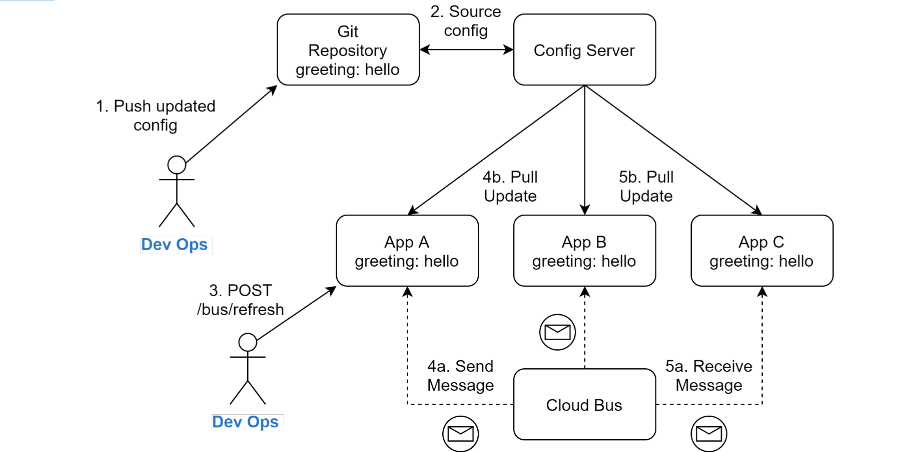

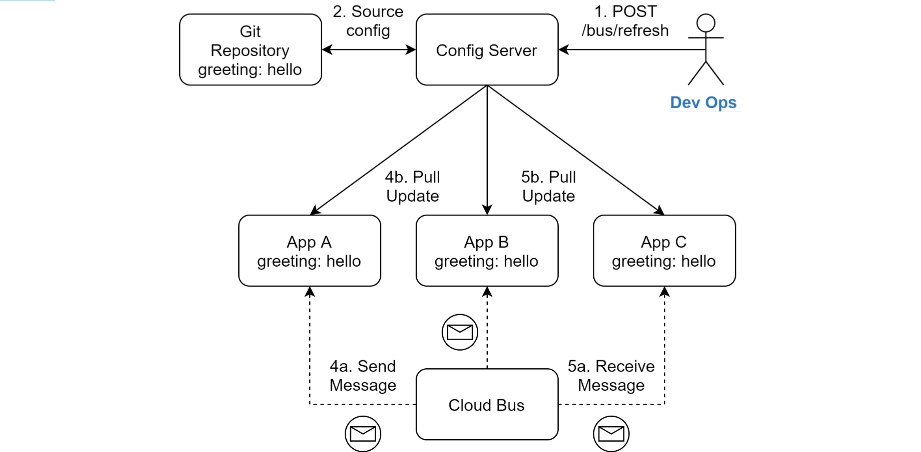

- 7.1.13 Bus消息总线

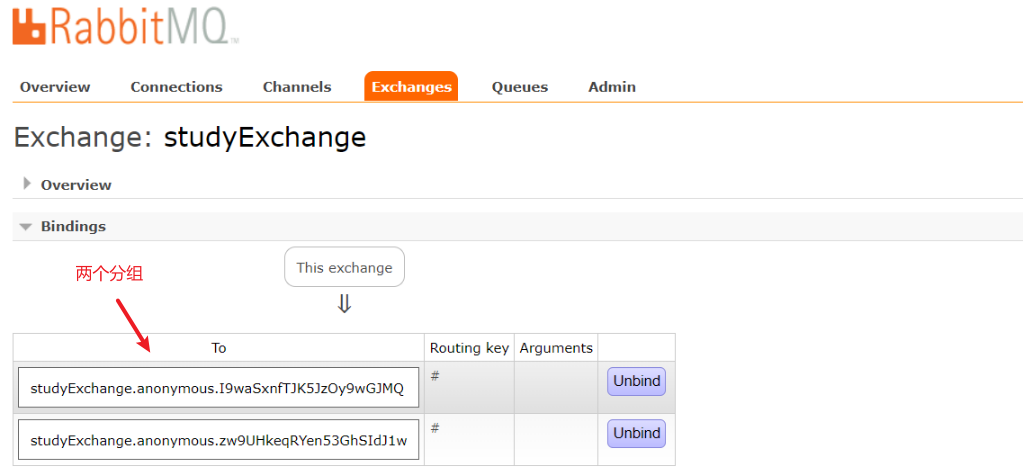

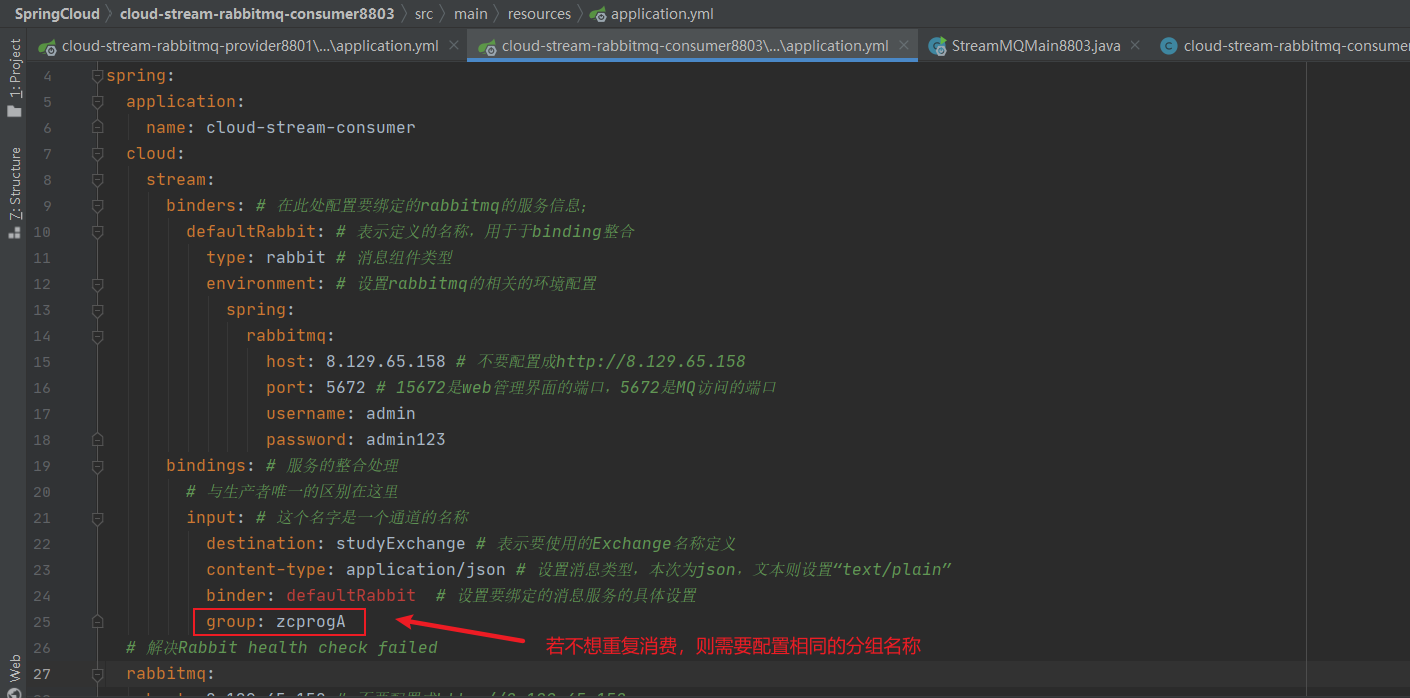

- 7.1.14 Stream消息驱动

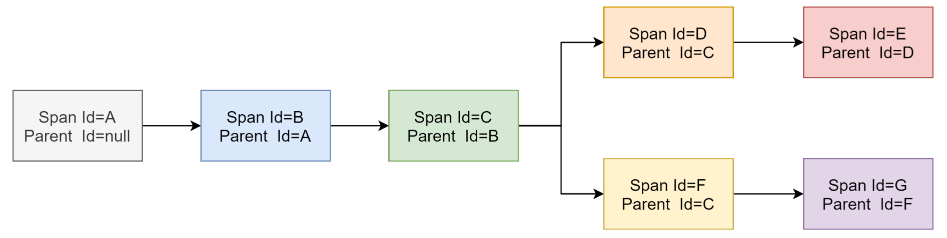

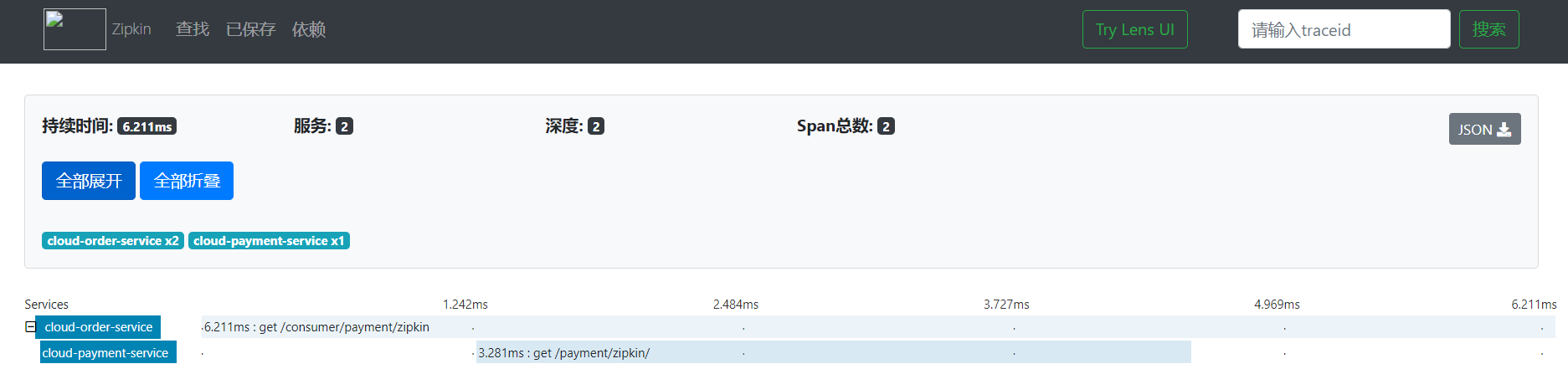

- 7.1.15 Sleuth分布式请求链路跟踪

- 7.1.16 SpringCloud Alibaba

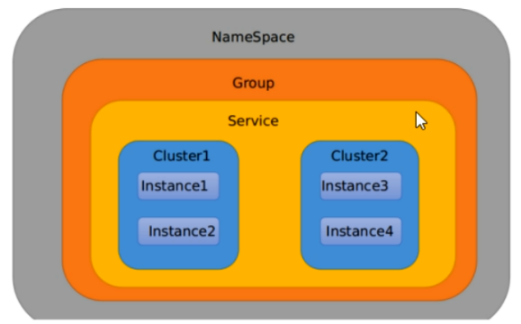

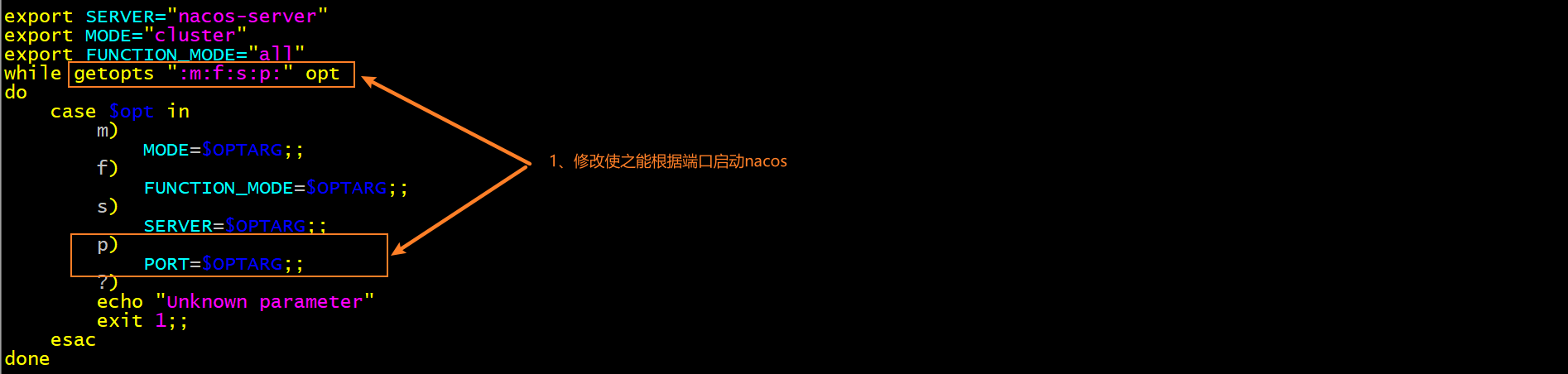

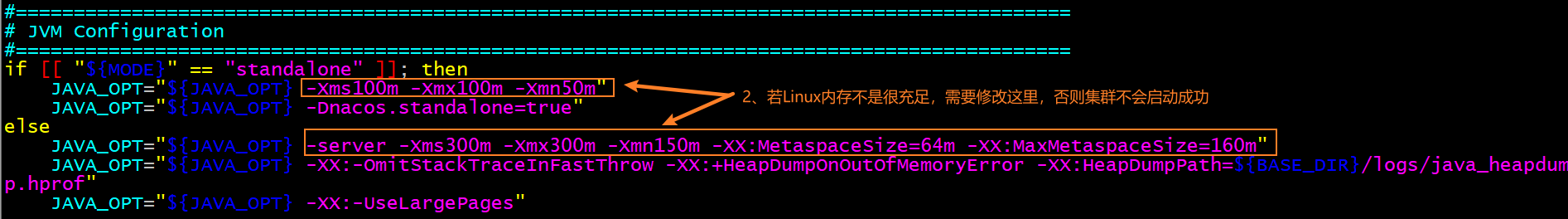

- 7.1.17 Nacos服务注册和配置中心

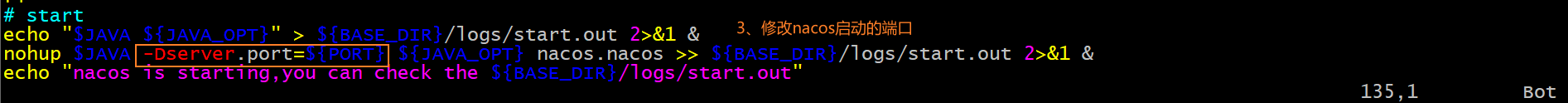

- 7.1.18 Sentinel熔断与限流

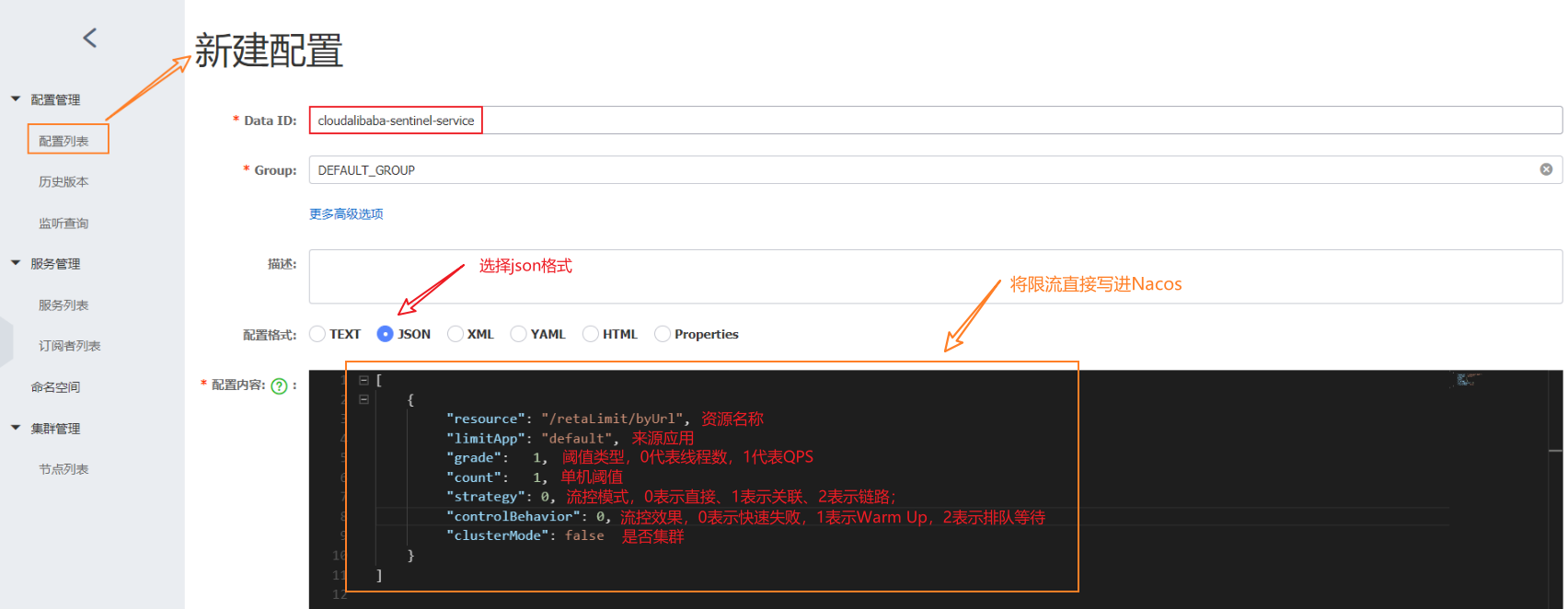

- 7.1.19 Seata分布式事务

- 7.2 SpringBoot

- 7.2.1 加速依赖包的导入

- 7.2.2 SpringBoot的配置

- 7.2.3 容器功能

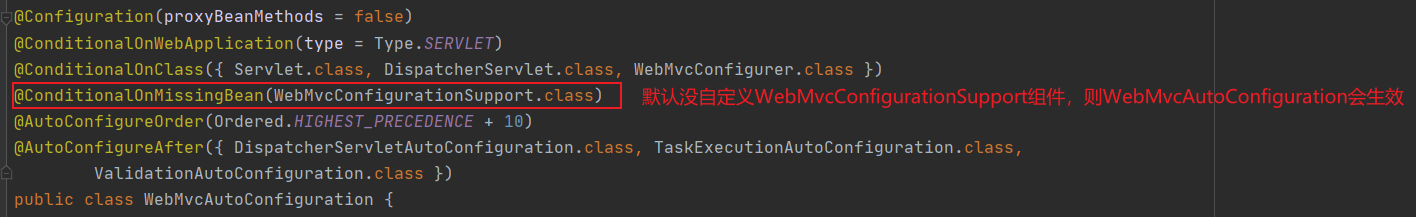

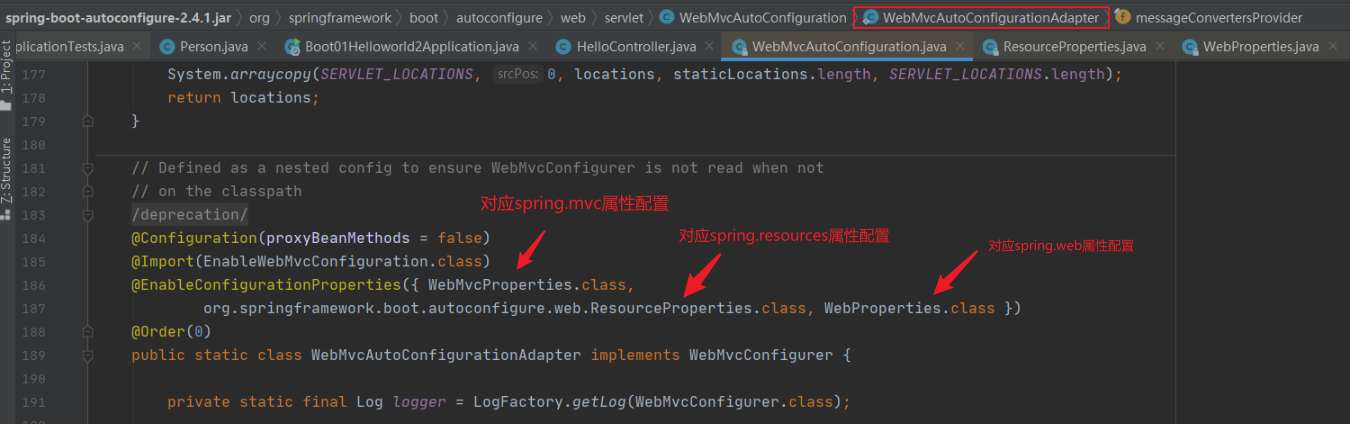

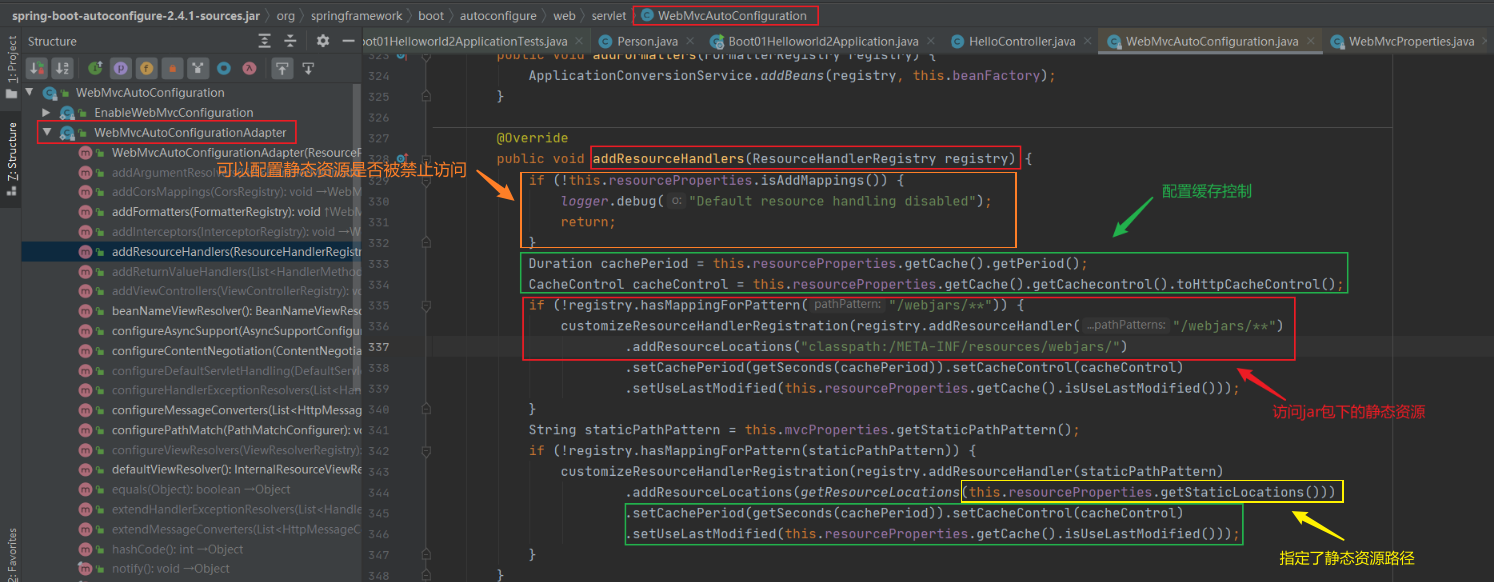

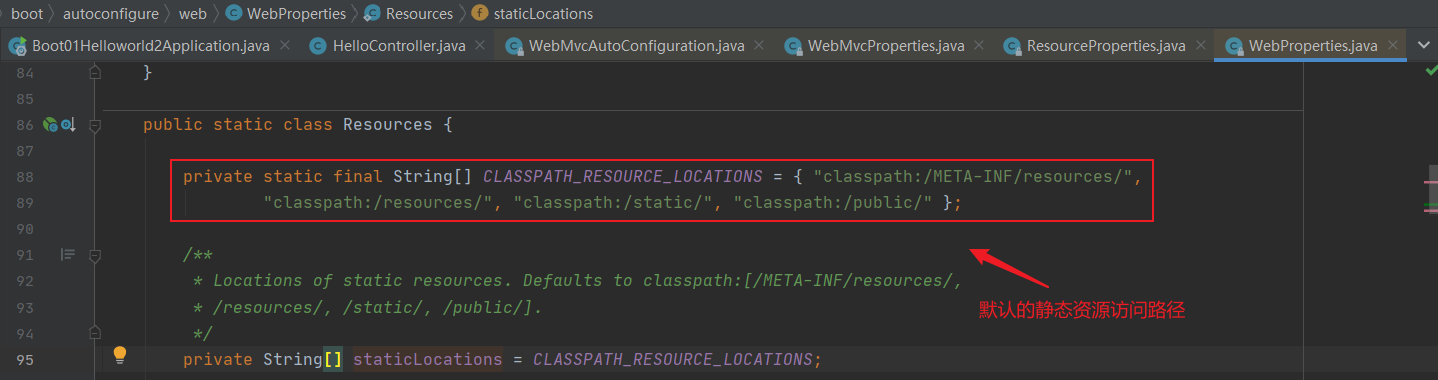

- 7.2.4 自动配置原理⭐

- 7.2.5 热更新

- 7.2.6 配置文件(yml)

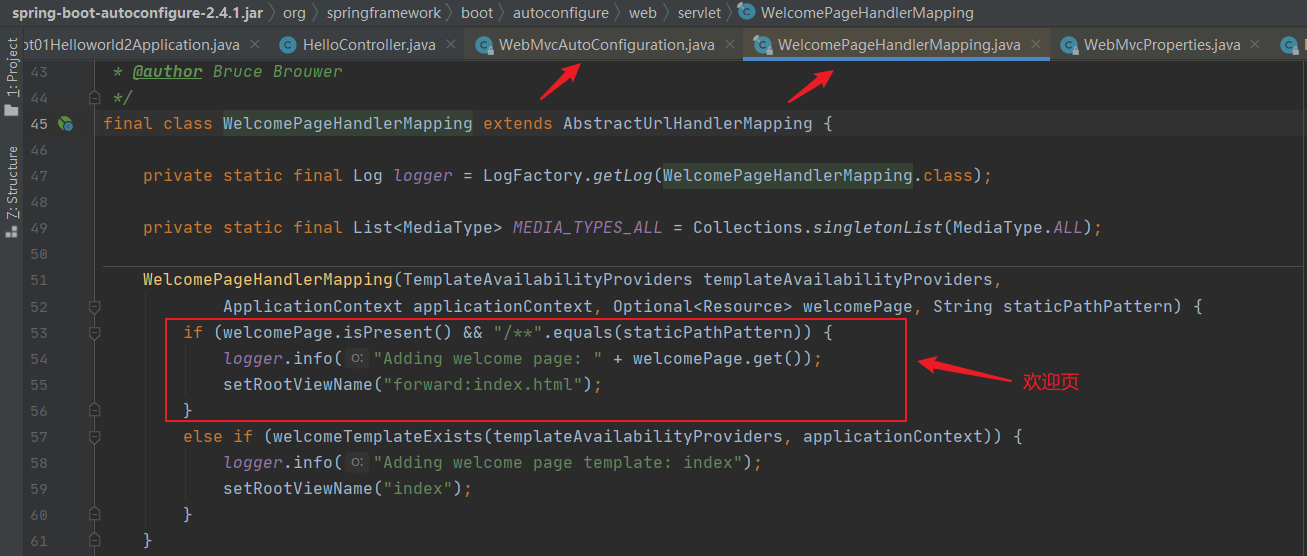

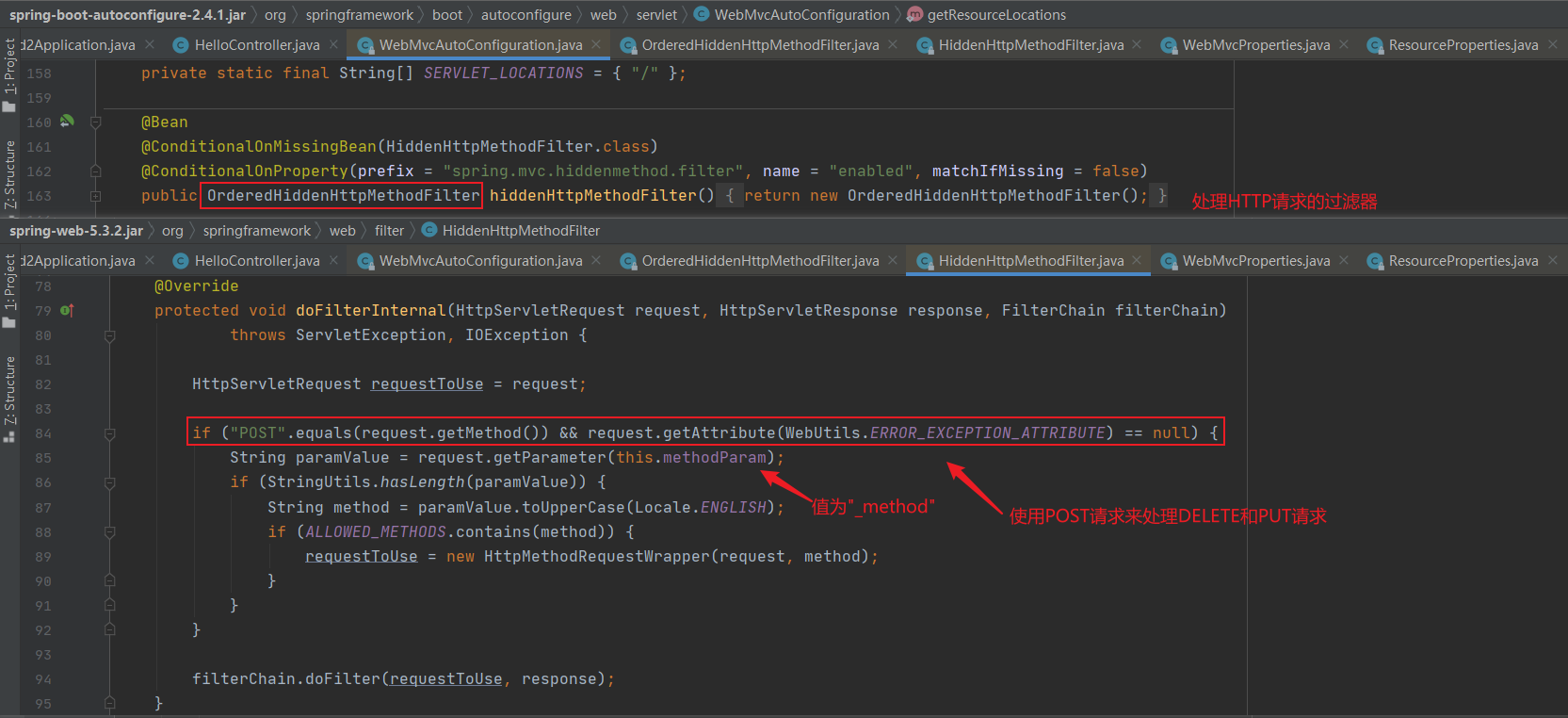

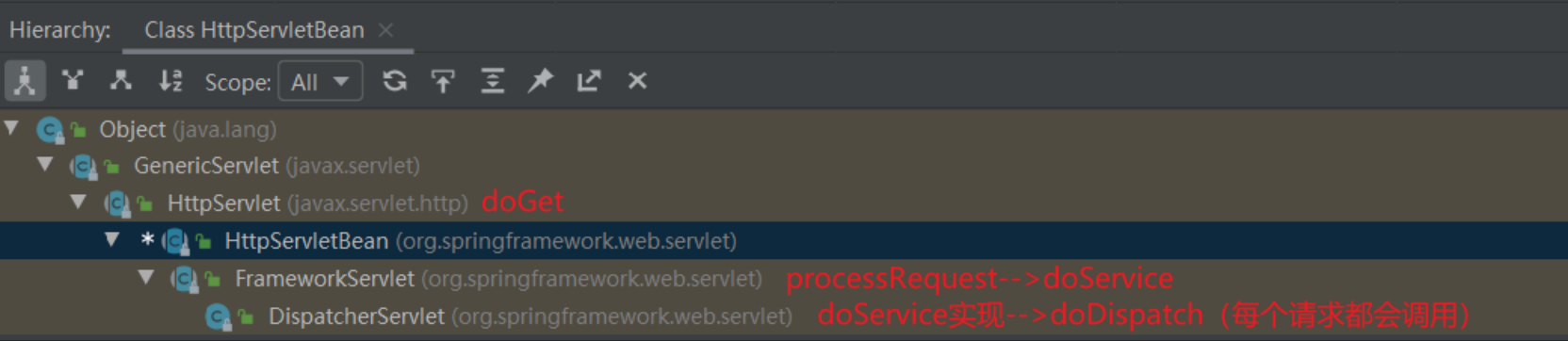

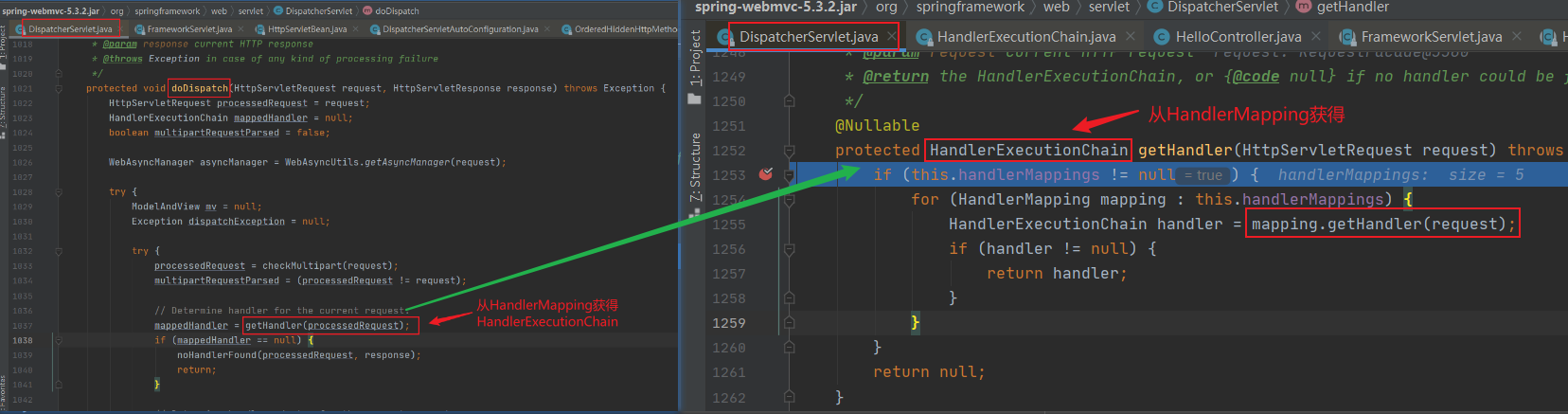

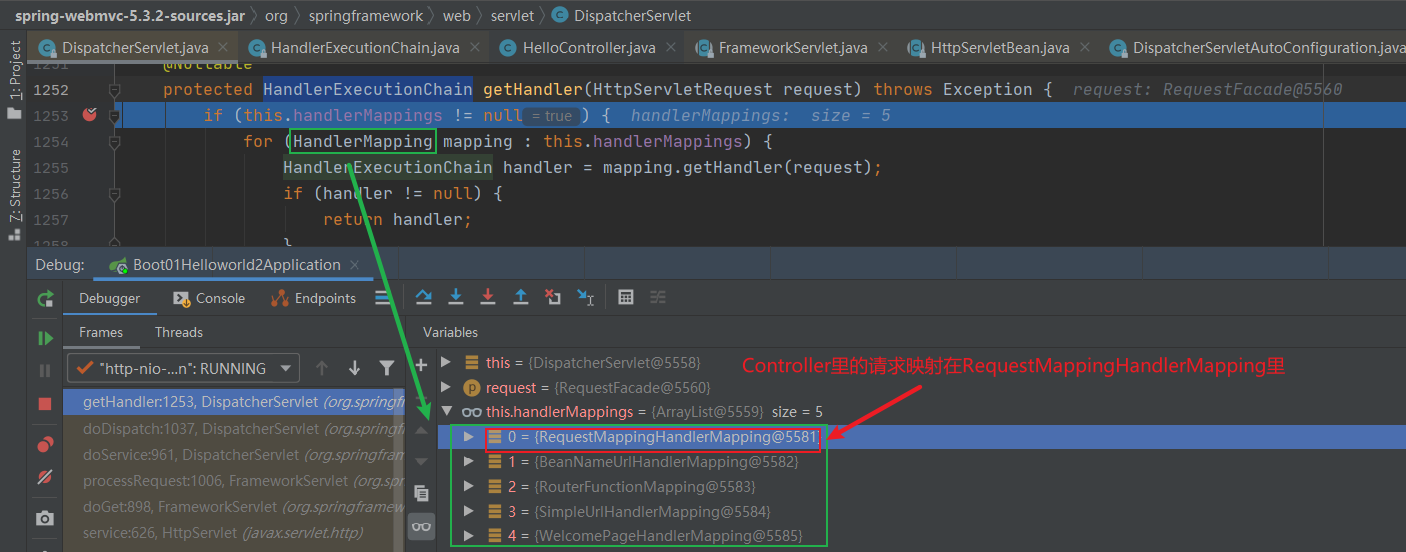

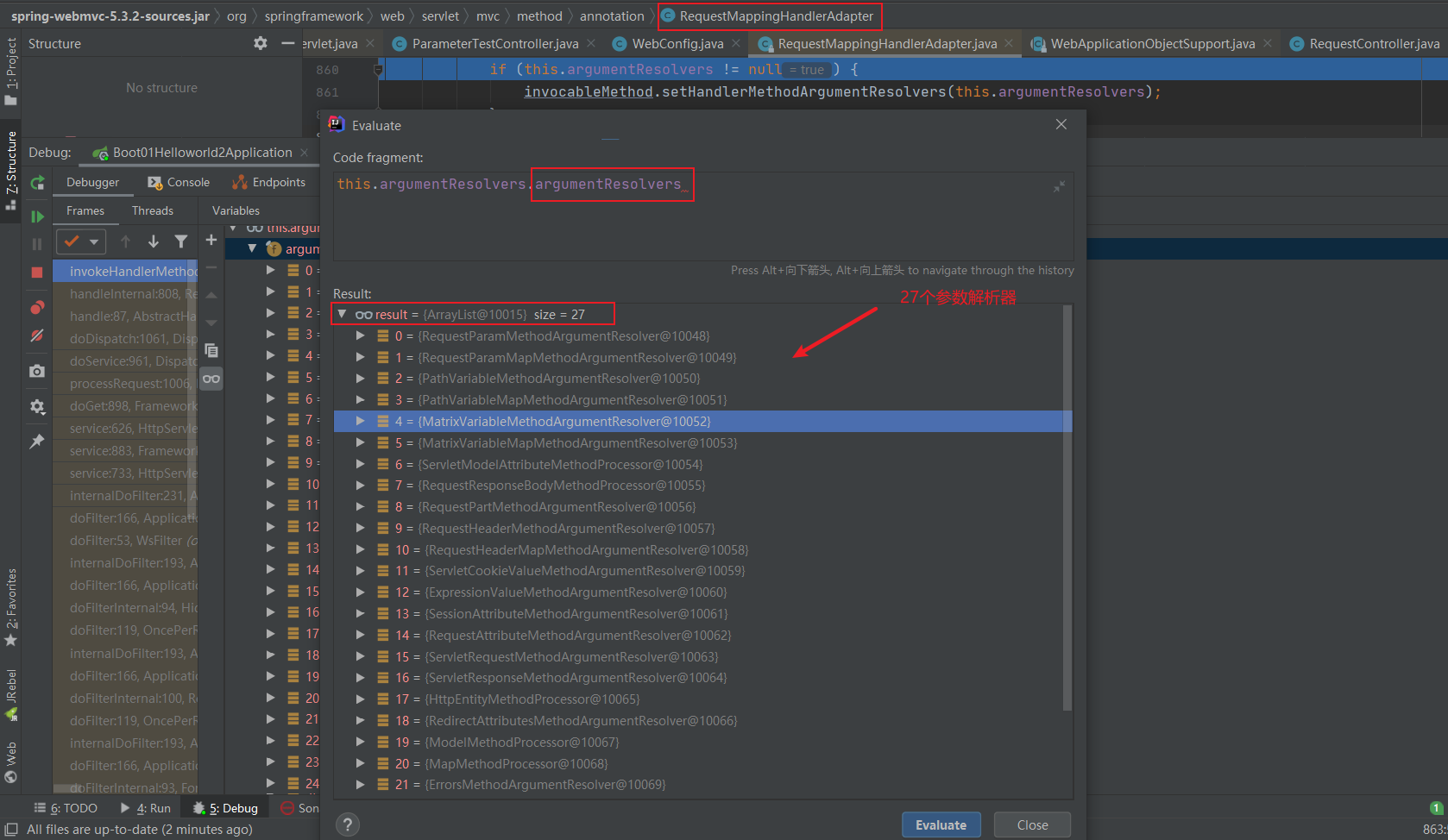

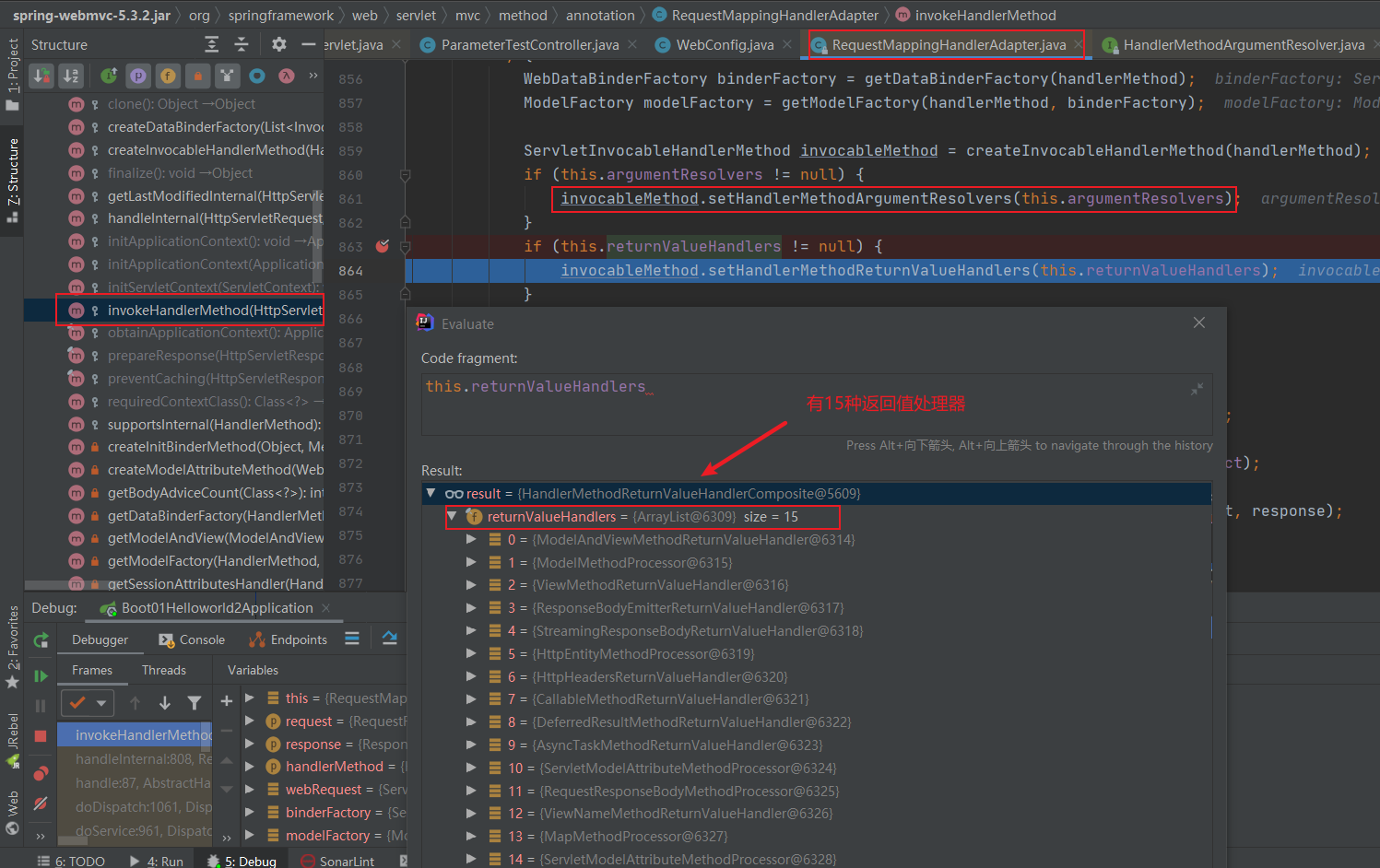

- 7.2.7 Web开发

- 7.2.8 数据访问

- 7.2.9 单元测试

- 7.2.10 指标监控

- 7.2.11 高级特性

- 7.3 WebFlux响应式编程

- 7.1 SpringCloud

- 8 Algorithm

- 9 JVM

- 10 Effective Java

- 11 Redis

- 12 消息中间件MQ

- 13 Nginx

- 14 Zookeeper

- 15 ElasticSearch

- 16 面试点总结

- 16.0 经典好文

- 16.1 自增变量

- 16.2 单例模式

- 16.3 类初始化和实例初始化

- 16.4 方法的参数传递机制

- 16.5 递归与迭代

- 16.6 成员变量与局部变量

- 16.7 Spring Bean作用域区别

- 16.8 Spring支持的事务传播属性和事务隔离级别

- 16.9 SpringMVC中如何解决POST请求中文乱码

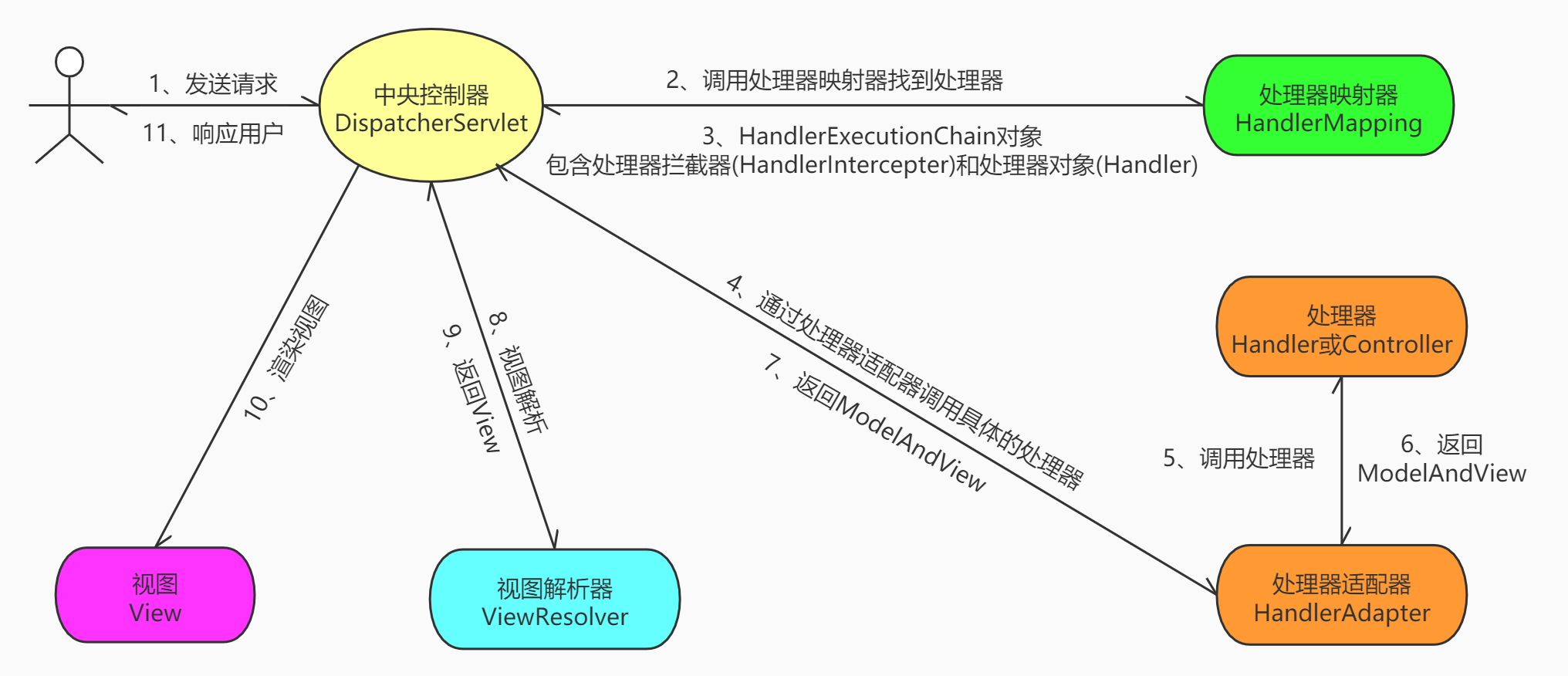

- 16.10 简述SpringMVC的工作流程

- 16.11 MyBatis中当实体类的属性和表中的字段不一致时如何解决?

- 16.12 Linux常用服务类相关命令

- 16.13 Git分支相关命令及实际应用

- 16.14 Redis持久化

- 16.15 MySQL什么时候适合索引?

- 16.16 JVM垃圾回收机制

- 16.17 Redis在项目中的使用场景

- 16.18 ElasticSearch和Solr的区别

- 16.19 单点登录的实现过程

- 16.20 购物车

- 16.21 消息队列

- 16.22 谈谈你对volatile的理解

- 16.23 关于指令重排

- 16.24 关于JMM

- 16.25 谈谈CAS

- 16.26 ABA问题与原子戳引用

- 16.27 List不安全之并发修改异常

- 16.28 Set不安全之并发修改异常

- 16.29 Map不安全之并发修改异常

- 16.30 公平锁/非公平锁

- 16.31 可重入锁(递归锁)

- 16.32 自旋锁的实现

- 16.33 独占锁(写锁)/共享锁(读锁)/互斥锁

- 16.34 CountDownLatch(倒计时器/减法计数器)

- 16.35 CyclicBarrier(栅栏/加法计数器)

- 16.36 Semaphore(信号量)

- 16.37 阻塞队列(3种生产者/消费者模式的实现)

- 16.38 synchronized和ReentrantLock的区别

- 16.39 Callable接口

- 16.40 线程池使用及优势

- 16.41 关于线程池

- 16.42 死锁编码及定位分析

- 16.43 关于GC Roots

- 16.44 JVM参数类型

- 16.45 查看JVM初始默认值

- 16.46 通过程序获得堆栈信息

- 16.47 JVM常用的基本配置参数

- 16.48 强/软/弱/虚引用的理解

- 16.49 关于WeakHashMap

- 16.50 关于OOM

- 16.51 关于垃圾收集器

- 16.52 七大默认垃圾收集器

- 16.53 JVM项目调优

- 16.54 生产环境服务器变慢,诊断思路和性能评估?

- 16.55 CPU占用过高的定位分析思路

- 16.56 JVM监控和性能分析工具

- 16.57 如何利用GitHub检索

- 16.58 String.intern()返回引用

- 16.59 LockSupport

- 16.60 AQS(AbstractQueuedSynchronizer)

- 16.61 Spring AOP顺序

- 16.62 Spring循环依赖

- 16.63 Redis的落地应用

- 16.64 Redis分布式锁

- 16.65 Redis内存淘汰策略

- 16.66 LRU算法的实现

- 16.67 过滤器(Filter)与拦截器(Interceptor)

- 16.68 重定向与请求转发的区别

- 16.69 Socket与Servlet区别

- 16.70 雪花算法

- 16.71 静态内部类和成员内部类

- 16.72 实现深拷贝的两种方式(原型模式)

- 16.73 中断线程的几种方法

- 16.74 notify和notifyAll的区别

- 16.75 sleep()和wait()的区别

- 16.76 泛型方法的调用

- 16.77 乐观锁/悲观锁/自旋锁/自适应自旋/锁消除/锁粗化/轻量级锁/偏向锁

- 16.78 java内存模型

- 16.79 jps/jstat/jinfo/jmap/jhat/jstack/jconsole/jvisualvm

- 16.80 wait/notify/notifyAll/sleep/join/yield

- 16.81 不可变类

- 16.82 竞争条件

- 16.82 代理模式/静态代理/动态代理/Cglib代理

- 16.83 JDK/JRE/JVM之间的关系

- 16.84 关于ThreadLocal

- 16.85 B-Tree/B+Tree/聚集索引/辅助索引/磁盘块/页块

- 16.86 数据库的三大范式

- 16.87 MySQL如何保证一致性、原子性、持久性

- 16.88 写SQL的几点注意事项

- 16.89 drop/delete/truncate

- 16.90 MySQL的默认隔离级别?MySQL如何解决幻读问题?

- 16.100 MySQL中如何优化大表

- 16.101 视图/存储过程/函数/触发器

- 16.102 数据库并发策略/锁种类

- 16.103 交叉连接/内连接/外连接

- 16.104 DDL/DML/DCL/DQL

- 16.105 Spring Bean的生命周期

- 16.106 如何使Spring中单例Bean线程安全

- 16.107 怎么重载的Spring Bean的生命周期方法

- 16.108 切面/通知/切点/连接点/切点表达式

- 16.109 SpringBoot有哪几种读取配置的方式

- 16.110 Eureka和Zookeeper用作服务注册与发现的区别

- 16.111 服务熔断和降级的区别

- 16.112 RPC和REST调用的区别

- 16.113 面试盲点

- 16.114 常考容器类源码

- 16.114.1 HashMap

- 16.114.2 ConcurrentHashMap

- 16.114.3 CopyOnWriteArrayList

- 16.114.4 CopyOnWriteArraySet

- 16.114.5 AbstractQueuedSynchronizer

- 16.114.6 ReentrantLock

- 16.114.7 ReentrantReadWriteLock

- 16.114.8 Semaphore

- 16.114.9 CountDownLatch

- 16.114.10 CyclicBarrier

- 16.114.11 synchronized锁升级过程

- 16.114.12 LongAdder

- 17 Undertow+JMeter压力测试

- 18 Linux

- 18.1 上传下载文件

- 18.2 文件权限

- 18.3 进程

- 18.4 服务

- 18.5 软件安装

模式定义:保证一个类只有一个实例,并且提供一个全局访问点。

应用场景:重量级的对象,不需要多个实例,如线程池、数据库连接池。

概念:延迟加载,只有在真正使用的时候,才开始实例化。

public class LazySingletonTest {

public static void main(String[] args) {

// 单线程情况

LazySingleton instance = LazySingleton.getInstance();

LazySingleton instance1 = LazySingleton.getInstance();

System.out.println(instance == instance1); // 输出 true

}

}

class LazySingleton{

private static LazySingleton instance;

private LazySingleton(){

}

public static LazySingleton getInstance(){

if (instance == null){

instance = new LazySingleton();

}

return instance;

}

}存在问题:

- 多线程情况下会出现线程安全问题

- double check 加锁优化

- 编译器(JIT),CPU有可能对指令进行重新排序,导致使用到尚未初始化的实例,可以通过添加volatile关键字进行修饰;对于volatile修饰的字段,可以防止指令重排。

下面详细进行介绍:如下代码可以演示在多线程情况下会出现线程安全问题。

public class LazySingletonTest {

public static void main(String[] args) {

//多线程情况

new Thread( () -> {

LazySingleton instance = LazySingleton.getInstance();

System.out.println(instance); // 输出LazySingleton@51a22f1d

}).start();

new Thread( () -> {

LazySingleton instance = LazySingleton.getInstance();

System.out.println(instance); // 输出LazySingleton@6706a70b

}).start();

}

}

class LazySingleton{

private static LazySingleton instance;

private LazySingleton(){

}

public static LazySingleton getInstance(){

if (instance == null){

try {

Thread.sleep(200);

} catch (InterruptedException e) {

e.printStackTrace();

}

instance = new LazySingleton();

}

return instance;

}

}解决方法一:在getInstance()方法上添加synchronized关键字可以解决这一问题,但是会导致性能降低。

class LazySingleton{

private static LazySingleton instance;

private LazySingleton(){

}

public synchronized static LazySingleton getInstance(){ // 添加synchronized关键字

if (instance == null){

try {

Thread.sleep(200);

} catch (InterruptedException e) {

e.printStackTrace();

}

instance = new LazySingleton();

}

return instance;

}

}解决方法二:为了解决方法一的性能问题,可以采用double check 加锁优化。

class LazySingleton{

private static LazySingleton instance;

private LazySingleton(){

}

public static LazySingleton getInstance(){

if (instance == null){

synchronized(LazySingleton.class){ // double check 加锁优化

if (instance == null){

instance = new LazySingleton();

}

}

}

return instance;

}

}解决办法三:方法二可能在编译层出现重排序问题,添加volatile关键字可以保证编译时先进行初始化,再引用赋值,否则可能会出现空指针问题。

class LazySingleton{

private volatile static LazySingleton instance; // 添加volatile关键字

private LazySingleton(){

}

public static LazySingleton getInstance(){

if (instance == null){

synchronized(LazySingleton.class){

if (instance == null){

// 字节码层运行细节

// 1.分配空间-->2.初始化-->3.引用赋值

// 添加volatile可以防止重排序(即先进行初始化,再引用赋值,保证二者不会颠倒执行),否则可能会出现空指针问题

instance = new LazySingleton();

}

}

}

return instance;

}

}概念:类加载的初始化阶段就完成了实例的初始化,本质上就是借助于jvm类加载机制,保证实例的唯一性。

类加载过程:

-

加载二进制数据到内存中,生成对应的Class数据结构。

-

连接:a.验证;b.准备(给类的静态成员变量赋默认值);c.解析。

-

初始化:给类的静态变量赋初值。

只有在真正使用对应的类时,才会触发初始化。(如当前类时启动类即main函数所在类,直接进行new操作、访问静态属性、访问静态方法、用反射访问类、初始化一个类的子类)

public class HungrySingletonTest {

public static void main(String[] args) {

HungrySingleton instance = HungrySingleton.getInstance();

HungrySingleton instance1 = HungrySingleton.getInstance();

System.out.println(instance == instance1); // 输出true

}

}

class HungrySingleton{

private static HungrySingleton instance = new HungrySingleton();

private HungrySingleton(){

}

public static HungrySingleton getInstance(){

return instance;

}

}s概念:

- 本质上是利用类的加载机制来保证线程安全。

- 只有在实际使用的时候,才会触发静态内部类的初始化,所以也是懒加载的一种形式。

class InnerClassSingleton{

private static class InnerClassHolder{

private static InnerClassSingleton instance = new InnerClassSingleton();

}

private InnerClassSingleton(){

}

public static InnerClassSingleton getInstance(){

return InnerClassHolder.instance;

}

}

- 使用饿汉模式和静态内部类模式创建的单例类,在使用反射时不能保证单例性。

public class SingletonTest { public static void main(String[] args) throws NoSuchMethodException, IllegalAccessException, InvocationTargetException, InstantiationException { Constructor<InnerClassSingleton> declaredConstructor = InnerClassSingleton.class.getDeclaredConstructor(); declaredConstructor.setAccessible(true); InnerClassSingleton innerClassSingleton = declaredConstructor.newInstance(); InnerClassSingleton instance = InnerClassSingleton.getInstance(); System.out.println(innerClassSingleton == instance); // 输出false } }

- 可以在饿汉模式和静态内部类模式对该问题进行防护,使用懒汉模式则不能进行防护。

class InnerClassSingleton{ private static class InnerClassHolder{ private static InnerClassSingleton instance = new InnerClassSingleton(); } private InnerClassSingleton(){ if(InnerClassHolder.instance!=null){ throw new RuntimeException("单例不允许多个实例"); } } public static InnerClassSingleton getInstance(){ return InnerClassHolder.instance; } }

OO设计原则:

- 找出应用中可能需要变化之处,把它们独立出来,不要和那些不需要变化的代码混在一起。(策略模式)

- 针对接口编程,而不是针对实现编程。(策略模式)

- 多用组合,少用继承。(策略模式)

- 为了交互对象之间的松耦合设计而努力。(观察者模式)

- 类应该对扩展开放,对修改关闭。(装饰者模式)

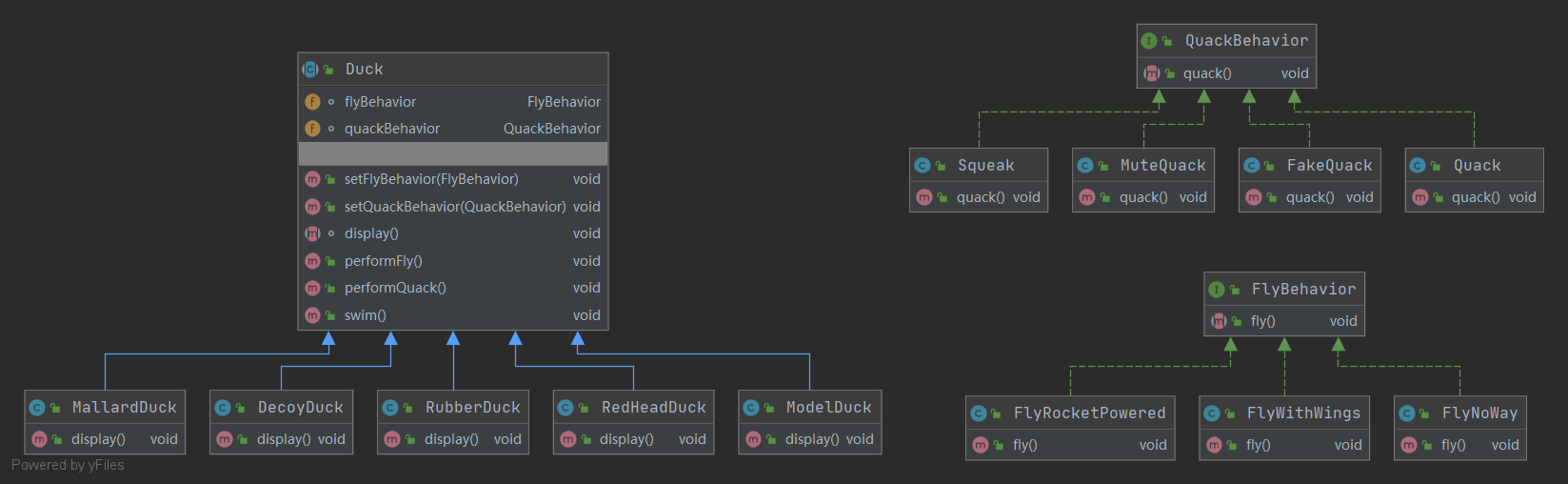

策略模式(Strategy Pattern):定义了算法族,分别封装起来,让它们之间可以互相替换,此模式让算法的变化独立于使用算法的客户。

"模拟鸭子的世界":

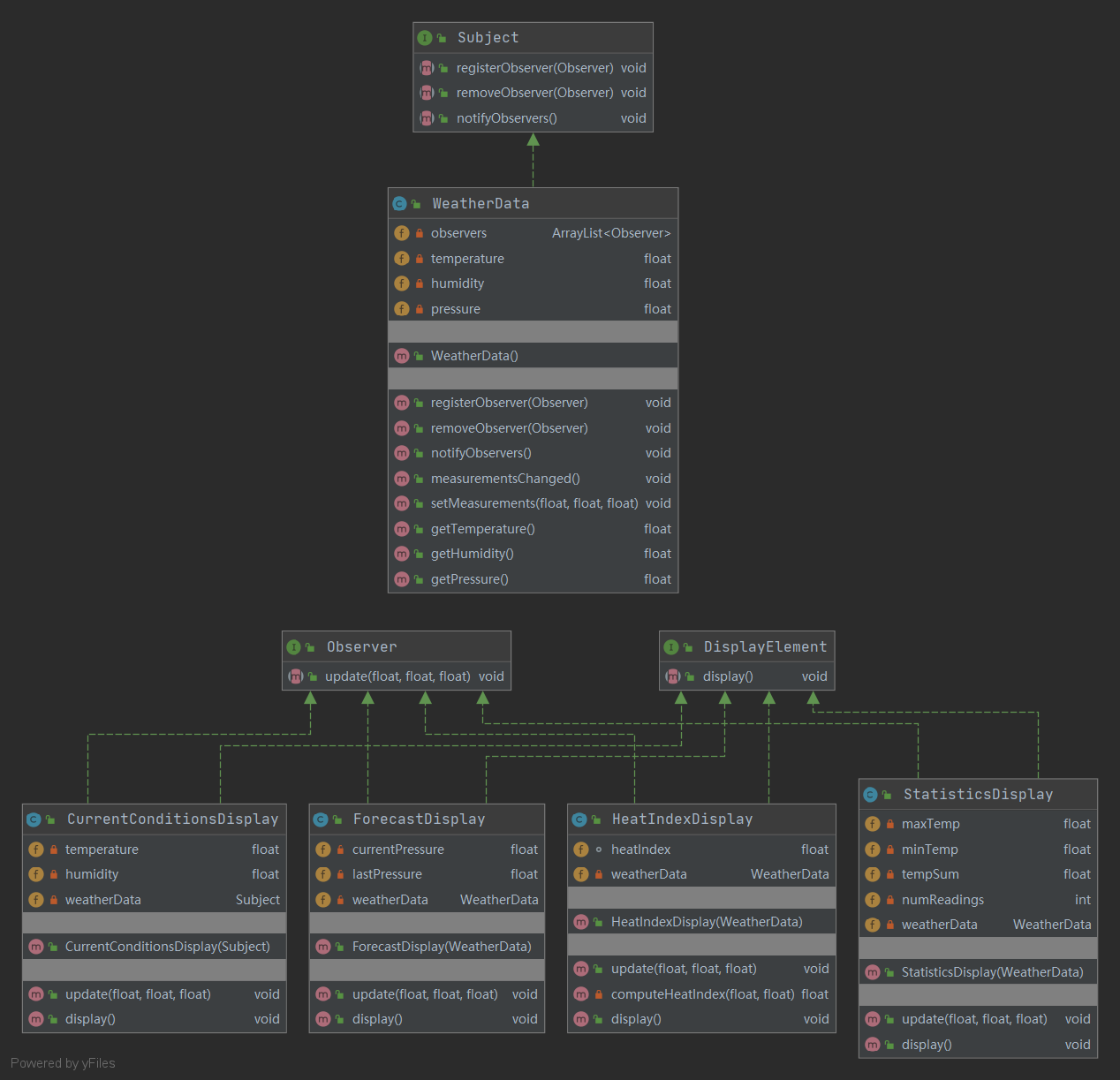

观察者模式(Observer Pattern):定义了对象之间的一对多依赖,这样一来,当一个对象改变状态时,它的所有依赖者都会收到通知并自动更新。观察者模式提供了一种对象设计,让主题和观察者之间松耦合。松耦合的设计之所以能让我们建立有弹性的OO系统,能够应对变化,是因为对象之间的互相依赖降到了最低。

"气象检测站":

自定义观察者模式:

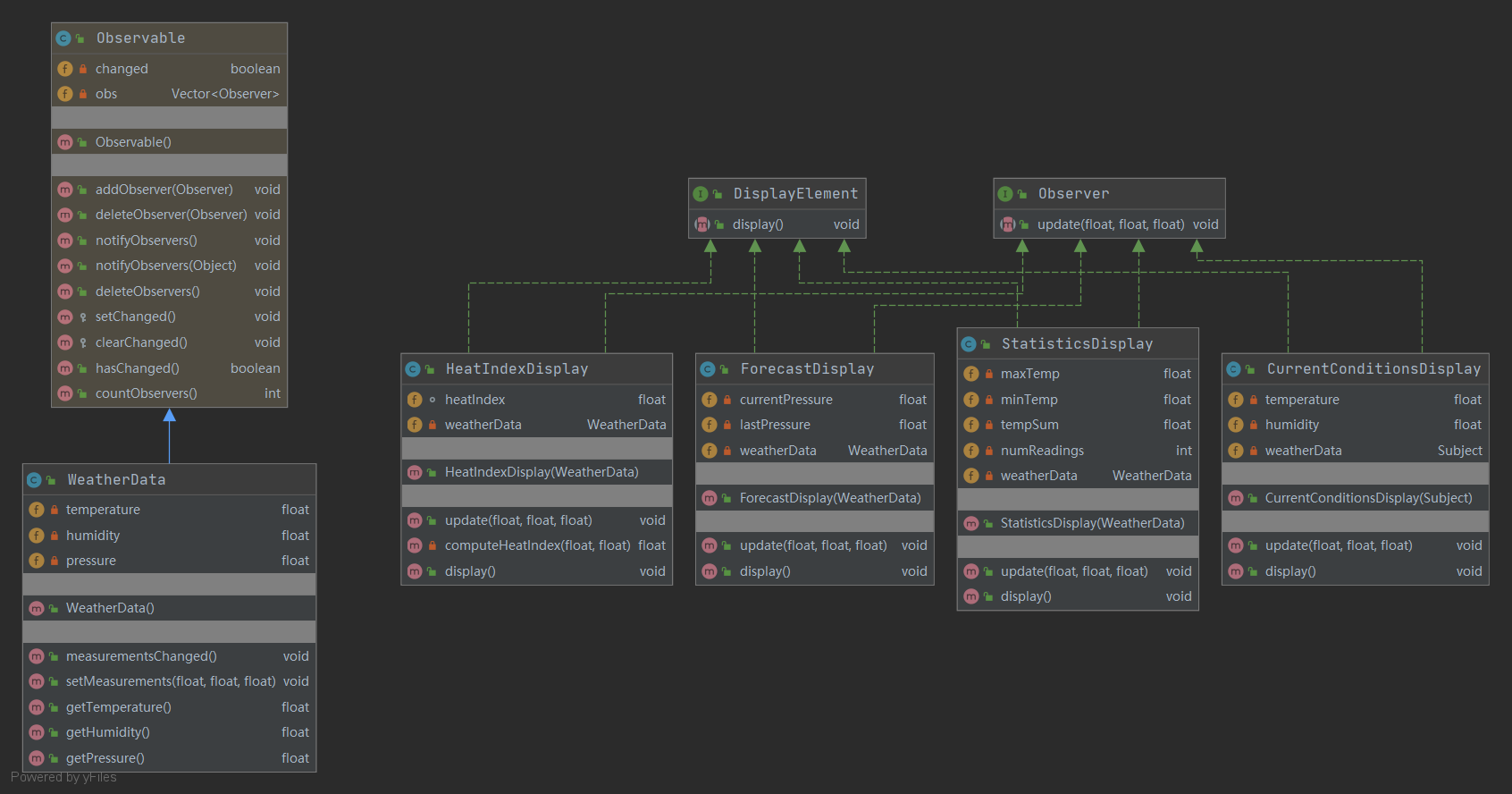

JDK观察者模式:Java提供的观察者模式:Observable类和Observer接口。

需要注意的是:Observable是一个类,违反了OO设计原则(针对接口编程,而不是针对实现编程)。由于java不支持多重继承,限制了Observable的复用潜力;此外,Observable的serChange方法被定义成protected,导致只有继承Observable类,才能将创建的Observable实例组合到自己的设计对象中来,这违反了OO设计又一个原则(多用组合,少用继承)。

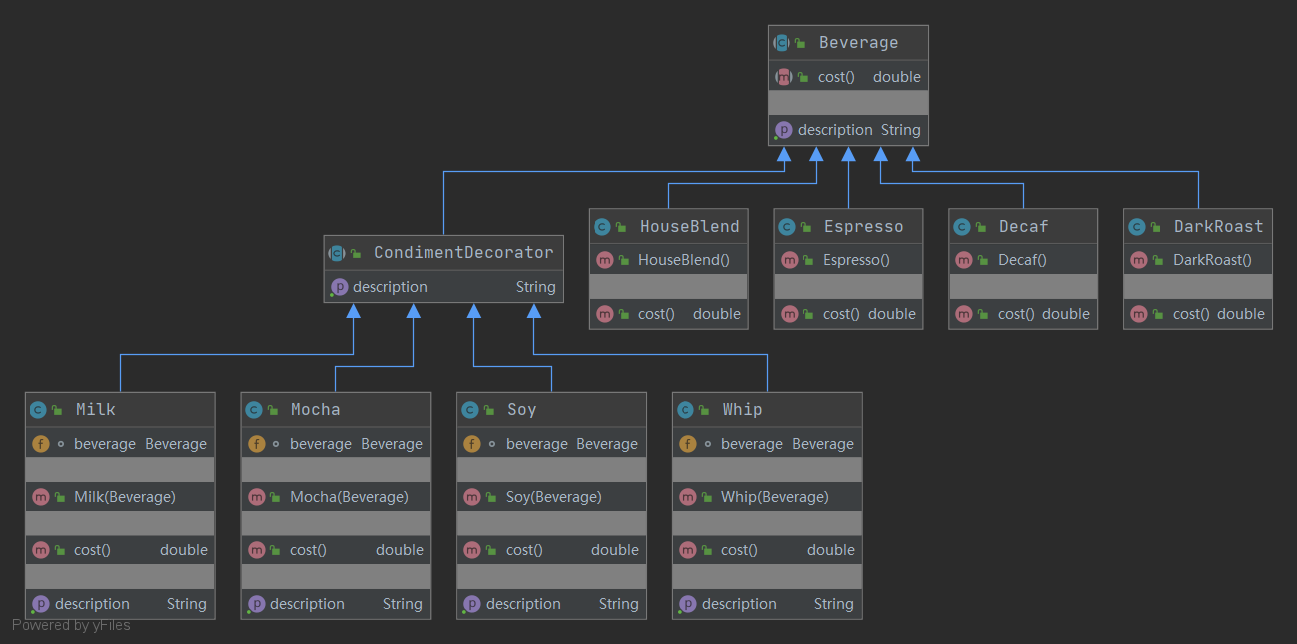

装饰者模式(Decorator Pattern):动态地将责任附加到对象上;若要扩展功能,装饰者提供了比继承更有弹性的替代方案。

"咖啡与调料"

自定义装饰者模式:

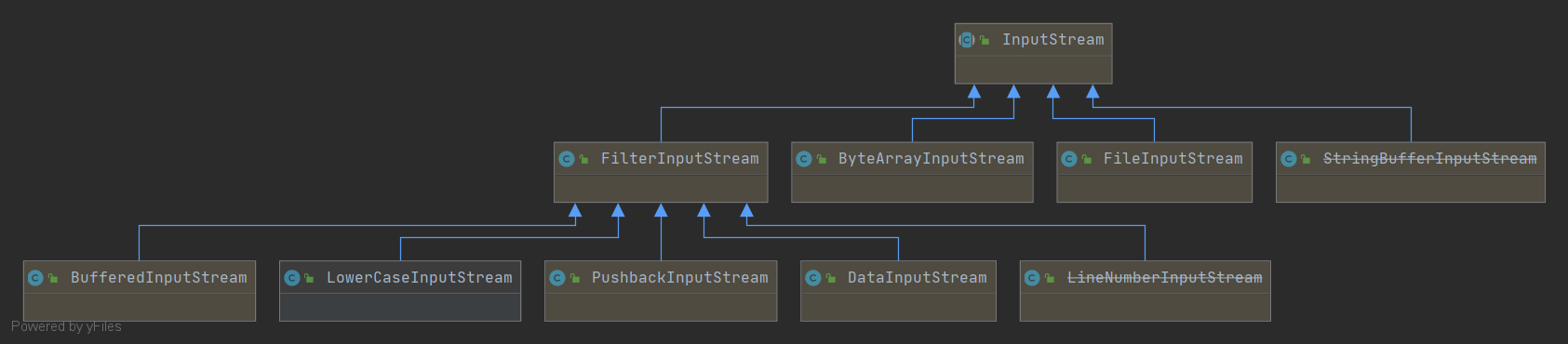

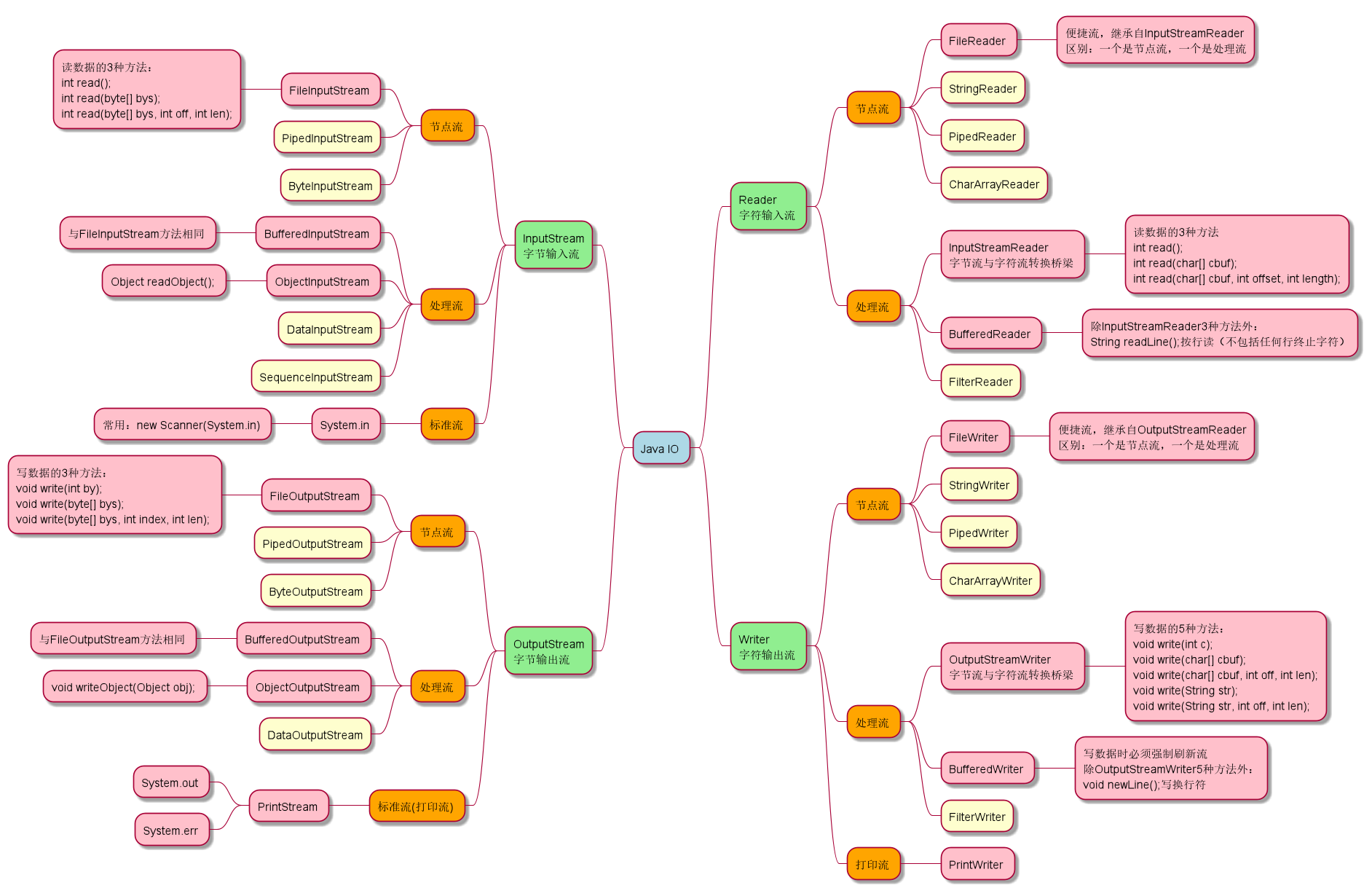

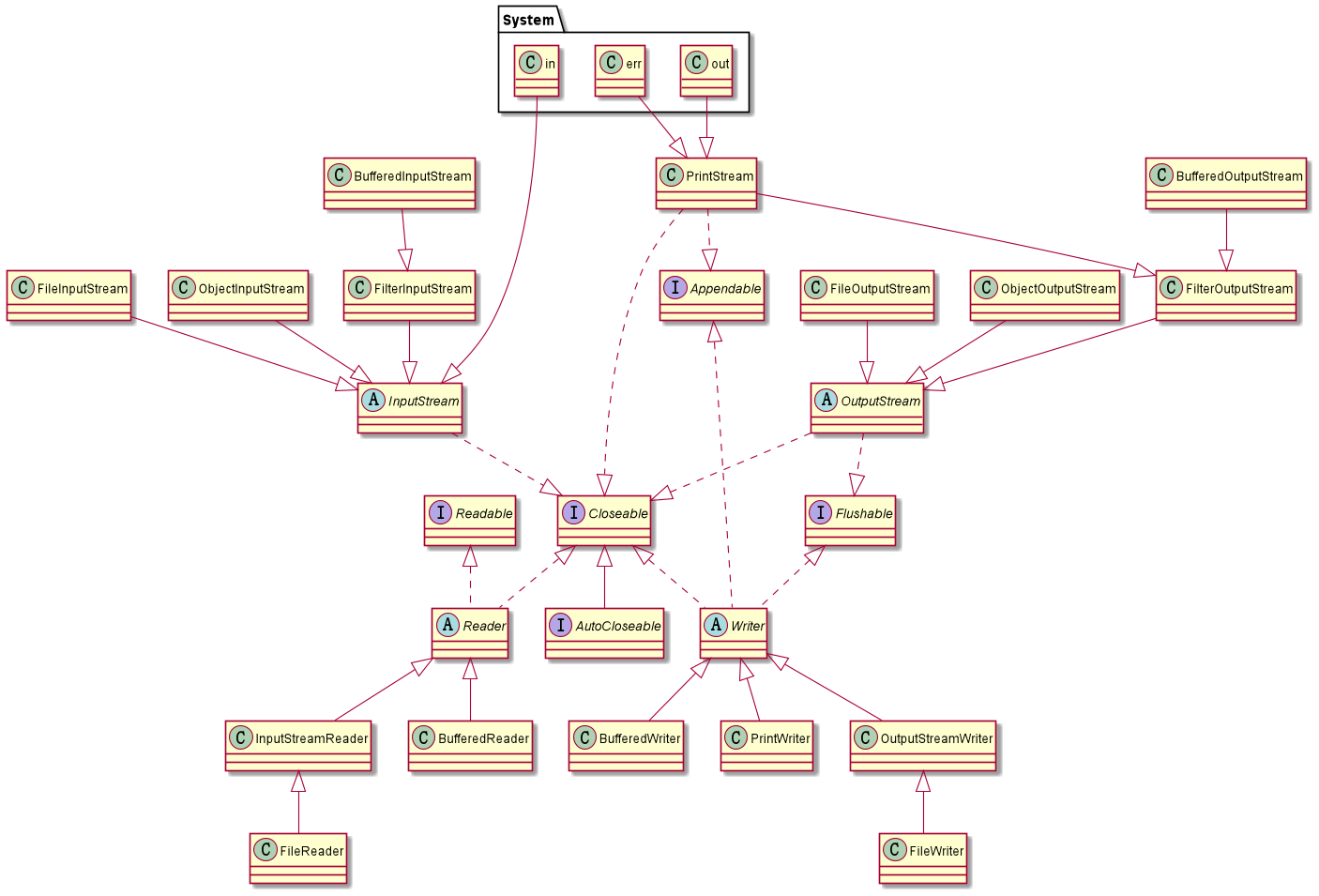

增强Java I/O的装饰者模式:

工厂模式(Factory Pattern):

"比萨工厂"

本部分图表使用IDEA+PlantUML+Graphviz制作:

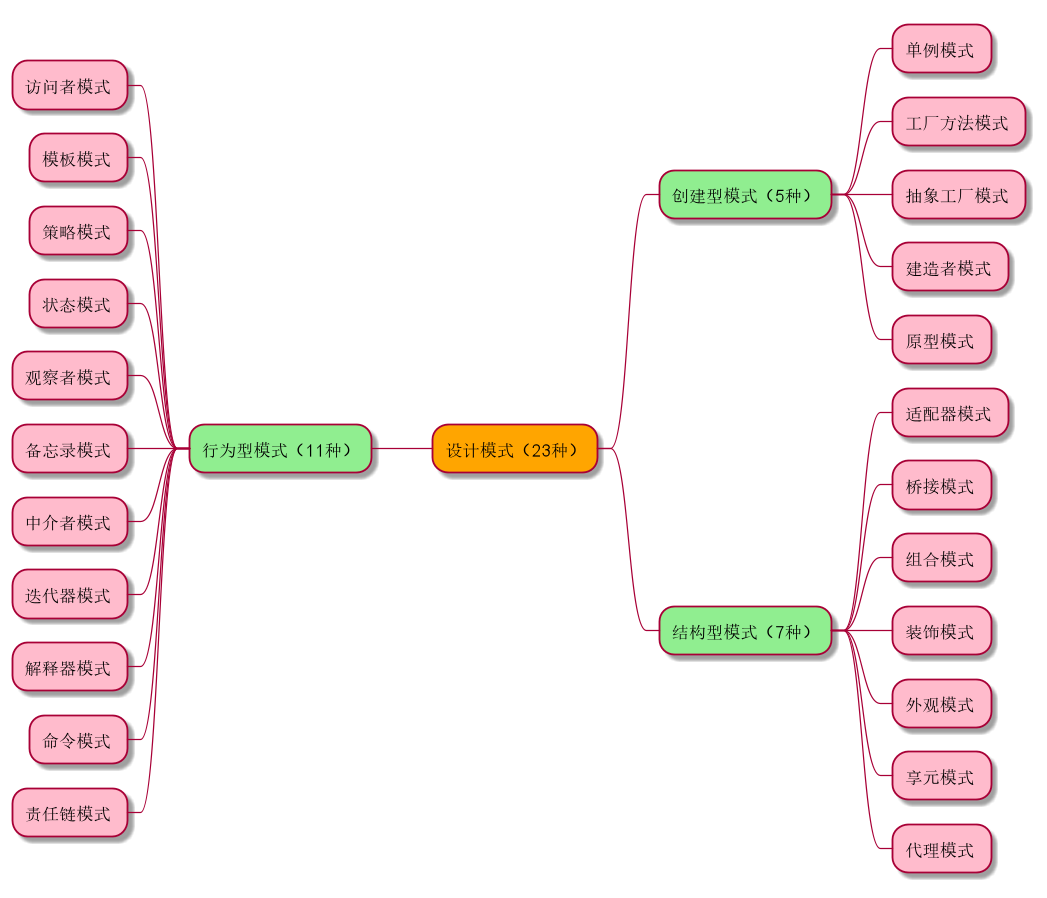

设计模式概览:

单例模式:一种创建型设计模式, 让你能够保证一个类只有一个实例, 并提供一个访问该实例的全局节点。

当系统中只需要一个实例对象或者系统中只允许一个公共访问点,除了这个公共访问点外,不能通过其他访问点访问该实例时,可以使用单例模式。单例模式的主要优点就是节约系统资源、提高了系统效率,同时也能够严格控制客户对它的访问。也许就是因为系统中只有一个实例,这样就导致了单例类的职责过重,违背了“单一职责原则”,同时也没有抽象类,所以扩展起来有一定的困难。其UML结构图非常简单,就只有一个类。

Java类库中的应用:

java.lang.Runtime#getRuntime()java.awt.Desktop#getDesktop()java.lang.System#getSecurityManager()

识别方法: 单例可以通过返回相同缓存对象的静态构建方法来识别。

详见1.1。

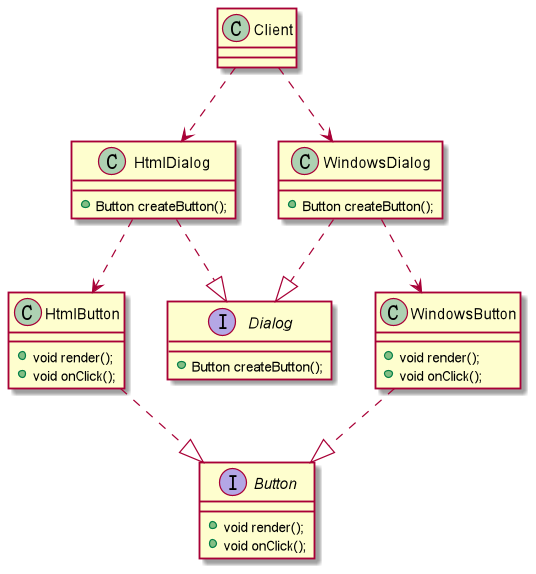

工厂方法模式:一种创建型设计模式, 其在父类中提供一个创建对象的方法, 允许子类决定实例化对象的类型。

作为抽象工厂模式的孪生兄弟,工厂方法模式定义了一个创建对象的接口,但由子类决定要实例化的类是哪一个,也就是说工厂方法模式让实例化推迟到子类。工厂方法模式非常符合"开闭原则",当需要增加一个新的产品时,我们只需要增加一个具体的产品类和与之对应的具体工厂即可,无须修改原有系统。同时在工厂方法模式中用户只需要知道生产产品的具体工厂即可,无须关系产品的创建过程,甚至连具体的产品类名称都不需要知道。虽然他很好的符合了“开闭原则”,但是由于每新增一个新产品时就需要增加两个类,这样势必会导致系统的复杂度增加。

Java类库中的应用:

java.util.Calendar#getInstance()java.util.ResourceBundle#getBundle()java.text.NumberFormat#getInstance()java.nio.charset.Charset#forName()java.net.URLStreamHandlerFactory#createURLStreamHandler(String)java.util.EnumSet#of()javax.xml.bind.JAXBContext#createMarshaller()

识别方法: 工厂方法可通过构建方法来识别, 它会创建具体类的对象, 但以抽象类型或接口的形式返回这些对象。

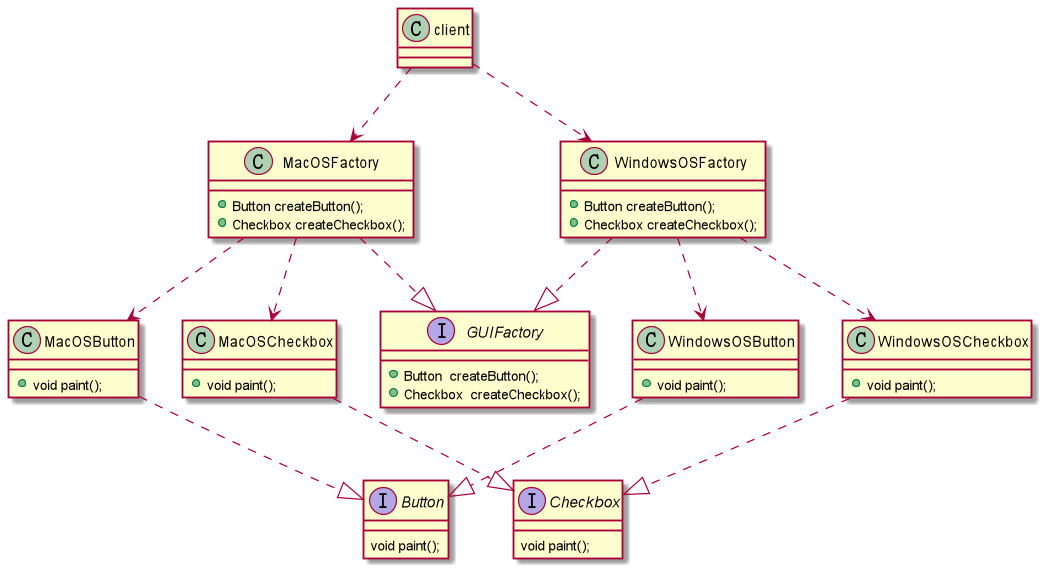

抽象工厂模式:一种创建型设计模式, 它能创建一系列相关的对象, 而无需指定其具体类。

提供一个接口,用于创建相关或者依赖对象的家族,而不需要明确指定具体类。他允许客户端使用抽象的接口来创建一组相关的产品,而不需要关系实际产出的具体产品是什么。这样一来,客户就可以从具体的产品中被解耦。它的优点是隔离了具体类的生成,使得客户端不需要知道什么被创建了,而缺点就在于新增新的行为会比较麻烦,因为当添加一个新的产品对象时,需要更加需要更改接口及其下所有子类。

Java类库中的应用:

javax.xml.parsers.DocumentBuilderFactory#newInstance()javax.xml.transform.TransformerFactory#newInstance()javax.xml.xpath.XPathFactory#newInstance()

识别方法: 我们可以通过方法来识别该模式——其会返回一个工厂对象。 接下来, 工厂将被用于创建特定的子组件。

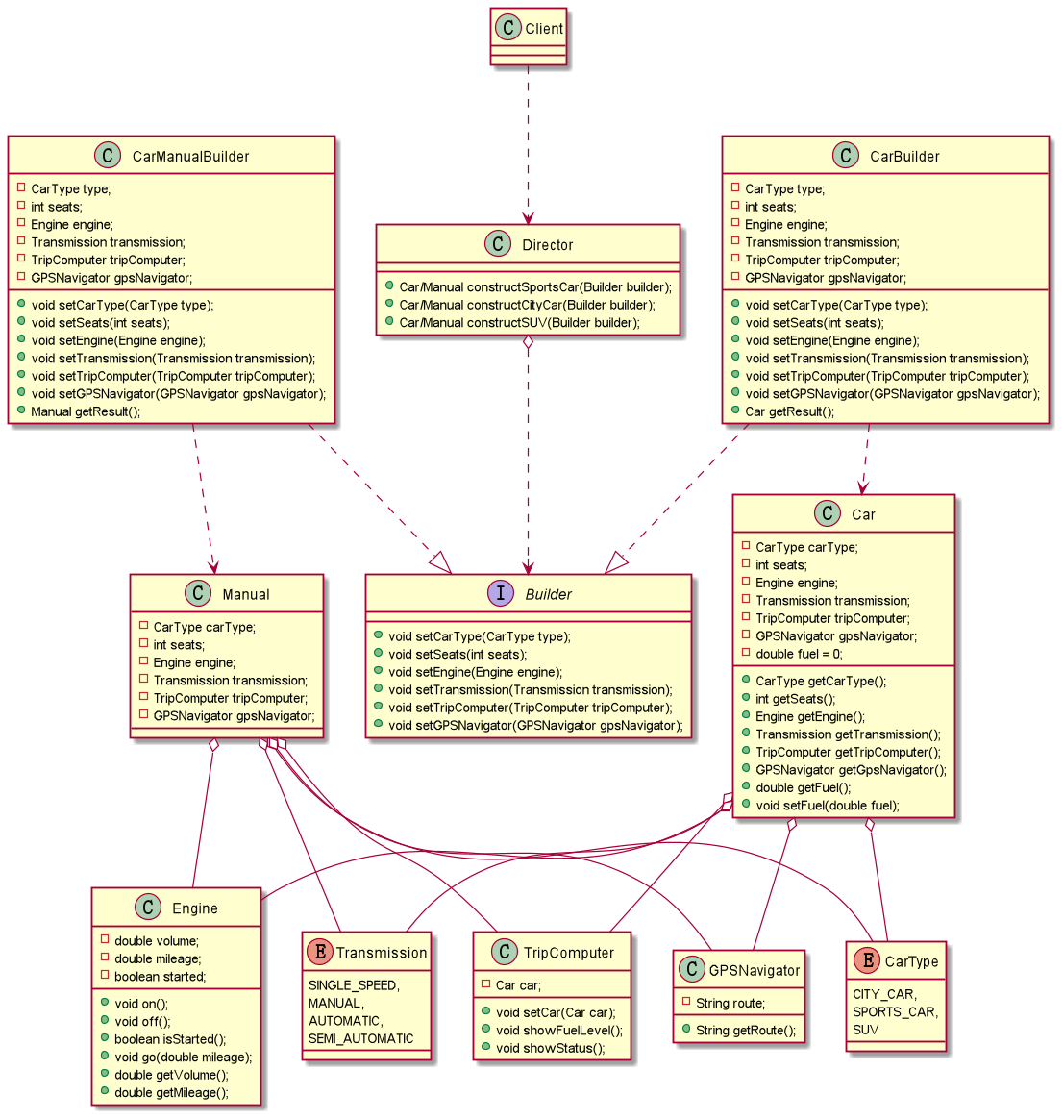

建造者模式(也称为生成器模式):一种创建型设计模式, 使你能够分步骤创建复杂对象。 该模式允许你使用相同的创建代码生成不同类型和形式的对象。

对于建造者模式而言,它主要是将一个复杂对象的构建与表示分离,使得同样的构建过程可以创建不同的表示。适用于那些产品对象的内部结构比较复杂。建造者模式将复杂产品的构建过程封装分解在不同的方法中,使得创建过程非常清晰,能够让我们更加精确的控制复杂产品对象的创建过程,同时它隔离了复杂产品对象的创建和使用,使得相同的创建过程能够创建不同的产品。但是如果某个产品的内部结构过于复杂,将会导致整个系统变得非常庞大,不利于控制,同时若几个产品之间存在较大的差异,则不适用建造者模式,毕竟这个世界上存在相同点大的两个产品并不是很多,所以它的使用范围有限。

Java类库中的应用:

java.lang.StringBuilder#append()java.lang.StringBuffer#append()java.nio.ByteBuffer#put()javax.swing.GroupLayout.Group#addComponent()java.lang.Appendable的所有实现

识别方法: 生成器模式可以通过类来识别, 它拥有一个构建方法和多个配置结果对象的方法。 生成器方法通常支持方法链 (例如 someBuilder->setValueA(1)->setValueB(2)->create() )。

建造者模式的一种简化(去掉Director):

public class Car {

private String carType;

private int seats;

private String engine;

private String transmission;

private String tripComputer;

private String gpsNavigator;

/* 禁止无参构造 */

private Car(){

throw new RuntimeException("Can't init...");

}

private Car(Builder builder){

this.carType = builder.carType;

this.seats = builder.seats;

this.engine = builder.engine;

this.transmission = builder.transmission;

this.tripComputer = builder.tripComputer;

this.gpsNavigator = builder.gpsNavigator;

}

@Override

public String toString() {

return "Car{" +

"carType='" + carType + '\'' +

", seats=" + seats +

", engine='" + engine + '\'' +

", transmission='" + transmission + '\'' +

", tripComputer='" + tripComputer + '\'' +

", gpsNavigator='" + gpsNavigator + '\'' +

'}';

}

public static final class Builder{

private String carType;

private int seats;

private String engine;

private String transmission;

private String tripComputer;

private String gpsNavigator;

public Builder(){ }

public Builder setCarType(String carType){

this.carType = carType;

return this;

}

public Builder setSeats(int seats){

this.seats = seats;

return this;

}

public Builder setEngine(String engine){

this.engine = engine;

return this;

}

public Builder setTransmission(String transmission){

this.transmission = transmission;

return this;

}

public Builder setTripComputer(String tripComputer){

this.tripComputer = tripComputer;

return this;

}

public Builder setGpsNavigator(String gpsNavigator){

this.gpsNavigator = gpsNavigator;

return this;

}

public Car build(){

return new Car(this);

}

}

public static void main(String[] args) {

Car car = new Builder()

.setCarType("SUV")

.setSeats(6)

.setEngine("1.6T")

.setTransmission("混合动力")

.setTripComputer("12.9寸液晶大屏")

.setGpsNavigator("北斗")

.build();

System.out.println(car);

}

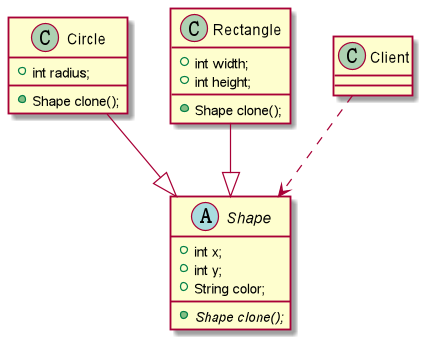

}原型模式:一种创建型设计模式, 使你能够复制已有对象, 而又无需使代码依赖它们所属的类。

在我们应用程序可能有某些对象的结构比较复杂,但是我们又需要频繁的使用它们,如果这个时候我们来不断的新建这个对象势必会大大损耗系统内存的,这个时候我们需要使用原型模式来对这个结构复杂又要频繁使用的对象进行克隆。所以原型模式就是用原型实例指定创建对象的种类,并且通过复制这些原型创建新的对象。它主要应用与那些创建新对象的成本过大时。它的主要优点就是简化了新对象的创建过程,提高了效率,同时原型模式提供了简化的创建结构。

根据拷贝方式不同,原型模式又可以分为:浅克隆和深克隆。一般实现的是浅克隆方式。

Java类库中的应用:

java.lang.Object#clone()

识别方法: 原型可以简单地通过 clone或 copy等方法来识别。

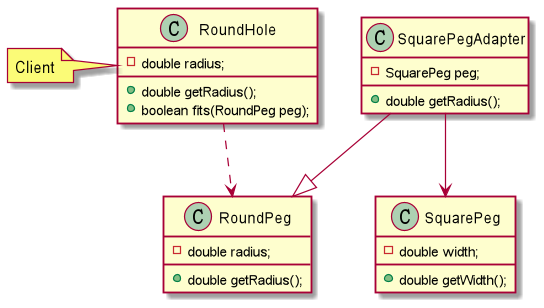

适配器模式:一种结构型设计模式, 它能使接口不兼容的对象能够相互合作。

在应用程序中我们可能需要将两个不同接口的类来进行通信,在不修改这两个的前提下我们可能会需要某个中间件来完成这个衔接的过程。这个中间件就是适配器。所谓适配器模式就是将一个类的接口,转换成客户期望的另一个接口。它可以让原本两个不兼容的接口能够无缝完成对接。作为中间件的适配器将目标类和适配者解耦,增加了类的透明性和可复用性。

Java类库中的应用:

java.util.Arrays#asList()java.util.Collections#list()java.util.Collections#enumeration()java.io.InputStreamReader(InputStream)java.io.OutputStreamWriter(OutputStream)javax.xml.bind.annotation.adapters.XmlAdapter#marshal()

识别方法:适配器可以通过以不同抽象或接口类型实例为参数的构造函数来识别。 当适配器的任何方法被调用时, 它会将参数转换为合适的格式, 然后将调用定向到其封装对象中的一个或多个方法。

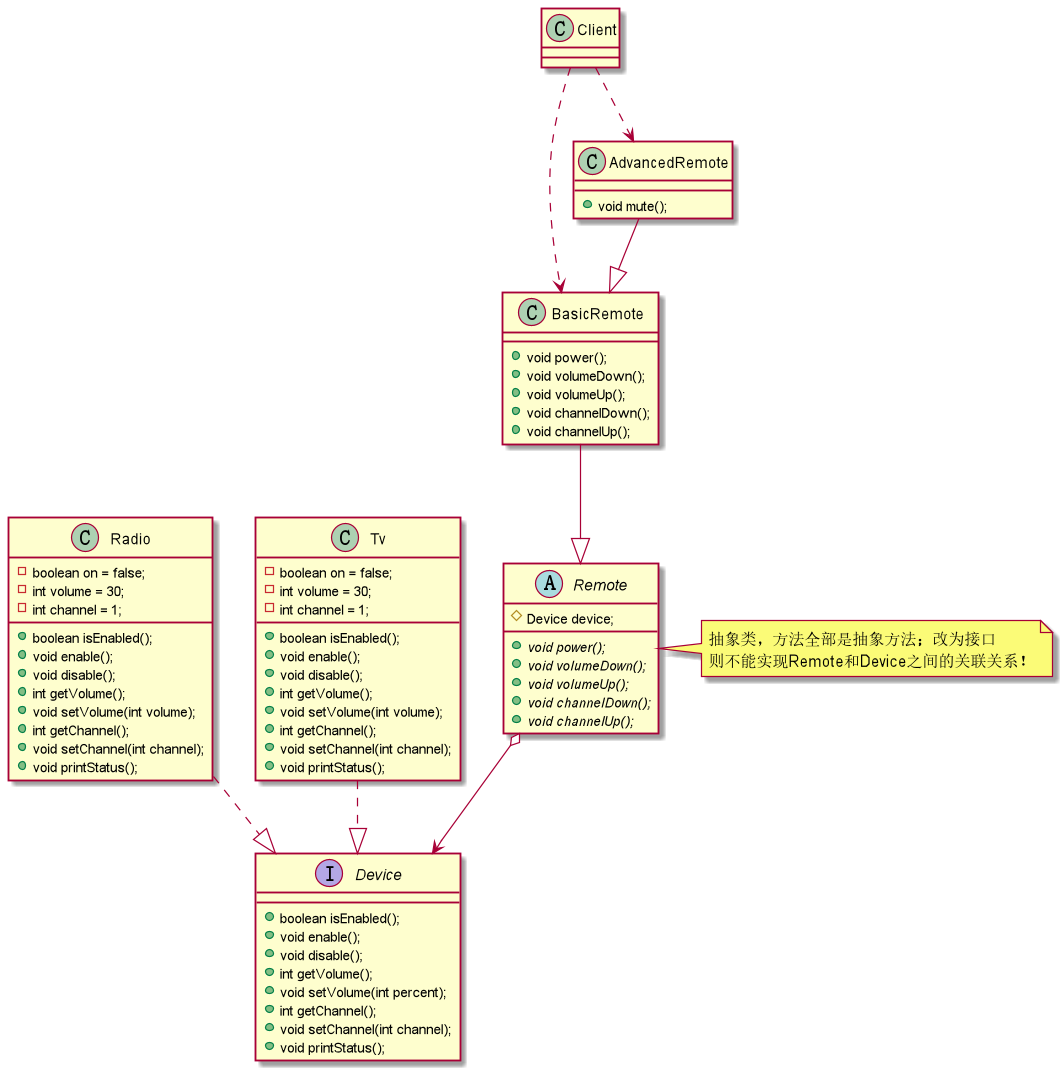

桥接模式:一种结构型设计模式, 可将一个大类或一系列紧密相关的类拆分为抽象和实现两个独立的层次结构, 从而能在开发时分别使用。

如果说某个系统能够从多个角度来进行分类,且每一种分类都可能会变化,那么我们需要做的就是讲这多个角度分离出来,使得他们能独立变化,减少他们之间的耦合,这个分离过程就使用了桥接模式。所谓桥接模式就是讲抽象部分和实现部分隔离开来,使得他们能够独立变化。桥接模式将继承关系转化成关联关系(关联优于继承),封装了变化,完成了解耦,减少了系统中类的数量,也减少了代码量。

使用示例: 桥接模式在处理跨平台应用、支持多种类型的数据库服务器或与多个特定种类(例如云平台和社交网络等)的API供应商协作时会特别有用。

识别方法: 桥接可以通过一些控制实体及其所依赖的多个不同平台之间的明确区别来进行识别。

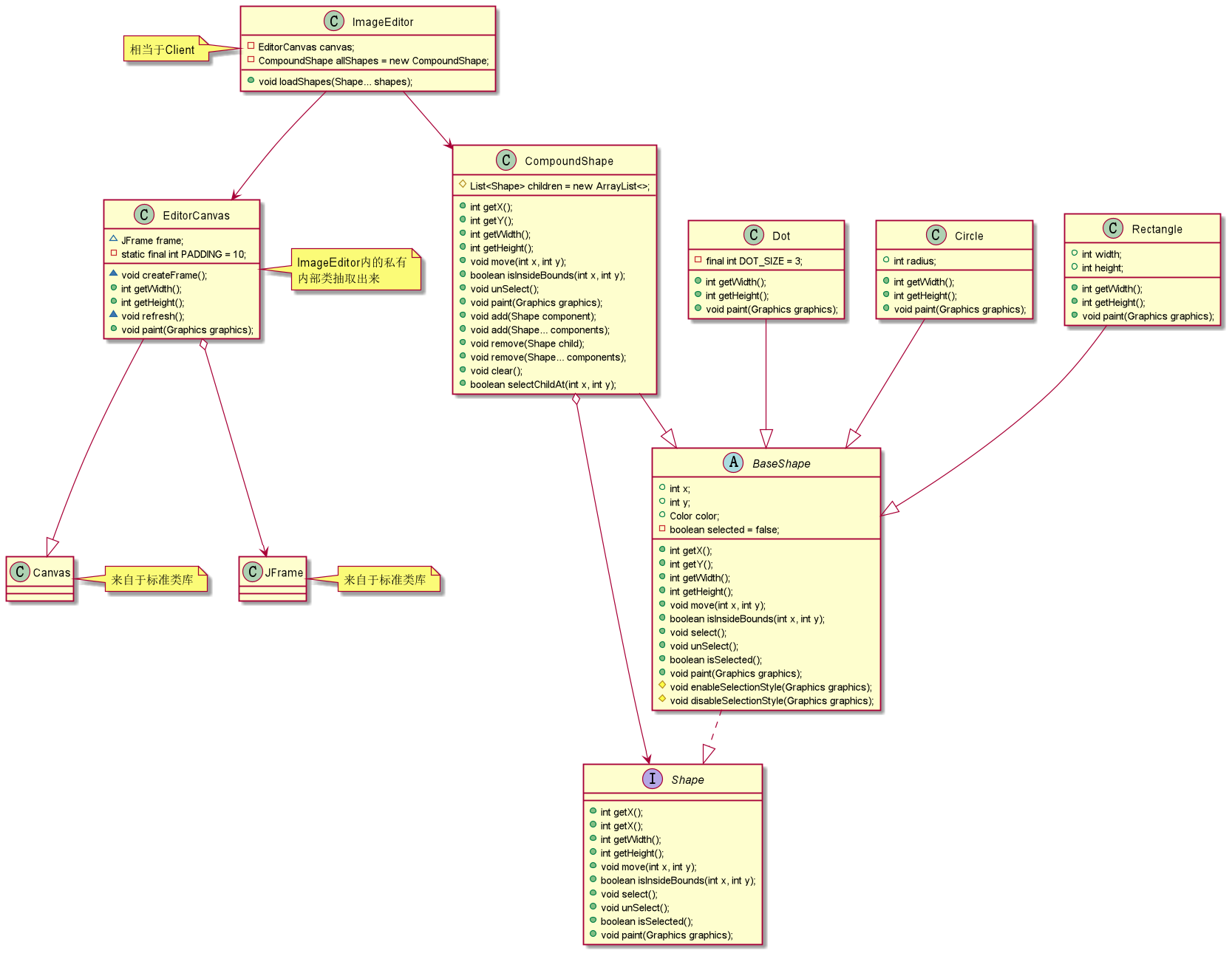

组合模式:一种结构型设计模式, 你可以使用它将对象组合成树状结构, 并且能像使用独立对象一样使用它们。

组合模式组合多个对象形成树形结构以表示“整体-部分”的结构层次。它定义了如何将容器对象和叶子对象进行递归组合,使得客户在使用的过程中无须进行区分,可以对他们进行一致的处理。在使用组合模式中需要注意一点也是组合模式最关键的地方:叶子对象和组合对象实现相同的接口。这就是组合模式能够将叶子节点和对象节点进行一致处理的原因。

虽然组合模式能够清晰地定义分层次的复杂对象,也使得增加新构件也更容易,但是这样就导致了系统的设计变得更加抽象,如果系统的业务规则比较复杂的话,使用组合模式就有一定的挑战了。

Java类库中的应用:

java.awt.Container#add(Component)javax.faces.component.UIComponent#getChildren()

识别方法: 组合可以通过将同一抽象或接口类型的实例放入树状结构的行为方法来轻松识别。

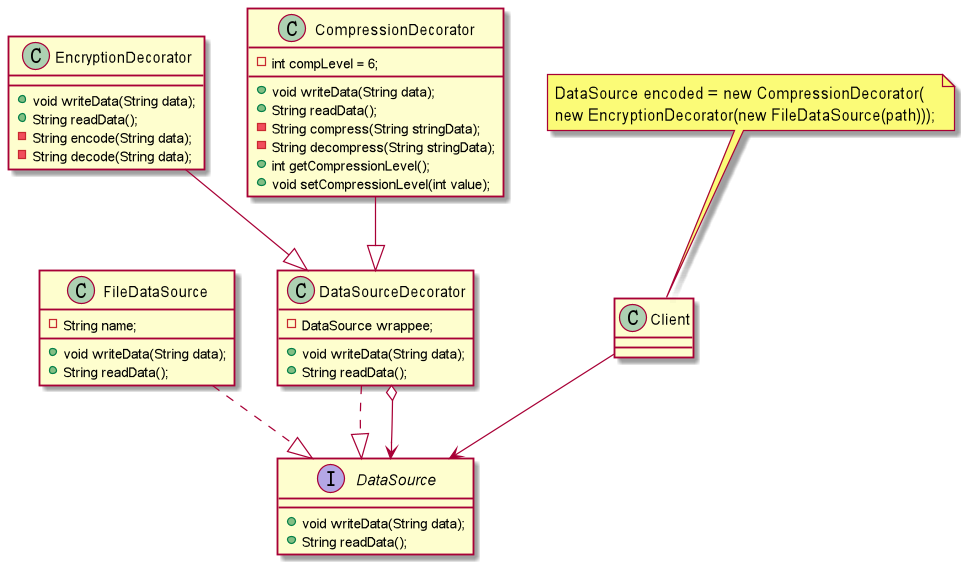

装饰模式:一种结构型设计模式, 允许你通过将对象放入包含行为的特殊封装对象中来为原对象绑定新的行为。

我们可以通过继承和组合的方式来给一个对象添加行为,虽然使用继承能够很好拥有父类的行为,但是它存在几个缺陷:一、对象之间的关系复杂的话,系统变得复杂不利于维护。二、容易产生“类爆炸”现象。三、是静态的。在这里我们可以通过使用装饰者模式来解决这个问题。装饰者模式,动态地将责任附加到对象上。若要扩展功能,装饰者提供了比继承更加有弹性的替代方案。虽然装饰者模式能够动态将责任附加到对象上,但是他会产生许多的细小对象,增加了系统的复杂度。

Java类库中的应用:

java.io.InputStream、 OutputStream、 Reader 和 Writer 的所有代码都有以自身类型的对象作为参数的构造函数。java.util.Collections; checkedXXX()、 synchronizedXXX() 和 unmodifiableXXX() 方法。javax.servlet.http.HttpServletRequestWrapper 和 HttpServletResponseWrapper。

识别方法:装饰可通过以当前类或对象为参数的创建方法或构造函数来识别。

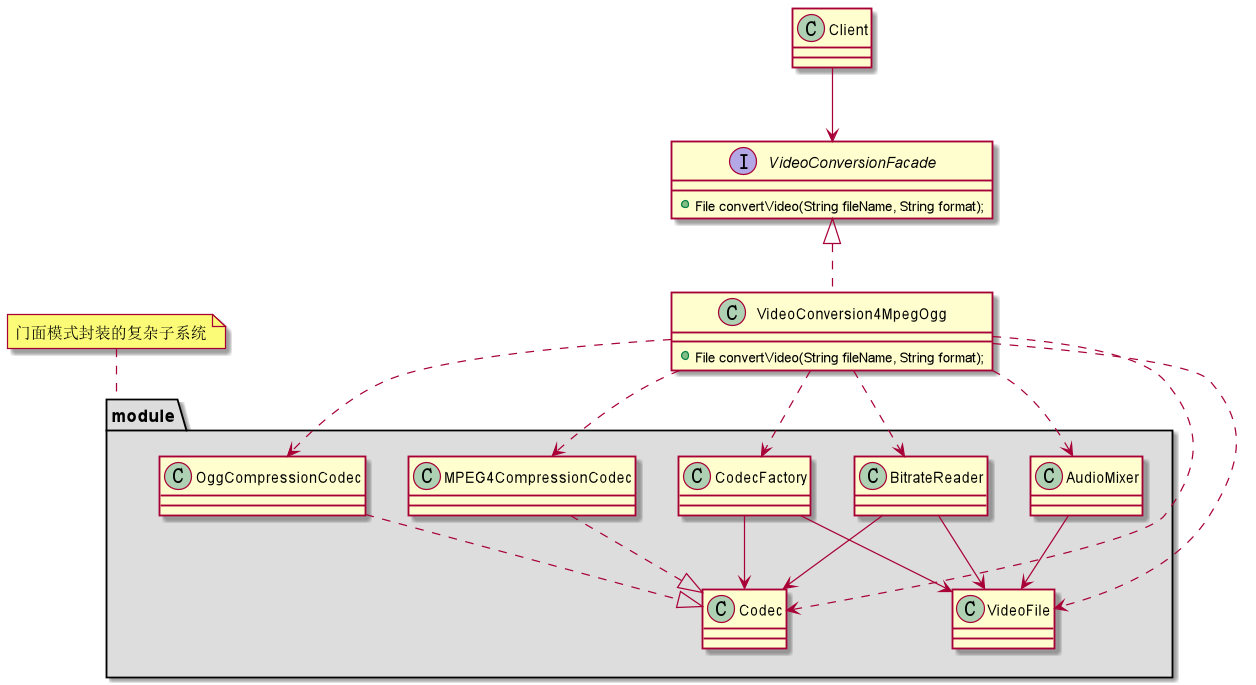

外观模式:也称为"门面模式"。一种结构型设计模式, 能为程序库、 框架或其他复杂类提供一个简单的接口。

我们都知道类与类之间的耦合越低,那么可复用性就越好,如果两个类不必彼此通信,那么就不要让这两个类发生直接的相互关系,如果需要调用里面的方法,可以通过第三者来转发调用。外观模式非常好的诠释了这段话。外观模式提供了一个统一的接口,用来访问子系统中的一群接口。它让一个应用程序中子系统间的相互依赖关系减少到了最少,它给子系统提供了一个简单、单一的屏障,客户通过这个屏障来与子系统进行通信。通过使用外观模式,使得客户对子系统的引用变得简单了,实现了客户与子系统之间的松耦合。但是它违背了“开闭原则”,因为增加新的子系统可能需要修改外观类或客户端的源代码。

Java类库中的应用:

javax.faces.context.FacesContext在底层使用了LifeCycle、ViewHandler和NavigationHandler这几个类,但绝大多数客户端不知道。javax.faces.context.ExternalContext在内部使用了ServletContext、HttpSession、HttpServletRequest、HttpServletResponse和其他一些类。

识别方法:外观可以通过使用简单接口, 但将绝大部分工作委派给其他类的类来识别。 通常情况下, 外观管理着其所使用的对象的完整生命周期。

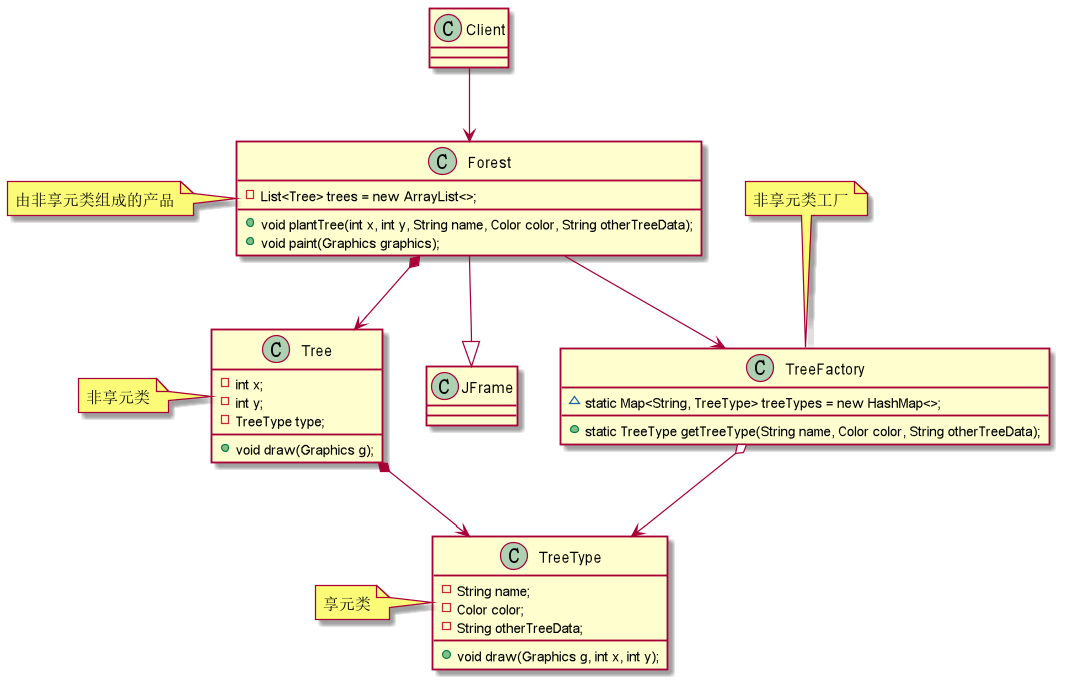

享元模式:一种结构型设计模式, 它摒弃了在每个对象中保存所有数据的方式, 通过共享多个对象所共有的相同状态, 让你能在有限的内存容量中载入更多对象。

在一个系统中对象会使得内存占用过多,特别是那些大量重复的对象,这就是对系统资源的极大浪费。享元模式对对象的重用提供了一种解决方案,它使用共享技术对相同或者相似对象实现重用。享元模式就是运行共享技术有效地支持大量细粒度对象的复用。系统使用少量对象,而且这些都比较相似,状态变化小,可以实现对象的多次复用。这里有一点要注意:享元模式要求能够共享的对象必须是细粒度对象。享元模式通过共享技术使得系统中的对象个数大大减少了,同时享元模式使用了内部状态和外部状态,同时外部状态相对独立,不会影响到内部状态,所以享元模式能够使得享元对象在不同的环境下被共享。同时正是分为了内部状态和外部状态,享元模式会使得系统变得更加复杂,同时也会导致读取外部状态所消耗的时间过长。

Java类库中的应用:

java.lang.Integer#valueOf(int)]以及Boolean、Byte、Character、Short、Long和BigDecimal

识别方法: 享元可以通过构建方法来识别, 它会返回缓存对象而不是创建新的对象。

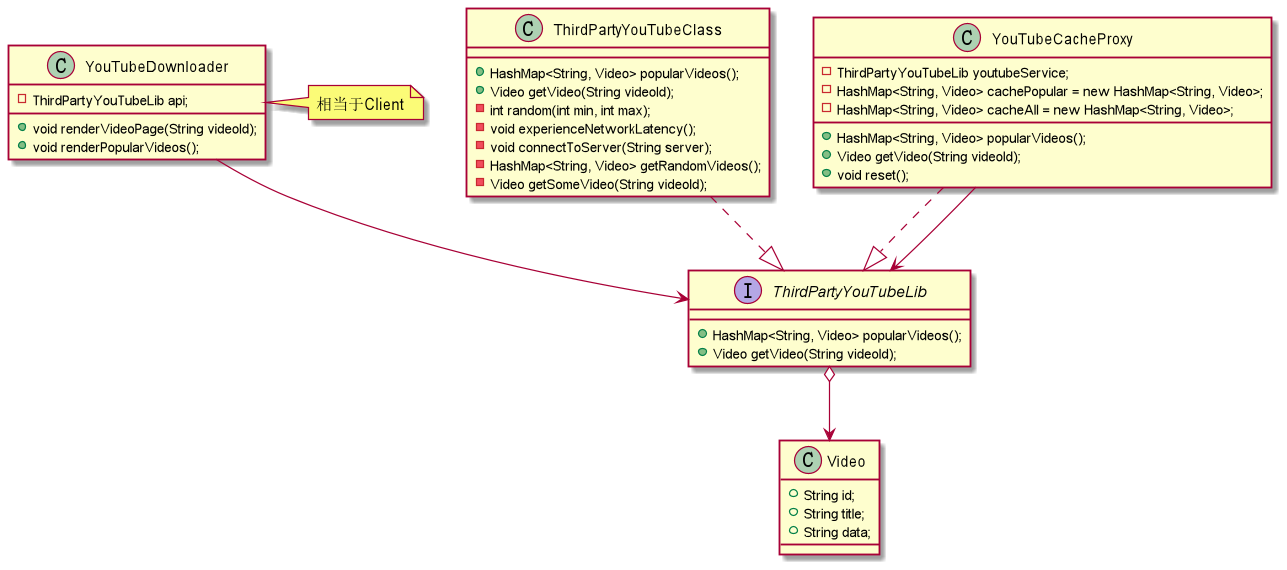

代理模式:一种结构型设计模式, 让你能够提供对象的替代品或其占位符。 代理控制着对于原对象的访问, 并允许在将请求提交给对象前后进行一些处理。

代理模式就是给一个对象提供一个代理,并由代理对象控制对原对象的引用。它使得客户不能直接与真正的目标对象通信。代理对象是目标对象的代表,其他需要与这个目标对象打交道的操作都是和这个代理对象在交涉。代理对象可以在客户端和目标对象之间起到中介的作用,这样起到了的作用不仅保护了目标对象,同时也在一定程度上面减少了系统的耦合度。

Java类库中的应用:

java.lang.reflect.Proxyjava.rmi.*javax.ejb.EJBjavax.inject.Injectjavax.persistence.PersistenceContext

识别方法:代理模式会将所有实际工作委派给一些其他对象。 除非代理是某个服务的子类, 否则每个代理方法最后都应该引用一个服务对象。

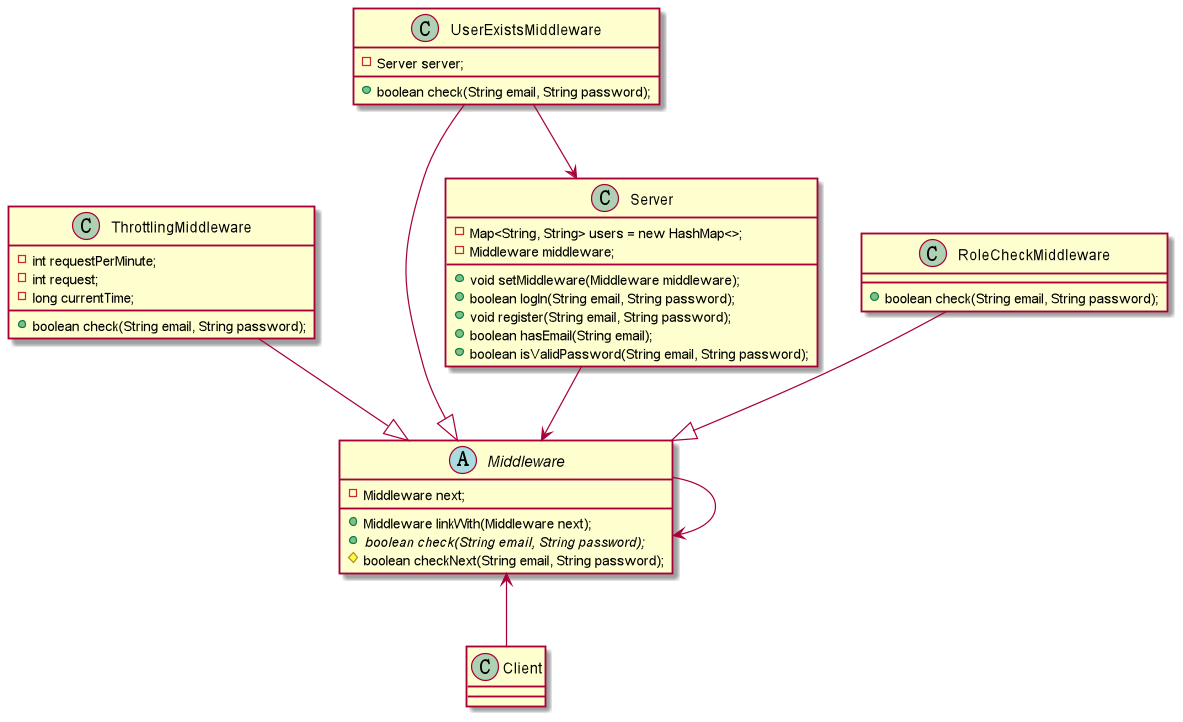

责任链模式:亦称"职责链模式" 。一种行为设计模式, 允许你将请求沿着处理者链进行发送。 收到请求后, 每个处理者均可对请求进行处理, 或将其传递给链上的下个处理者。

职责链模式描述的请求如何沿着对象所组成的链来传递的。它将对象组成一条链,发送者将请求发给链的第一个接收者,并且沿着这条链传递,直到有一个对象来处理它或者直到最后也没有对象处理而留在链末尾端。避免请求发送者与接收者耦合在一起,让多个对象都有可能接收请求,将这些对象连接成一条链,并且沿着这条链传递请求,直到有对象处理它为止,这就是职责链模式。在职责链模式中,使得每一个对象都有可能来处理请求,从而实现了请求的发送者和接收者之间的解耦。同时职责链模式简化了对象的结构,它使得每个对象都只需要引用它的后继者即可,而不必了解整条链,这样既提高了系统的灵活性也使得增加新的请求处理类也比较方便。但是在职责链中我们不能保证所有的请求都能够被处理,而且不利于观察运行时特征。

Java类库中的应用:

javax.servlet.Filter#doFilter()java.util.logging.Logger#log()

识别方法:该模式可通过一组对象的行为方法间接调用其他对象的相同方法来识别, 而且所有对象都会遵循相同的接口。

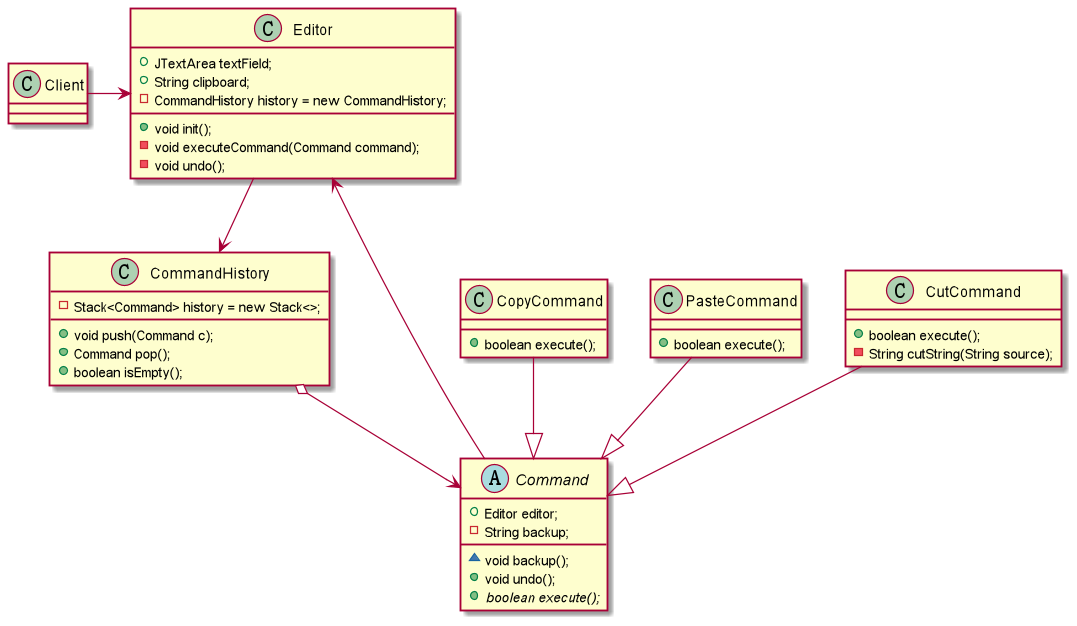

命令模式:一种行为设计模式, 它可将请求转换为一个包含与请求相关的所有信息的独立对象。 该转换让你能根据不同的请求将方法参数化、 延迟请求执行或将其放入队列中, 且能实现可撤销操作。

有些时候我们想某个对象发送一个请求,但是我们并不知道该请求的具体接收者是谁,具体的处理过程是如何的,们只知道在程序运行中指定具体的请求接收者即可,对于这样将请求封装成对象的我们称之为命令模式。所以命令模式将请求封装成对象,以便使用不同的请求、队列或者日志来参数化其他对象。同时命令模式支持可撤销的操作。

命令模式可以将请求的发送者和接收者之间实现完全的解耦,发送者和接收者之间没有直接的联系,发送者只需要知道如何发送请求命令即可,其余的可以一概不管,甚至命令是否成功都无需关心。同时我们可以非常方便的增加新的命令,但是可能就是因为方便和对请求的封装就会导致系统中会存在过多的具体命令类。

Java类库中的应用:

-

java.lang.Runnable -

javax.swing.Action

识别方法: 命令模式可以通过抽象或接口类型 (发送者) 中的行为方法来识别, 该类型调用另一个不同的抽象或接口类型 (接收者) 实现中的方法, 该实现则是在创建时由命令模式的实现封装。 命令类通常仅限于一些特殊行为。

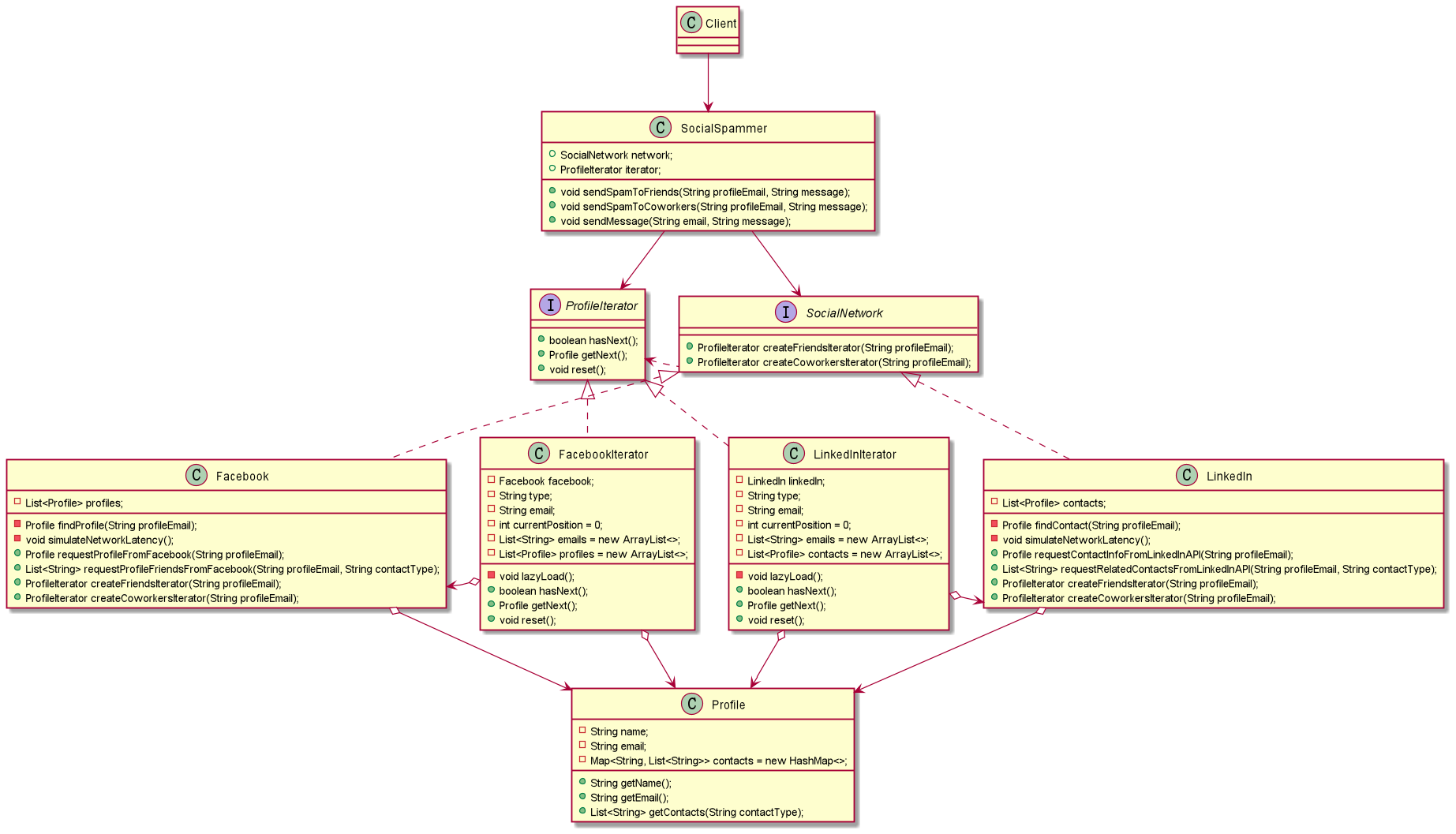

迭代器模式:一种行为设计模式, 让你能在不暴露集合底层表现形式 (列表、 栈和树等) 的情况下遍历集合中所有的元素。

对于迭代在编程过程中我们经常用到,能够游走于聚合内的每一个元素,同时还可以提供多种不同的遍历方式,这就是迭代器模式的设计动机。在我们实际的开发过程中,我们可能会需要根据不同的需求以不同的方式来遍历整个对象,但是我们又不希望在聚合对象的抽象接口中充斥着各种不同的遍历操作,于是我们就希望有某个东西能够以多种不同的方式来遍历一个聚合对象,这时迭代器模式出现了。

何为迭代器模式?所谓迭代器模式就是提供一种方法顺序访问一个聚合对象中的各个元素,而不是暴露其内部的表示。迭代器模式是将迭代元素的责任交给迭代器,而不是聚合对象,我们甚至在不需要知道该聚合对象的内部结构就可以实现该聚合对象的迭代。通过迭代器模式,使得聚合对象的结构更加简单,它不需要关注它元素的遍历,只需要专注它应该专注的事情,这样就更加符合单一职责原则了。

Java类库中的应用:

java.util.Iteratorjava.util.Scannerjava.util.Enumeration

识别方法:迭代器可以通过导航方法 (例如 next和 previous等) 来轻松识别。 使用迭代器的客户端代码可能没有其所遍历的集合的直接访问权限。

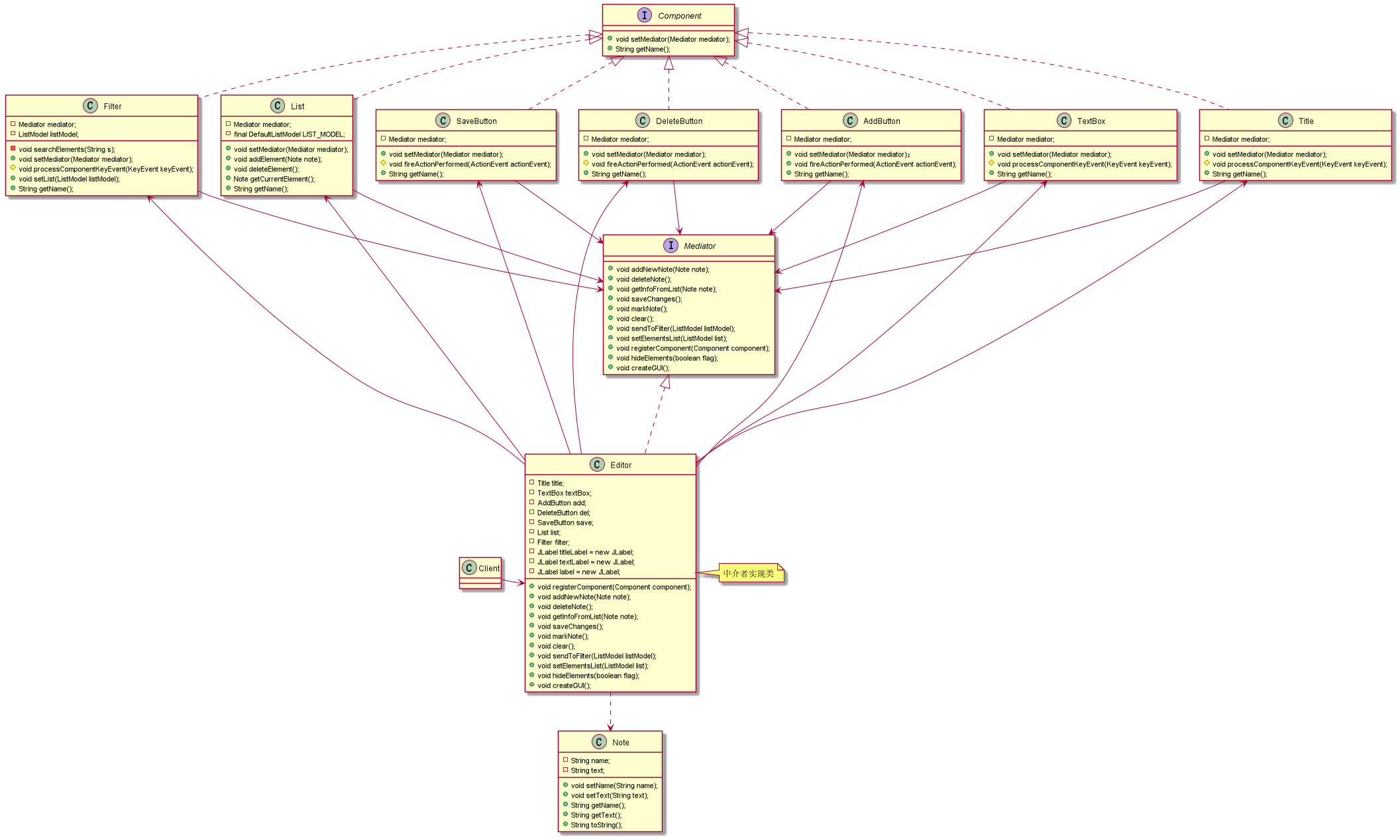

中介者模式:一种行为设计模式, 能让你减少对象之间混乱无序的依赖关系。 该模式会限制对象之间的直接交互, 迫使它们通过一个中介者对象进行合作。

租房各位都有过的经历吧!在这个过程中中介结构扮演着很重要的角色,它在这里起到一个中间者的作用,给我们和房主互相传递信息。在外面软件的世界里同样需要这样一个中间者。在我们的系统中有时候会存在着对象与对象之间存在着很强、复杂的关联关系,如果让他们之间有直接的联系的话,必定会导致整个系统变得非常复杂,而且可扩展性很差!在前面我们就知道如果两个类之间没有不必彼此通信,我们就不应该让他们有直接的关联关系,如果实在是需要通信的话,我们可以通过第三者来转发他们的请求。同样,这里我们利用中介者来解决这个问题。

所谓中介者模式就是用一个中介对象来封装一系列的对象交互,中介者使各对象不需要显式地相互引用,从而使其耦合松散,而且可以独立地改变它们之间的交互。在中介者模式中,中介对象用来封装对象之间的关系,各个对象可以不需要知道具体的信息通过中介者对象就可以实现相互通信。它减少了对象之间的互相关系,提供了系统可复用性,简化了系统的结构。

在中介者模式中,各个对象不需要互相知道了解,他们只需要知道中介者对象即可,但是中介者对象就必须要知道所有的对象和他们之间的关联关系,正是因为这样就导致了中介者对象的结构过于复杂,承担了过多的职责,同时它也是整个系统的核心所在,它有问题将会导致整个系统的问题。所以如果在系统的设计过程中如果出现“多对多”的复杂关系群时,千万别急着使用中介者模式,而是要仔细思考是不是您设计的系统存在问题。

Java类库中的应用:

-

java.util.Timer -

java.util.concurrent.Executor#execute() -

java.util.concurrent.ExecutorService -

java.util.concurrent.ScheduledExecutorService(invokeXXX()和submit()方法) -

java.lang.reflect.Method#invoke()

备忘录模式:一种行为设计模式, 允许在不暴露对象实现细节的情况下保存和恢复对象之前的状态。

后悔药人人都想要,但是事实却是残酷的,根本就没有后悔药可买,但是也不仅如此,在软件的世界里就有后悔药!备忘录模式就是一种后悔药,它给我们的软件提供后悔药的机制,通过它可以使系统恢复到某一特定的历史状态。

所谓备忘录模式就是在不破坏封装的前提下,捕获一个对象的内部状态,并在该对象之外保存这个状态,这样可以在以后将对象恢复到原先保存的状态。它实现了对信息的封装,使得客户不需要关心状态保存的细节。保存就要消耗资源,所以备忘录模式的缺点就在于消耗资源。如果类的成员变量过多,势必会占用比较大的资源,而且每一次保存都会消耗一定的内存。

Java类库中的应用:

- 所有

java.io.Serializable的实现都可以模拟备忘录 - 所有

javax.faces.component.StateHolder的实现

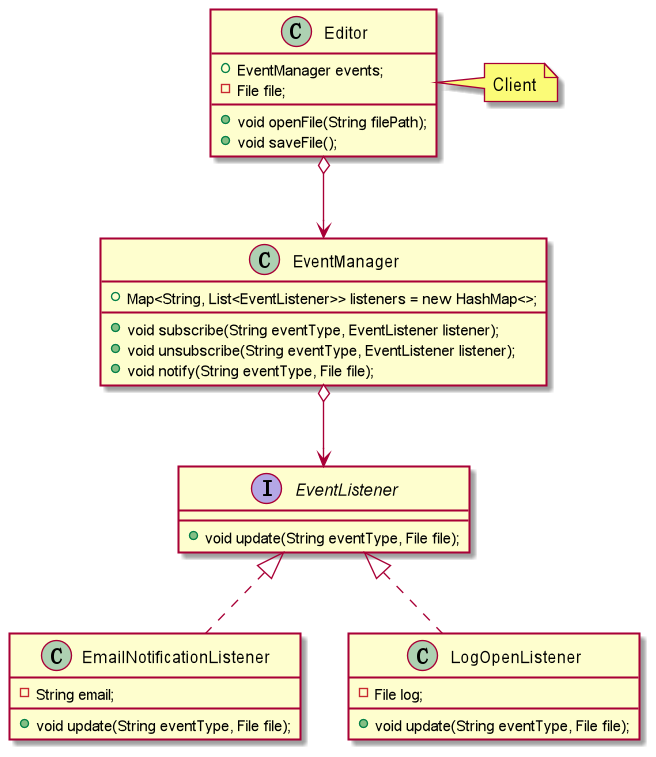

观察者模式:亦称"事件订阅者"/"监听者"/"Event-Subscriber"/"Listener"/"Observer"。是一种行为设计模式, 允许你定义一种订阅机制, 可在对象事件发生时通知多个"观察"该对象的其他对象。

何谓观察者模式?观察者模式定义了对象之间的一对多依赖关系,这样一来,当一个对象改变状态时,它的所有依赖者都会收到通知并且自动更新。在这里,发生改变的对象称之为观察目标,而被通知的对象称之为观察者。一个观察目标可以对应多个观察者,而且这些观察者之间没有相互联系,所以么可以根据需要增加和删除观察者,使得系统更易于扩展。所以观察者提供了一种对象设计,让主题和观察者之间以松耦合的方式结合。

Java类库中的应用:

java.util.Observer/java.util.Observable(极少在真实世界中使用)java.util.EventListener的所有实现(几乎广泛存在于Swing组件中)javax.servlet.http.HttpSessionBindingListenerjavax.servlet.http.HttpSessionAttributeListenerjavax.faces.event.PhaseListener

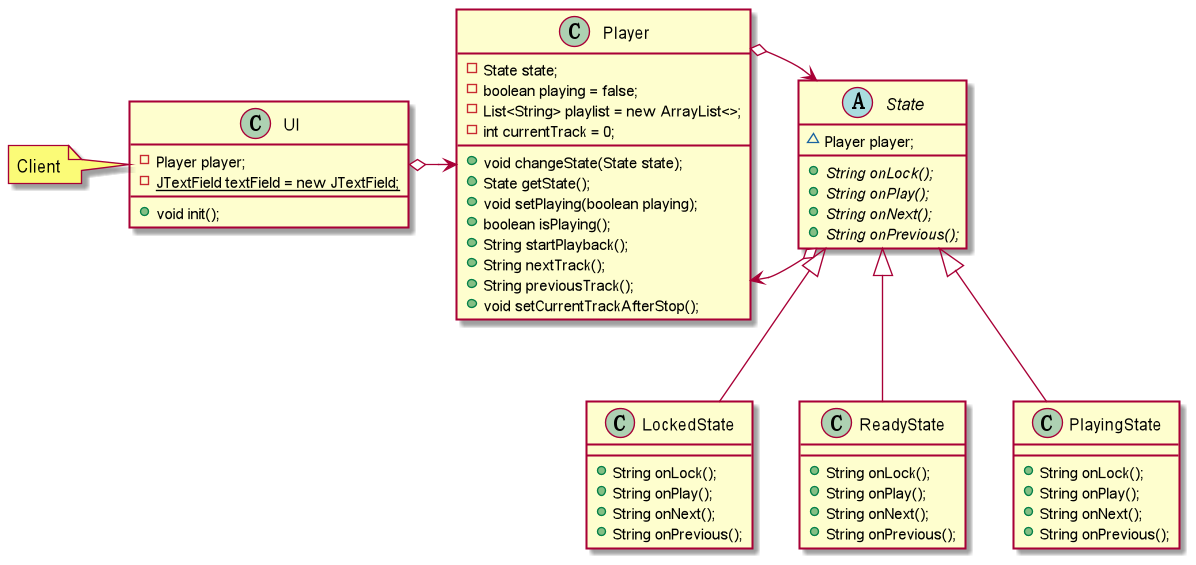

状态模式:一种行为设计模式, 让你能在一个对象的内部状态变化时改变其行为, 使其看上去就像改变了自身所属的类一样。

在很多情况下我们对象的行为依赖于它的一个或者多个变化的属性,这些可变的属性我们称之为状态,也就是说行为依赖状态,即当该对象因为在外部的互动而导致他的状态发生变化,从而它的行为也会做出相应的变化。对于这种情况,我们是不能用行为来控制状态的变化,而应该站在状态的角度来思考行为,即是什么状态就要做出什么样的行为。这个就是状态模式。

所以状态模式就是允许对象在内部状态发生改变时改变它的行为,对象看起来好像修改了它的类。

在状态模式中我们可以减少大块的if…else语句,它是允许态转换逻辑与状态对象合成一体,但是减少if…else语句的代价就是会换来大量的类,所以状态模式势必会增加系统中类或者对象的个数。同时,状态模式是将所有与某个状态有关的行为放到一个类中,并且可以方便地增加新的状态,只需要改变对象状态即可改变对象的行为。但是这样就会导致系统的结构和实现都会比较复杂,如果使用不当就会导致程序的结构和代码混乱,不利于维护。

Java类库中的应用:

javax.faces.lifecycle.LifeCycle#execute()(由FacesServlet控制,行为依赖于当前JSF生命周期的阶段(状态))。

识别方法:状态模式可通过受外部控制且能根据对象状态改变行为的方法来识别。

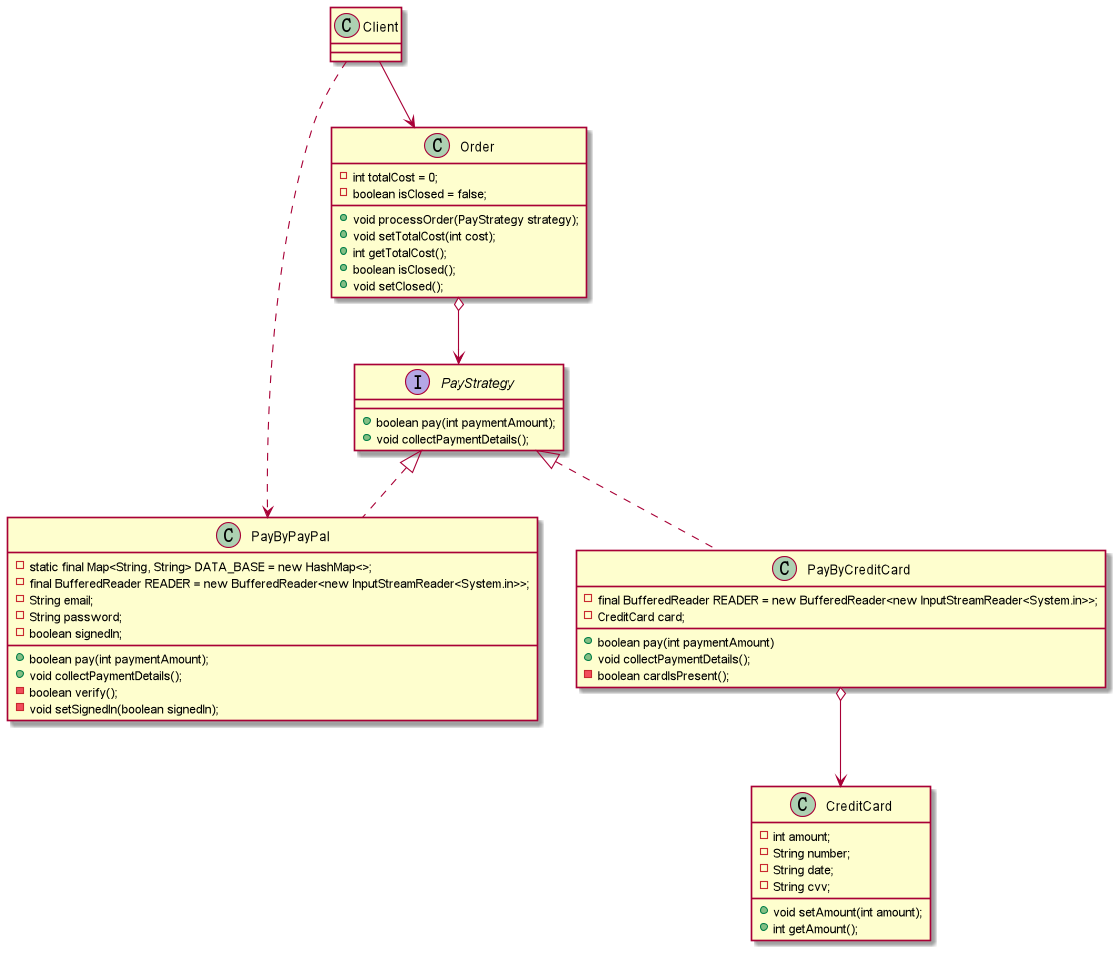

策略模式:一种行为设计模式, 它能让你定义一系列算法, 并将每种算法分别放入独立的类中, 以使算法的对象能够相互替换。

我们知道一件事可能会有很多种方式来实现它,但是其中总有一种最高效的方式,在软件开发的世界里面同样如此,我们也有很多中方法来实现一个功能,但是我们需要一种简单、高效的方式来实现它,使得系统能够非常灵活,这就是策略模式。

策略模式就是定义了算法族,分别封装起来,让他们之前可以互相转换,此模式然该算法的变化独立于使用算法的客户。在策略模式中它将这些解决问题的方法定义成一个算法群,每一个方法都对应着一个具体的算法,这里的一个算法我就称之为一个策略。虽然策略模式定义了算法,但是它并不提供算法的选择,即什么算法对于什么问题最合适这是策略模式所不关心的,所以对于策略的选择还是要客户端来做。客户必须要清楚的知道每个算法之间的区别和在什么时候什么地方使用什么策略是最合适的,这样就增加客户端的负担。同时,策略模式也非常完美的符合了"开闭原则",用户可以在不修改原有系统的基础上选择算法或行为,也可以灵活地增加新的算法或行为。但是一个策略对应一个类将会是系统产生很多的策略类。

Java类库中的应用:

-

对

java.util.Comparator#compare()的调用来自Collections#sort()。 -

javax.servlet.http.HttpServlet#service()方法, 还有接受HttpServletRequest和HttpServletResponse对象作为参数的doXXX()方法。 -

javax.servlet.Filter#doFilter()。

识别方法: 策略模式可以通过允许嵌套对象完成实际工作的方法以及允许将该对象替换为不同对象的设置器来识别。

模板方法模式:是一种行为设计模式, 它在超类中定义了一个算法的框架(骨架), 允许子类在不修改结构的情况下重写算法的特定步骤。

有些时候我们做某几件事情的步骤都差不多,仅有那么一小点的不同,在软件开发的世界里同样如此,如果我们都将这些步骤都一一做的话,费时费力不讨好。所以我们可以将这些步骤分解、封装起来,然后利用继承的方式来继承即可,当然不同的可以自己重写实现嘛!这就是模板方法模式提供的解决方案。

所谓模板方法模式就是在一个方法中定义一个算法的骨架,而将一些步骤延迟到子类中。模板方法使得子类可以在不改变算法结构的情况下,重新定义算法中的某些步骤。模板方法模式就是基于继承的代码复用技术的。在模板方法模式中,我们可以将相同部分的代码放在父类中,而将不同的代码放入不同的子类中。也就是说我们需要声明一个抽象的父类,将部分逻辑以具体方法以及具体构造函数的形式实现,然后声明一些抽象方法让子类来实现剩余的逻辑,不同的子类可以以不同的方式来实现这些逻辑。所以模板方法的模板其实就是一个普通的方法,只不过这个方法是将算法实现的步骤封装起来的。

Java类库中的应用:

java.io.InputStream、java.io.OutputStream、java.io.Reader和java.io.Writer的所有非抽象方法java.util.AbstractList、java.util.AbstractSet和java.util.AbstractMap的所有非抽象方法javax.servlet.http.HttpServlet,所有默认发送HTTP 405"方法不允许"错误响应的doXXX()方法,你可随时对其进行重写

识别方法:模版方法可以通过行为方法来识别,该方法已有一个在基类中定义的"默认"行为。

-

泛化关系(继承关系):带三角箭头的实线,箭头指向父类。

-

实现关系**:带三角箭头的虚线,箭头指向接口**。

-

关联关系:

- 双向关联**:有两个普通箭头或者没有箭头的实线。**

- 单向关联**:带普通箭头的实线,指向被拥有者。**

-

聚合关系:是整体与部分的关系,且部分可以离开整体而单独存在。聚合是一种强的关联关系。

- 带空心菱形的实心线,菱形指向整体。

-

组合关系:是整体与部分的关系,但部分不能离开整体而单独存在。组合是一种比聚合还要强的关联关系。

- 带实心菱形的实线,菱形指向整体。

-

依赖关系:是一种使用的关系,即一个类的实现需要另一个类的协助。

- 带普通箭头的虚线,指向被使用者。

-

可见性:

- public:+

- protected:#

- private:-

- package:~

- IDEA安装PlantUML-integration插件。

- 安装Graphviz软件。

- 学习PlantUML语法。

- 依赖关系:

..> - 继承关系:

--|> - 实现关系:

..|> - 关联关系:

Computer --> Mouse - 聚合关系:

Person o-- IDCard - 组合关系:

Person *-- Head

- 依赖关系:

参考文章博客:JDK里的设计模式、《HeadFirst设计模式》、UML类图、设计模式总结、PlantUML使用教程、PlantUML官方教程、设计模式的学习、设计模式英文教程

程序:是指令和数据的有序集合,本身没有任何运行含义,是一个静态的概念。

进程:程序执行的过程,是一个动态的概念。进程是系统资源分配的单位,一个进程中可以包含多个线程。

- 进程是操作系统分配资源的最小单元。

- 一个程序至少有一个进程,一个进程至少有一个线程。

线程:线程是CPU调度和执行的单位。Java默认有2个线程(main和gc)。Java本身并不能真正开启线程,底层通过native本地方法使用C语言开启线程。

- 线程是操作系统调度的最小单元。

并发:CPU一核,模拟出来多条线程,快速交替。(查看CPU的核数:Runtime.getRuntime().availableProcessors())。并发编程的本质是充分利用CPU的资源。

并行:CPU多核,多个线程可以同时执行。(使用线程池提高性能)

线程创建的三种方式:

- Thread类

# 1. 自定义线程类继承Thread类

# 2. 重写Run方法,编写线程执行体

# 3. 创建线程对象,调用start方法启动线程- Runnable接口

# 1. 实现Runnable接口

# 2. 实现重写Run方法,编写线程执行体

# 3. 创建线程对象,调用start方法启动线程

这里与Thread类有区别:Runnable实现类必须作为Thread类的构造参数;本质是Thread类实现了Runnable接口。

# 注意:避免单继承局限性,推荐使用Runnable接口- Callable接口

# 1. 实现Callable接口,需要返回值类型

# 2. 重写call方法,需要抛出异常

# 3. 创建目标对象

# 4. 创建执行服务(线程池): ExecutorService service = Executors.newFixedThreadPool(1);

# 5. 提交执行(submit方法): Future<返回值类型> result1 = service.submit(t1);

# 6. 获取结果: 返回值类型 r1 = result1.get();

# 7. 关闭服务: service.shutdownNow();

# Callable的好处:可以定义返回值;可以抛出异常静态代理模式:

Lamda表达式:

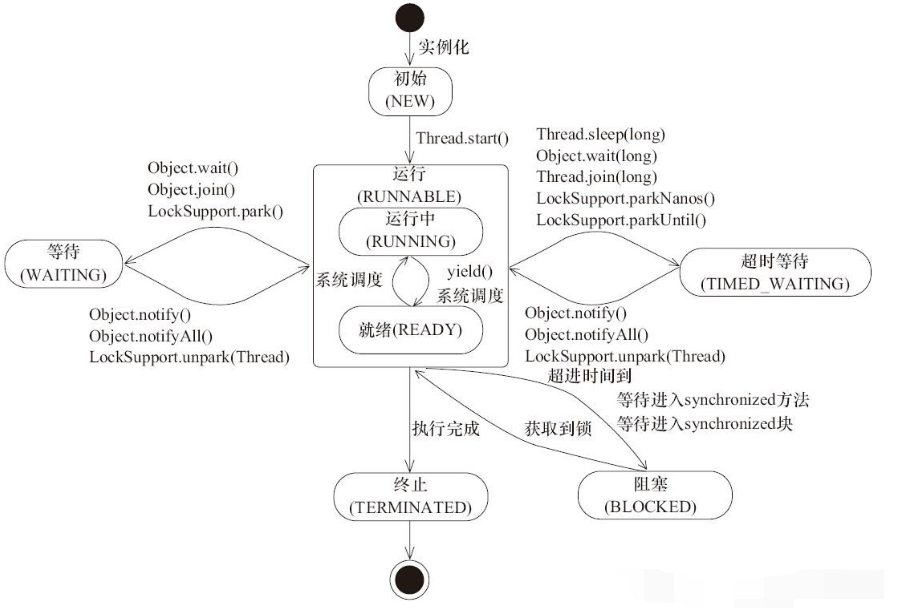

线程的六种状态:

- 创建(NEW):新创建了一个线程对象,但还没有调用start()方法。

- 运行(RUNNABLE):Java线程中将就绪(READY)和运行中(RUNNING)两种状态笼统的称为"运行"。

- 阻塞(BLOCKED):表示线程阻塞于锁。

- 等待(WAITING):进入该状态的线程需要等待其他线程做出一些特定动作(通知或中断)。

- 超时等待(TIMED_WAITING):该状态不同于WAITING,它可以在指定的时间后自行返回。

- 死亡(TERMINATED):表示该线程已经执行完毕。

# 1. 如何停止线程?

# 1.1 不建议使用stop方法(已废弃)

# 1.2 建议线程正常停止(可以利用循环次数控制,不建议死循环)

# 1.3 或者使用标志位

# 2. 线程休眠(sleep)

# 2.1 sleep(时间)指定当前线程阻塞的毫秒数

# 2.2 sleep存在异常InterruptedException

# 2.3 sleep时间达到后线程进入就绪状态

# 2.4 sleep可以模拟网络延时、倒计时等

# 2.5 每一个对象都有一个锁,sleep不会释放锁

# 3. 线程礼让(yield)

# 3.1 礼让线程,让当前正在执行的线程暂停,但不阻塞

# 3.2 将线程从运行状态转为就绪状态

# 3.3 让CPU重新调度,例如不一定成功,看CPU心情

# 4. 线程强制执行(join)

# 4.1 Join合并线程,待此线程执行完成后,再执行其他线程,其他线程阻塞(类似于插队)

# 5. 常见的与线程相关的方法

# 5.1 获取当前线程的名称:Thread.currentThread().getName()

# 5.2 获取线程状态的方法:thread.getState()

# 5.3 设置/获取线程的优先级:setPriority(int xxx),getPriority(),默认优先级是5守护线程:

- 线程分为用户线程和守护线程(使用**setDaemon(true)**可以设置为守护线程)。

- 虚拟机必须确保用户线程执行完毕(如main方法为用户线程)。

- 虚拟机不用等待守护线程执行完毕(如gc方法为守护线程)。

- 守护线程的应用:后台记录操作日志、监控内存、垃圾回收...

使用锁机制(synchronized)解决同步必然会带来如下问题:

- 一个线程持有锁会导致其他所有需要此锁的线程挂起。

- 在多线程竞争下,加锁、释放锁会导致比较多的上下文切换和调度延时,会引起性能问题。

- 如果一个优先级高的线程等待一个优先级低的线程释放锁,会导致优先级倒置,引起性能问题。

同步方法:在方法上添加synchronized关键字。若将一个大的方法声明为synchronized将会影响效率。

同步块:

- 在代码块上添加synchronized(同步监视器)。

- 同步监视器可以是任何对象,但是推荐使用共享资源作为同步监视器。

- 同步方法中无需指定同步监视器,因为同步方法的同步监视器就是this。

死锁:多个线程各自占有一些共享资源,并且互相等待其他线程占有的资源才能运行,而导致两个或者多个线程都在等待对方释放资源,都停止执行的情形。某一个同步块同时拥有"两个以上对象的锁"时,就可能会发生"死锁"问题。

产生死锁的四个必要条件:

- 互斥条件:即当资源被一个线程使用(占有)时,别的线程不能使用。

- 不可抢占:资源请求者不能强制从资源占有者手中夺取资源,资源只能由资源占用者主动释放。

- 请求和保持:当资源的请求者在请求其他的资源的同时保持对原有资源的占有。

- 循环等待:即存在一个等待队列, P1占有P2的资源,P2占有P3的资源,P3占有P1的资源。

关于Lock锁:

- 从jdk5.0开始,Java提供了更强大的线程同步机制:通过显示定义同步锁对象来实现同步,同步锁使用Lock对象充当。

- java.util.concurrent.locks.Lock接口是控制多个线程对共享资源进行访问的工具。锁提供了对共享资源的独立访问,每次只能有一个线程对Lock对象加锁,线程开始访问共享资源之前应先获得Lock对象。

- ReentrantLock类实现了Lock,它拥有与synchronized相同的并发性和内存语义,在实现线程安全的控制中,比较常用的是ReentrantLock,可以显示加锁(lock()方法)和释放锁(unlock()方法)。

synchronized与Lock的对比:

- 类型不同:synchronized是内置的java关键字;Lock是一个类。

- 使用灵活性不同:synchronized无法判断获取锁的状态;Lock可以判断是否获取到了锁。

- 使用方法不用:synchronized是隐式锁,出了作用域自动释放;Lock是显示锁(需手动开启和释放锁,如果不释放锁,会造成死锁)。

- 锁的限制不同:synchronized加锁后,若线程没获取到锁,会一致等待下去;Lock锁不一定会等待下去(

lock.tryLock()方法)。 - 锁的类型不同:synchronized是可重入锁,不可中断的,非公平锁;Lock锁是可重入锁,但是可以判断锁,是非公平锁(可以自己设置)。(公平锁与非公平锁:公平锁遵循先来后到;非公平锁可以"插队"(Java默认是非公平锁))

- 使用范围不同:synchronized有代码块锁和方法锁;Lock只有代码块锁。

- 使用场景不同:synchronized适合锁少量的代码同步问题;Lock适合锁大量的同步代码(JVM将花费较少的时间来调度线程),此外Lock锁具有更好的扩展性(提供更多的子类)。优先使用顺序:Lock-->同步代码块-->同步方法。

- 线程通信:生产者与消费者问题

- 使用以下几个方法解决线程之间的通信问题:wait()/wait(long timeout),notify()/notifyAll()。

- 与sleep方法不同,wait方法会释放锁。

- 有两种解决生产者与消费者问题的方法:管程法、信号灯法。

常见的线程池技术:c3p0、Druid。

volatile: volatile修饰的变量不允许线程内部缓存和重排序,只能直接修改内存,所以对其他线程是可见的;但是,volatile只能让被他修饰的内容具有可见性,但不能保证它具有原子性。例如volatile int a = 0; ,之后有一个操作a++;,这个变量a具有可见性,但是a++;依然是一个非原子操作,也就是这个操作同样存在线程安全的问题。此外,volatile还可以禁止指令重排序,可以使用volatile和synchronized两个关键字来保证线程之间操作的有序性。

transient:将不需要序列化的属性前添加关键字transient,序列化对象的时候,这个属性就不会被序列化。

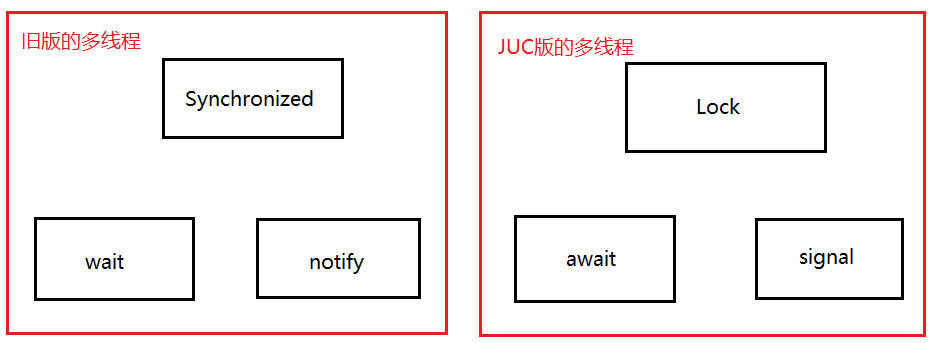

JUC,是指jdk里的三个与多线程有关的工具包:java.util.concurrent、java.util.concurrent.atomic、java.util.concurrent.locks。

关于多线程开发:企业级开发为了降低耦合度,线程就是一个单独的资源类,没有任何附属的操作。

**

* 真正的多线程开发,公司中的开发,降低耦合性。线程就是一个单独的资源类,没有任何附属的操作!

*

*/

public class SaleTicketDemo01 {

public static void main(String[] args) {

// 并发:多线程操作同一个资源类, 把资源类丢入线程

Ticket ticket = new Ticket();

// @FunctionalInterface 函数式接口,jdk1.8 lambda表达式 (参数)->{ 代码 }

new Thread(()->{

for (int i = 1; i < 40 ; i++) {

ticket.sale();

}

},"A").start();

new Thread(()->{

for (int i = 1; i < 40 ; i++) {

ticket.sale();

}

},"B").start();

new Thread(()->{

for (int i = 1; i < 40 ; i++) {

ticket.sale();

}

},"C").start();

}

}

// 资源类 OOP

class Ticket {

// 属性、方法

private int number = 30;

// 卖票的方式

// synchronized 本质: 队列,锁

public synchronized void sale(){ // synchronized可以换成lock锁

if (number>0){

System.out.println(Thread.currentThread().getName()+"卖出了"+(number--)+"票,剩余:"+number);

}

}

}面试高频点:单例模式、排序算法、生产者和消费者、死锁。

生产者消费者中的虚假唤醒问题:

/**

* 线程之间的通信问题:生产者和消费者问题,等待唤醒,通知唤醒

* 线程交替执行:A、B 操作同一个变量num = 0

* A num+1

* B num-1

*/

public class A {

public static void main(String[] args) {

Data data = new Data();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.increment();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"A").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.decrement();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"B").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.increment();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"C").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.decrement();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"D").start();

}

}

// 判断等待,业务,通知

class Data{ // 数字 资源类

private int number = 0;

public synchronized void increment() throws InterruptedException { //+1

if (number!=0){ //0 (将if改为while即可解决虚假唤醒问题)

this.wait(); // 等待

}

number++;

System.out.println(Thread.currentThread().getName()+"=>"+number);

this.notifyAll(); // 通知其他线程,我+1完毕了

}

public synchronized void decrement() throws InterruptedException { //-1

if (number==0){ // 1 (将if改为while即可解决虚假唤醒问题)

this.wait(); // 等待

}

number--;

System.out.println(Thread.currentThread().getName()+"=>"+number);

this.notifyAll(); // 通知其他线程,我-1完毕了

}

}若有A、B、C、D四个线程,且Data类中increment和decrement在if条件中等待唤醒,则会出现虚假唤醒的问题。具体原因可以参见jdk文档中的解释:

// 以下解释来源于jdk文档:

// 线程也可以唤醒,而不会被通知、中断或超时,即所谓的虚假唤醒。虽然这在实践中很少发生,但应用程序必须通过测试应该使线程被唤醒的条件来防范,并且如果条件不满足则继续等待。换句话说,等待应该总是出现在循环中,类似这样:

synchronized (obj) {

while (<condition does not hold>){

obj.wait(timeout);

}

...

}

// 关于生产者消费者中的虚假唤醒问题:将if改为while即可解决虚假唤醒问题。关于Condition接口:Condition接口位于java.util.concurrent.locks包下。jdk文档中是这么解释Condition接口的:Condition因素出Object监视器方法( wait , notify和notifyAll )成不同的对象,以得到具有多个等待集的每个对象,通过将它们与使用任意的组合的效果Lock个实现。 Lock替换synchronized方法和语句的使用, Condition取代了对象监视器方法的使用。

public class B {

public static void main(String[] args) {

Data2 data = new Data2();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.increment();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"A").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.decrement();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"B").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.increment();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"C").start();

new Thread(()->{

for (int i = 0; i < 10; i++) {

try {

data.decrement();

} catch (InterruptedException e) {

e.printStackTrace();

}

}

},"D").start();

}

}

// 判断等待,业务,通知

class Data2{ // 数字 资源类

private int number = 0;

Lock lock = new ReentrantLock();

Condition condition = lock.newCondition();

//+1

public void increment() throws InterruptedException {

lock.lock();

try {

while (number!=0){ //0

condition.await(); // 等待

}

number++;

System.out.println(Thread.currentThread().getName()+"=>"+number);

condition.signalAll(); // 通知其他线程,我+1完毕了

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

//-1

public synchronized void decrement() throws InterruptedException {

lock.lock();

try {

while (number==0){ // 1

condition.await(); // 等待

}

number--;

System.out.println(Thread.currentThread().getName()+"=>"+number);

condition.signalAll(); // 通知其他线程,我-1完毕了

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

}使用Condition可以实现精准通知和唤醒。

/**

* A 执行完调用B,B执行完调用C,C执行完调用A

*/

public class C {

public static void main(String[] args) {

Data3 data = new Data3();

new Thread(()->{

for (int i = 0; i <10 ; i++) {

data.printA();

}

},"A").start();

new Thread(()->{

for (int i = 0; i <10 ; i++) {

data.printB();

}

},"B").start();

new Thread(()->{

for (int i = 0; i <10 ; i++) {

data.printC();

}

},"C").start();

}

}

class Data3{ // 资源类 Lock

private Lock lock = new ReentrantLock();

private Condition condition1 = lock.newCondition();

private Condition condition2 = lock.newCondition();

private Condition condition3 = lock.newCondition();

private int number = 1; // 1A 2B 3C

public void printA(){

lock.lock();

try {

// 业务,判断-> 执行-> 通知

while (number!=1){

// 等待

condition1.await();

}

System.out.println(Thread.currentThread().getName()+"=>AAAAAAA");

number = 2;

condition2.signal(); // 唤醒,唤醒指定的人,B

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

public void printB(){

lock.lock();

try {

// 业务,判断-> 执行-> 通知

while (number!=2){

condition2.await();

}

System.out.println(Thread.currentThread().getName()+"=>BBBBBBBBB");

number = 3;

condition3.signal(); // 唤醒,唤醒指定的人,c

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

public void printC(){

lock.lock();

try {

// 业务,判断-> 执行-> 通知

while (number!=3){

condition3.await();

}

System.out.println(Thread.currentThread().getName()+"=>BBBBBBBBB");

number = 1;

condition1.signal(); // 唤醒,唤醒指定的人,A

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

}synchronized 修饰方法:锁的是this对象(不唯一)。

static + synchronized 修饰方法:锁的是Class对象(唯一)。

ArrayList:并发下ArrayList是不安全的,会抛出java.util.ConcurrentModificationException并发修改异常。解决方法有以下几种方式:

-

第1种解决方法:使用Vector代替ArrayList(Vector出现的比ArrayList早,那ArrayList存在的意义?)。

-

第2种解决方法:使用集合工具类

Collections.synchronizedList(List<T> list)。 -

第3种解决方法:使用JUC下的CopyOnWriteArrayList类(CopyOnWrite写入时复制,简称COW,是计算机程序设计领域的一种优化策略,在写入的时候避免覆盖造成的数据问题)。CopyOnWriteArrayList使用Lock锁,效率更高;而Vector使用的是synchronized锁,效率低。

HashSet:并发下HashSet也是不安全的,会抛出java.util.ConcurrentModificationException并发修改异常。解决方法有以下几种方式:

- 第1种解决办法:使用集合工具类

Collections.synchronizedSet(Set<T> set)。 - 第2种解决办法:使用JUC下的CopyOnWriteArraySet类(写入时复制)。

HashMap:并发下HashMap(HashMap的加载因子与初始化容量?)也是不安全的,会抛出java.util.ConcurrentModificationException并发修改异常。解决方法有以下几种方式:

- 第1种解决方法:使用集合工具类

Collections.synchronizedMap(Map<K,V> m)。 - 第2种解决办法:使用JUC下的ConcurrentHashMap类(ConcurrentHashMap的原理?)。

Collable:可以有返回值;可以抛出异常;call方法(类似于Runnable种的run方法)。

注意事项:

- Collable的执行结果会被缓存。

- 获取返回结果可能需要等待,从而会导致阻塞。

public class CallableTest {

public static void main(String[] args) throws ExecutionException, InterruptedException {

// new Thread(new Runnable()).start();

// new Thread(new FutureTask<V>()).start();

// new Thread(new FutureTask<V>( Callable )).start();

new Thread().start(); // 怎么启动Callable

MyThread thread = new MyThread();

FutureTask futureTask = new FutureTask(thread); // 适配类

new Thread(futureTask,"A").start();

new Thread(futureTask,"B").start(); // 结果会被缓存,效率高

Integer o = (Integer) futureTask.get(); //这个get 方法可能会产生阻塞!把他放到最后;或者使用异步通信来处理!

System.out.println(o);

}

}

class MyThread implements Callable<Integer> {

@Override

public Integer call() {

System.out.println("call()"); // 会打印几个call

// 耗时的操作

return 1024;

}

}CountDownLatch(减法计数器,也称倒计时器):允许一个或多个线程等待直到在其他线程中执行的一组操作完成的同步辅助。

原理:每次有线程调用countDown方法,则数量减1;若计数器变为0,await方法就会被唤醒,继续执行。

- countDownLatch.countDown():数量-1;

- countDownLatch.await():等待计数器归0,然后再往下执行。

// 计数器

public class CountDownLatchDemo {

public static void main(String[] args) throws InterruptedException {

// 总数是6,必须要执行任务的时候,再使用!

CountDownLatch countDownLatch = new CountDownLatch(6);

for (int i = 1; i <=6 ; i++) {

new Thread(()->{

System.out.println(Thread.currentThread().getName()+" Go out");

countDownLatch.countDown(); // 数量-1

},String.valueOf(i)).start();

}

countDownLatch.await(); // 等待计数器归零,然后再向下执行

System.out.println("Close Door");

}

}CyclicBarrier(加法计数器,也称栅栏):允许一组线程全部等待彼此达到共同屏障点的同步辅助。 循环阻塞在涉及固定大小的线程方的程序中很有用,这些线程必须偶尔等待彼此。 屏障被称为循环 ,因为它可以在等待的线程被释放之后重新使用。

public class CyclicBarrierDemo {

public static void main(String[] args) {

/**

* 集齐7颗龙珠召唤神龙

*/

// 召唤龙珠的线程

CyclicBarrier cyclicBarrier = new CyclicBarrier(8,()->{

System.out.println("召唤神龙成功!");

});

for (int i = 1; i <=7 ; i++) {

final int temp = i;

// lambda能操作到 i 吗?不能,需要通过中间变量temp

new Thread(()->{

System.out.println(Thread.currentThread().getName()+"收集"+temp+"个龙珠");

try {

cyclicBarrier.await(); // 等待

} catch (InterruptedException e) {

e.printStackTrace();

} catch (BrokenBarrierException e) {

e.printStackTrace();

}

}).start();

}

}

}Semaphore(信号量,用于限流):一个计数信号量。 在概念上,信号量维持一组许可证。 如果有必要,每个acquire()都会阻塞,直到许可证可用,然后才能使用它。 每个release()添加许可证,潜在地释放阻塞获取方。 但是,没有使用实际的许可证对象;Semaphore只保留可用数量的计数,并相应地执行。

原理:常用于多个共享资源的互斥(例如抢车位)。

- semaphore.acquire():获得,如果已经满了,等待被释放为止。

- semaphore.release():释放,会将当前的信号量释放+1,然后唤醒等待的线程。

public class SemaphoreDemo {

public static void main(String[] args) {

// 线程数量:停车位! 限流!

Semaphore semaphore = new Semaphore(3);

for (int i = 1; i <=6 ; i++) {

new Thread(()->{

// acquire() 得到

try {

semaphore.acquire();

System.out.println(Thread.currentThread().getName()+"抢到车位");

TimeUnit.SECONDS.sleep(2);

System.out.println(Thread.currentThread().getName()+"离开车位");

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

semaphore.release(); // release() 释放

}

},String.valueOf(i)).start();

}

}

}ReadWriteLock:维护一对关联的locks,一个用于只读操作,一个用于写入操作。 read lock可以由多个阅读器线程同时进行,只要没有作者。 write lock是独家的。

独占锁:写锁。

共享锁:读锁。

/**

* 独占锁(写锁) 一次只能被一个线程占有

* 共享锁(读锁) 多个线程可以同时占有

* ReadWriteLock

* 读-读 可以共存!

* 读-写 不能共存!

* 写-写 不能共存!

*/

public class ReadWriteLockDemo {

public static void main(String[] args) {

MyCache myCache = new MyCache();

// 写入

for (int i = 1; i <= 5 ; i++) {

final int temp = i;

new Thread(()->{

myCache.put(temp+"",temp+"");

},String.valueOf(i)).start();

}

// 读取

for (int i = 1; i <= 5 ; i++) {

final int temp = i;

new Thread(()->{

myCache.get(temp+"");

},String.valueOf(i)).start();

}

}

}

// 加锁的

class MyCacheLock{

private volatile Map<String,Object> map = new HashMap<>();

// 读写锁: 更加细粒度的控制

private ReadWriteLock readWriteLock = new ReentrantReadWriteLock();

private Lock lock = new ReentrantLock();

// 存,写入的时候,只希望同时只有一个线程写

public void put(String key,Object value){

readWriteLock.writeLock().lock();

try {

System.out.println(Thread.currentThread().getName()+"写入"+key);

map.put(key,value);

System.out.println(Thread.currentThread().getName()+"写入OK");

} catch (Exception e) {

e.printStackTrace();

} finally {

readWriteLock.writeLock().unlock();

}

}

// 取,读,所有人都可以读!

public void get(String key){

readWriteLock.readLock().lock();

try {

System.out.println(Thread.currentThread().getName()+"读取"+key);

Object o = map.get(key);

System.out.println(Thread.currentThread().getName()+"读取OK");

} catch (Exception e) {

e.printStackTrace();

} finally {

readWriteLock.readLock().unlock();

}

}

}阻塞队列:遵循FIFO。放入时若队列已满,则必须阻塞等待;取出时若队列是空的,则必须阻塞等待放入。

BlockingQueue(阻塞队列)的实现类:ArrayBlockingQueue(数组阻塞队列)、LinkedBlockingQueue(链表阻塞队列)、SynchronousQueue(同步阻塞队列)。

阻塞队列的应用:多线程并发处理、线程池。

阻塞队列的四组API:

| 方式 | 抛出异常 | 有返回值,不抛出异常 | 阻塞等待 | 超时等待 |

|---|---|---|---|---|

| 添加 | add | offer() | put() | offer(,,) |

| 移除 | remove | poll() | take() | poll(,) |

| 检测队首元素 | element | peek | - | - |

- 抛出异常。

- 不会抛出异常。

- 阻塞、一直等待。

- 超时等待。

public class Test {

public static void main(String[] args) throws InterruptedException {

test4();

}

public static void test1(){ // 抛出异常

// 队列的大小

ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue<>(3);

System.out.println(blockingQueue.add("a"));

System.out.println(blockingQueue.add("b"));

System.out.println(blockingQueue.add("c"));

// IllegalStateException: Queue full 抛出异常!

// System.out.println(blockingQueue.add("d"));

System.out.println("=-===========");

System.out.println(blockingQueue.element()); // 查看队首元素是谁

System.out.println(blockingQueue.remove());

System.out.println(blockingQueue.remove());

System.out.println(blockingQueue.remove());

// java.util.NoSuchElementException 抛出异常!

// System.out.println(blockingQueue.remove());

}

public static void test2(){ // 有返回值,不会抛出异常

// 队列的大小

ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue<>(3);

System.out.println(blockingQueue.offer("a"));

System.out.println(blockingQueue.offer("b"));

System.out.println(blockingQueue.offer("c"));

System.out.println(blockingQueue.peek());

// System.out.println(blockingQueue.offer("d")); // false 不抛出异常!

System.out.println("============================");

System.out.println(blockingQueue.poll());

System.out.println(blockingQueue.poll());

System.out.println(blockingQueue.poll());

System.out.println(blockingQueue.poll()); // null 不抛出异常!

}

public static void test3() throws InterruptedException { // 等待,阻塞(一直阻塞)

// 队列的大小

ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue<>(3);

// 一直阻塞

blockingQueue.put("a");

blockingQueue.put("b");

blockingQueue.put("c");

// blockingQueue.put("d"); // 队列没有位置了,一直阻塞

System.out.println(blockingQueue.take());

System.out.println(blockingQueue.take());

System.out.println(blockingQueue.take());

System.out.println(blockingQueue.take()); // 没有这个元素,一直阻塞

}

public static void test4() throws InterruptedException { // 等待,阻塞(等待超时)

// 队列的大小

ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue<>(3);

blockingQueue.offer("a");

blockingQueue.offer("b");

blockingQueue.offer("c");

// blockingQueue.offer("d",2,TimeUnit.SECONDS); // 等待超过2秒就退出

System.out.println("===============");

System.out.println(blockingQueue.poll());

System.out.println(blockingQueue.poll());

System.out.println(blockingQueue.poll());

blockingQueue.poll(2,TimeUnit.SECONDS); // 等待超过2秒就退出

}

}SynchronousQueue队列:同步队列,和其他BlockingQueue不一样,SynchronousQueue不存储元素,put了一个元素,必须从里面先take取出来,否则不能再put进去值。

/**

* 同步队列

* 和其他的BlockingQueue 不一样, SynchronousQueue 不存储元素

* put了一个元素,必须从里面先take取出来,否则不能再put进去值!

*/

public class SynchronousQueueDemo {

public static void main(String[] args) {

BlockingQueue<String> blockingQueue = new SynchronousQueue<>(); // 同步队列

new Thread(()->{

try {

System.out.println(Thread.currentThread().getName()+" put 1");

blockingQueue.put("1");

System.out.println(Thread.currentThread().getName()+" put 2");

blockingQueue.put("2");

System.out.println(Thread.currentThread().getName()+" put 3");

blockingQueue.put("3");

} catch (InterruptedException e) {

e.printStackTrace();

}

},"T1").start();

new Thread(()->{

try {

TimeUnit.SECONDS.sleep(3);

System.out.println(Thread.currentThread().getName()+"=>"+blockingQueue.take());

TimeUnit.SECONDS.sleep(3);

System.out.println(Thread.currentThread().getName()+"=>"+blockingQueue.take());

TimeUnit.SECONDS.sleep(3);

System.out.println(Thread.currentThread().getName()+"=>"+blockingQueue.take());

} catch (InterruptedException e) {

e.printStackTrace();

}

},"T2").start();

}

}线程池面试点**:三大方法、七大参数、四种拒绝策略**。

池化技术:事先准备好一些资源,有人要用,就来这里取,用完之后再还回来。池化技术的本质是优化资源的使用。例如:线程池、连接池、内存池、对象池...

线程池的好处:降低资源的消耗;提高响应速度;方便管理。(总结好处**:线程复用、可以控制最大并发数、管理线程**)

- Executors.newSingleThreadExecutor():创建单个线程。

- Executors.newFixedThreadPool(5):创建一个固定大小的线程池。

- Executors.newCachedThreadPool():创建一个可伸缩的(遇强则强、遇弱则弱)线程池。

阿里巴巴开发手册规定:线程池不允许使用Executors去创建,而是通过ThreadPoolExecutor的方式,这样的处理方式让写的同学更加明确线程池的运行规则,规避资源耗尽的风险。

- FixedThreadPool和SingleThreadExecutor:允许的请求队列长度为Integer.MAX_VALUE,可能会堆积大量的请求,从而导致OOM。

- CachedThreadPool和ScheduledThreadPool:允许创建线程数量为Integer.MAX_VALUE,可能会创建大量的线程,从而导致OOM。

三大方法的本质均是调用ThreadPoolExecutor创建线程池,ThreadPoolExecutor的构造器有七大参数:

- int corePoolSize:核心线程的数量。

- int maximumPoolSize:最大核心线程池大小。

最大线程池大小如何设置?:

若是CPU密集型应用:最大线程数=CPU的核数。

若是IO密集型应用:最大线程数>IO线程的数量(一般最大线程数取IO线程的2倍即可)。

- long keepAliveTime:超时了但没有人调用就会释放。

- TimeUnit unit : 超时时间。

- BlockingQueue workQueue:阻塞队列。

- ThreadFactory threadFactory:线程工厂,创建线程的,一般不用动。

- RejectedExecutionHandler handler:拒绝策略。

- new ThreadPoolExecutor.AbortPolicy() :银行满了,还有人进来,不处理这个人的,抛出异常。

- new ThreadPoolExecutor.CallerRunsPolicy():哪来的回哪去,不会抛出异常。

- new ThreadPoolExecutor.DiscardPolicy():队列满了,丢掉任务,不会抛出异常。

- new ThreadPoolExecutor.DiscardOldestPolicy() :队列满了,尝试去和最早的竞争(若竞争四百则丢掉任务),也不会抛出异常。

/**

* new ThreadPoolExecutor.AbortPolicy() // 银行满了,还有人进来,不处理这个人的,抛出异常

* new ThreadPoolExecutor.CallerRunsPolicy() // 哪来的去哪里!

* new ThreadPoolExecutor.DiscardPolicy() //队列满了,丢掉任务,不会抛出异常!

* new ThreadPoolExecutor.DiscardOldestPolicy() //队列满了,尝试去和最早的竞争,也不会抛出异常!

*/

public class Demo01 {

public static void main(String[] args) {

// 自定义线程池!工作 ThreadPoolExecutor

// 最大线程到底该如何定义

// 1、CPU 密集型,几核,就是几,可以保持CPu的效率最高!

// 2、IO 密集型 > 判断你程序中十分耗IO的线程,

// 程序 15个大型任务 io十分占用资源!

// 获取CPU的核数

System.out.println(Runtime.getRuntime().availableProcessors());

List list = new ArrayList();

ExecutorService threadPool = new ThreadPoolExecutor(

2,

Runtime.getRuntime().availableProcessors(), // 获取电脑的核数(最大线程数=CPU的核数)

3,

TimeUnit.SECONDS,

new LinkedBlockingDeque<>(3),

Executors.defaultThreadFactory(),

new ThreadPoolExecutor.DiscardOldestPolicy()); //队列满了,尝试去和最早的竞争,也不会抛出异常!

try {

// 最大承载:Deque + max

// 超过 RejectedExecutionException

for (int i = 1; i <= 9; i++) {

// 使用了线程池之后,使用线程池来创建线程

threadPool.execute(()->{

System.out.println(Thread.currentThread().getName()+" ok");

});

}

} catch (Exception e) {

e.printStackTrace();

} finally {

// 线程池用完,程序结束,关闭线程池

threadPool.shutdown();

}

}

}需要重点掌握**:函数式接口、Lambda表达式、链式编程、Stream流式计算**。

函数式接口:只有一个方法的接口(主要用于简化编程模型,在新版本的框架底层大量应用)。只要是函数式接口就可以用Lambda表达式简化。

Function函数式接口:有一个输入参数,有一个输出参数。

/**

* Function 函数型接口, 有一个输入参数,有一个输出

* 只要是函数型接口,就可以用Lambda表达式简化

*/

public class Demo01 {

public static void main(String[] args) {

//

// Function<String,String> function = new Function<String,String>() {

// @Override

// public String apply(String str) {

// return str;

// }

// };

Function<String,String> function = str->{return str;};

System.out.println(function.apply("asd"));

}

}Predicate断定式接口:有一个输入参数,返回一个boolean类型。

/**

* 断定型接口:有一个输入参数,返回值只能是 布尔值!

*/

public class Demo02 {

public static void main(String[] args) {

// 判断字符串是否为空

// Predicate<String> predicate = new Predicate<String>(){

//// @Override

//// public boolean test(String str) {

//// return str.isEmpty();

//// }

//// };

Predicate<String> predicate = (str)->{return str.isEmpty(); };

System.out.println(predicate.test(""));

}

}Consumer消费型接口:只有输入,没有返回值。

/**

* Consumer 消费型接口: 只有输入,没有返回值

*/

public class Demo03 {

public static void main(String[] args) {

// Consumer<String> consumer = new Consumer<String>() {

// @Override

// public void accept(String str) {

// System.out.println(str);

// }

// };

Consumer<String> consumer = (str)->{System.out.println(str);};

consumer.accept("sdadasd");

}

}Supplier供给型接口:没有输入,只有返回值。

/**

* Supplier 供给型接口 没有参数,只有返回值

*/

public class Demo04 {

public static void main(String[] args) {

// Supplier supplier = new Supplier<Integer>() {

// @Override

// public Integer get() {

// System.out.println("get()");

// return 1024;

// }

// };

Supplier supplier = ()->{ return 1024; };

System.out.println(supplier.get());

}

}大数据:存储 + 计算。集合、MySQL本质是存储,计算都应该交给流来操作。

/**

* 题目要求:一分钟内完成此题,只能用一行代码实现!

* 现在有5个用户!筛选:

* 1、ID 必须是偶数

* 2、年龄必须大于23岁

* 3、用户名转为大写字母

* 4、用户名字母倒着排序

* 5、只输出一个用户!

*/

public class Test {

public static void main(String[] args) {

User u1 = new User(1,"a",21);

User u2 = new User(2,"b",22);

User u3 = new User(3,"c",23);

User u4 = new User(4,"d",24);

User u5 = new User(6,"e",25);

// 集合就是存储

List<User> list = Arrays.asList(u1, u2, u3, u4, u5);

// 计算交给Stream流

// lambda表达式、链式编程、函数式接口、Stream流式计算

list.stream()

.filter(u->{return u.getId()%2==0;})

.filter(u->{return u.getAge()>23;})

.map(u->{return u.getName().toUpperCase();})

.sorted((uu1,uu2)->{return uu2.compareTo(uu1);})

.limit(1)

.forEach(System.out::println);

}

}ForkJoin: ForkJoin在jdk1.7中引入的,并行执行任务,提高效率。

ForkJoin特点:工作窃取。原因是底层是采用双端队列实现的。(ForkJoin的具体使用?Stream并行流的具体使用?)

/**

* 求和计算的任务!

* 3000 6000(ForkJoin) 9000(Stream并行流)

* // 如何使用 forkjoin

* // 1、forkjoinPool 通过它来执行

* // 2、计算任务 forkjoinPool.execute(ForkJoinTask task)

* // 3. 计算类要继承 ForkJoinTask

*/

public class ForkJoinDemo extends RecursiveTask<Long> {

private Long start; // 1

private Long end; // 1990900000

// 临界值

private Long temp = 10000L;

public ForkJoinDemo(Long start, Long end) {

this.start = start;

this.end = end;

}

// 计算方法

@Override

protected Long compute() {

if ((end-start)<temp){

Long sum = 0L;

for (Long i = start; i <= end; i++) {

sum += i;

}

return sum;

}else { // forkjoin 递归

long middle = (start + end) / 2; // 中间值

ForkJoinDemo task1 = new ForkJoinDemo(start, middle);

task1.fork(); // 拆分任务,把任务压入线程队列

ForkJoinDemo task2 = new ForkJoinDemo(middle+1, end);

task2.fork(); // 拆分任务,把任务压入线程队列

return task1.join() + task2.join();

}

}

}

// 比较几种不同方法的计算速度

public class Test {

public static void main(String[] args) throws ExecutionException, InterruptedException {

// test1(); // 12224ms

// test2(); // 10038ms

// test3(); // 153ms

}

// 普通程序员

public static void test1(){

Long sum = 0L;

long start = System.currentTimeMillis();

for (Long i = 1L; i <= 10_0000_0000; i++) {

sum += i;

}

long end = System.currentTimeMillis();

System.out.println("sum="+sum+" 时间:"+(end-start));

}

// 会使用ForkJoin

public static void test2() throws ExecutionException, InterruptedException {

long start = System.currentTimeMillis();

ForkJoinPool forkJoinPool = new ForkJoinPool();

ForkJoinTask<Long> task = new ForkJoinDemo(0L, 10_0000_0000L);

ForkJoinTask<Long> submit = forkJoinPool.submit(task);// 提交任务

Long sum = submit.get();

long end = System.currentTimeMillis();

System.out.println("sum="+sum+" 时间:"+(end-start));

}

public static void test3(){

long start = System.currentTimeMillis();

// Stream并行流 () (]

long sum = LongStream.rangeClosed(0L, 10_0000_0000L).parallel().reduce(0, Long::sum);

long end = System.currentTimeMillis();

System.out.println("sum="+"时间:"+(end-start));

}

}Future的设计初衷:对将来的某个事件的结果进行建模。使用Future的实现类CompletableFuture可以实现异步调用。

/**

* 异步调用: CompletableFuture

* // 异步执行

* // 成功回调

* // 失败回调

*/

public class Demo01 {

public static void main(String[] args) throws ExecutionException, InterruptedException {

// 没有返回值的 runAsync 异步回调

// CompletableFuture<Void> completableFuture = CompletableFuture.runAsync(()->{

// try {

// TimeUnit.SECONDS.sleep(2);

// } catch (InterruptedException e) {

// e.printStackTrace();

// }

// System.out.println(Thread.currentThread().getName()+"runAsync=>Void");

// });

//

// System.out.println("1111");

//

// completableFuture.get(); // 获取阻塞执行结果

// 有返回值的 supplyAsync 异步回调

// ajax,成功和失败的回调

// 返回的是错误信息;

CompletableFuture<Integer> completableFuture = CompletableFuture.supplyAsync(()->{

System.out.println(Thread.currentThread().getName()+"supplyAsync=>Integer");

int i = 10/0;

return 1024;

});

System.out.println(completableFuture.whenComplete((t, u) -> {

System.out.println("t=>" + t); // 正常的返回结果

System.out.println("u=>" + u); // 错误信息:java.util.concurrent.CompletionException: java.lang.ArithmeticException: / by zero

}).exceptionally((e) -> {

System.out.println(e.getMessage());

return 233; // 可以获取到错误的返回结果

}).get());

}

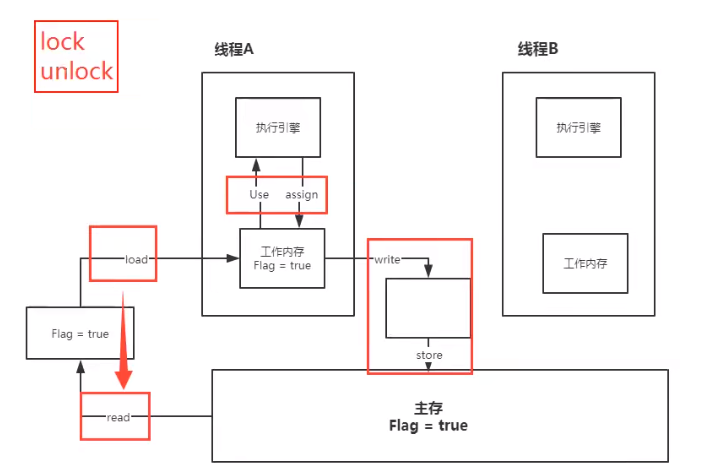

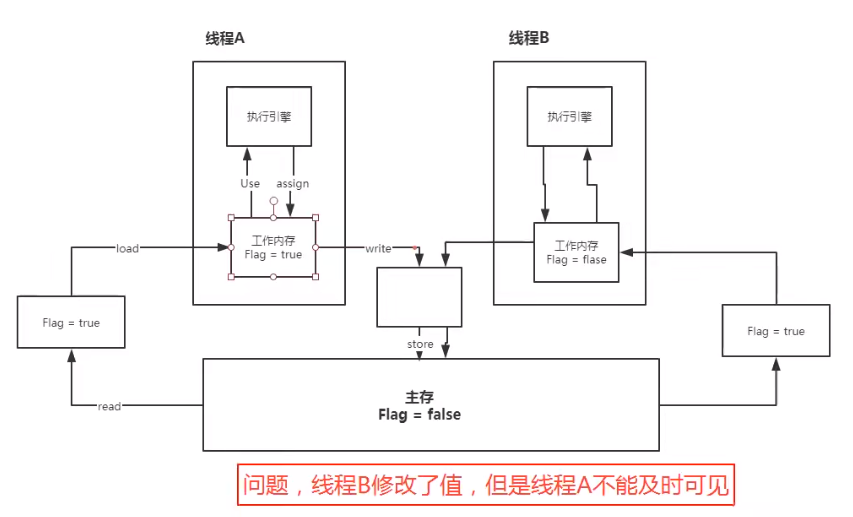

}JMM: Java Memory Model,Java内存模型。

关于JMM的一些同步的约定:

- 线程解锁前,必须把共享变量立刻刷回主存。

- 线程加锁前,必须读取主存中的最新值到工作内存中。

- 加锁和解锁是同一把锁。

线程的工作内存与主内存之间有8种操作:

- lock(锁定):作用于主内存的变量,把一个变量标识为线程独占状态。

- unlock(解锁):作用于主内存的变量,它把一个处于锁定状态的变量释放出来,释放后的变量才可以被其他线程锁定。

- read(读取):作用于主内存变量,它把一个变量的值从主内存传输到线程的工作内存中,以便随后的load动作使用。

- load(载入):作用于工作内存的变量,它把read操作从主存中变量放入工作内存中。

- use(使用):作用于工作内存中的变量,它把工作内存中的变量传输给执行引擎,每当虚拟机遇到一个需要使用到变量的值,就会使用到这个指令。

- assign(赋值):作用于工作内存中的变量,它把一个从执行引擎中接受到的值放入工作内存的变量副本中。

- store(存储):作用于主内存中的变量,它把一个从工作内存中一个变量的值传送到主内存中,以便后续的write使用。

- write(写入):作用于主内存中的变量,它把store操作从工作内存中得到的变量的值放入主内存的变量中。

JMM对这八种指令的使用,制定了如下规则:

- 不允许read和load、store和write操作之一单独出现。即使用了read必须load,使用了store必须write。

- 不允许线程丢弃他最近的assign操作,即工作变量的数据改变了之后,必须告知主存。

- 不允许一个线程将没有assign的数据从工作内存同步回主内存。

- 一个新的变量必须在主内存中诞生,不允许工作内存直接使用一个未被初始化的变量。就是怼变量实施use、store操作之前,必须经过assign和load操作。

- 一个变量同一时间只有一个线程能对其进行lock。多次lock后,必须执行相同次数的unlock才能解锁。

- 如果对一个变量进行lock操作,会清空所有工作内存中此变量的值,在执行引擎使用这个变量前,必须重新load或assign操作初始化变量的值。

- 如果一个变量没有被lock,就不能对其进行unlock操作。也不能unlock一个被其他线程锁住的变量。

- 对一个变量进行unlock操作之前,必须把此变量同步回主内存。

针对多个线程修改共享变量的情况:若不引入volatile,会出现问题。(引出下节的volatile可以解决这一问题)

volatile:是java虚拟机提供的轻量级的同步机制。有如下三大特性:

- 保证可见性。

public class JMMDemo {

// 不加volatile程序就会死循环

// 加volatile可以保证可见性

private volatile static int num = 0;

public static void main(String[] args) { // main

new Thread(()->{ // 线程 1 对主内存的变化不知道的

while (num==0){

}

}).start();

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

num = 1;

System.out.println(num);

}

}-

不保证原子性(原子性即不可分割,表示线程在执行任务的时候,不能被打扰,也不能被分割,要么同时成功,要么同时失败)。

(数据库里的ACID四大原则?)

**如果不加lock和synchronized,怎么保证原子性?**使用原子类可以保证原子性。原子类的底层直接和操作系统挂钩,会直接在内存中修改值(Unsafe类是一个很特殊的存在)。

**那为什么原子类可以保证原子性?**原子类的底层用的CAS,详见

2.2.18节。

// volatile 不保证原子性

public class VDemo02 {

// volatile 不保证原子性

// 原子类的 Integer

private volatile static AtomicInteger num = new AtomicInteger();

public static void add(){

// num++; // 不是一个原子性操作

num.getAndIncrement(); // AtomicInteger + 1 方法, CAS

}

public static void main(String[] args) {

//理论上num结果应该为 2 万

for (int i = 1; i <= 20; i++) {

new Thread(()->{

for (int j = 0; j < 1000 ; j++) {

add();

}

}).start();

}

while (Thread.activeCount()>2){ // main gc

Thread.yield();

}

System.out.println(Thread.currentThread().getName() + " " + num);

}

}- 禁止指令重排。

**什么是指令重排?**你写的程序,计算机并不是按照你写的那样去执行的。

源代码到程序的过程:源代码-->编译器优化的重排-->指令并行也可能重排-->内存系统也会重排-->执行。

处理器在进行指令重排的时候,会考虑数据之间的依赖性,这在多线程情况下会出现问题(例如:A线程没有出现数据依赖,B线程也没有出现数据依赖,但B线程的指令重排后的结果对线程出现了依赖,就可能会出现问题)。

举个例子:a、b、x、y默认值都是0

| 线程A | 线程B |

|---|---|

| x=a | y=b |

| b=1 | a=2 |

正常的结果:x = 0; y = 0; 但是可能由于指令重排:

| 线程A | 线程B |

|---|---|

| b=1 | a=2 |

| x=a | y=b |

指令重排导致的诡异结果:x = 2; y = 1; volatile关键字就可以避免指令重排。

**那为什么volatile可以避免指令重排呢?**添加volatile之后,在volatile写的时候,会在指令前后添加内存屏障,以禁止上下指令之间的交换。

普通读-->普通写-->内存屏障(禁止上下指令顺序交换)-->volatile写-->内存屏障(禁止上下指令顺序交换)。

**那volatile在那里应用最多呢?**在单例模式的饿汉模式使用最多。

- 饿汉模式:详见

1.1节。 - 懒汉模式:详见

1.1节。(双重检测 + volatile,简称DCL模式) - 静态内部类:详见

1.1节。

注意:饿汉模式、懒汉模式及静态内部类都是不安全的,使用反射可以破解这种单例模式。

// 例子1:使用反射破坏原有的单例模式(饿汉/懒汉模式)

public static void main(String[] args) throws Exception {

LazyMan instance = LazyMan.getInstance();

Constructor<LazyMan> declaredConstructor = LazyMan.class.getDeclaredConstructor(null);

declaredConstructor.setAccessible(true);

LazyMan instance2 = declaredConstructor.newInstance();

System.out.println(instance);

System.out.println(instance2); // 输出instance与instance2不相等(反射可以破坏单例)

}

// 例子2:升级为三重判断,依然可以使用反射破坏单例模式

public class LazyMan {

private LazyMan(){

synchronized (LazyMan.class){

if (lazyMan!=null){ // 使用三重判断

throw new RuntimeException("不要试图使用反射破坏异常");

}

}

}

private volatile static LazyMan lazyMan;

// 双重检测锁模式的 懒汉式单例 DCL懒汉式

public static LazyMan getInstance(){

if (lazyMan==null){

synchronized (LazyMan.class){

if (lazyMan==null){

lazyMan = new LazyMan(); // 不是一个原子性操作

}

}

}

return lazyMan;

}

// 反射!

public static void main(String[] args) throws Exception {

Constructor<LazyMan> declaredConstructor = LazyMan.class.getDeclaredConstructor(null);

declaredConstructor.setAccessible(true);

LazyMan instance = declaredConstructor.newInstance();

LazyMan instance2 = declaredConstructor.newInstance();

System.out.println(instance);

System.out.println(instance2); // 输出instance2依然不等于instance

}

}

// 例子3:使用红绿灯模式,通过反射依然可以破坏单例模式

public class LazyMan {

private static boolean qinjiang = false;

private LazyMan(){

synchronized (LazyMan.class){

if (qinjiang == false){

qinjiang = true;

}else {

throw new RuntimeException("不要试图使用反射破坏异常");

}

}

}

private volatile static LazyMan lazyMan;

// 双重检测锁模式的 懒汉式单例 DCL懒汉式

public static LazyMan getInstance(){

if (lazyMan==null){

synchronized (LazyMan.class){

if (lazyMan==null){

lazyMan = new LazyMan(); // 不是一个原子性操作

}

}

}

return lazyMan;

}

// 反射!

public static void main(String[] args) throws Exception {

Field qinjiang = LazyMan.class.getDeclaredField("qinjiang");

qinjiang.setAccessible(true);

Constructor<LazyMan> declaredConstructor = LazyMan.class.getDeclaredConstructor(null);

declaredConstructor.setAccessible(true);

LazyMan instance = declaredConstructor.newInstance();

qinjiang.set(instance,false);

LazyMan instance2 = declaredConstructor.newInstance();

System.out.println(instance);

System.out.println(instance2); // 输出instance2依然不等于instance

}

}

// 例子4: 使用枚举(反射不会破坏枚举)单例模式,这种情况下才不可以被破坏

public enum EnumSingle {

INSTANCE;

public EnumSingle getInstance(){

return INSTANCE;

}

}

class Test{

public static void main(String[] args) throws NoSuchMethodException, IllegalAccessException, InvocationTargetException, InstantiationException {

EnumSingle instance1 = EnumSingle.INSTANCE;

Constructor<EnumSingle> declaredConstructor = EnumSingle.class.getDeclaredConstructor(String.class,int.class);

declaredConstructor.setAccessible(true);

EnumSingle instance2 = declaredConstructor.newInstance();

// NoSuchMethodException: com.progzc.single.EnumSingle.<init>()

System.out.println(instance1);

System.out.println(instance2);

}

}CAS: Compare and Swap,即比较再交换。比较当前工作中的值和主内存中的值,如果这个值是期望的,那么则执行操作;如果不是则一直循环(底层是自旋锁)。

CAS原理:CAS底层使用Unsafe的本地方法(C语言)去操作内存(保证了很高的效率),操作的底层采用了自旋锁。

CAS缺点:

- 循环会耗事。

- 一次性只能保证一个共享变量的原子性。

- ABA问题。

什么是ABA问题?

解决ABA问题:引入待版本号的原子引用,对应的**是乐观锁。

public class CASDemo {

//AtomicStampedReference 注意,如果泛型是一个包装类,注意对象的引用问题

// 正常在业务操作,这里面比较的都是一个个对象

static AtomicStampedReference<Integer> atomicStampedReference = new AtomicStampedReference<>(1,1);

// CAS compareAndSet : 比较并交换!

public static void main(String[] args) {

new Thread(()->{

int stamp = atomicStampedReference.getStamp(); // 获得版本号

System.out.println("a1=>"+stamp);

try {

TimeUnit.SECONDS.sleep(1);

} catch (InterruptedException e) {

e.printStackTrace();

}

Lock lock = new ReentrantLock(true);

atomicStampedReference.compareAndSet(1, 2,

atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

System.out.println("a2=>"+atomicStampedReference.getStamp());

System.out.println(atomicStampedReference.compareAndSet(2, 1,

atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1));

System.out.println("a3=>"+atomicStampedReference.getStamp());

},"a").start();

// 乐观锁的原理相同!

new Thread(()->{

int stamp = atomicStampedReference.getStamp(); // 获得版本号

System.out.println("b1=>"+stamp);

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println(atomicStampedReference.compareAndSet(1, 6, stamp, stamp + 1));

System.out.println("b2=>"+atomicStampedReference.getStamp());

},"b").start();

}

}注意事项:Integer使用了对象缓存机制,默认范围是-128~127,推荐使用静态工厂方法valueOf获取对象实例,而不是New,因为valueOf使用缓存,而New一定会创建新的对象,分配新的内存空间。

阿里巴巴开发手册:所有相同类型的包装类对象之间值得比较,全部使用equals方法比较。这是因为:对于Integer var = ? 在-128~127之间的赋值,Integer对象是在IntegerCache.cache产生,会复用已有对象,这个区间内的Integer值可以直接使用==进行判断,但是这个区间之外的所有数据,都会在堆上产生,并不会复用已有对象。这是一个大坑,推荐使用equals方法进行判断。

公平锁:不能插队,必须先来后到。

非公平锁:可以插队(默认都是非公平锁)。

public ReentrantLock() { // 默认都是非公平锁

sync = new NonfairSync();

}

public ReentrantLock(boolean fair) {

sync = fair ? new FairSync() : new NonfairSync();

}

// 例子:非公平锁

public class FairLocked implements Runnable {

private int seatNumber = 100;

// 公平锁实现 ReentrantLock构造方法中设置为true:代表公平锁

// 设置为false:代表非公平锁 默认也是非公平锁

private ReentrantLock lock = new ReentrantLock();

@Override

public void run() {

while (true) {

try {

lock.lock();

if (seatNumber > 0) {

Thread.sleep(100);

--seatNumber;

System.out.println(Thread.currentThread().getName() + "占用1个座位,还剩余 " + seatNumber + "个座位");

} else {

System.out.println(Thread.currentThread().getName() + ":不好意思,票卖完了!");

break;

}

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

}

public static void main(String[] args) {

FairLocked rlbr = new FairLocked();

Thread t1 = new Thread(rlbr, "A窗口");

Thread t2 = new Thread(rlbr, "B窗口");

t1.start();

t2.start();

}

}可重入锁:可以理解为递归锁(拿到了外面的锁,才能获取里面的锁)。

Synchronized版的可重入锁:

// Synchronized

public class Demo01 {

public static void main(String[] args) {

Phone phone = new Phone();

new Thread(()->{

phone.sms();

},"A").start();

new Thread(()->{

phone.sms();

},"B").start(); // 先输出A的sms和call,再输出B的sms和call

}

}

class Phone{

public synchronized void sms(){

System.out.println(Thread.currentThread().getName() + "sms");

call(); // 这里也有锁

}

public synchronized void call(){

System.out.println(Thread.currentThread().getName() + "call");

}

}Lock版的可重入锁:

public class Demo02 {

public static void main(String[] args) {

Phone2 phone = new Phone2();

new Thread(()->{

phone.sms();

},"A").start();

new Thread(()->{

phone.sms();

},"B").start();

}

}

class Phone2{

Lock lock = new ReentrantLock();

public void sms(){

lock.lock(); // 细节问题:lock.lock(); lock.unlock(); // lock 锁必须配对,否则就会死在里面

lock.lock();

try {

System.out.println(Thread.currentThread().getName() + "sms");

call(); // 这里也有锁

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

lock.unlock();

}

}

public void call(){

lock.lock();

try {

System.out.println(Thread.currentThread().getName() + "call");

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.unlock();

}

}

}自旋锁:加锁后陷入无限循环。自旋锁是计算机科学用于多线程同步的一种锁,线程反复检查锁变量是否可用。由于线程在这一过程中保持执行,因此是一种忙等待。

// 利用CAS实现自定义自旋锁

public class SpinlockDemo {

// int 0

// Thread null

AtomicReference<Thread> atomicReference = new AtomicReference<>();

public void myLock(){ // 加锁

Thread thread = Thread.currentThread();

System.out.println(Thread.currentThread().getName() + "==> mylock");

while (!atomicReference.compareAndSet(null,thread)) { // 自旋锁

}

}

public void myUnLock(){ // 解锁

Thread thread = Thread.currentThread();

System.out.println(Thread.currentThread().getName() + "==> myUnlock");

atomicReference.compareAndSet(thread,null);

}

}

// 测试自旋锁

public class TestSpinLock {

public static void main(String[] args) throws InterruptedException {

// 底层使用的自旋锁CAS

SpinlockDemo lock = new SpinlockDemo();

new Thread(()-> {

lock.myLock();

try {

TimeUnit.SECONDS.sleep(5);

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.myUnLock();

}

},"T1").start();

TimeUnit.SECONDS.sleep(1);

new Thread(()-> {

lock.myLock();

try {

TimeUnit.SECONDS.sleep(1);

} catch (Exception e) {

e.printStackTrace();

} finally {

lock.myUnLock();

}

},"T2").start();

}

}死锁的例子:

public class DeadLockDemo {

public static void main(String[] args) {

String lockA = "lockA";

String lockB = "lockB";

new Thread(new MyThread(lockA, lockB), "T1").start();

new Thread(new MyThread(lockB, lockA), "T2").start();

}

}

class MyThread implements Runnable{

private String lockA;

private String lockB;

public MyThread(String lockA, String lockB) {

this.lockA = lockA;

this.lockB = lockB;

}

@Override

public void run() {

synchronized (lockA){

System.out.println(Thread.currentThread().getName() + "lock:"+lockA+"=>get"+lockB);

try {

TimeUnit.SECONDS.sleep(2);

} catch (InterruptedException e) {

e.printStackTrace();

}

synchronized (lockB){

System.out.println(Thread.currentThread().getName() + "lock:"+lockB+"=>get"+lockA);

}

}

}

}怎么排查解决死锁?

- 第一步:使用jps定位进程号(使用命令

jps -l)。 - 第二步:使用jstack查看进程信息(使用命令

jstack 进程号)

面试中问怎么排除问题?

- 查看日志。

- 查看堆栈信息。(这样比较专业)

结束线程的方法:

-

Thread类的

public final void stop()方法,但这个方法被标记为了过时,简单的说,我们不应该使用它,可以忽略它。 -

使用中断机制:中断并不是强迫终止一个线程,它是一种协作机制,是给线程传递一个取消信号,但是由线程来决定如何以及何时退出。

-

Thread类的

public boolean isInterrupted()方法- 属于实例方法,需要通过线程对象调用。

- 返回对应线程的中断标志位是否为true。

-

Thread类的

public void interrupt()方法- 属于实例方法,需要通过线程对象调用。

- 调用该方法的线程的状态将被置为"中断"状态。注意:线程中断仅仅是设置线程的中断状态位,不会停止线程。需要用户自己去监视线程的状态为并做处理。支持线程中断的方法(也就是线程中断后会抛出InterruptedException的方法,比如这里的sleep,以及Object.wait等方法)就是在监视线程的中断状态,一旦线程的中断状态被置为"中断状态",就会抛出中断异常。

-

Thread类的

public static boolean interrupted()方法- 属于静态方法,实际会调用Thread.currentThread()操作当前线程。

- 返回当前线程的中断标志位是否为true,但它还有一个重要的副作用,就是清空中断标志位,也就是说,连续两次调用interrupted(),第一次返回的结果为true,第二次一般就是false (除非同时又发生了一次中断)。

public class Interrupt { public static void main(String[] args) throws Exception { Thread t = new Thread(new Worker()); t.start(); Thread.sleep(200); t.interrupt(); System.out.println("Main thread stopped."); } public static class Worker implements Runnable { public void run() { System.out.println("Worker started."); try { Thread.sleep(500); } catch (InterruptedException e) { Thread curr = Thread.currentThread(); //再次调用interrupt方法中断自己,将中断状态设置为“中断” curr.interrupt(); System.out.println("Worker IsInterrupted: " + curr.isInterrupted()); System.out.println("Worker IsInterrupted: " + curr.isInterrupted()); System.out.println("Static Call: " + Thread.interrupted());//clear status System.out.println("---------After Interrupt Status Cleared----------"); System.out.println("Static Call: " + Thread.interrupted()); System.out.println("Worker IsInterrupted: " + curr.isInterrupted()); System.out.println("Worker IsInterrupted: " + curr.isInterrupted()); } System.out.println("Worker stopped."); } } } // 输出 Worker started. Main thread stopped. Worker IsInterrupted: true Worker IsInterrupted: true Static Call: true ---------After Interrupt Status Cleared---------- Static Call: false Worker IsInterrupted: false Worker IsInterrupted: false Worker stopped.

-

B站多线程教程、线程的六种状态及切换、volatile关键字、transient关键字、B站并发编程、Java内存模型、CAS、周明志-深入理解JAVA虚拟机、中断线程的几种方法对比

操作系统的作用:

- 为各个独立的进程分配资源,如内存、文件句柄、安全证书等。

- 在进程中通过一些通信机制来交换数据,如套接字、信号处理器、共享内存、信号量、文件等。

并发的作用:

- 提高系统的资源利用率。

- 公平性。使不同的用户和程序对计算机上的资源有着同等的使用权。

- 便利性。可以使用多个程序来执行一个任务。

线程与进程:

- 线程是轻量级的进程。

- 线程会共享进程范围内的资源(如内存句柄、文件句柄),但是每个线程都有各自的程序计数器、栈以及局部变量。

线程的优势:

- 发挥多核处理器的强大能力。

- 建模的简单性。

- 异步事件的简化处理。

- 响应更灵敏的用户界面。

线程带来的风险:

-

安全性问题("永远不发生糟糕的事情"):如自增不是一个原子性操作(读/自增/写)。

竞态条件是一种常见的并发安全问题,可以采用同步机制(synchronized)来解决。

-

活跃性问题("某件正确的事情最终会发生"):如死锁、饥饿、活锁问题。

-

性能问题:上下文切换带来的系统开销。

总结:线程无处不在:JVM、各种框架(框架通过在框架线程中调用应用程序代码将并发性引入到程序中)。

共享:变量可以由多个线程同时访问。

可变:变量的值在其生命周期内可以发生变化。

当多个线程访问同一个可变的状态变量时没有使用合适的同步,那么程序可能会出现错误,解决方法有三种:

- 不在线程之间共享该状态变量。

- 将状态变量修改为不可变的变量。

- 在访问状态变量时使用同步。

线程安全性:

- 当多个线程访问某个类时,这个类始终都能表现出正确的行为,那么就称这个类是线程安装的。

- 无状态对象一定是线程安全的。

竞态条件:在并发编程中,由于不恰当的执行时序而出现不正确的结果。当某个计算的正确性取决于多个线程的交替执行时序时,就会发生竞态条件。竞态条件的本质是基于一种可能失效的观察结果来做出判断或执行某个计算。

- "先检查后执行"的一种常见情况就是延迟初始化(例如单例模式),延迟初始化中包含一个竞态条件。

- 要避免竞态条件,就必须在某个线程修改该变量时,通过某种方式防止其他线程使用这个变量。

原子操作:对于访问同一个状态的所有操作(包括该操作本身)来说,这个操作是一个以原子方式执行的操作。

复合操作:包含了一组必须以原子方式执行的操作,如"先检查后执行"、"读取-修改-写入"(如自增)都是复合操作。

将复合操作变成线程安全的方法:

- 使用

java.util.concurrent.atomic包下的原子变量类(线程安全状态变量,如AtomicLong),这些原子变量类用于实现在数值和对象引用上的原子状态转换(如AtomicLong的incrementAndGet方法是一种原子操作的自增)。在实际情况中,应尽可能地使用现有的线程安全对象(如AtomicLong)来管理类的状态。 - 在方法上加锁。

- 使用不可变对象。

为什么要加锁解决线程安全问题,难道使用原子变量类不行吗?

当在不变性条件中涉及多个变量时,各个变量之间并不是彼此独立的,而是某个变量的值会对其他变量的值产生约束。因此,当更新某一个变量时,需要在同一个原子操作中对其他变量同时进行更新。这个时候锁登场了。

内置锁:同步代码块(Synchronized Block)。同步代码块由两部分组成:锁的对象引用+锁保护的代码块。

- 若以关键字Synchronized修饰普通方法,则该同步代码块的锁就是方法调用所在对象。

- 若以关键字Synchronized修饰静态方法,则该同步代码块的锁就是Class对象。

- 每个java对象都可以当作锁,这种锁称之为内置锁或监视器锁。

- java的内置锁是一种互斥锁。

- 在方法上使用同步代码块,往往可以解决线程安全问题,但是又会带来性能问题。

重入:

- 内置锁是可重入的。若某个线程试图获得一个已经由它自己持有的锁,那么这个请求就会成功。

- "重入"意味着获取锁的操作粒度是"线程",而不是"调用"。

- "重入"的实现方式是为每个锁关联一个获取计数值和一个所有者线程。

- "重入"提升了加锁行为的封装性,简化了面向对象并发代码的开发。如父类有一个Synchronized方法,而子类也继承并重写了这个方法,同时也添加了Synchronized,当调用子类的Synchronized方法时,重入避免了死锁的发生。需要注意的是,调用子类的Synchronized方法时加的锁是父类的锁。

用锁来保护状态:

- 对于可能被多个线程同时访问的可变状态变量,在访问它时都需要持有同一个锁;每个共享的可变变量都应该只由一个锁来保护。

- 常见的加锁约定:将所有的可变状态都封装在对象内部,并通过对象的内置锁对所有访问可变状态的代码路径进行同步,使得在该对象上不会发生并发访问(如Vector类)。

- 通过缩小同步代码块的作用范围,可以既确保并发性,又提高性能。

- 同时使用同步代码块和原子变量,不仅会带来混乱,还会降低性能。

线程的安全性和对象的共享形成了构建线程安全类以及通过java.util.concurrent类库来构建并发应用程序的重要基础。