[toc]

- 前台

root/12345678

- 后台

root/12345678

-

下载Anaconda

-

下载MySQL和Redis数据库

-

创建虚拟环境

- 爬虫环境

conda create -n Spider python=3.8 pip install -r .\spider\FoodsSpider\requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/

- Web环境

conda create -n web python=3.8 pip install -r .\web-server\requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple/

-

切换至Spider环境

conda activate jobfreeSpider

-

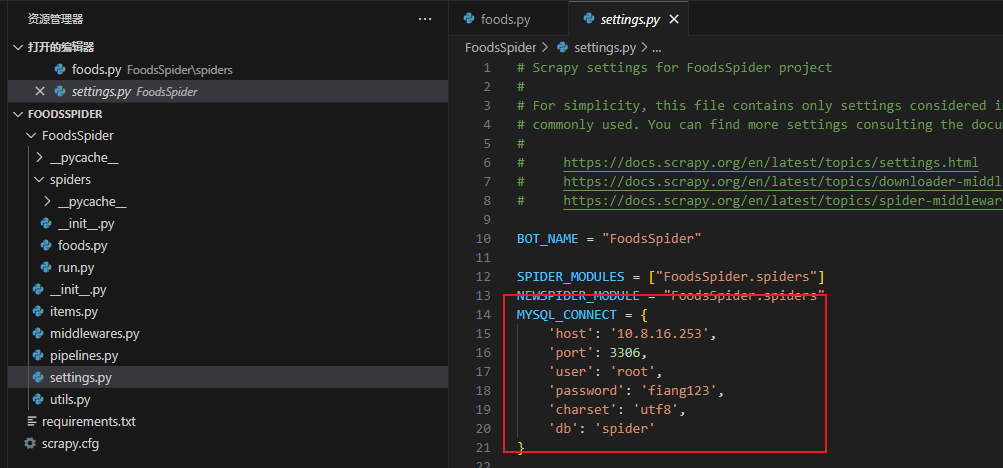

修改Foods-recommendations\spider\FoodsSpider\FoodsSpider\settings.py的mysql连接配置

-

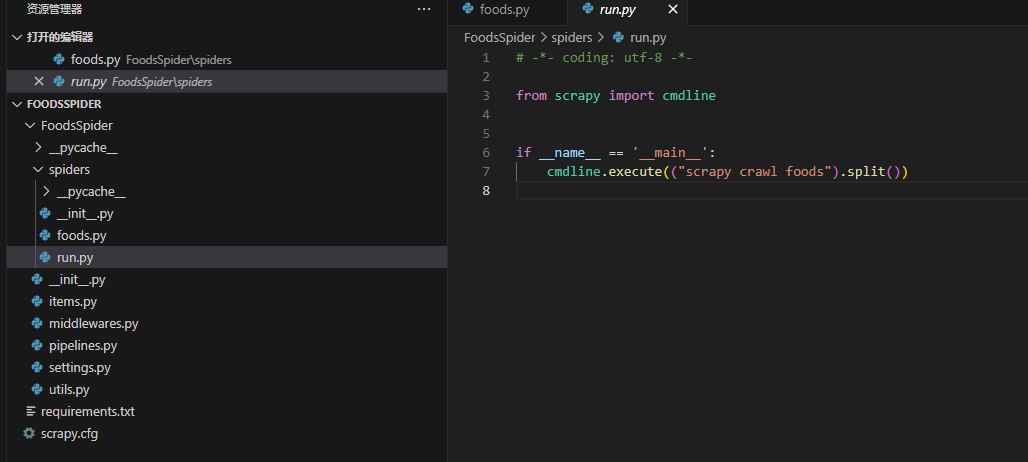

执行Foods-recommendations\spider\FoodsSpider\FoodsSpider\spider\run.py启动scrapy

# web-server\DRF\settings.py

# SMTP邮箱设置,怎么申请请自行网上学习

EMAIL_BACKEND = 'django.core.mail.backends.smtp.EmailBackend'

EMAIL_HOST = '' # 邮箱SMTP服务器地址

EMAIL_HOST_USER = '' # 邮箱用户名

EMAIL_HOST_PASSWORD = '' # 邮箱密码

# EMAIL_USE_TLS = True # 使用TLS加密

DEFAULT_FROM_EMAIL = '' # 默认发件人邮箱

#redis

REDIS_HOST='127.0.0.1'

REDIS_PORT=6379

REDIS_PSW=''

REDIS_DB=1

#MySQL

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'NAME': 'foods',

'USER': 'root',

'PASSWORD': 'root',

'HOST': '127.0.0.1',

'PORT': 3306,

'OPTIONS': {'charset': 'utf8mb4'},

},

}conda activate jobfree

cd web-server

python manage.py migrate双击web-start.bat

cd web-server

conda activate web

python manage.py runserver有集群则跳过

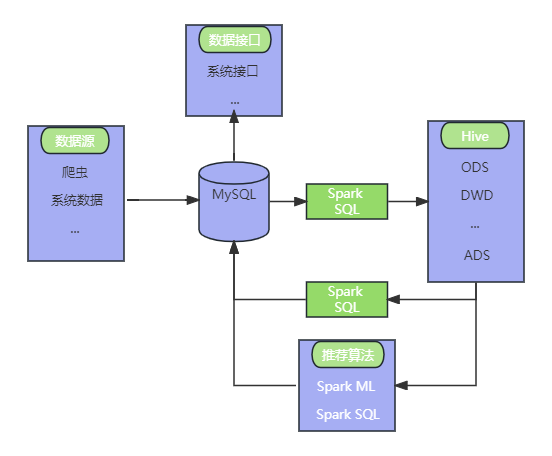

Windows下使用hadoop+hive+sparkSQL-CSDN博客

pip install findsparkETL\xxx目录下的py文件

ETL\ALS\train_run.py