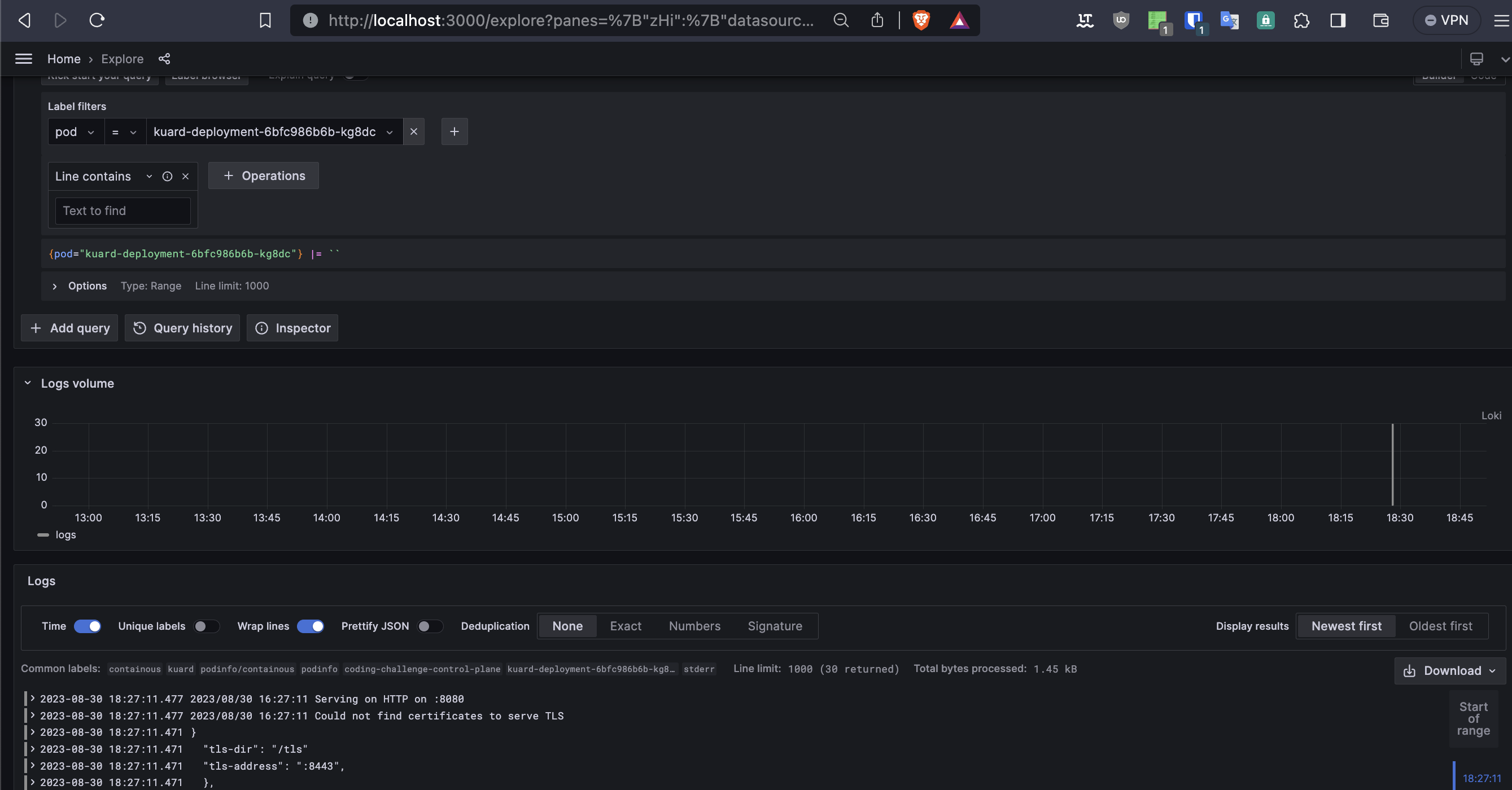

beschreibe wie die Komponenten einer möglichen Logging Lösung zusammenarbeiten.

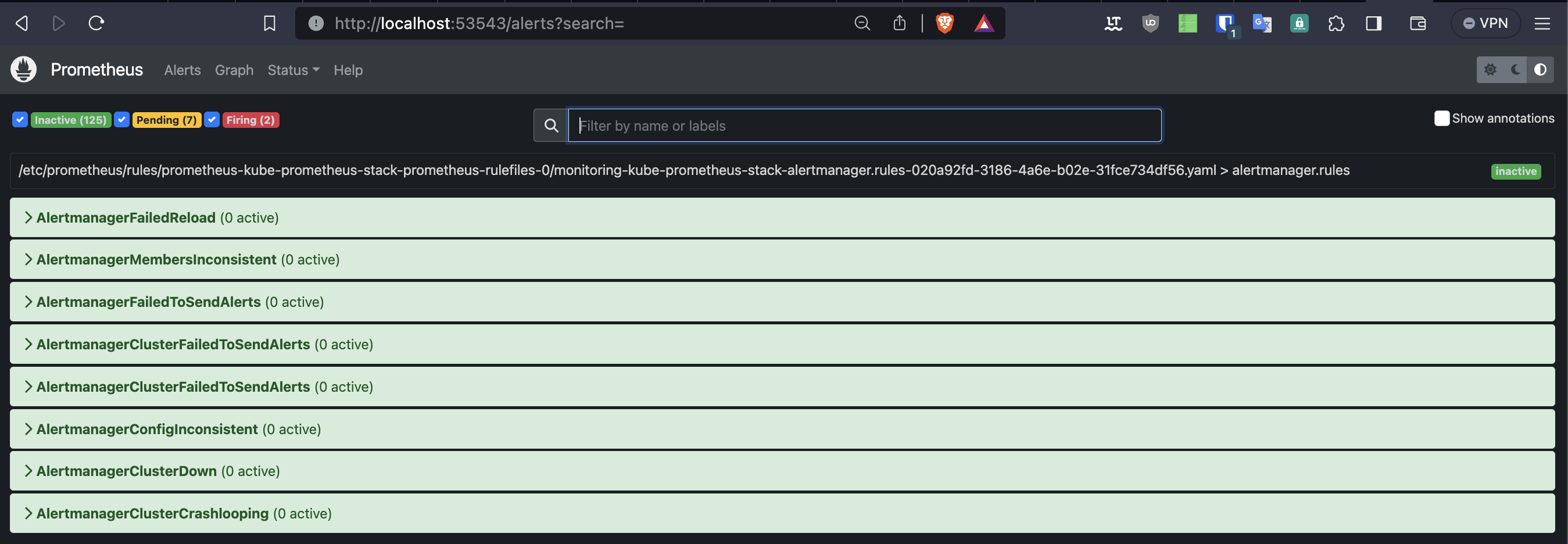

- Sammelt kontinuierlich Metriken von Anwendungen und Infrastrukturkomponenten im Cluster.

- Speichert Metriken in die TSDB (Time-Series-Database) und ermöglicht das Setzen von Alarmregeln.

- Agent auf den Cluster-Knoten, erfasst Protokolldaten von Anwendungen.

- Strukturiert und sendet Protokolle an Loki zur Aggregation und Speicherung.

- Aggregiert Protokolldaten von Promtail und anderen Quellen.

- Indiziert und komprimiert Protokolle für effiziente Speicherung.

- Ermöglicht schnelle Abfragen und Suche für Fehlerbehebung und Analyse.

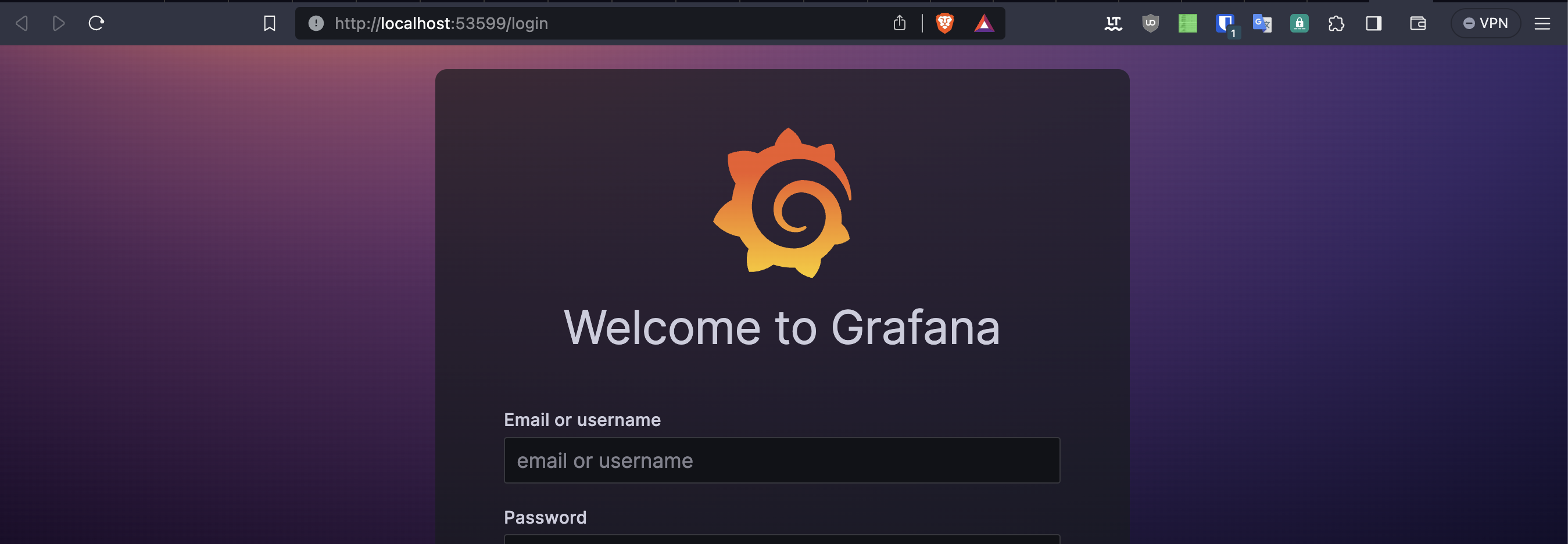

- Bietet benutzerfreundliche Oberfläche für Visualisierung und Analyse von Prometheus-Metriken.

- Erstellung von Dashboards mit Metrikdiagrammen und Trends.

- Überwacht Prometheus-Alarmregeln und -Benachrichtigungen.

- Leitet Benachrichtigungen bei Schwellenwertüberschreitungen oder Ereignissen weiter.

- Benachrichtigungen über verschiedene Kanäle wie E-Mail oder Slack.

Wie kann mit Kubernetes Boardmitteln sichergestellt werden, dass die Applikation mit einer hohen Anzahl an Requests auskommt?

- Kubernetes bietet die Möglichkeit, Pods automatisch basierend auf CPU-Auslastung oder anderen Metriken horizontal zu skalieren.

- Neue Pods werden bei steigender Last automatisch gestartet und bei geringerer Last heruntergefahren.

- Verwende ein Kubernetes-Deployment, um die Anzahl der laufenden Pods zu kontrollieren.

- Deployments ermöglichen Rolling Updates ohne Ausfallzeiten, was besonders wichtig bei Skalierungsänderungen ist.

- Ein LoadBalancer-Service verteilt eingehende Anfragen gleichmäßig auf die bereitgestellten Pods.

- Dies verbessert die Skalierbarkeit und Verteilung der Last auf die Pods.

- Kubernetes kann den gesamten Cluster automatisch skalieren, indem zusätzliche Nodes hinzugefügt werden.

- Diese Funktion erfordert oft Integration mit Cloud-Providern zur Skalierung der Infrastruktur.

- Implementiere sinnvolle Caching-Mechanismen, um häufige Anfragen zu beschleunigen und die Belastung zu reduzieren.

- Optimiere den Code und die Datenbankabfragen, um die Anwendungsleistung zu steigern.

- Identifizieren Fehler frühzeitig im Entwicklungsprozess.

- Klare Richtlinien für Code Qualität etablieren.

- Kleinere Code Reviews für effektive Fehlererkennung.

- Verständlicher Code erleichtert Fehlerfindung.

- Funktionalität gemäß Anforderungen überprüfen.

- Automatisierte CI/CD-Pipelines integrieren Tests (Unit, Integration, Regression).

- Automatisierte Tools für statische Code-Analyse nutzen. (Sonar Qube)

- Code standards sicherstellen. (Linting)

- Aussagekräftige Dokumentation beifügen.

- Verwende z.B

kustomize buildzum Generieren der Kubernetes Manifeste. - Validiere die Manifeste mit

kubectl apply --dry-run=client -f <manifest-datei>. - Nutze Tools wie

kubevaloderkubeconform, um die Manifeste gegen das Kubernetes-Schema zu validieren.

Welche Möglichkeiten gibt es ein fehlgeschlagenes Deployment auf eine frühere Version zurückzusetzen?

- Bei deklarativ verwalteten Infrastrukturen wird der Zustand des Clusters in einem Git-Repository gespeichert. Das bietet den großen Vorteile des Zurücksetzens auf einen alten Stand. Fehlerhafte Pull Request können geschlossen oder rückgängig machen werden.

helm rollback <RELEASE_NAME> <REVISION>

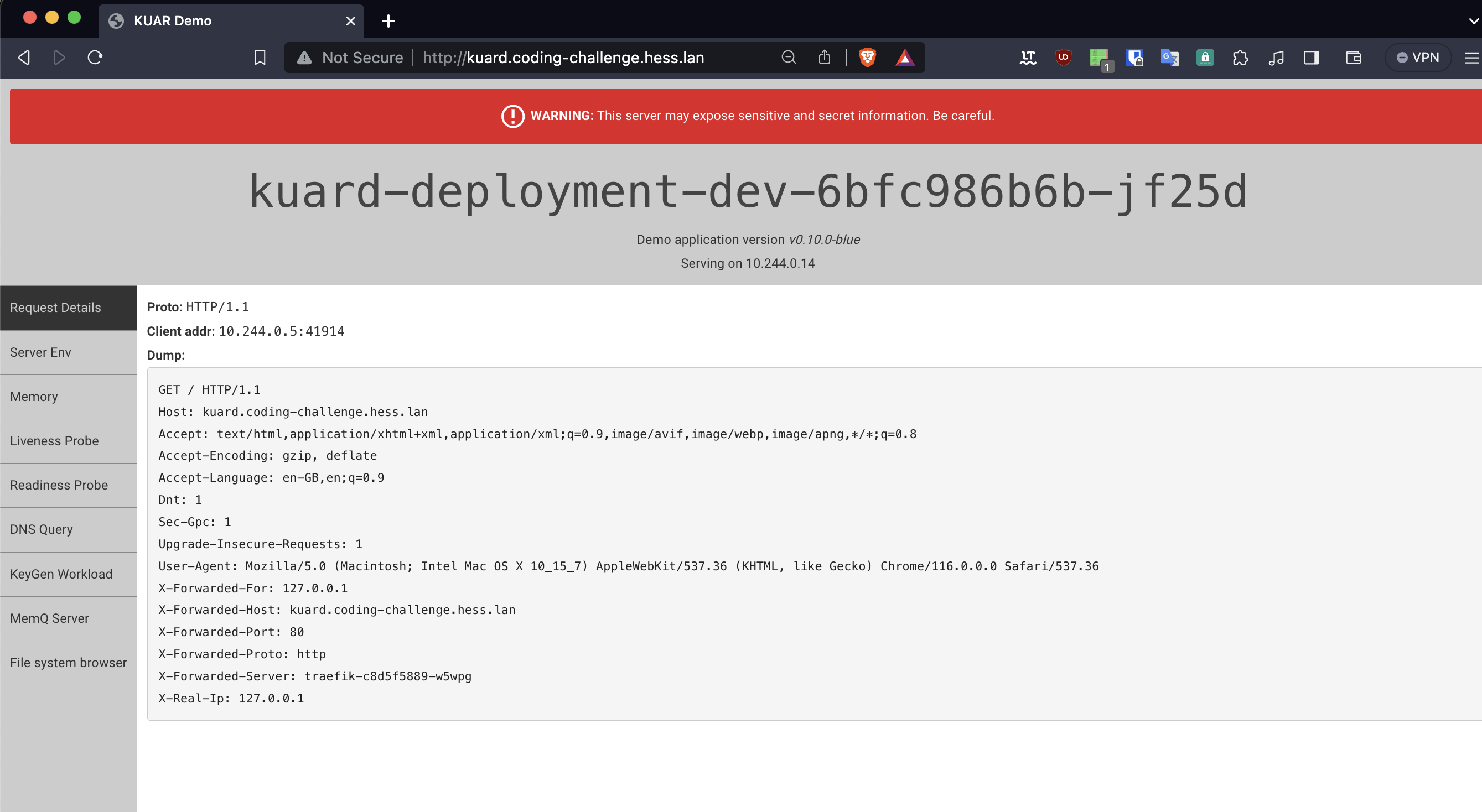

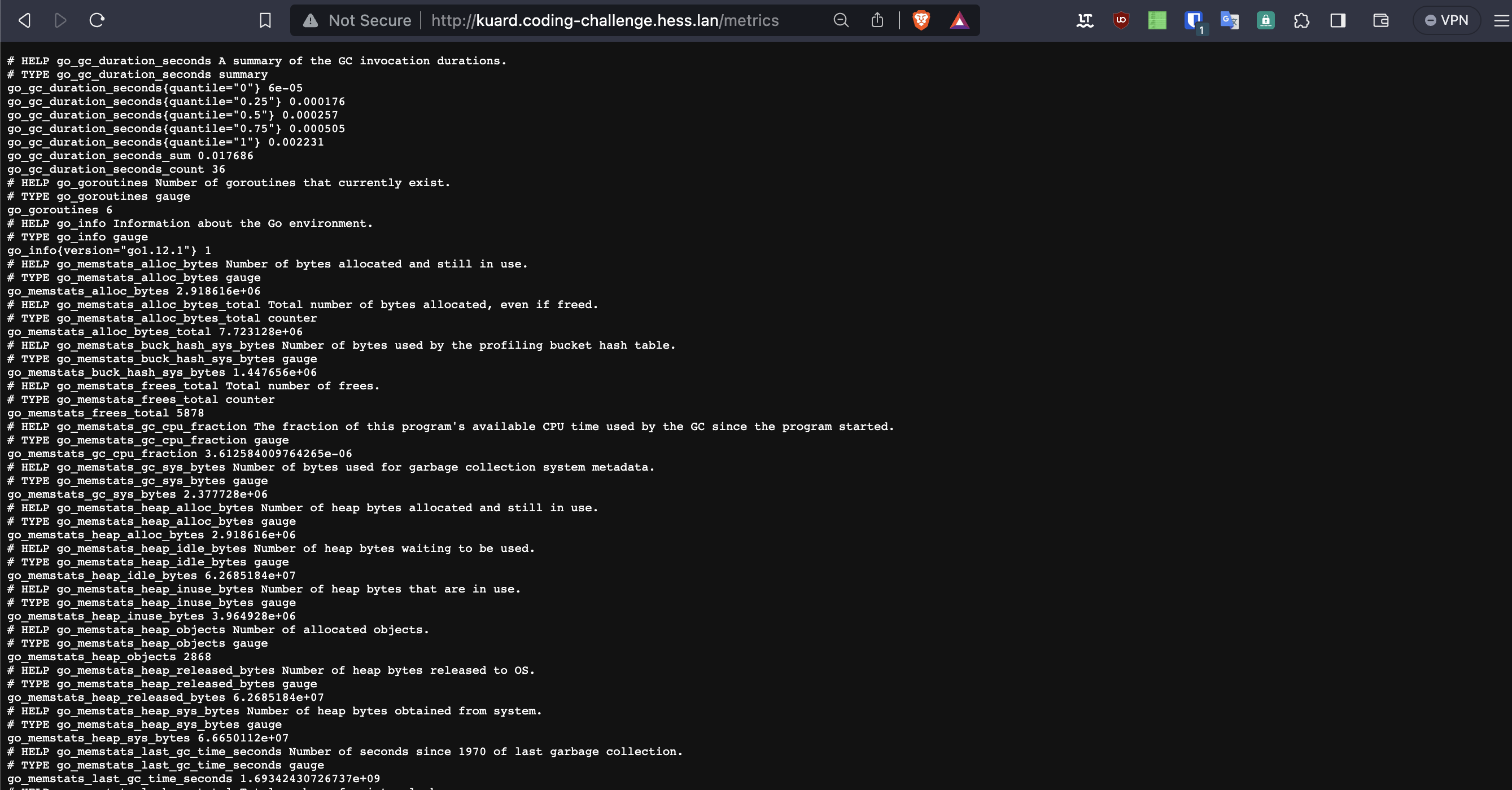

curl http://kuard.coding-challenge.hess.lan/metrics- bietet eine integrierte CI Lösung, die eng mit GitLab-Repositories und MergeRequest verknüpft ist

- Ermöglicht eine nahtlose Integration von Code-Verwaltung und Automatisierung.

- Leider nicht komplett OpenSource.

- Native Kubernetes-Anwendungsbereitstellung.

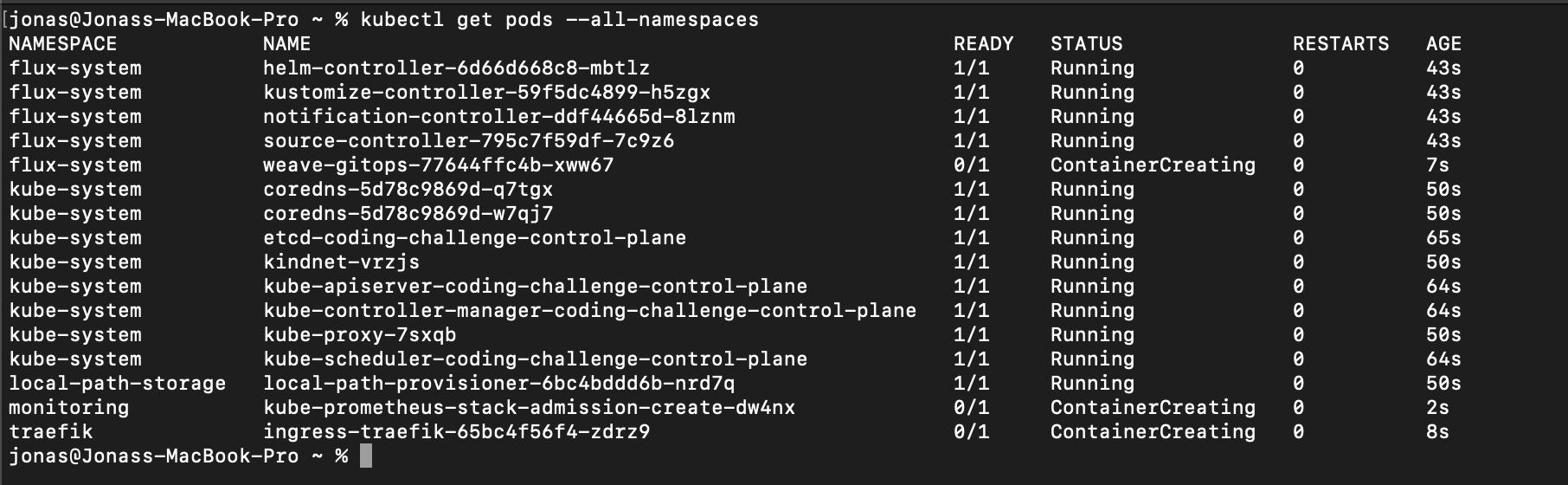

- Basiert auf GitOps-Prinzipien.

- Automatisiert die Synchronisierung von Kubernetes-Ressourcen aus Git.

- Unterstützt Multi-Cluster-Umgebungen.

- Schöne Benutzeroberfläche zur Anzeige und Verwaltung des Anwendungsstatus.