Это публичный репозиторий, созданный для обучения и отработки навыков. Если вы DevOps специалист, то полезной информации для вас тут нет.

Здесь будут опубликованы некоторые ДЗ по курсу. Github - простой и удобный способ доставки решения до преподавателя.

- Заполните README.md ответами на вопросы. Сделайте git push в ветку master. В ответе отправьте ссылку на ваш открытый репозиторий с изменённым playbook и заполненным README.md

Ответ:

https://github.com/bysart/08-ansible-01-base

Исходный код AWS провайдера склонировать от сюда: https://github.com/hashicorp/terraform-provider-aws.git. Просто найдите нужные ресурсы в исходном коде и ответы на вопросы станут понятны.

- Найдите, где перечислены все доступные resource и data_source, приложите ссылку на эти строки в коде на гитхабе.

- Для создания очереди сообщений SQS используется ресурс aws_sqs_queue у которого есть параметр name.

- С каким другим параметром конфликтует name? Приложите строчку кода, в которой это указано.

- Какая максимальная длина имени?

- Какому регулярному выражению должно подчиняться имя?

Ответ:

Колонирование репозитория:

git clone https://github.com/hashicorp/terraform-provider-aws.git

- resource и data_source:

ResourcesMap: map[string]*schema.Resource

DataSourcesMap: map[string]*schema.Resource

-

- name конфликтует с:

ConflictsWith: []string{"name_prefix"}

- name конфликтует с:

объявлено в Schema: map[string]*schema.Schema

- максимальная длинна имени: 80 символов

- ограничения по регулярному выражению для имени:

[0-9A-Za-z-_] в том числе доп ограничения fifo, которые определены в func validateSQSNonFifoQueueName func validateSQSFifoQueueName.

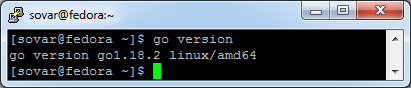

- Установите golang

Ответ:

- Знакомство с gotour

Ответ: https://go.dev/tour/list

- Написание кода

- Напишите программу для перевода метров в футы (1 фут = 0.3048 метр). Можно запросить исходные данные у пользователя, а можно статически задать в коде. Для взаимодействия с пользователем можно использовать функцию Scanf

package main

import "fmt"

func main() {

var foot float64

fmt.Print("Type foot: ")

fmt.Scanf("%f", &foot)

result := foot * 0.3048

fmt.Println("Meters:", result )

}

[sovar@fedora go]$ go run test.go

Type foot: 7.7

Meters: 2.34696

- Напишите программу, которая найдет наименьший элемент в любом заданном списке

x := []int{48,96,86,68,57,82,63,70,37,34,83,27,19,97,9,17,}

package main

import "fmt"

func main() {

x := []int{48,2, 96,86,3,68,57,82,63,70,37,34,83,27,19,97,9,17,1}

zero := 0

for i, less := range x {

if (i == 0) {

zero = less

} else {

if (less < zero) {

zero = less

}

}

}

fmt.Println("Min integer: ", zero)

}

[sovar@fedora go]$ go run test.go

Min integer: 1

- Напишите программу, которая выводит числа от 1 до 100, которые делятся на 3. То есть (3, 6, 9, …)

package main

import "fmt"

func main() {

for i := 1; i <= 100; i++ {

if (i%3) == 0 {

fmt.Print("[",i,"]")

}

}

}

[sovar@fedora go]$ go run test.go

[3][6][9][12][15][18][21][24][27][30][33][36][39][42][45][48][51][54][57][60][63][66][69][72][75][78][81][84][87][90][93][96][99]

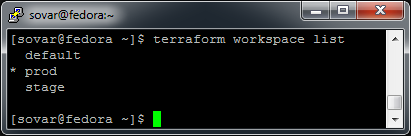

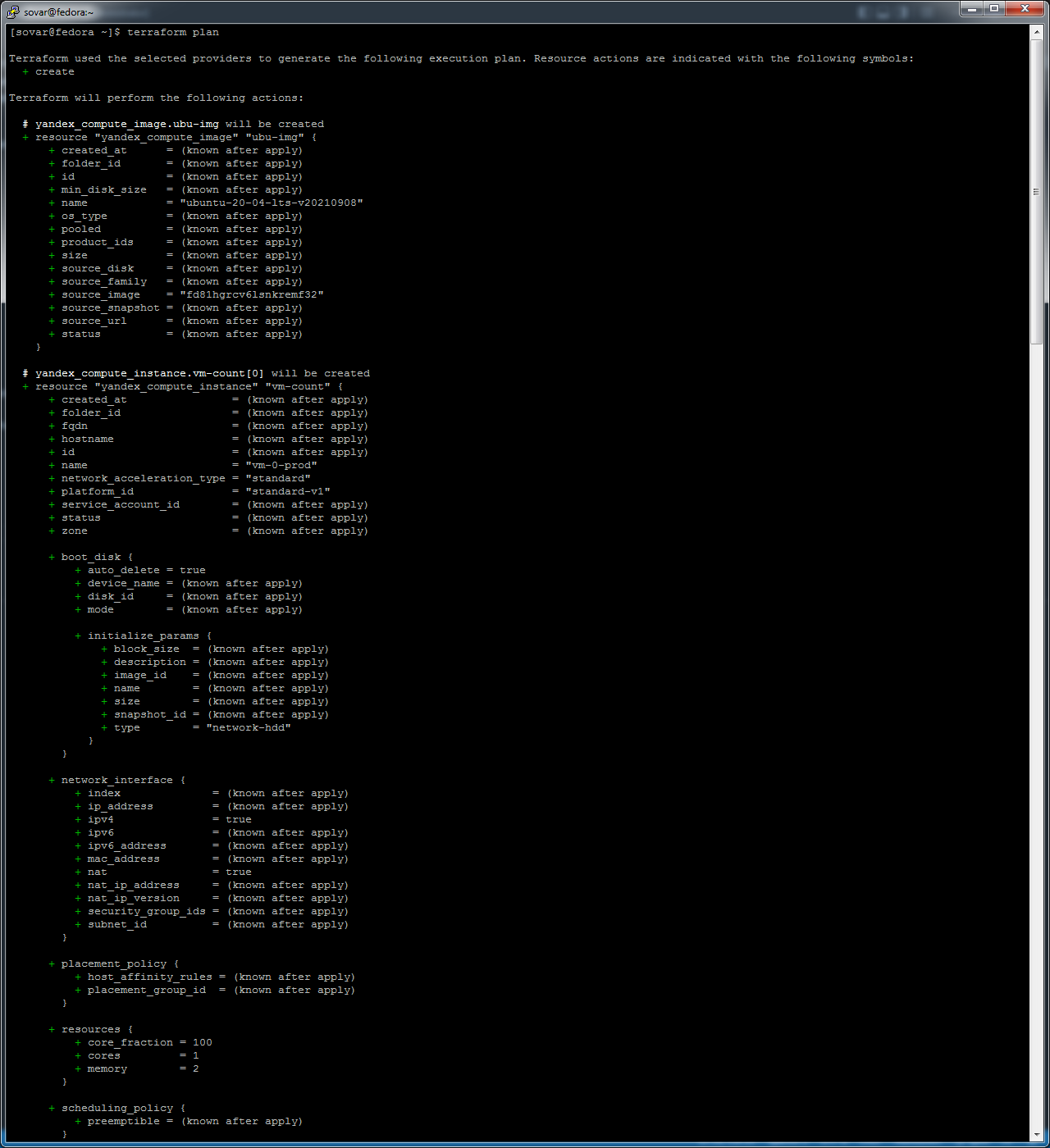

- Инициализируем проект и создаем воркспейсы. Выполните terraform init: если был создан бэкэнд в S3, то терраформ создат файл стейтов в S3 и запись в таблице dynamodb. иначе будет создан локальный файл со стейтами. Создайте два воркспейса stage и prod. В уже созданный aws_instance добавьте зависимость типа инстанса от вокспейса, что бы в разных ворскспейсах использовались разные instance_type. Добавим count. Для stage должен создаться один экземпляр ec2, а для prod два. Создайте рядом еще один aws_instance, но теперь определите их количество при помощи for_each, а не count. Что бы при изменении типа инстанса не возникло ситуации, когда не будет ни одного инстанса добавьте параметр жизненного цикла create_before_destroy = true в один из рессурсов aws_instance. При желании поэкспериментируйте с другими параметрами и рессурсами. В виде результата работы пришлите: Вывод команды terraform workspace list. Вывод команды terraform plan для воркспейса prod.

Ответ:

terraform workspace list

Ссылка на файл: main.tf

terraform plan вывод результата большой, скрин ниже, в том числе прилагаю лог: terraform-plan.log

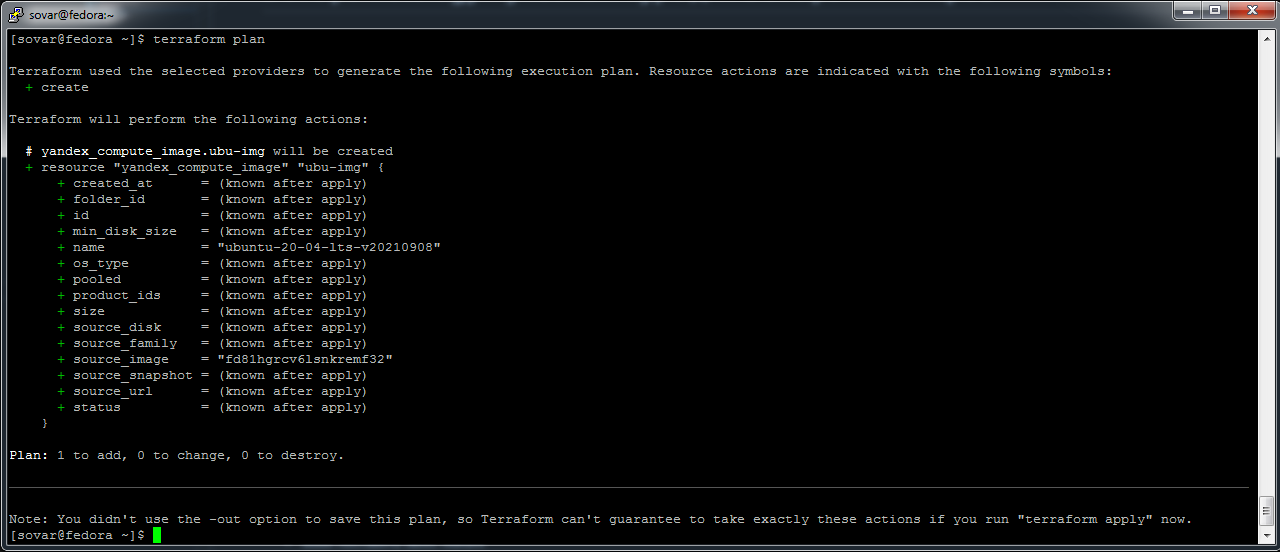

- (Вариант с Yandex.Cloud). Регистрация в ЯО и знакомство с основами (необязательно, но крайне желательно). Создание aws ec2 или yandex_compute_instance через терраформ - yandex_compute_image, terraform plan выполняется без ошибок. При помощи какого инструмента (из разобранных на прошлом занятии) можно создать свой образ ami?

Ответ: Применительно к YandexCloud - можно создавать образы при помощи packer.

Ссылка на файл : main.tf

terraform {

required_providers {

yandex = {

source = "yandex-cloud/yandex"

}

}

required_version = ">= 0.13"

}

provider yandex {

token = " "

cloud_id = "b1gkgvmr9o8bsvjohk1b"

folder_id = "b1gvmrjec5nkml550njb"

zone = "default-ru-central1-a"

}

resource yandex_compute_image ubu-img {

name = "ubuntu-20-04-lts-v20210908"

source_image = "fd81hgrcv6lsnkremf32"

}

- Основное задание

DevOps В репозитории содержится код проекта на python. Проект - RESTful API сервис. Ваша задача автоматизировать сборку образа с выполнением python-скрипта:

- Образ собирается на основе centos:7

- Python версии не ниже 3.7

- Установлены зависимости: flask flask-jsonpify flask-restful

- Создана директория /python_api

- Скрипт из репозитория размещён в /python_api

- Точка вызова: запуск скрипта

- Если сборка происходит на ветке master: Образ должен пушится в docker registry вашего gitlab python-api:latest, иначе этот шаг нужно пропустить

Product Owner Вашему проекту нужна бизнесовая доработка: необходимо поменять JSON ответа на вызов метода GET /rest/api/get_info, необходимо создать Issue в котором указать:

- Какой метод необходимо исправить

- Текст с { "message": "Already started" } на { "message": "Running"}

- Issue поставить label: feature

Developer Вам пришел новый Issue на доработку, вам необходимо:

- Создать отдельную ветку, связанную с этим issue

- Внести изменения по тексту из задания

- Подготовить Merge Requst, влить необходимые изменения в master, проверить, что сборка прошла успешно

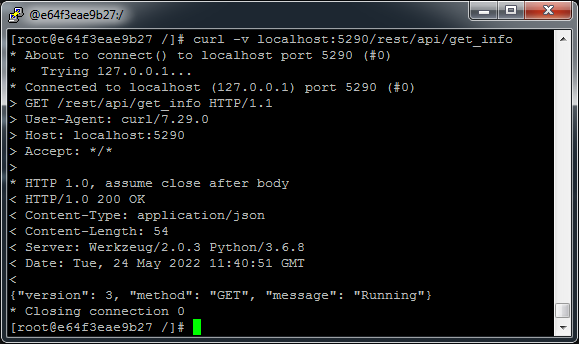

Tester Разработчики выполнили новый Issue, необходимо проверить валидность изменений:

- Поднять докер-контейнер с образом python-api:latest и проверить возврат метода на корректность

- Закрыть Issue с комментарием об успешности прохождения, указав желаемый результат и фактически достигнутый

Ответ:

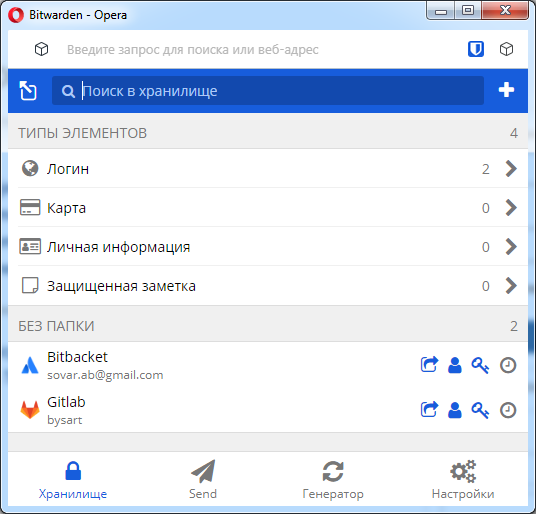

https://gitlab.com/net_gy/gitlab-0906

.gitlab-ci.yml

variables:

tag: latest

regi: registry.gitlab.com/net_gy/gitlab-0906

docker-build:

# Use the official docker image.

image: docker:latest

stage: build

services:

- docker:dind

before_script:

- docker login -u "$CI_REGISTRY_USER" -p "$CI_REGISTRY_PASSWORD" $CI_REGISTRY

# Default branch leaves tag empty (= latest tag)

# All other branches are tagged with the escaped branch name (commit ref slug)

script:

- |

if [[ "$CI_COMMIT_BRANCH" == "$CI_DEFAULT_BRANCH" ]]; then

echo "Running on default branch '$CI_DEFAULT_BRANCH'"

docker build --pull -t ${regi}/python-api:${tag} .

docker push ${regi}/python-api:${tag}

else

echo "Running on branch '$CI_COMMIT_BRANCH', will not be pushed"

fi

# Run this job in a branch where a Dockerfile exists

rules:

- if: $CI_COMMIT_BRANCH

exists:

- Dockerfile

Dockerfile

FROM centos:7

RUN yum install -y python3 python3-pip

RUN pip3 install flask flask-jsonpify flask-restful

COPY python-api.py /opt/python-api/python-api.py

CMD ["python3", "/opt/python-api/python-api.py"]

python-api.py

from flask import Flask, request

from flask_restful import Resource, Api

from json import dumps

from flask_jsonpify import jsonify

app = Flask(__name__)

api = Api(app)

class Info(Resource):

def get(self):

return {'version': 3, 'method': 'GET', 'message': 'Running'}

api.add_resource(Info, '/rest/api/get_info')

if __name__ == '__main__':

app.run(host='0.0.0.0', port='5290')

скрин:

- Основное задание:

- Сделать Freestyle Job, который будет запускать ansible-playbook из форка репозитория

- Сделать Declarative Pipeline, который будет выкачивать репозиторий с плейбукой и запускать её

- Перенести Declarative Pipeline в репозиторий в файл Jenkinsfile

- Перенастроить Job на использование Jenkinsfile из репозитория

- Создать Scripted Pipeline, наполнить его скриптом из pipeline

- Заменить credentialsId на свой собственный

- Проверить работоспособность, исправить ошибки, исправленный Pipeline вложить в репозитрий в файл ScriptedJenkinsfile

- Отправить ссылку на репозиторий в ответе

Ответ:

ScriptedJenkiknsfileq

node("ansible_docker"){

stage("Git checkout"){

git credentialsId: 'vmkey', url: 'git@github.com:bysart/example-playbook.git'

}

stage("Check ssh key"){

secret_check=true

}

stage("Run playbook"){

if (secret_check){

sh 'ansible-galaxy install -r requirements.yml'

sh 'ansible-playbook -i inventory/prod.yml site.yml'

}

else{

echo 'no more keys'

}

}

}

requirements.yml

---

- src: https://github.com/geerlingguy/ansible-role-java.git

scm: git

name: geerlingguy.java

site.yml

---

- hosts: any

tasks:

- name: installing repo for Java 8 in Ubuntu

apt_repository: repo='ppa:openjdk-r/ppa'

- hosts: any

roles:

- role: geerlingguy.java

when: "ansible_os_family == 'Debian'"

java_packages:

- openjdk-8-jdk

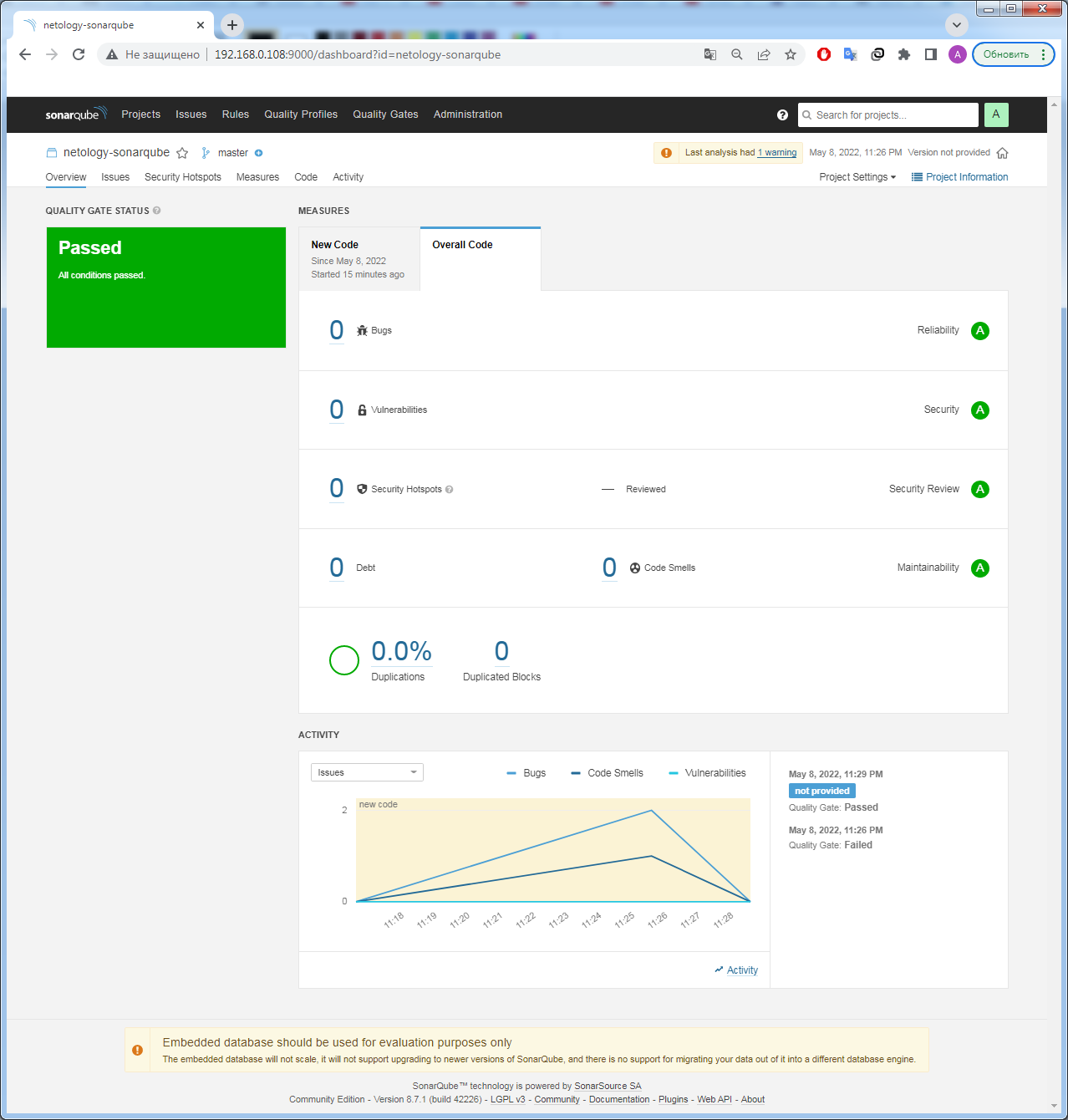

- задание 1 - Знакомоство с SonarQube

Ответ:

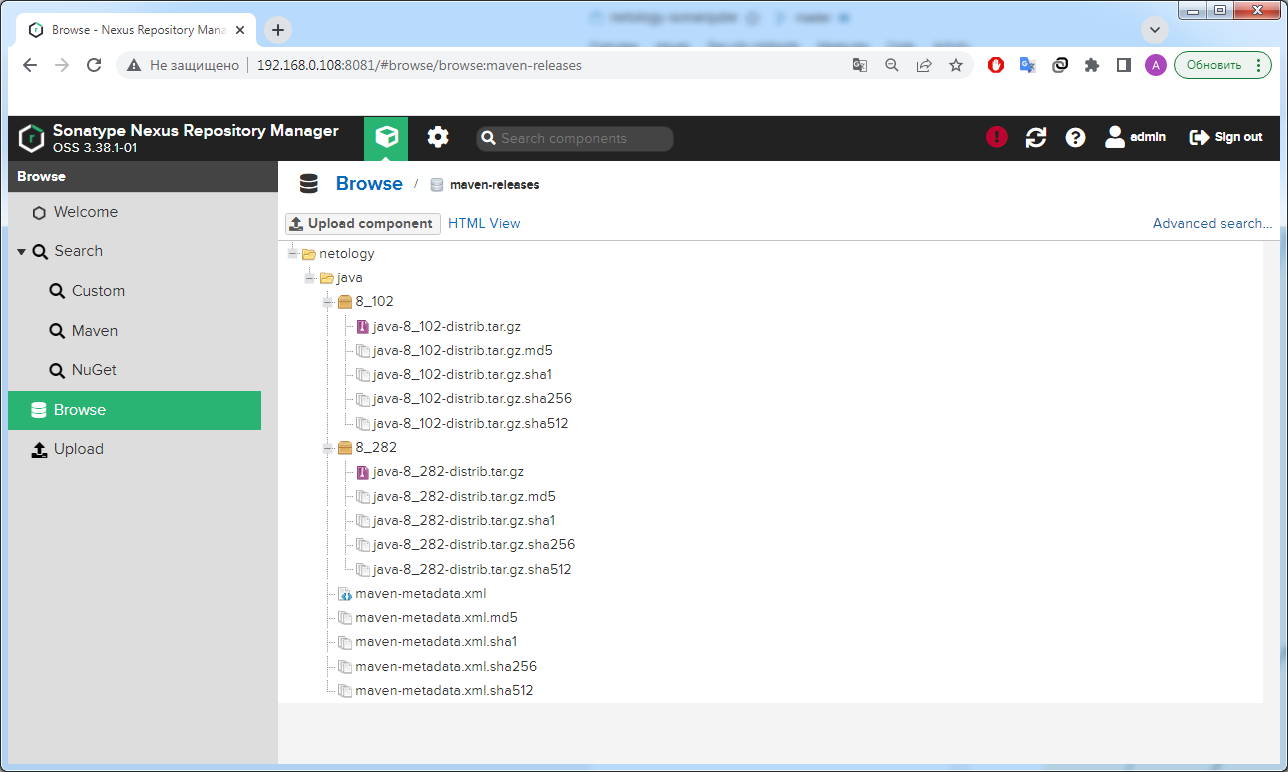

- задание 1 - Знакомоство с Nexus

Ответ:

<metadata modelVersion="1.1.0">

<groupId>netology</groupId>

<artifactId>java</artifactId>

<versioning>

<latest>8_282</latest>

<release>8_282</release>

<versions>

<version>8_102</version>

<version>8_282</version>

</versions>

<lastUpdated>20220508211011</lastUpdated>

</versioning>

</metadata>

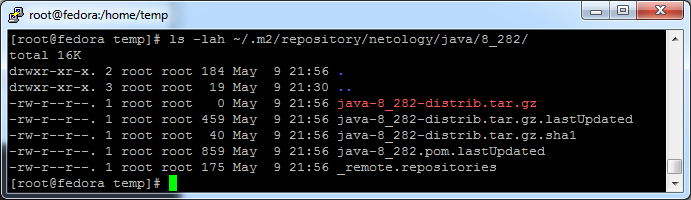

- задание 1 - Знакомоство с Maven

Ответ:

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.netology.app</groupId>

<artifactId>simple-app</artifactId>

<version>1.0-SNAPSHOT</version>

<repositories>

<repository>

<id>my-repo</id>

<name>maven-public</name>

<url>http://localhost:8081/repository/maven-releases/</url>

</repository>

</repositories>

<dependencies>

<dependency>

<groupId>netology</groupId>

<artifactId>java</artifactId>

<version>8_282</version>

<classifier>distrib</classifier>

<type>tar.gz</type>

</dependency>

</dependencies>

</project>

- Получить бесплатную JIRA. Настроить её для своей "команды разработки". Создать доски kanban и scrum. Если всё отработало в рамках ожидания - выгрузить схемы workflow для импорта в XML. Файлы с workflow приложить к решению задания.

Ответ: Бесплатный доступ к JIRA получил, настроил два бизнес процесса, две доски - Scrum, Kanban. Результаты загрузил в директорию:

- Выбор инструментов Какой тип инфраструктуры будем использовать для этого проекта: изменяемый или не изменяемый? Будет ли центральный сервер для управления инфраструктурой? Будут ли агенты на серверах? Будут ли использованы средства для управления конфигурацией или инициализации ресурсов?

Ответ: В силу определенных входных данных, считаю необходимым сделать выбор в пользу:

Тип инфраструктуры: не изменяемый, так как уже есть образы Packer и Docker, в том, числе разработчики привыкли к контейнерам, то ввел бы, как стандарт образы Docker, как платформа предоставления серверных мощностей (серверов), так как есть уже Kuber, то его бы использовал, как решение оркестрации контейнеров, тем более это будет задачей будущего с возростанием количества клиентов. Ansible - инструмент подготовки ENV внутри уже подготовленных контейнеров, в том числе Terraform - применял бы в части Cloud решений. Так как Ansible инструмент без использования агентов, то на сервера не устанавливаются агенты. Ansible - инструмент без центрального сервера. В части поставленных задач, все, что относится к Private Cloud использовал бы управление конфигурацией, часть сервиса, что располагается в Public Cloud - использовал бы инициализацию ресурсов.

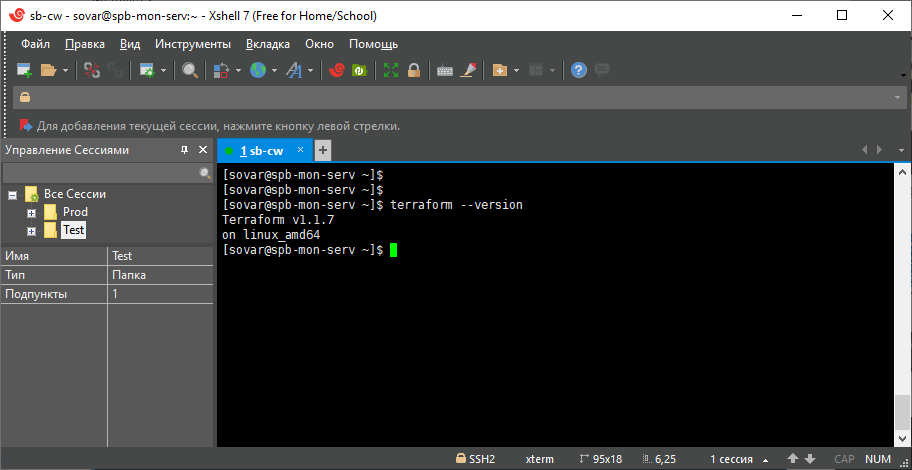

- Установка терраформ Установите терраформ при помощи менеджера пакетов используемого в вашей операционной системе. В виде результата этой задачи приложите вывод команды terraform --version

Ответ:

Устанавливал не через пакетный менеджер. Скачал бинарник с зеркала, скопировал в директорию

/usr/local/bin/

- В виде результата этой задачи приложите вывод --version двух версий терраформа доступных на вашем компьютере или виртуальной машине

Ответ: Скачал два бинирника, положил в разные директории, сделал symlink-и

[sovar@spb-mon-serv temp]$ ls -lah /usr/local/terraform/

total 16K

drwxr-xr-x. 4 root root 4.0K Mar 18 14:44 .

drwxr-xr-x. 13 root root 4.0K Mar 18 14:43 ..

drwxr-xr-x. 2 root root 4.0K Mar 18 14:45 tr0.12.31

drwxr-xr-x. 2 root root 4.0K Mar 18 14:43 tr1.1.7

[sovar@spb-mon-serv temp]$ sudo ln -s /usr/local/terraform/tr0.12.31/terraform /usr/local/bin/terraform0.12.31

[sovar@spb-mon-serv temp]$ sudo ln -s /usr/local/terraform/tr1.1.7/terraform /usr/local/bin/terraform1.1.7

[sovar@spb-mon-serv temp]$ terraform0.12.31 -v

Terraform v0.12.31

Your version of Terraform is out of date! The latest version

is 1.1.7. You can update by downloading from https://www.terraform.io/downloads.html

[sovar@spb-mon-serv temp]$ terraform1.1.7 -v

Terraform v1.1.7

on linux_amd64

- Пользователь (разработчик) написал в канал поддержки, что у него уже 3 минуты происходит CRUD операция в MongoDB и её нужно прервать. Вы как инженер поддержки решили произвести данную операцию: напишите список операций, которые вы будете производить для остановки запроса пользователя предложите вариант решения проблемы с долгими (зависающими) запросами в MongoDB

Ответ:

В первую очередь необходимо найти данную операцию - db.currentOp(). После можно воспользоваться командой db.killOp(), чтобы прервать выполнение команды.

Для того, чтобы не попадать в такую ситуацию, возможно использование параметра maxTimeMS() для запросов CRUD в MongoDB.

- Вы запустили инстанс Redis для использования совместно с сервисом, который использует механизм TTL. Причем отношение количества записанных key-value значений к количеству истёкших значений есть величина постоянная и увеличивается пропорционально количеству реплик сервиса. При масштабировании сервиса до N реплик вы увидели, что: сначала рост отношения записанных значений к истекшим Redis блокирует операции записи Как вы думаете, в чем может быть проблема?

Ответ: В Redis есть два способа очистить просроченные записи: "ленивый" и "активный". В случае с ленивым - просроченные записи запрашиваются командой, активный способ - повторяется каждые 100 миллисекунд и проводит записи в состояние устаревшие, затем данные записи исключаются. ACTIVE_EXPIRE_CYCLE_LOOKUPS_PER_LOOP по умолчанию имеет значение 20, таким образом за раз можно пометить и очистить около 200 устаревших записей. Процесс проверки зациклится и мы ощутим задержки, а потом и вовсе не будут приниматься данные на запись, если появятся истекшие записи более 25% по отношению ко всем. В данном случае как раз так и получается. Такой подход необходим, чтобы не использовать слишком много памяти для ключей, срок действия которых уже истек.

- Вы подняли базу данных MySQL для использования в гис-системе. При росте количества записей, в таблицах базы, пользователи начали жаловаться на ошибки вида: InterfaceError: (InterfaceError) 2013: Lost connection to MySQL server during query u'SELECT..... ' Как вы думаете, почему это начало происходить и как локализовать проблему? Какие пути решения данной проблемы вы можете предложить?

Ответ:

Скорее всего проблема заключается в том, что данные BLOB больше, чем значение max_allowed_packet, чтобы избежать подобных вещей следует увеличить значение max_allowed_packet

- Вы решили перевести гис-систему из задачи 3 на PostgreSQL, так как прочитали в документации, что эта СУБД работает с большим объемом данных лучше, чем MySQL. После запуска пользователи начали жаловаться, что СУБД время от времени становится недоступной. В dmesg вы видите, что: postmaster invoked oom-killer Как вы думаете, что происходит? Как бы вы решили данную проблему?

Ответ: Когда памяти не хватает, вызывается oom-killer и уничтожается процесс PostgreSQL. Необходимо проверить настройки сервиса в части памяти, внести корректировки.

- Используя докер образ centos:7 как базовый и документацию по установке и запуску Elastcisearch: составьте Dockerfile-манифест для elasticsearch; соберите docker-образ и сделайте push в ваш docker.io репозиторий; запустите контейнер из получившегося образа и выполните запрос пути / c хост-машины; Требования к elasticsearch.yml: данные path должны сохраняться в /var/lib; имя ноды должно быть netology_test; В ответе приведите: текст Dockerfile манифеста ссылку на образ в репозитории dockerhub ответ elasticsearch на запрос пути / в json виде

Ответ:

Dockerfile:

FROM centos:centos7

RUN yum -y install wget; yum clean all && \

groupadd --gid 1000 elasticsearch && \

adduser --uid 1000 --gid 1000 --home /usr/share/elasticsearch elasticsearch && \

mkdir /var/lib/elasticsearch/ && \

chown -R 1000:1000 /var/lib/elasticsearch/

USER 1000:1000

WORKDIR /usr/share/elasticsearch

ENV EL_VER=8.0.1

RUN wget -q https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-${EL_VER}-linux-x86_64.tar.gz && \

tar -xzf elasticsearch-${EL_VER}-linux-x86_64.tar.gz && \

cp -rp elasticsearch-${EL_VER}/* ./ && \

rm -rf elasticsearch-${EL_VER}*

COPY ./config/elasticsearch.yml /usr/share/elasticsearch/config/

EXPOSE 9200

CMD ["bin/elasticsearch"]

Link to dockerhub: https://hub.docker.com/r/bysart/es

Ответ ES:

[elasticsearch@d9266f5869ec ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200

Enter host password for user 'elastic':

{

"name" : "netology_test",

"cluster_name" : "netology",

"cluster_uuid" : "speGr8sMRA-NkZG3gjJPYw",

"version" : {

"number" : "8.0.1",

"build_flavor" : "default",

"build_type" : "tar",

"build_hash" : "801d9ccc7c2ee0f2cb121bbe22ab5af77a902372",

"build_date" : "2022-02-24T13:55:40.601285296Z",

"build_snapshot" : false,

"lucene_version" : "9.0.0",

"minimum_wire_compatibility_version" : "7.17.0",

"minimum_index_compatibility_version" : "7.0.0"

},

"tagline" : "You Know, for Search"

}

- Ознакомтесь с документацией и добавьте в elasticsearch 3 индекса, в соответствии со таблицей. Получите список индексов и их статусов, используя API и приведите в ответе на задание. Получите состояние кластера elasticsearch, используя API. Как вы думаете, почему часть индексов и кластер находится в состоянии yellow? Удалите все индексы.

Ответ:

Список индексов и их статусы:

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X PUT https://localhost:9200/ind-1?pretty -H 'Content-Type: application/json' -d'{ "settings": { "index": { "number_of_shards": 1, "number_of_replicas": 0 }}}'

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X PUT https://localhost:9200/ind-2?pretty -H 'Content-Type: application/json' -d'{ "settings": { "index": { "number_of_shards": 2, "number_of_replicas": 1 }}}'

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X PUT https://localhost:9200/ind-3?pretty -H 'Content-Type: application/json' -d'{ "settings": { "index": { "number_of_shards": 4, "number_of_replicas": 2 }}}'

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200/_cat/indices?v

Enter host password for user 'elastic':

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open ind-1 wKioCclpQgKO3UL_yzwZgg 1 0 0 0 225b 225b

yellow open ind-3 0kOnROPHQd-hOX9IduPksw 4 2 0 0 900b 900b

yellow open ind-2 oVkx8NaLTIGxrmRY_xO7fQ 2 1 0 0 450b 450b

Состояние кластера:

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200/_cluster/health?pretty

Enter host password for user 'elastic':

{

"cluster_name" : "netology",

"status" : "yellow",

"timed_out" : false,

"number_of_nodes" : 1,

"number_of_data_nodes" : 1,

"active_primary_shards" : 9,

"active_shards" : 9,

"relocating_shards" : 0,

"initializing_shards" : 0,

"unassigned_shards" : 10,

"delayed_unassigned_shards" : 0,

"number_of_pending_tasks" : 0,

"number_of_in_flight_fetch" : 0,

"task_max_waiting_in_queue_millis" : 0,

"active_shards_percent_as_number" : 47.368421052631575

}

Состояние yellow по кластеру связано с тем, что есть unassigned шарды.

Удаление индексов:

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X DELETE https://localhost:9200/ind-1?pretty

Enter host password for user 'elastic':

{

"acknowledged" : true

}

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X DELETE https://localhost:9200/ind-2?pretty

Enter host password for user 'elastic':

{

"acknowledged" : true

}

[elasticsearch@71ef1a8e572b ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X DELETE https://localhost:9200/ind-3?pretty

Enter host password for user 'elastic':

{

"acknowledged" : true

}

- Создайте директорию {путь до корневой директории с elasticsearch в образе}/snapshots. Используя API зарегистрируйте данную директорию как snapshot repository c именем netology_backup. Приведите в ответе запрос API и результат вызова API для создания репозитория. Создайте индекс test с 0 реплик и 1 шардом и приведите в ответе список индексов. Создайте snapshot состояния кластера elasticsearch. Приведите в ответе список файлов в директории со snapshotами. Удалите индекс test и создайте индекс test-2. Приведите в ответе список индексов. Восстановите состояние кластера elasticsearch из snapshot, созданного ранее. Приведите в ответе запрос к API восстановления и итоговый список индексов.

Ответ:

В elasticsearch.yml была добавлена директива path.repo: /usr/share/elasticsearch/snapshots, сам запрос на регистрацию snapshot repo:

[elasticsearch@2403641c68f1 ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X PUT https://localhost:9200/_snapshot/netology_backup?pretty -H 'Content-Type: application/json' -d' { "type": "fs", "settings": { "location": "/usr/share/elasticsearch/snapshots"}}'

Enter host password for user 'elastic':

{

"acknowledged" : true

}

Список индексов:

[elasticsearch@2403641c68f1 ~]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200/_cat/indices?v

Enter host password for user 'elastic':

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open test 7rRcEyc6S6GXZJ5B3_ii0w 1 0 0 0 225b 225b

Директория snapshots до snapshot:

[elasticsearch@2403641c68f1 snapshots]$ ls -lah /usr/share/elasticsearch/snapshots

total 16K

drwxrwxr-x. 2 elasticsearch elasticsearch 4.0K Mar 9 11:31 .

drwx------. 1 elasticsearch elasticsearch 4.0K Mar 9 11:24 ..

Директория snapshots после snapshot

[elasticsearch@2403641c68f1 snapshots]$ ls -lah /usr/share/elasticsearch/snapshots

total 52K

drwxrwxr-x. 3 elasticsearch elasticsearch 4.0K Mar 9 11:48 .

drwx------. 1 elasticsearch elasticsearch 4.0K Mar 9 11:24 ..

-rw-r--r--. 1 elasticsearch elasticsearch 1.1K Mar 9 11:48 index-0

-rw-r--r--. 1 elasticsearch elasticsearch 8 Mar 9 11:48 index.latest

drwxr-xr-x. 5 elasticsearch elasticsearch 4.0K Mar 9 11:48 indices

-rw-r--r--. 1 elasticsearch elasticsearch 18K Mar 9 11:48 meta-YCONu7qjRemBquBUkalV2g.dat

-rw-r--r--. 1 elasticsearch elasticsearch 396 Mar 9 11:48 snap-YCONu7qjRemBquBUkalV2g.dat

Список индексов после удаления test и создания test-2

[elasticsearch@2403641c68f1 snapshots]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200/_cat/indices?v

Enter host password for user 'elastic':

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open test-2 sPegl4shSY-fY0soZ2eEkw 1 0 0 0 225b 225b

Запрос на восстановление, список индексов:

[elasticsearch@2403641c68f1 snapshots]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic -X POST https://localhost:9200/_snapshot/netology_backup/snapshot_09_03_2022/_restore?pretty

Enter host password for user 'elastic':

{

"accepted" : true

}

[elasticsearch@2403641c68f1 snapshots]$ curl --cacert /usr/share/elasticsearch/config/certs/http_ca.crt -u elastic https://localhost:9200/_cat/indices?v

Enter host password for user 'elastic':

health status index uuid pri rep docs.count docs.deleted store.size pri.store.size

green open test-2 sPegl4shSY-fY0soZ2eEkw 1 0 0 0 225b 225b

green open test cIFjzz5mQ2O8Ng5mLlKuCQ 1 0 0 0 225b 225b

- Используя docker поднимите инстанс PostgreSQL (версию 13). Данные БД сохраните в volume. Подключитесь к БД PostgreSQL используя psql. Воспользуйтесь командой ? для вывода подсказки по имеющимся в psql управляющим командам. Найдите и приведите управляющие команды для: вывода списка БД подключения к БД вывода списка таблиц вывода описания содержимого таблиц выхода из psql

Ответ:

\l - список БД

\c[onnect] {[DBNAME|- USER|- HOST|- PORT|-] | conninfo} connect to new database (currently "postgres") - подключение к БД

\dt[S+] [PATTERN] - список таблиц

\d[S+] NAME - описание содержимого таблиц

\q - выход из psql

- Используя psql создайте БД test_database. Изучите бэкап БД. Восстановите бэкап БД в test_database. Перейдите в управляющую консоль psql внутри контейнера. Подключитесь к восстановленной БД и проведите операцию ANALYZE для сбора статистики по таблице. Используя таблицу pg_stats, найдите столбец таблицы orders с наибольшим средним значением размера элементов в байтах. Приведите в ответе команду, которую вы использовали для вычисления и полученный результат.

Ответ:

Восстановление БД из дампа

postgres@spb-mon-serv:/$ psql -f /backup/dump.sql test_database

SET

SET

SET

SET

SET

set_config

------------

(1 row)

SET

SET

SET

SET

SET

SET

CREATE TABLE

ALTER TABLE

CREATE SEQUENCE

ALTER TABLE

ALTER SEQUENCE

ALTER TABLE

COPY 8

setval

--------

8

(1 row)

ALTER TABLE

Сбор статистики по таблице

postgres=# analyze verbose orders;

INFO: analyzing "public.orders"

INFO: "orders": scanned 1 of 1 pages, containing 8 live rows and 0 dead rows; 8 rows in sample, 8 estimated total rows

ANALYZE

Использование таблицы pg_stats

postgres=# select avg_width from pg_stats where tablename='orders';

avg_width

-----------

4

16

4

(3 rows)

- Архитектор и администратор БД выяснили, что ваша таблица orders разрослась до невиданных размеров и поиск по ней занимает долгое время. Вам, как успешному выпускнику курсов DevOps в нетологии предложили провести разбиение таблицы на 2 (шардировать на orders_1 - price>499 и orders_2 - price<=499). Предложите SQL-транзакцию для проведения данной операции. Можно ли было изначально исключить "ручное" разбиение при проектировании таблицы orders?

Ответ:

Да, можно было избежать разбиения таблицы вручную, необходимо было определить тип на моменте проектирования и создания - partitioned table

postgres=#

begin;

create table orders_new (

id integer NOT NULL,

title varchar(80) NOT NULL,

price integer) partition by range(price);

create table orders_less partition of orders_new for values from (0) to (499);

create table orders_more partition of orders_new for values from (499) to (99999);

insert into orders_new (id, title, price) select * from orders;

commit;

BEGIN

CREATE TABLE

CREATE TABLE

CREATE TABLE

INSERT 0 8

COMMIT

- Используя утилиту pg_dump создайте бекап БД test_database. Как бы вы доработали бэкап-файл, чтобы добавить уникальность значения столбца title для таблиц test_database?

Ответ: Для определения занчения столбца title можно было бы использовать индекс, для обеспечения уникальности.

postgres@spb-mon-serv:/$ pg_dump -d test_database > /backup/db_dump.sql

- Используя docker поднимите инстанс MySQL (версию 8). Данные БД сохраните в volume. Изучите бэкап БД и восстановитесь из него. Перейдите в управляющую консоль mysql внутри контейнера. Используя команду \h получите список управляющих команд. Найдите команду для выдачи статуса БД и приведите в ответе из ее вывода версию сервера БД. Подключитесь к восстановленной БД и получите список таблиц из этой БД. Приведите в ответе количество записей с price > 300. В следующих заданиях мы будем продолжать работу с данным контейнером.

Ответ:

статус и версия сервера БД

mysql> status

--------------

mysql Ver 8.0.28 for Linux on x86_64 (MySQL Community Server - GPL)

Connection id: 20

Current database: test_db

Current user: root@localhost

SSL: Not in use

Current pager: stdout

Using outfile: ''

Using delimiter: ;

Server version: 8.0.28 MySQL Community Server - GPL

Protocol version: 10

Connection: Localhost via UNIX socket

Server characterset: utf8mb4

Db characterset: utf8mb4

Client characterset: latin1

Conn. characterset: latin1

UNIX socket: /var/run/mysqld/mysqld.sock

Binary data as: Hexadecimal

Uptime: 40 min 23 sec

Threads: 2 Questions: 103 Slow queries: 0 Opens: 219 Flush tables: 3 Open tables: 137 Queries per second avg: 0.042

--------------

список таблиц

mysql> show tables;

+-------------------+

| Tables_in_test_db |

+-------------------+

| orders |

+-------------------+

1 row in set (0.00 sec)

количество записей с price > 300

mysql> select count(*) from orders where price>300;

+----------+

| count(*) |

+----------+

| 1 |

+----------+

1 row in set (0.00 sec)

- Создайте пользователя test в БД c паролем test-pass, используя: плагин авторизации mysql_native_password срок истечения пароля - 180 дней количество попыток авторизации - 3 максимальное количество запросов в час - 100 аттрибуты пользователя: Фамилия "Pretty" Имя "James" Предоставьте привелегии пользователю test на операции SELECT базы test_db. Используя таблицу INFORMATION_SCHEMA.USER_ATTRIBUTES получите данные по пользователю test и приведите в ответе к задаче.

Ответ:

создание пользователя

create user 'test'@'localhost'

identified with mysql_native_password by 'test-pass'

with max_queries_per_hour 100

password expire interval 180 day

failed_login_attempts 3

attribute '{"fname": "James","lname": "Pretty"}';

предоставление права

mysql> grant select on test_db. to test@'localhost';

mysql> flush privileges;

информация по пользователю

mysql> select * from INFORMATION_SCHEMA.USER_ATTRIBUTEs where user = 'test';

+------+-----------+---------------------------------------+

| USER | HOST | ATTRIBUTE |

+------+-----------+---------------------------------------+

| test | localhost | {"fname": "James", "lname": "Pretty"} |

+------+-----------+---------------------------------------+

1 row in set (0.00 sec)

- Установите профилирование SET profiling = 1. Изучите вывод профилирования команд SHOW PROFILES;. Исследуйте, какой engine используется в таблице БД test_db и приведите в ответе. Измените engine и приведите время выполнения и запрос на изменения из профайлера в ответе: на MyISAM на InnoDB

Ответ:

информация по engine

mysql> show table status where name = 'orders';

+--------+--------+---------+------------+------+----------------+-------------+-----------------+--------------+-----------+----------------+---------------------+---------------------+------------+--------------------+----------+----------------+---------+

| Name | Engine | Version | Row_format | Rows | Avg_row_length | Data_length | Max_data_length | Index_length | Data_free | Auto_increment | Create_time | Update_time | Check_time | Collation | Checksum | Create_options | Comment |

+--------+--------+---------+------------+------+----------------+-------------+-----------------+--------------+-----------+----------------+---------------------+---------------------+------------+--------------------+----------+----------------+---------+

| orders | InnoDB | 10 | Dynamic | 5 | 3276 | 16384 | 0 | 0 | 0 | 6 | 2022-02-28 18:57:41 | 2022-02-28 18:57:41 | NULL | utf8mb4_0900_ai_ci | NULL | | |

+--------+--------+---------+------------+------+----------------+-------------+-----------------+--------------+-----------+----------------+---------------------+---------------------+------------+--------------------+----------+----------------+---------+

1 row in set (0.00 sec)

mysql> SHOW PROFILES;

+----------+------------+----------------------------------+

| Query_ID | Duration | Query |

+----------+------------+----------------------------------+

| 11 | 0.09740925 | ALTER TABLE orders ENGINE=MyISAM |

| 12 | 0.11446900 | ALTER TABLE orders ENGINE=InnoDB |

+----------+------------+----------------------------------+

2 rows in set, 1 warning (0.00 sec)

- Изучите файл my.cnf в директории /etc/mysql. Измените его согласно ТЗ (движок InnoDB): Скорость IO важнее сохранности данных Нужна компрессия таблиц для экономии места на диске Размер буффера с незакомиченными транзакциями 1 Мб Буффер кеширования 30% от ОЗУ Размер файла логов операций 100 Мб Приведите в ответе измененный файл my.cnf.

Ответ:

[mysqld]

pid-file = /var/run/mysqld/mysqld.pid

socket = /var/run/mysqld/mysqld.sock

datadir = /var/lib/mysql

secure-file-priv= NULL

innodb_flush_log_at_trx_commit = 0

innodb_file_per_table = 1

autocommit = 0

innodb_log_buffer_size = 1M

key_buffer_size = 2448М

max_binlog_size = 100M

- Используя docker поднимите инстанс PostgreSQL (версию 12) c 2 volume, в который будут складываться данные БД и бэкапы. Приведите получившуюся команду или docker-compose манифест.

Ответ:

version: "3.9"

volumes:

postgressql_data:

backup_postgressql_data:

services:

postgressql:

image: postgres:12-bullseye

container_name: postgressql

environment:

- PGDATA=/var/lib/postgresql/data/

- POSTGRES_PASSWORD=pspass

volumes:

- postgressql_data:/var/lib/postgresql/data

- backup_postgressql_data:/backup

- ./config:/docker-entrypoint-initdb.d

network_mode: "host"

2.-5. Задания c 2 пункта по 5 пункт

При выполнении заданий 2-5 сгруппировал все в одно. Представил, что необходимо подготовить не просто БД, а уже преднастроенную. Для простаты проверки сбрасываю линк на задания: https://github.com/netology-code/virt-homeworks/tree/virt-11/06-db-02-sql

Ответ:

При старте контейнера использовал директорию /docker-entrypoint-initdb.d для объявление и запуска скрипта инициализации, который подготавливает среду: на вход psql подаю файл с описание всех необходимых команд. Важно заметить, что скрипты, которые размещены в /docker-entrypoint-initdb.d будут работать только при старте контейнера первый раз. Хотелось проверить отработает или нет. Для того, чтобы не держать в голове это ограничение и для идемпотентности следовало бы использовать директиву command в docker compose, в таком случае необходимо было поменять скрипт.

#!/bin/bash

psql -f docker-entrypoint-initdb.d/setup-after-up

setup-after-up

CREATE DATABASE test_db

TEMPLATE template0

ENCODING 'UTF-8';

CREATE USER "test-admin-user";

CREATE USER "test-simple-user";

CREATE TABLE orders (

id serial PRIMARY KEY,

order_name varchar(25) NOT NULL CHECK (order_name <> ''),

price integer NOT NULL CHECK (price > 0)

);

CREATE TABLE clients (

id serial PRIMARY KEY,

last_name varchar(45) NOT NULL CHECK (last_name <> ''),

country varchar(35) NOT NULL CHECK (country <> ''),

order_number integer REFERENCES orders

);

CREATE INDEX country_index ON clients(country);

GRANT ALL ON ALL TABLES IN SCHEMA "public" TO "test-admin-user";

GRANT SELECT, INSERT, UPDATE, DELETE

ON ALL TABLES IN SCHEMA "public"

TO "test-simple-user";

\o /tmp/output-task2

\l

\d+ orders

\d+ clients

SELECT table_name, grantee, privilege_type

FROM information_schema.role_table_grants

WHERE table_name='orders';

SELECT table_name, grantee, privilege_type

FROM information_schema.role_table_grants

WHERE table_name='clients';

\o

INSERT INTO orders

VALUES (1, 'Шоколад', 10),

(2, 'Принтер', 3000),

(3, 'Книга', 500),

(4, 'Монитор', 7000),

(5, 'Гитара', 4000);

INSERT INTO clients

VALUES (1, 'Иванов Иван Иванович', 'USA'),

(2, 'Петров Петр Петрович', 'Canada'),

(3, 'Иоганн Себастьян Бах', 'Japan'),

(4, 'Ронни Джеймс Дио', 'Russia'),

(5, 'Ritchie Blackmore', 'Russia');

\o /tmp/output-task3

SELECT * FROM orders;

SELECT * FROM clients;

SELECT COUNT(*) FROM orders;

SELECT COUNT(*) FROM clients;

\o

UPDATE clients SET order_number=3 WHERE id=1;

UPDATE clients SET order_number=4 WHERE id=2;

UPDATE clients SET order_number=5 WHERE id=3;

\o /tmp/output-task4

SELECT * FROM clients;

SELECT * FROM clients WHERE order_number IS NOT NULL;

\o /tmp/output-task5

EXPLAIN (FORMAT YAML) SELECT * FROM clients WHERE order_number IS NOT NULL;

Для контроля выполнения команд sql результат выполнения записывал в файлы.

output-task2:

List of databases

Name | Owner | Encoding | Collate | Ctype | Access privileges

-----------+----------+----------+------------+------------+-----------------------

postgres | postgres | UTF8 | en_US.utf8 | en_US.utf8 |

template0 | postgres | UTF8 | en_US.utf8 | en_US.utf8 | =c/postgres +

| | | | | postgres=CTc/postgres

template1 | postgres | UTF8 | en_US.utf8 | en_US.utf8 | =c/postgres +

| | | | | postgres=CTc/postgres

test_db | postgres | UTF8 | en_US.utf8 | en_US.utf8 |

(4 rows)

Table "public.orders"

Column | Type | Collation | Nullable | Default | Storage | Stats target | Description

------------+-----------------------+-----------+----------+------------------------------------+----------+--------------+-------------

id | integer | | not null | nextval('orders_id_seq'::regclass) | plain | |

order_name | character varying(25) | | not null | | extended | |

price | integer | | not null | | plain | |

Indexes:

"orders_pkey" PRIMARY KEY, btree (id)

Check constraints:

"orders_order_name_check" CHECK (order_name::text <> ''::text)

"orders_price_check" CHECK (price > 0)

Referenced by:

TABLE "clients" CONSTRAINT "clients_order_number_fkey" FOREIGN KEY (order_number) REFERENCES orders(id)

Access method: heap

Table "public.clients"

Column | Type | Collation | Nullable | Default | Storage | Stats target | Description

--------------+-----------------------+-----------+----------+-------------------------------------+----------+--------------+-------------

id | integer | | not null | nextval('clients_id_seq'::regclass) | plain | |

last_name | character varying(45) | | not null | | extended | |

country | character varying(35) | | not null | | extended | |

order_number | integer | | | | plain | |

Indexes:

"clients_pkey" PRIMARY KEY, btree (id)

"country_index" btree (country)

Check constraints:

"clients_country_check" CHECK (country::text <> ''::text)

"clients_last_name_check" CHECK (last_name::text <> ''::text)

Foreign-key constraints:

"clients_order_number_fkey" FOREIGN KEY (order_number) REFERENCES orders(id)

Access method: heap

table_name | grantee | privilege_type

------------+------------------+----------------

orders | postgres | INSERT

orders | postgres | SELECT

orders | postgres | UPDATE

orders | postgres | DELETE

orders | postgres | TRUNCATE

orders | postgres | REFERENCES

orders | postgres | TRIGGER

orders | test-admin-user | INSERT

orders | test-admin-user | SELECT

orders | test-admin-user | UPDATE

orders | test-admin-user | DELETE

orders | test-admin-user | TRUNCATE

orders | test-admin-user | REFERENCES

orders | test-admin-user | TRIGGER

orders | test-simple-user | INSERT

orders | test-simple-user | SELECT

orders | test-simple-user | UPDATE

orders | test-simple-user | DELETE

(18 rows)

table_name | grantee | privilege_type

------------+------------------+----------------

clients | postgres | INSERT

clients | postgres | SELECT

clients | postgres | UPDATE

clients | postgres | DELETE

clients | postgres | TRUNCATE

clients | postgres | REFERENCES

clients | postgres | TRIGGER

clients | test-admin-user | INSERT

clients | test-admin-user | SELECT

clients | test-admin-user | UPDATE

clients | test-admin-user | DELETE

clients | test-admin-user | TRUNCATE

clients | test-admin-user | REFERENCES

clients | test-admin-user | TRIGGER

clients | test-simple-user | INSERT

clients | test-simple-user | SELECT

clients | test-simple-user | UPDATE

clients | test-simple-user | DELETE

(18 rows)

output-task3

id | order_name | price

----+------------+-------

1 | Шоколад | 10

2 | Принтер | 3000

3 | Книга | 500

4 | Монитор | 7000

5 | Гитара | 4000

(5 rows)

id | last_name | country | order_number

----+----------------------+---------+--------------

1 | Иванов Иван Иванович | USA |

2 | Петров Петр Петрович | Canada |

3 | Иоганн Себастьян Бах | Japan |

4 | Ронни Джеймс Дио | Russia |

5 | Ritchie Blackmore | Russia |

(5 rows)

count

-------

5

(1 row)

count

-------

5

(1 row)

output-task4

id | last_name | country | order_number

----+----------------------+---------+--------------

4 | Ронни Джеймс Дио | Russia |

5 | Ritchie Blackmore | Russia |

1 | Иванов Иван Иванович | USA | 3

2 | Петров Петр Петрович | Canada | 4

3 | Иоганн Себастьян Бах | Japan | 5

(5 rows)

id | last_name | country | order_number

----+----------------------+---------+--------------

1 | Иванов Иван Иванович | USA | 3

2 | Петров Петр Петрович | Canada | 4

3 | Иоганн Себастьян Бах | Japan | 5

(3 rows)

output-task4.

EXPLAIN - позволяет нам дать служебную информацию о запросе к БД, в том числе время на выполнение запроса, что при оптимизации работы БД является очень полезной информацией.

QUERY PLAN

------------------------------------------

- Plan: +

Node Type: "Seq Scan" +

Parallel Aware: false +

Relation Name: "clients" +

Alias: "clients" +

Startup Cost: 0.00 +

Total Cost: 13.50 +

Plan Rows: 348 +

Plan Width: 204 +

Filter: "(order_number IS NOT NULL)"

(1 row)

- Создайте бэкап БД test_db и поместите его в volume, предназначенный для бэкапов (см. Задачу 1). Остановите контейнер с PostgreSQL (но не удаляйте volumes). Поднимите новый пустой контейнер с PostgreSQL. Восстановите БД test_db в новом контейнере. Приведите список операций, который вы применяли для бэкапа данных и восстановления.

Ответ:

Делаем бэкап

postgres@spb-svc:/$ pg_dumpall > /backup/backup_"`date +"%d-%m-%Y"`"

Останавливаем контейнер и удаляем его

[sovar@spb-mon-serv build-postgressql]$ docker compose down

[+] Running 1/1

⠿ Container postgressql Removed 0.3s 0.3s

Удаляем volume с данными

sovar@spb-mon-serv build-postgressql]$ docker volume ls

DRIVER VOLUME NAME

local build-mon-service_grafana_data

local build-mon-service_prometheus_data

local build-postgressql_backup_postgressql_data

local build-postgressql_postgressql_data

[sovar@spb-mon-serv build-postgressql]$ docker volume rm build-postgressql_postgressql_data

build-postgressql_postgressql_data

[sovar@spb-mon-serv build-postgressql]$ docker volume ls

DRIVER VOLUME NAME

local build-mon-service_grafana_data

local build-mon-service_prometheus_data

local build-postgressql_backup_postgressql_data

Стартуем новый контейнер, при этом скрипт инициализации, который у нас был убираем, дабы не получить готовую БД

[sovar@spb-mon-serv build-postgressql]$ docker compose up

[+] Running 2/2

⠿ Volume "build-postgressql_postgressql_data" Created 0.0s

⠿ Container postgressql Created 0.1s

Коннект к контейнеру, чтобы убедиться, что нам есть с чего восстановиться

[sovar@spb-mon-serv build-postgressql]$ docker exec -it postgressql bash

postgres@spb-mon-serv:/$ ls backup/

backup_20-02-2022

Восстановление из бекапа

postgres@spb-mon-serv:/$ psql -f /backup/backup_20-02-2022

Проверка, что восстановление успешно

postgres-# \l

List of databases

Name | Owner | Encoding | Collate | Ctype | Access privileges

-----------+----------+----------+------------+------------+-----------------------

postgres | postgres | UTF8 | en_US.utf8 | en_US.utf8 |

template0 | postgres | UTF8 | en_US.utf8 | en_US.utf8 | =c/postgres +

| | | | | postgres=CTc/postgres

template1 | postgres | UTF8 | en_US.utf8 | en_US.utf8 | =c/postgres +

| | | | | postgres=CTc/postgres

test_db | postgres | UTF8 | en_US.utf8 | en_US.utf8 |

(4 rows)

postgres-# \dt

List of relations

Schema | Name | Type | Owner

--------+---------+-------+----------

public | clients | table | postgres

public | orders | table | postgres

(2 rows)

postgres=# SELECT * FROM orders;

id | order_name | price

----+------------+-------

1 | Шоколад | 10

2 | Принтер | 3000

3 | Книга | 500

4 | Монитор | 7000

5 | Гитара | 4000

(5 rows)

postgres=# SELECT * FROM clients;

id | last_name | country | order_number

----+----------------------+---------+--------------

4 | Ронни Джеймс Дио | Russia |

5 | Ritchie Blackmore | Russia |

1 | Иванов Иван Иванович | USA | 3

2 | Петров Петр Петрович | Canada | 4

3 | Иоганн Себастьян Бах | Japan | 5

(5 rows)

Выводы: Результат можно достичь многими способами, в своих реализациях необходимо ориентироваться на баланс достаточного и необходимого. IaaC, идемпотентность - это просто наше все. было бы уместным добавить в docker compose настройки, которые бы снимали вопросы прав доступа для postgres на директорию backup, возможно для бекапа неплохо было бы завести юзера. Крайне важно до старта реализации прорабатывать и продумывать все необходимые обстоятельства. Преподготовка с планом и архитектурными решениями будет не лишней работой. В лист to do: "проанализировать полученный опыт"

- Архитектор ПО решил проконсультироваться у вас, какой тип БД лучше выбрать для хранения определенных данных. Он вам предоставил следующие типы сущностей, которые нужно будет хранить в БД: 1.Электронные чеки в json виде; 2.Склады и автомобильные дороги для логистической компании; 3.Генеалогические деревья; 4.Кэш идентификаторов клиентов с ограниченным временем жизни для движка аутентификации; 5.Отношения клиент-покупка для интернет-магазина; Выберите подходящие типы СУБД для каждой сущности и объясните свой выбор.

Ответ:

- документо-ориентированная БД - чек - финансовый документ для хранения информации о совершенной сделке. Не уверен, однако, скорее всего регулятор РФ требует сохранение данного вида информации по форме и с доп. требованиями, для таких задач подойдет ДО БД.

- сетевые (паутинные) БД - склады и пути сообщения между ними, если положить это на географическую карту, напоминает паутину, достаточно посмотреть на навигатор, в том числе мне бы хотелось отразить данные и в графовой БД. Потому как ребра между складами и есть дороги, со своим оценочным весом - кол-во времени на преодоление расстояния. С универа помню, о том, что пропускные способности дорого рассчитывали в сове время по теории графов.

- иерархическая БД - один отец от которого пошел род.

- БД ключ-значение - нам важно быстрый доступ к данным, по конкретному указателю, ключ, все остальное не интересно, мне кажется самое то использовать БД ключ-значение.

- реляционные БД - в данном случае нам важно хранить данные о клиенте, о том, что покупал, какое кол-во, в какой период, в таком случае мы можем получать статистику и аналитику по людям, понимать. что они покупают чаще, обладая такой информацией, можем выдавать персональные предложения - стимулировать совершать покупки.

- Вы создали распределенное высоконагруженное приложение и хотите классифицировать его согласно CAP-теореме. Какой классификации по CAP-теореме соответствует ваша система, если (каждый пункт - это отдельная реализация вашей системы и для каждого пункта надо привести классификацию): 1.Данные записываются на все узлы с задержкой до часа (асинхронная запись); 2.При сетевых сбоях, система может разделиться на 2 раздельных кластера; 3.Система может не прислать корректный ответ или сбросить соединение; А согласно PACELC-теореме, как бы вы классифицировали данные реализации?

Ответ:

- CA | PC/EL

- PA | PA/EL

- PC | PA/EC

- Могут ли в одной системе сочетаться принципы BASE и ACID? Почему?

Ответ: На текущий момент распределенные системы состоят из множества сервисов, то есть одна система - может быть рассмотрена нами, как совокупность подсистем, в такой плоскости (абстракции) мы можем говорить, что одна БД должна быть построена в рамках принципа BASE, а вторая часть исключительно ACID. Таким образом, в общем, эти два принципа антиподы, но распределенные системы, как жизнь, очень сложны и многогранны, поэтому корректнее говорить о том, что мы знаем о принципах построения, для каждого куска системы, с учетом требований, мы будем опираться либо на принципы ACID, или на BASE.

- Вам дали задачу написать системное решение, основой которого бы послужили: фиксация некоторых значений с временем жизни; реакция на истечение таймаута; Вы слышали о key-value хранилище, которое имеет механизм Pub/Sub. Что это за система? Какие минусы выбора данной системы?

Ответ: Redis - БД с высокой производительностью, за счет хранения данных в памяти, это с одной стороны плюс и в то же время может быть расценен, как минус, хранение в памяти позволяет быстро получить доступ к данным, но есть риск потери данных, в том числе мы сильно ограничены в рамках памяти. По этой причине подобного рода БД хорошо зарекомендовали себя в рамках кеша, могут использоваться, как модуль большой системы и работать в паре с другими сервисами в рамках микросервисной архитектуры. Также, если рассматривать redis, как sub/pub систему, то БД не хранит у себя сообщения, отправляет потребителям и затем удаляет. В какой то степени, поэтому не приходится говорить о надежности и стабильности. Поэтому в каждом конкретном случае достоинства становятся минусами и наоборот. Redis - "как пуля резкий, вылетели сообщения и больше о них ни кто не вспоминает". Мне трудно говорить о плюсах и минусах, я ранее не работал с данной БД не могу более обширнее и правильнее дать ответ.

- Дайте письменые ответы на следующие вопросы: В чём отличие режимов работы сервисов в Docker Swarm кластере: replication и global? Какой алгоритм выбора лидера используется в Docker Swarm кластере? Что такое Overlay Network?

Ответ:

- В случае, когда указан mode global, то сервис запустится не всех нодах, в случае с replication - только на тех нодах, на которых мы указали в конфиге.

- Алгоритм RAFT - алгоритм построен на распределенном консенсусе, то есть в единицу времени, как минимум две ноды участвуют, отправляют заявку на лидерство, тот кто первый ответил, то становится лидером. Дальше в работе ноды между собой посылают запросы, чтобы определить доступен ли лидер и отвечает ли он до сих пор самый первый, в случае, когда лидер не ответил в заданное время идет пересогласование по тому же принципу. попытался дать пояснения своими словами

- Overlay Network - распределенная сеть кластера, которая позволяет общаться контейнерам между собой на разных нодах, возможно шифрование трафика. docker engine в рамках такой сети, сам занимается маршрутизацией.

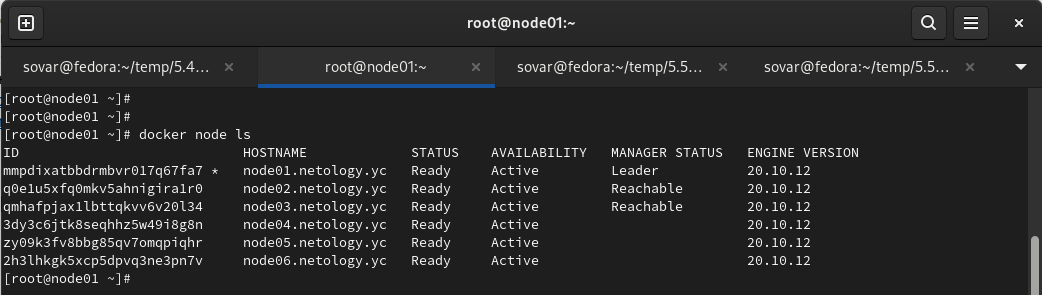

- Создать ваш первый Docker Swarm кластер в Яндекс.Облаке Для получения зачета, вам необходимо предоставить скриншот из терминала (консоли), с выводом команды:

docker node ls

Ответ:

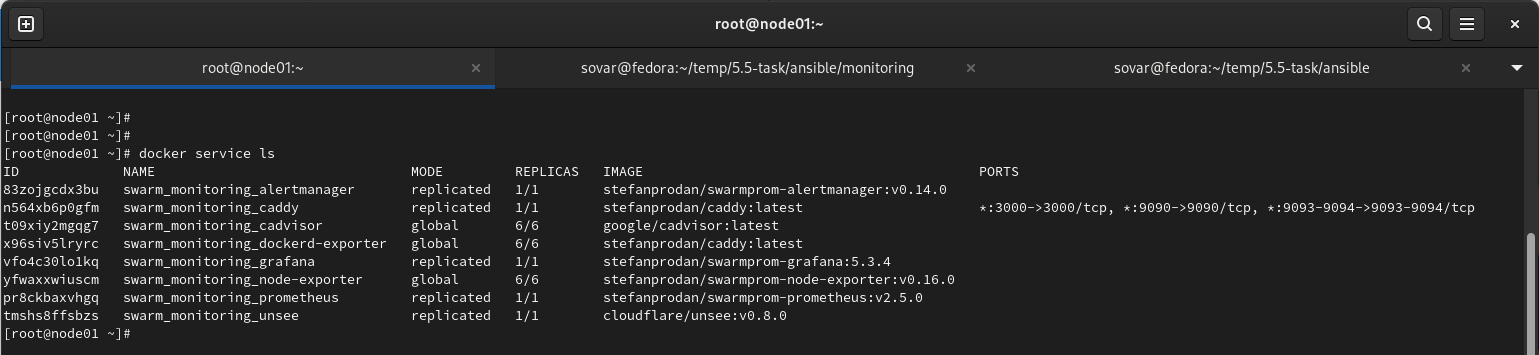

- Создать ваш первый, готовый к боевой эксплуатации кластер мониторинга, состоящий из стека микросервисов. Для получения зачета, вам необходимо предоставить скриншот из терминала (консоли), с выводом команды:

docker service ls

Ответ:

- Выполнить на лидере Docker Swarm кластера команду (указанную ниже) и дать письменное описание её функционала, что она делает и зачем она нужна: см.документацию: https://docs.docker.com/engine/swarm/swarm_manager_locking/

docker swarm update --autolock=true

Ответ: Логи по выбору лидера из менеджеров шифруются по умолчанию. Таким образом обеспечивается собственно безопасность. Трафик между нодами в том, числе шифруется по той же причине. Ключи шифрования и логов, и трафика, на момент рестарта Docker помещаются в память менеджеров. Вы становитесь владельцем заблокированных таким способом ключей и необходимо ручная разблокировка менеджеров, после того как ребут закончился. Разблокировка происходит тем ключом, который генерировался на момент блока.

[root@node01 ~]# docker swarm update --autolock=true

Swarm updated.

To unlock a swarm manager after it restarts, run the `docker swarm unlock`

command and provide the following key:

SWMKEY-1-K9aFG5dQ/rSVx0NC43spQc5xORF+/jDrpRSQsREylMc

Please remember to store this key in a password manager, since without it you

will not be able to restart the manager.

[root@node01 ~]# docker node ls

Error response from daemon: Swarm is encrypted and needs to be unlocked before it can be used. Please use "docker swarm unlock" to unlock it.

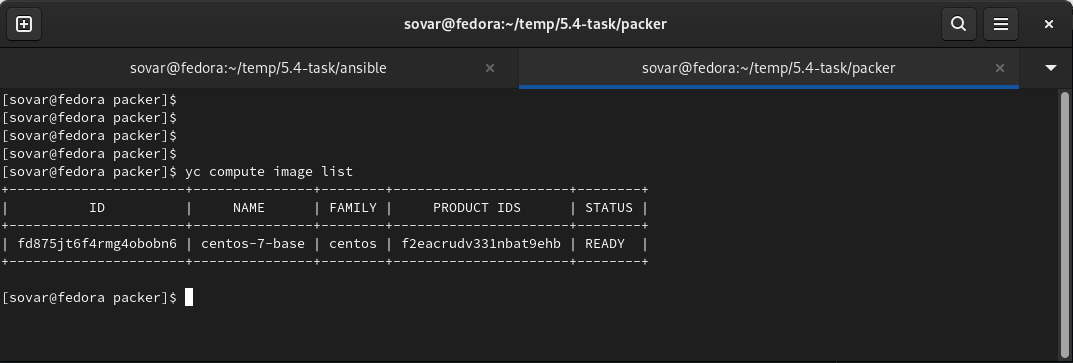

- Создать собственный образ операционной системы с помощью Packer. Для получения зачета, вам необходимо предоставить: Скриншот страницы, как на слайде из презентации (слайд 37)

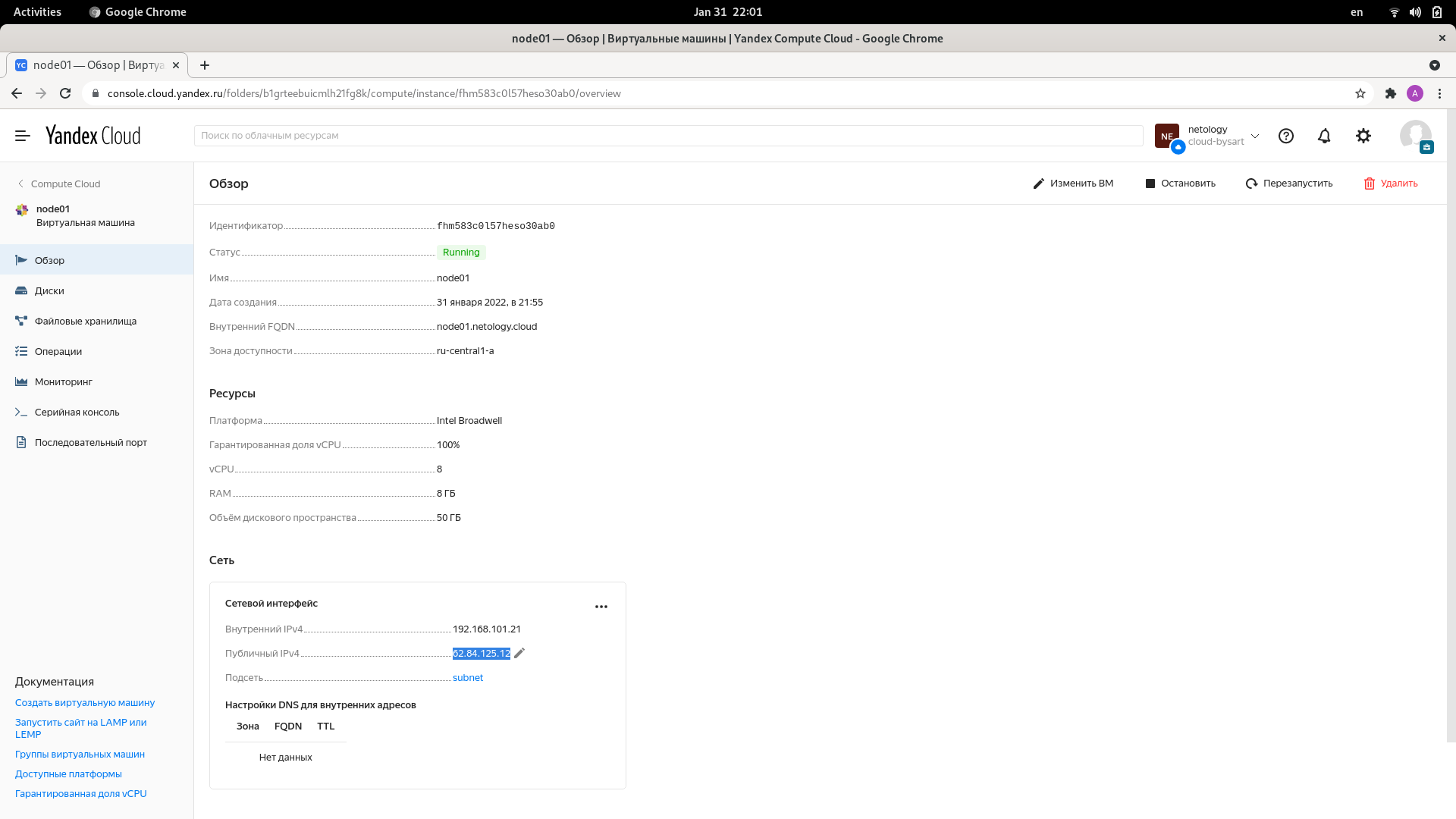

- Создать вашу первую виртуальную машину в Яндекс.Облаке. Для получения зачета, вам необходимо предоставить: Скриншот страницы свойств созданной ВМ

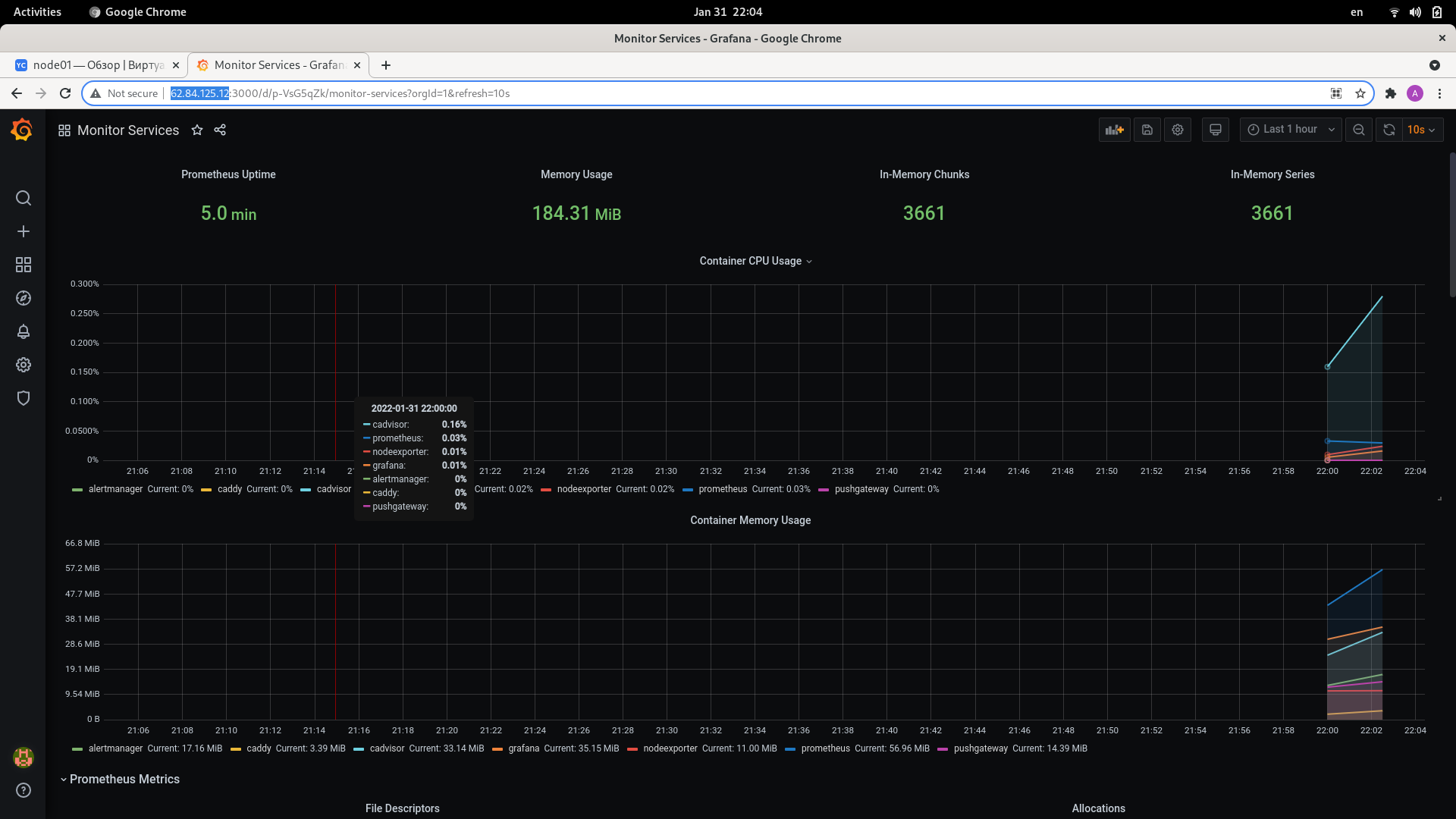

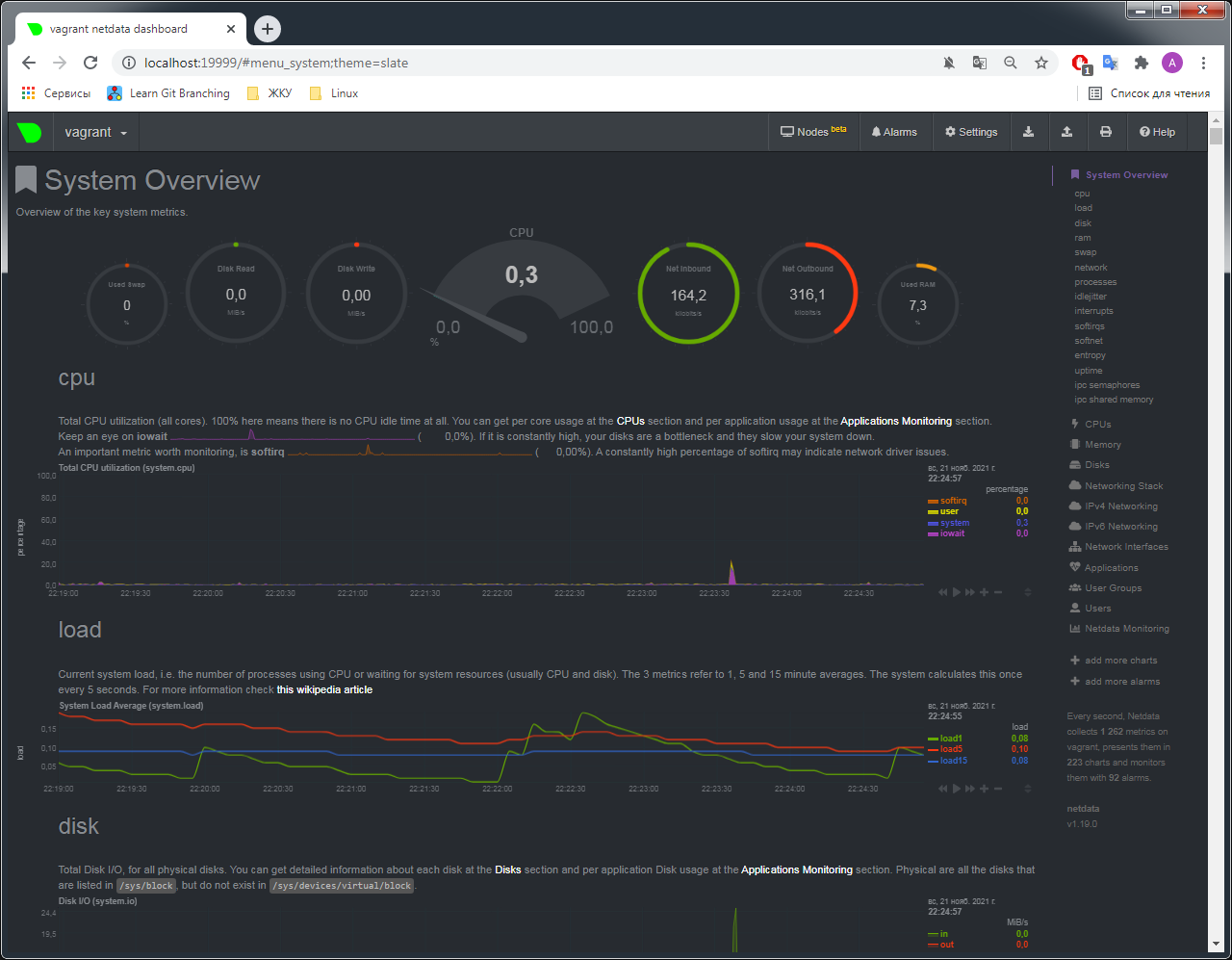

- Создать ваш первый готовый к боевой эксплуатации компонент мониторинга, состоящий из стека микросервисов. Для получения зачета, вам необходимо предоставить: Скриншот работающего веб-интерфейса Grafana с текущими метриками

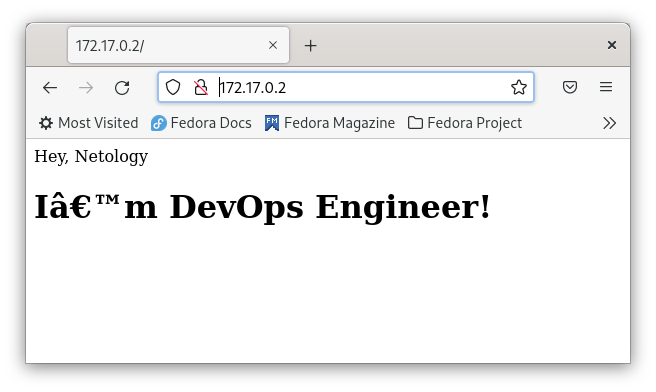

- Сценарий выполнения задачи: создайте свой репозиторий на https://hub.docker.com; выберете любой образ, который содержит веб-сервер Nginx; создайте свой fork образа; реализуйте функциональность: запуск веб-сервера в фоне с индекс-страницей, содержащей HTML-код ниже. Опубликуйте созданный форк в своем репозитории и предоставьте ответ в виде ссылки на https://hub.docker.com/username_repo.

<html>

<head>

Hey, Netology

</head>

<body>

<h1>I’m DevOps Engineer!</h1>

</body>

</html>

Ответ: https://hub.docker.com/r/bysart/alpine-ngnix

- Посмотрите на сценарий ниже и ответьте на вопрос: "Подходит ли в этом сценарии использование Docker контейнеров или лучше подойдет виртуальная машина, физическая машина? Может быть возможны разные варианты?" Детально опишите и обоснуйте свой выбор.

Ответ:

- Высоконагруженное монолитное java веб-приложение - монолитное веб-приложение предполагает сборку всего в одном месте (frontend, backend, UI). Так как монолитное веб-приложение высоконагруженное, то стоит размещать или на физической среде, или можно использовать пара виртуализацию, если накладными расходами можно пренебречь, однако контейнеризация не подойдет, так предполагается выполнение одного сервиса в рамках контейнера.

- Nodejs веб-приложение - контейнеризация подойдет для решения задачи, по сути node.js - это условно говоря environment для javascript для построения логики работы веб-приложения, является его частью, модулем, хорошо укладывается в микро сервисную архитектуру.

- Мобильное приложение c версиями для Android и iOS - предполагается, что приложение имеет своего потребителя, а значит необходим UI для взаимодействия с пользователем. По моему мнению, корректнее всего использовать виртуализацию с реализацией виртуальной машины.

- Шина данных на базе Apache Kafka - если можно так выразится, то это сервис по трансляции данных из одного формата данных одного приложения в другое. По моему мнению хорошо применить контейнеризацию, так как отсутствуют накладные расходы на виртуализацию, достигается простота масштабирования и управления. В данном случае необходимо организация отказоустойчивости.

- Elasticsearch кластер для реализации логирования продуктивного веб-приложения - три ноды elasticsearch, два logstash и две ноды kibana - для упомянутых продуктов есть контейнеры на docker hub. Из-за простоты управления и сборки контейнеров, мне кажется необходимо распихать продукты по контейнерам и на основании контейнеров собрать кластер стека ELK. В силу прозрачности реализации, в том числе возможности реализации подходов IaaC, контейнеризация в данном случае помогает закрыть вопросы по менеджменту и что очень важно получить регулярный предсказуемый результат.

- Мониторинг-стек на базе Prometheus и Grafana - по моему мнению также как и пример с ELK, скорее всего с течением времени будут вноситься изменения в систему мониторинга и не один раз, будут добавляется метрики, так как точки мониторинга будут меняться - добавляться новый функционал, было бы не плохо применить IaaC в том числе и в этом случае - мониторинг как код, контейнеризация помогает этого добиться.

- MongoDB, как основное хранилище данных для java-приложения - либо виртуализация, либо контейнеризация, все зависит от реализации архитектуры приложения. Сложно дать вразумительный ответ - никогда не работал с данной БД, затрудняюсь обосновать выбор. Чувствую, что так будет правильно.

- Gitlab сервер для реализации CI/CD процессов и приватный (закрытый) Docker Registry - отдельный физический сервер или виртуализация, если сервер есть в наличии использовал бы его, но только необходимо оценить доступные объемы хранения данных, в том числе подумать о техническом сопровождении: просчитать затраты на поддержку железа и ЗИП. Если по совокупности поставленных задач будет понятно, что через осязаемое недалекое время мы выйдем за пределы мощностей физ. сервера, то выбрал бы, на перспективу, виртуализацию, однако возможны первичные затраты на доп. железо, но все зависит от проекта. Требуется пред проектная аналитика.

- Запустите первый контейнер из образа centos c любым тэгом в фоновом режиме, подключив папку /data из текущей рабочей директории на хостовой машине в /data контейнера; Запустите второй контейнер из образа debian в фоновом режиме, подключив папку /data из текущей рабочей директории на хостовой машине в /data контейнера; Подключитесь к первому контейнеру с помощью docker exec и создайте текстовый файл любого содержания в /data; Добавьте еще один файл в папку /data на хостовой машине; Подключитесь во второй контейнер и отобразите листинг и содержание файлов в /data контейнера.

Ответ:

Подымаем первый контейнер, так как в контейнере определена команда CMD bash, то при запуске выполняется запуск bash и контейнер уходит в статус stop, поэтому применяю sleep infinity, можно было использовать ключ -t. При помощи exec, на уже запущеном контейнере вызываю bash, через ls показываю примапленный volume.

[sovar@fedora docker]$ docker run -d -v /data:/data centos sleep infinity

867d3a86aa2a60f3806d1d5d25c0957676cd8942d1fea34263584466491eb670

[sovar@fedora docker]$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

867d3a86aa2a centos "sleep infinity" 4 seconds ago Up 4 seconds bold_tu

[sovar@fedora docker]$ docker exec -it 867d3a86aa2a bash

[root@867d3a86aa2a /]#

[root@867d3a86aa2a /]# ls -lah /

total 60K

drwxr-xr-x 1 root root 4.0K Jan 24 20:21 .

drwxr-xr-x 1 root root 4.0K Jan 24 20:21 ..

-rwxr-xr-x 1 root root 0 Jan 24 20:21 .dockerenv

lrwxrwxrwx 1 root root 7 Nov 3 2020 bin -> usr/bin

drwxr-xr-x 2 root root 4.0K Jan 24 19:12 data

drwxr-xr-x 5 root root 340 Jan 24 20:21 dev

drwxr-xr-x 1 root root 4.0K Jan 24 20:21 etc

drwxr-xr-x 2 root root 4.0K Nov 3 2020 home

lrwxrwxrwx 1 root root 7 Nov 3 2020 lib -> usr/lib

lrwxrwxrwx 1 root root 9 Nov 3 2020 lib64 -> usr/lib64

drwx------ 2 root root 4.0K Sep 15 14:17 lost+found

drwxr-xr-x 2 root root 4.0K Nov 3 2020 media

drwxr-xr-x 2 root root 4.0K Nov 3 2020 mnt

drwxr-xr-x 2 root root 4.0K Nov 3 2020 opt

dr-xr-xr-x 363 root root 0 Jan 24 20:21 proc

dr-xr-x--- 2 root root 4.0K Sep 15 14:17 root

drwxr-xr-x 11 root root 4.0K Sep 15 14:17 run

lrwxrwxrwx 1 root root 8 Nov 3 2020 sbin -> usr/sbin

drwxr-xr-x 2 root root 4.0K Nov 3 2020 srv

dr-xr-xr-x 13 root root 0 Jan 24 20:21 sys

drwxrwxrwt 7 root root 4.0K Sep 15 14:17 tmp

drwxr-xr-x 12 root root 4.0K Sep 15 14:17 usr

drwxr-xr-x 20 root root 4.0K Sep 15 14:17 var

Аналогичные действия для контейнера с debian, исключение составляет порядок ключей, эксперимент - последовательность ключей не играет роли, заметка в дневник, уточнить у экспертов.

[sovar@fedora docker]$ docker run -v /data:/data -d debian sleep infinity

4561ae7cd80e4a6b87c042a9d4d020a37ab712662aae697af45404bf9a61bda8

[sovar@fedora docker]$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

4561ae7cd80e debian "sleep infinity" 5 seconds ago Up 4 seconds friendly_maxwell

867d3a86aa2a centos "sleep infinity" 3 minutes ago Up 3 minutes bold_tu

root@4561ae7cd80e:/# ls -lah /

total 76K

drwxr-xr-x 1 root root 4.0K Jan 24 20:25 .

drwxr-xr-x 1 root root 4.0K Jan 24 20:25 ..

-rwxr-xr-x 1 root root 0 Jan 24 20:25 .dockerenv

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 bin

drwxr-xr-x 2 root root 4.0K Dec 11 17:25 boot

drwxr-xr-x 2 root root 4.0K Jan 24 19:12 data

drwxr-xr-x 5 root root 340 Jan 24 20:25 dev

drwxr-xr-x 1 root root 4.0K Jan 24 20:25 etc

drwxr-xr-x 2 root root 4.0K Dec 11 17:25 home

drwxr-xr-x 8 root root 4.0K Dec 20 00:00 lib

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 lib64

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 media

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 mnt

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 opt

dr-xr-xr-x 307 root root 0 Jan 24 20:25 proc

drwx------ 2 root root 4.0K Dec 20 00:00 root

drwxr-xr-x 3 root root 4.0K Dec 20 00:00 run

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 sbin

drwxr-xr-x 2 root root 4.0K Dec 20 00:00 srv

dr-xr-xr-x 13 root root 0 Jan 24 20:25 sys

drwxrwxrwt 2 root root 4.0K Dec 20 00:00 tmp

drwxr-xr-x 11 root root 4.0K Dec 20 00:00 usr

drwxr-xr-x 11 root root 4.0K Dec 20 00:00 var

С контейнера под centos создаю в директории файл

[root@867d3a86aa2a /]# echo '' > /data/centos-file-1

[root@867d3a86aa2a /]# ls /data

centos-file-1

Созадю файл с хоста

[sovar@fedora docker]$ echo '' > /data/fedora-host-file-2

[sovar@fedora docker]$ ls /data

centos-file-1 fedora-host-file-2

Листинг файлов в директории из контейнера debian

root@4561ae7cd80e:/# ls -lah /data

total 16K

drwxr-xrwx 2 root root 4.0K Jan 24 20:38 .

drwxr-xr-x 1 root root 4.0K Jan 24 20:25 ..

-rw-r--r-- 1 root root 1 Jan 24 20:29 centos-file-1

-rw-rw-r-- 1 1000 1000 1 Jan 24 20:38 fedora-host-file-2

- Воспроизвести практическую часть лекции самостоятельно. Соберите Docker образ с Ansible, загрузите на Docker Hub и пришлите ссылку вместе с остальными ответами к задачам.

Ответ: https://hub.docker.com/r/bysart/ansible

- Опишите своими словами основные преимущества применения на практике IaaC паттернов. Какой из принципов IaaC является основополагающим?

Ответ: IaaC - качественно новый подход к ведению дел в Ops. Это одномоментно и техническая реализация поставленной задачи, и документирование действий, настроек. Кодинг для описания инфраструктуры приводит нас к тому, что не плохо было бы разбираться в программировании, и с точки зрения получения финального продукта - программы (в рамках Ops - код инфраструктуры), и сточки зрения - а как писать код, как его структурировать, как применять эффективные методы описания логики. В данном случае работает правило: не изобретай велосипед, все что тебе нужно, уже было сделано до тебя, тебе остается знать опыт разработки IaaC, понимать когда и что использовать и осознанно, с ответственностью, применять то или иное в работе, да, всегда, остается место для творчества и реализации, но применение паттернов IaaC опоравдано оптимизационно и функционально. Вообще, основополагающем принципом, в рамках IaaC, является обеспеченеи идемпотентности. По моему мнению, именно паттерны, которые формировались в рамка развития той или технологии - квинтэссенция максимально эффективного опыта ИТ специалистов и обеспечивает стабильность получения предсказуемого постоянного результата.

- Чем Ansible выгодно отличается от других систем управление конфигурациями? Какой, на ваш взгляд, метод работы систем конфигурации более надёжный push или pull?

Ответ: Ansible написан на Python, использует метод push, что не требует установки ни демонов, ни агентов, в случае с pull методом такие агенты нужны, что потенциально может быть еще одной точкой сбоя. Использует SSH без необходимости дополнительно докручивать PKI. По совокупности, все это делает Ansible простым и эффективным.

- Установить на личный компьютер: VirtualBox, Vagrant, Ansible. Приложить вывод команд установленных версий каждой из программ, оформленный в markdown.

Ответ:

[sovar@fedora ~]$ vboxmanage --version

6.1.32r149290

[sovar@fedora ~]$ vagrant -v

Vagrant 2.2.19

[sovar@fedora ~]$ ansible --version

ansible 2.9.27

config file = /etc/ansible/ansible.cfg

configured module search path = ['/home/sovar/.ansible/plugins/modules', '/usr/share/ansible/plugins/modules']

ansible python module location = /usr/lib/python3.10/site-packages/ansible

executable location = /usr/bin/ansible

python version = 3.10.0 (default, Oct 4 2021, 00:00:00) [GCC 11.2.1 20210728 (Red Hat 11.2.1-1)]

- Воспроизвести практическую часть лекции самостоятельно. Создать виртуальную машину. Зайти внутрь ВМ, убедиться, что Docker установлен с помощью команды

docker ps

Ответ:

[sovar@fedora vagrant]$ vagrant ssh

Welcome to Ubuntu 20.04.3 LTS (GNU/Linux 5.4.0-91-generic x86_64)

* Documentation: https://help.ubuntu.com

* Management: https://landscape.canonical.com

* Support: https://ubuntu.com/advantage

System information disabled due to load higher than 1.0

This system is built by the Bento project by Chef Software

More information can be found at https://github.com/chef/bento

Last login: Thu Jan 20 08:02:10 2022 from 10.0.2.2

vagrant@server1:~$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

Задание - 5.1. Введение в виртуализацию. Типы и функции гипервизоров. Обзор рынка вендоров и областей применения.

- Опишите кратко, как вы поняли: в чем основное отличие полной (аппаратной) виртуализации, паравиртуализации и виртуализации на основе ОС.

Ответ:

- Аппаратная (полная) виртуализация - полная эмуляция процессора, памяти и необходимых перифирийных устройств, в силу чего большие накладные расходы, что может выливаться в уменьшение производительности. Однако данные проблемы отчасти закрываются динамической трансляцией и реализацией аппаратной виртуализации Inet-VT, AMD-V.

- Паравиртулизация - в том числе эмуляция работы устройств, однако гостевая ОС знает о наличии гипервизора, а выполнения привилегированных инструкций происходит через гипервизор, поэтому происходит серьезное изменение ядра гостевой ОС. В силу данной особенности подходит для ОС с открытым кодом, издержки меньше, производительность не особо страдает.

- Виртуализация на основе ОС - еще называется контейнеризация, при помощи механизмов namespace и cgroups, можно выделять новые пространства имен, ограничивать ресурсы хостовой машины, тем самым создавать изолированные контейнеры, в которых будут выполняться процессы. Ядро гостевой ОС не может отличаться от ядра хостовой ОС.

- Выберите один из вариантов использования организации физических серверов, в зависимости от условий использования. Опишите, почему вы выбрали к каждому целевому использованию такую организацию.

Ответ:

- Высоконагруженная база данных, чувствительная к отказу: виртуализация уровня ОС - так БД можно рассматривать, как приложение (сервис), по моему мнению необходимо запаковать это в контейнер, создать несколько таких контейнеров, тем самым получить отказоустойчивый кластер, управление контейнером сводится к управлению процессом - быстро и без накладных расходов.

- Различные web-приложения: виртуализация уровня ОС - если приложения могут и должны работать на том же ядре, что и ядро хостовой ОС, если, все же, в связи с этим есть ограничения, тогда паравиртуализация. Так как это web-приложения, то это значит, что будет достаточно много обращений к ним, как к сервису, поэтому нам в первую очередь необходимо обеспечить хорошую производительность и снизить накладные расходы. Данный способ так же позволяет утилизировать по максимуму хостовые ресурсы, управление контейнерами позволит нам упростить в принципе управление стеком веб приложений.

- Windows системы для использования бухгалтерским отделом: паравиртуализация - системы для бухов - по большей части, не требуют от нас супер производительности и кол-во обращение более менее прогнозируемое и поддается подсчету. Виртуализация более масштабируемое решение, скорее всего можно сформировать единую точку управления.

- Системы, выполняющие высокопроизводительные расчеты на GPU: физические сервера - так как потребуется установка мощных графических процессоров для обработки данных. Хотя, графические интерфейсы в том, числе виртуализируются, однако предполагаю, что все таки физические решения для графических вычислений более производительны.

П.С. Хотел бы отметить, что при выборе того или иного решения, необходимо проводить более глубокую аналитику - что за приложения будут выполняться, какие задачи будут решать новые сервисы, в том числе необходимо учитывать и анализировать не только страт проекта, но и делать выбор с учетом требования по отказоустойчивости и масштабируемости. Возможно было бы уместно для типовых задач проанализировать ИТ опыт, так сказать рассмотреть best practice. А также не мало важно учитывать бюджет проекта.

- Выберите подходящую систему управления виртуализацией для предложенного сценария. Детально опишите ваш выбор.

Ответ:

Сценарий 1: VMWare. В рамках продуктов виртуализации и управления, решения от VMWare являются наиболее сбалансированными, имеют достаточно обширный функционал, который позволит закрыть вопросы по сопровождению и администрированию среды на 100 VM Windows, Linux.

Сценарий 2: KVM. Решение на базе KVM позволит управлять гостевыми ОС, как Windows, так и Linux, без особых потерь в производительности, что обеспечивает решение поставленной задачи. Проект развивающийся, это несет в себе риски, но ими можно пренебречь, так как производительность нас интересует в первую очередь.

Сценарий 3: XEN PV. Решение позволит поднять инфраструктуру на базе Windows OS, является open source проектом, обеспечит высокую производительность.

Сценарий 4: Virtual Box совместно с Vagrant. Для создания окружения для тестирования подойдет open source решение Virtual Box, с помощью Vagrant можно добиться автоматизации сборки такого окружения, при помощи Vagrantfile отдавать данное окружения всем, кто заинтересован, это позволит точно быть уверенным, что среда у всех единая.

- Опишите возможные проблемы и недостатки гетерогенной среды виртуализации (использования нескольких систем управления виртуализацией одновременно) и что необходимо сделать для минимизации этих рисков и проблем. Если бы у вас был выбор, то создавали бы вы гетерогенную среду или нет? Мотивируйте ваш ответ примерами.

Ответ: выбор среды виртуализации делается на основании плотного пред проектного анализа, рассматривается детальное описание требований к будущей реализации, мое мнение такое, если мы можем на проекте избежать солянки из продуктов и решений, то ни к чему вводить два или более решений по управлению виртуальной средой. Однако, если же этого не избежать, специфика поставленной задачи, такова, что гетерогенная среда будет оправдана, и с точки зрения затрат, и с точки зрения управления, то тогда необходимо внедрять такое решение, но учитывать особенности - две или более точки управления виртуальными средами, это в свою очередь тянет за собой и необходимость привлекать более скиловый персонал, объем выполняемых работ увеличиться, потребуется разработка автоматизационных решений под обе среды, возможно это наложит существенные ограничения на выбор стека технологий по мониторингу, логированию и бекапированию или наоборот увеличит кол-во продуктов. В том числе значительно усложняется вопрос по реализации прозрачного процесса управления изменениями, то есть изменения, которые будут доставляться в одну среду, могут отличаться в смысле способа и метода доставки в другой среде. Для минимизации влияния всех описаных факторов, техническое решение должно быть проработано хорошо, задача отладки процессов управления сервисов в гетерогенной среде становиться крайне важна, в том числе для страховки необходимо будет прорабатывать детальный план DRP - disaster recovery plan. По моему личному мнению, гетерогенная среда виртуализации - требует определенного баланса между необходмиым и достаточным, необходимо отдавать себе отчет в том, какой стек технологий будет использоваться, и точно не стоит боятся, необходимо ответственно подходить к архитектуре решения.

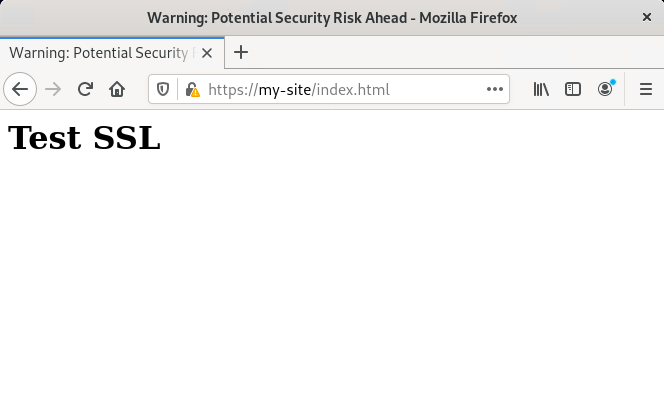

Задание:

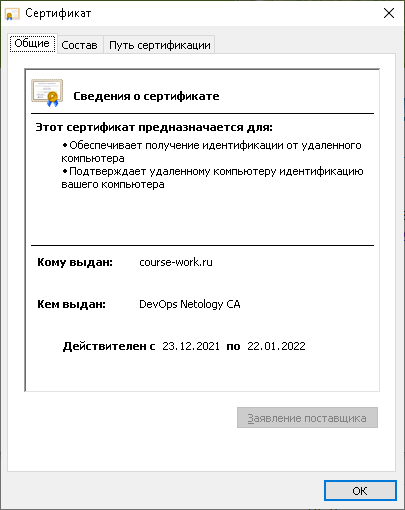

Результатом курсовой работы должны быть снимки экрана или текст:

- Процесс установки и настройки ufw

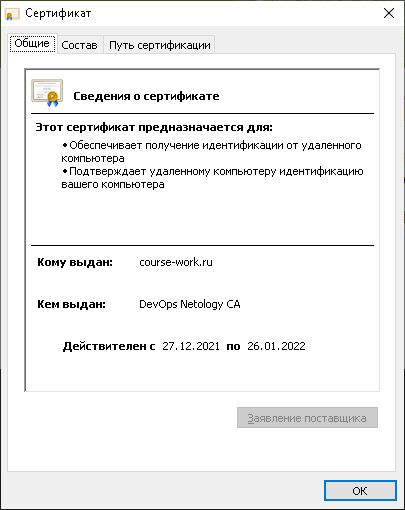

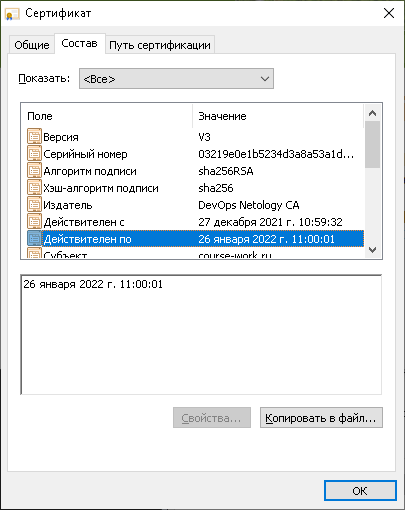

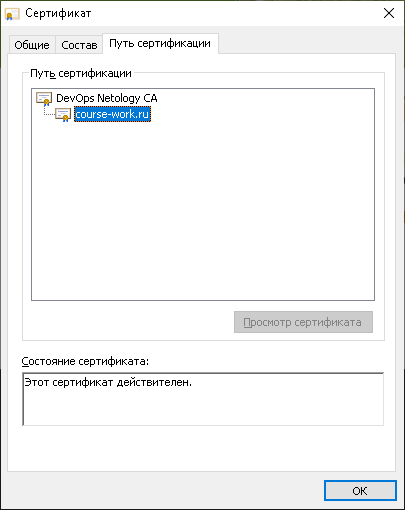

- Процесс установки и выпуска сертификата с помощью hashicorp vault

- Процесс установки и настройки сервера nginx

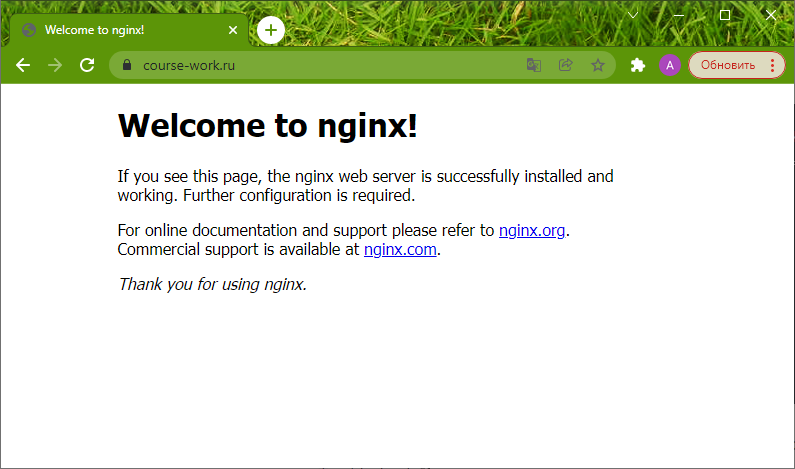

- Страница сервера nginx в браузере хоста не содержит предупреждений

- Скрипт генерации нового сертификата работает (сертификат сервера ngnix должен быть "зеленым")

- Crontab работает (выберите число и время так, чтобы показать что crontab запускается и делает что надо)

Решение:

- Процесс установки и настройки ufw

sudo apt install ufw

sudo ufw default deny incoming

Default incoming policy changed to 'deny'

(be sure to update your rules accordingly)

sudo ufw default allow outgoing

Default outgoing policy changed to 'allow'

(be sure to update your rules accordingly)

sudo ufw enable

Command may disrupt existing ssh connections. Proceed with operation (y|n)? y

Firewall is active and enabled on system startup

sudo ufw allow 22

sudo ufw allow 443

sudo ufw logging on medium

Logging enabled

sudo ufw status verbose

[sudo] password for sovar:

Status: active

Logging: on (low)

Default: deny (incoming), allow (outgoing), disabled (routed)

New profiles: skip

To Action From

-- ------ ----

22 ALLOW IN Anywhere

443 ALLOW IN Anywhere

22 (v6) ALLOW IN Anywhere (v6)

443 (v6) ALLOW IN Anywhere (v6)

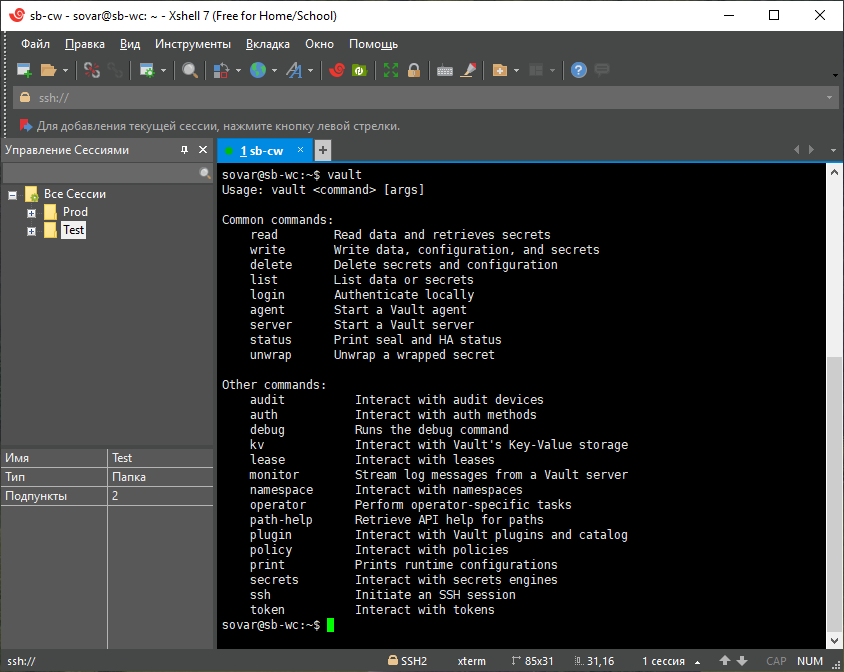

- Процесс установки и выпуска сертификата с помощью hashicorp vault

curl -fsSL https://apt.releases.hashicorp.com/gpg | sudo apt-key add -

Warning: apt-key is deprecated. Manage keyring files in trusted.gpg.d instead (see apt-key(8)).

OK

sudo apt-add-repository "deb [arch=amd64] https://apt.releases.hashicorp.com $(lsb_release -cs) main"

sudo apt-get update ; sudo apt-get install vault

vault server -dev -dev-root-token-id root

export VAULT_ADDR=http://127.0.0.1:8200

export VAULT_TOKEN=root

vault secrets enable pki

vault secrets tune -max-lease-ttl=87600h pki