- 🔥 服务器基础环境安装及常用工具

- 🐎 大模型调用总结

- 大模型原理介绍

- 🚅 大模型训练

- 🍄检索增强生成(RAG)

- 🚀 Agent

- ♻️ AI图像生成

- 🏡 AI语音合成

- 🎵 AI音乐合成

- 📐 Suno

- 📞 我用AI技术做了一个虚拟女友

- 💬 AI技术应用交流群

- 👥 微信公众号

采用语言python

| 大模型 | 厂商名称 | API调用文档 | 支持模型(闭源) | 依赖下载 |

|---|---|---|---|---|

| chatglm | 智谱 | 链接 | GLM-4、GLM-4V、GLM-3-Turbo | pip install zhipuai |

| 星火大模型 | 科大讯飞 | 链接 | V1.5、V2.0、V3.0和V3.5四个版本 | pip install --upgrade spark_ai_python |

| 通义千问 | 阿里 | 链接 | qwen-turbo、qwen-plus、qwen-max等 | pip install dashscope |

| 文心一言 | 百度 | 链接 | ERNIE-4.0、ERNIE-3.5、ERNIE-Lite等 | pip install qianfan |

| kimi | 月之暗面 | 链接 | moonshot-v1-8k、moonshot-v1-32k、moonshot-v1-128k | pip install openai |

| chatgpt | OpenAI | 链接 | gpt4、gpt3.5 | pip install openai |

- 千亿级开源大模型Qwen1.5-110B-Chat部署实测

- 目前有什么可以本地部署的大模型推荐?

- 为什么vllm消耗显存那么大?

- 大模型本地部署这么麻烦,为什么不直接调用API?

- vllm

- 8bit量化、4bit量化技术原理介绍

- 一文讲明白初学者怎么入门大语言模型(LLM)?

- 从矩阵运算角度理解反向传播

- 图解Transformer中的Attention机制

- llama3整体架构图介绍

- llama3原始权重与HuggingFace权重的区别

- llama3归一化方法RMSNorm实现

- llama3分组查询注意力(Grouped Query Attention,GQA)实现

- llama3 掩码注意力机制(Masked Grouped Query Attention)实现

- llama3前馈网络SwiGLU实现

- llama3整体推理实现

- 一文带你了解预训练、指令微调和人类反馈强化学习

- 初学者如何快速入门大模型微调

- 介绍部分微调中的Prompt-Tuning

- 从原理到实战讲明白大模型微调方法LoRA

- 如何从零开始训练一个llm模型?

| 项目 | 教程 | 代码 |

|---|---|---|

| 如何从零开始训练一个llm模型? | https://www.zhihu.com/question/641255219/answer/3625159394 | 配套代码 |

| 项目 | 教程 | 代码 |

|---|---|---|

| 不依赖微调框架,从0实现LoRA微调 | 配套代码 |

-

只需三个脚本,单机多卡微调BaiChuan2-13B并发布服务

-

只需三个脚本,多机多卡微调BaiChuan2-13B并发布服务

-

只需三个脚本,使用vllm部署BaiChuan2-13B

| 项目 | 微调方式 | 教程 | 视频教程 | 相关依赖 |

|---|---|---|---|---|

| 微调大模型实现情感预测 | Lora | 我用LLaMA-Factory微调大模型来实现商品评论情感分析,准确率高达91.70% | 视频链接 | 配套代码 |

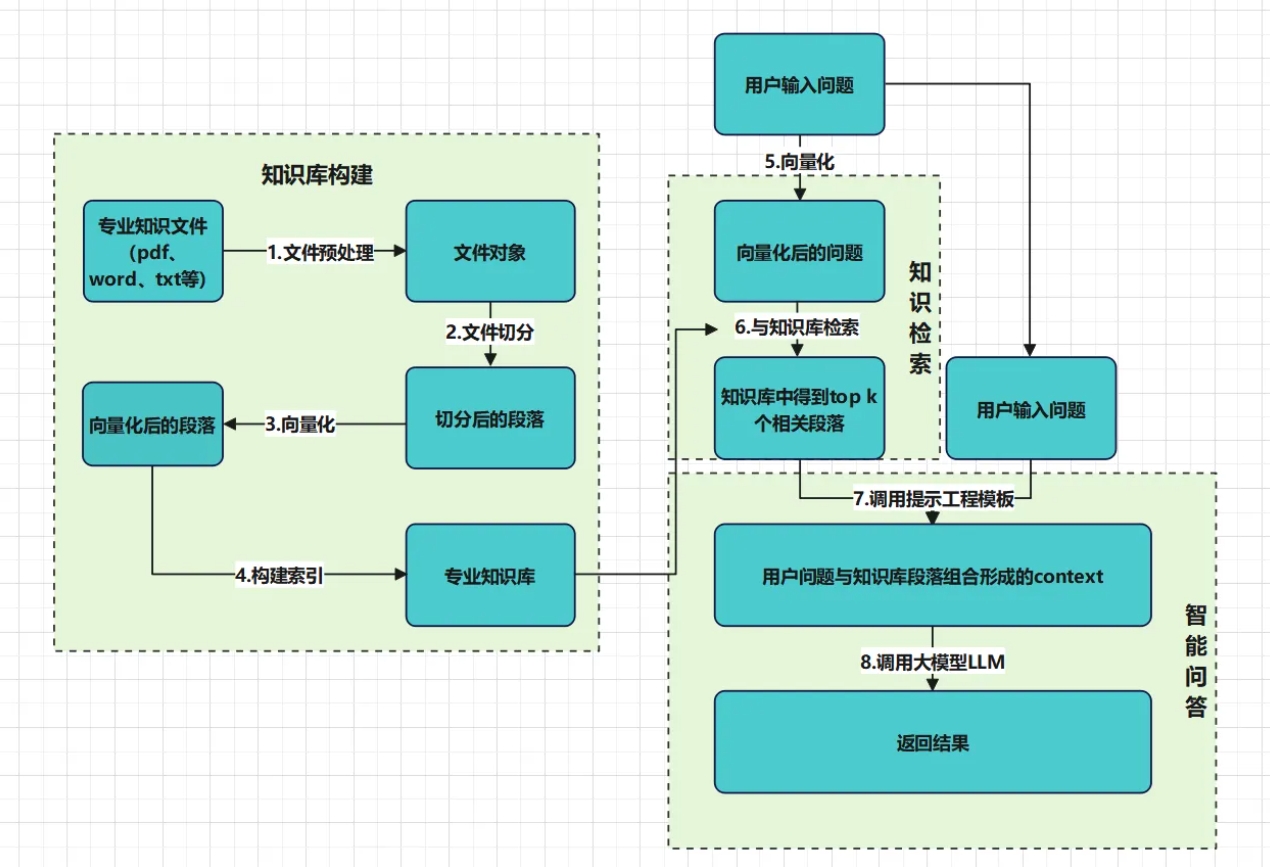

RAG整体技术路线可分为3大块8个小点见下图,其中包含知识库构建、知识检索和知识问答。其中核心在于知识库构建

详细介绍见:

-

常规rag存在的问题:

一是如何应对复杂多变的数据,这些数据包含各种格式,更复杂的还包含各类图表、pdf、excel循环嵌套等。如果在没有理解这些数据的基础之上直接简单粗暴地做RAG ,就会导致知识检索失败,从而导致rag失败。

二是如何查询和排序。假设知识库中有10W条数据,你的问题需要和10W数据匹配检索并且找到最适合的几条,无疑于大海捞针。

-

ragflow是如何改善这些问题的?

一是基于深度文档理解deepdoc模块,能够从各类复杂格式的非结构化数据中提取真知灼见。

二是引入多路召回和重排序,才能保证数据检索召回的准确度

项目地址:ragflow

| 向量数据库 | 数据处理 | 语义召回 | 教程 | 视频地址 |

|---|---|---|---|---|

| Elasticsearch | deepdoc模块 | 多路召回、融合重排序 | 我用ragflow做了一款初中历史辅导助手 | https://www.bilibili.com/video/BV1yw4m1y7yA/ |

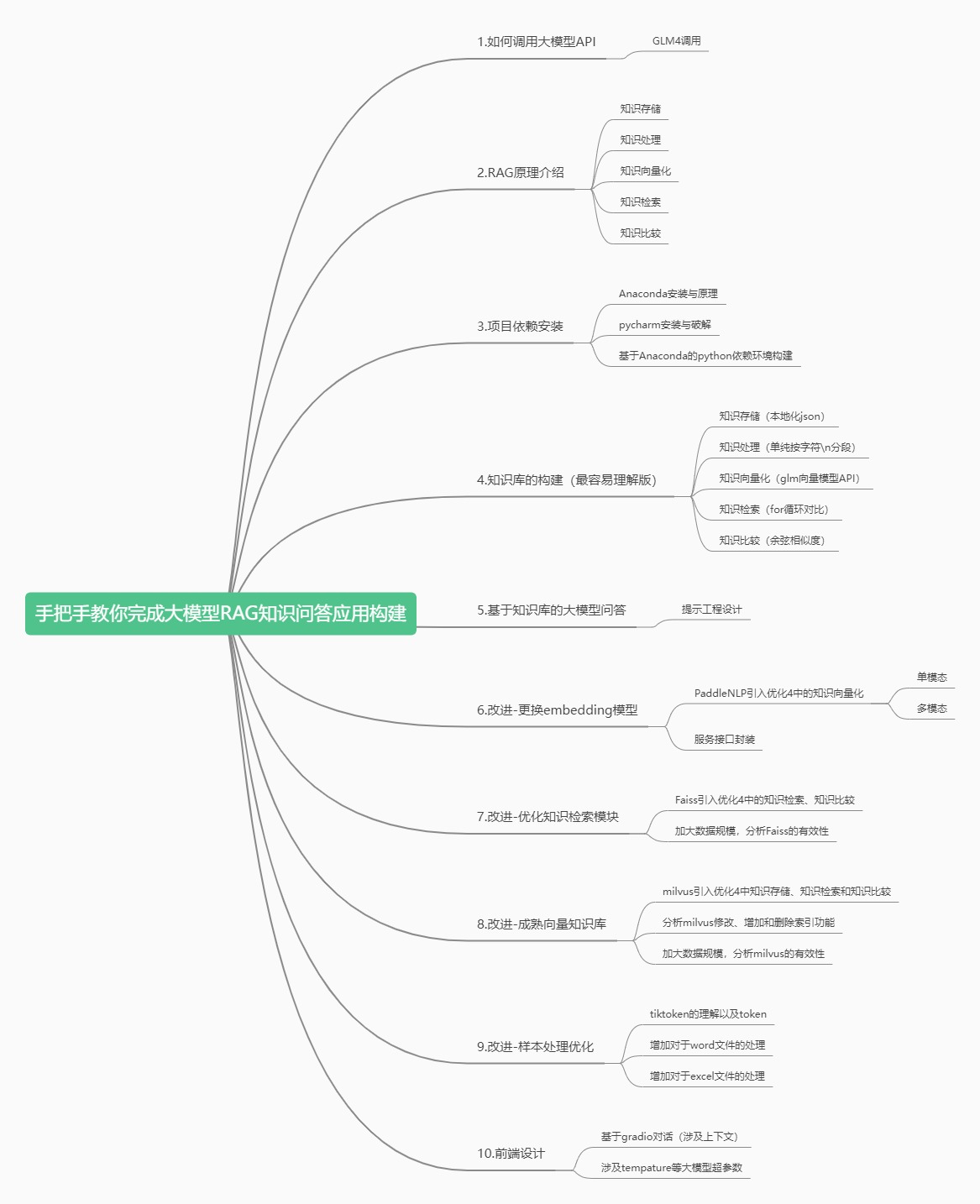

github上的代码封装程度高,不利于小白学习入门。

常规的大模型RAG框架有langchain等,但是langchain等框架源码理解困难,debug源码上手难度大。

因此,我写了一个人人都能看懂、人人都能修改的大模型RAG框架代码。

整体项目结构如下图所示:手把手教你大模型RAG框架架构。

代码与教程如下:

| 章节 | 教程 | 代码 |

|---|---|---|

| 01.如何调用大模型API | 手把手教你完成大模型RAG知识问答应用构建-01.如何调用大模型API | 配套代码 |

| 02.RAG介绍 | 手把手教你完成大模型RAG知识问答应用构建-02.RAG介绍 | / |

| 03.部署环境准备 | 手把手教你完成大模型RAG知识问答应用构建-03.项目依赖环境准备 | / |

| 04.知识库构建 | 手把手教你完成大模型RAG知识问答应用构建-04.知识库构建 | / |

| 05.基于知识库的大模型问答 | 手把手教你完成大模型RAG知识问答应用构建-05.基于知识库的大模型问答 | 配套代码 |

| 06.改进-用自己的embedding模型 | 手把手教你完成大模型RAG知识问答应用构建-06.用自己的embedding模型 | 配套代码 |

| 07.封装镜像对外提供服务 | 更新中 | 更新中 |

| 08.改进-基于Faiss的大模型知识索引构建 | 更新中 | 配套代码 |

| 09.改进-使用向量数据库 | 更新中 | 配套代码 |

| 10.前端构建 | 更新中 | 更新中 |

| 项目 | 教程 | 代码 |

|---|---|---|

| 手写Qwen2大模型function call | https://zhuanlan.zhihu.com/p/730995043 | 配套代码 |

图片挂掉,可加微信:Code-GUO

图片挂掉,可加微信:Code-GUO

如有疑问请提交issue,有违规侵权,请联系本人 coderguo@foxmail.com ,本人立马删除相应链接,感谢!

本仓库仅作学习交流分享使用,任何子环节不作任何商用。