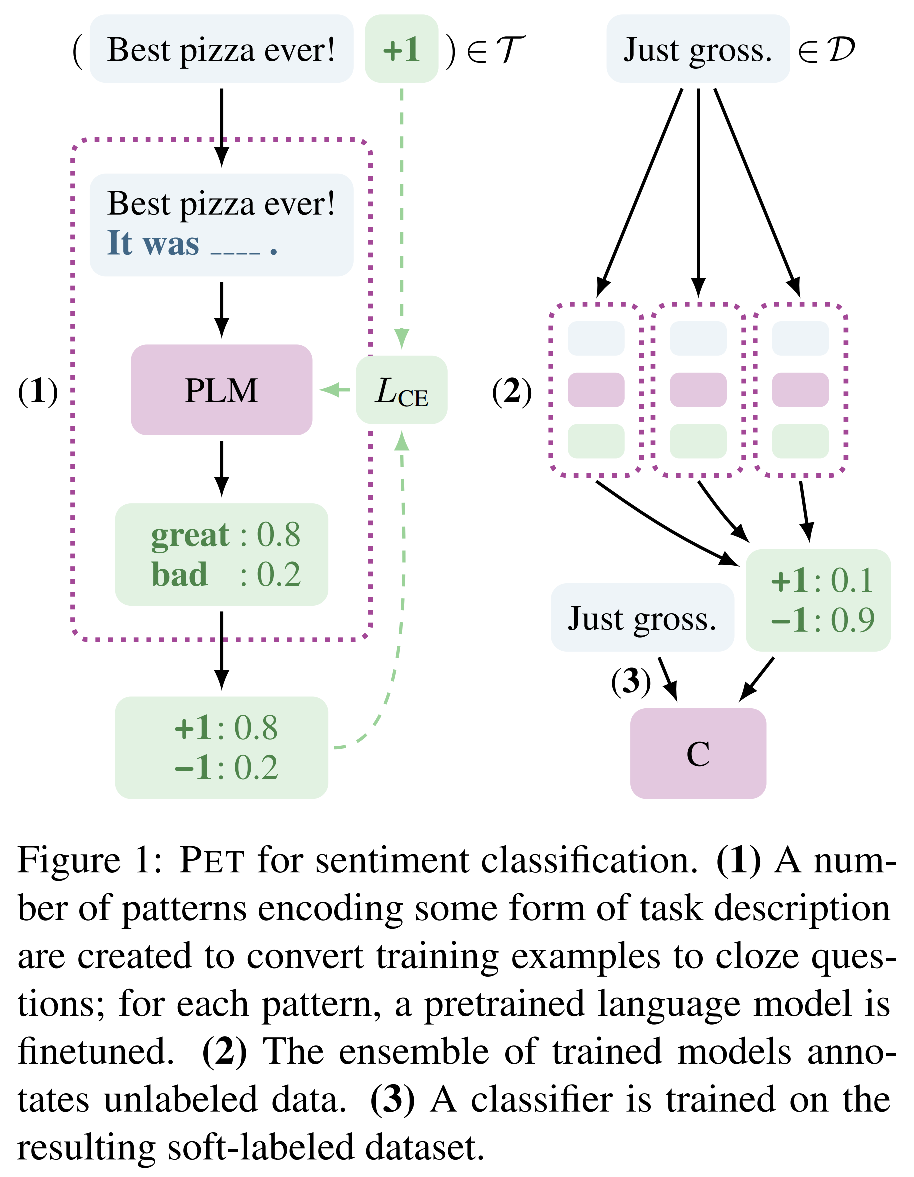

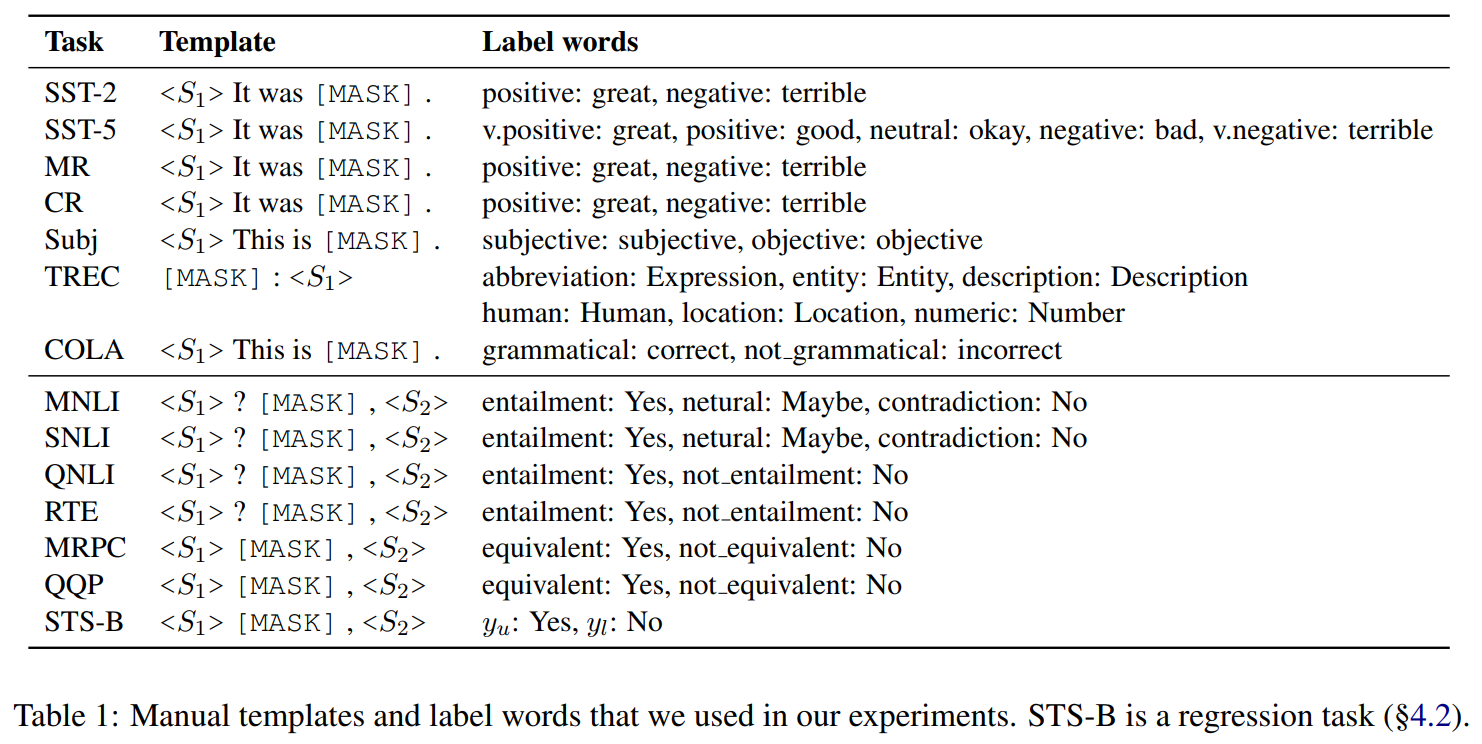

1. Exploiting Cloze Questions for Few Shot Text Classification and Natural Language Inference (EACL 2021) [pdf]

hard prompt MLM参数更新

- 由于语言、领域和任务的标注成本极高,在实际将语言模型应用到下游任务时,labeled samples很珍贵,few-shot场景非常常见,限制有监督学习,因而引起学者、从业者们对few-shot setting下执行NLP任务的关注。

- 给预训练语言模型引入文本解释/任务描述,可以通过无监督方式有效解决一些NLP任务(zero-shot scenario)。

- 综合考虑,本文提出引入pattern-exploiting-training,设计一种半监督训练策略PET和其改进版本iPET,将NLP的输入samples(text)映射为填空题形式(cloze-style phrase)。

2. It’s Not Just Size That Matters - Small Language Models Are Also Few-Shot Learners (NAACL 2021) [pdf]

hard prompt MLM参数更新

- PET、iPET框架只能处理单个[mask]的完形填空,而实际任务可能会遇到多个[mask]。

- 本文相当于PET、iPET的改进版本,将单[mask] token拓展到k个[mask] tokens。

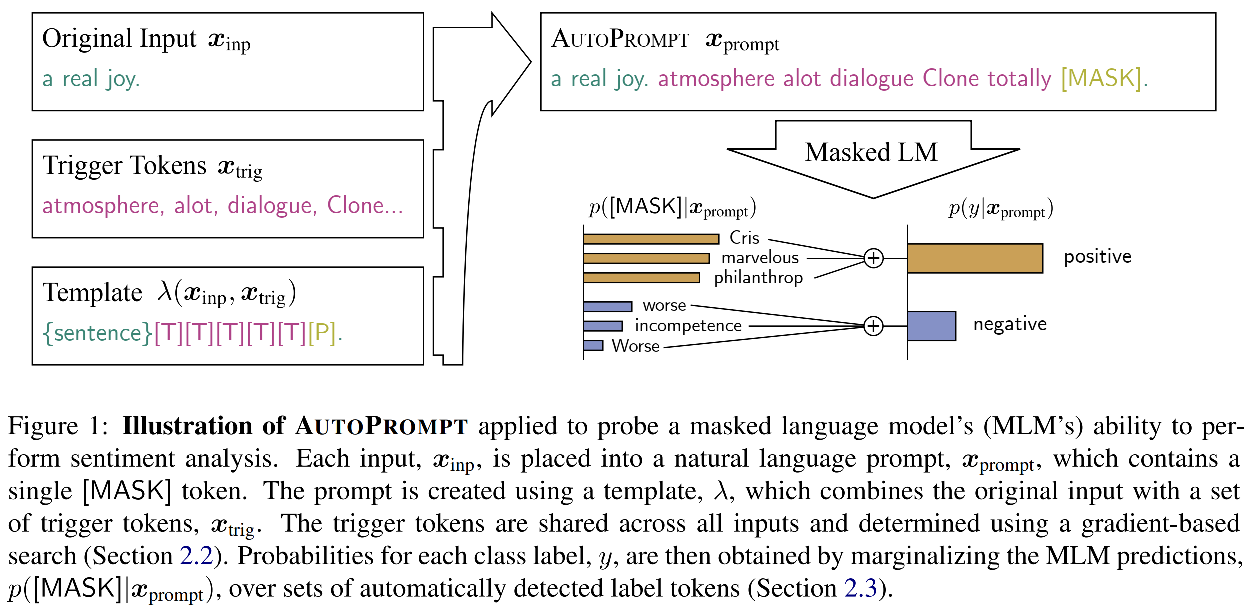

3. AUTOPROMPT: Eliciting Knowledge from Language Models with Automatically Generated Prompts (PrePrint 2020) [pdf]

soft prompt MLM参数固定?

- 在使用预训练语言模型时,将下游任务定义为填空题形式(任务->语言模型,与语言模型完美契合),使用prompt沟通预训练模型和下游任务,有助于评价预训练阶段学习到的知识情况,切无需引入大量的新参数。

- 以往专家设计的prompt(hard prompt)成本高,对许多任务而言不直观,此外,模型对prompt包含的context信息高度敏感,因此人工设计的prompt容易引入bias。

- 为此,本文提出自动学习prompt和label的方式。

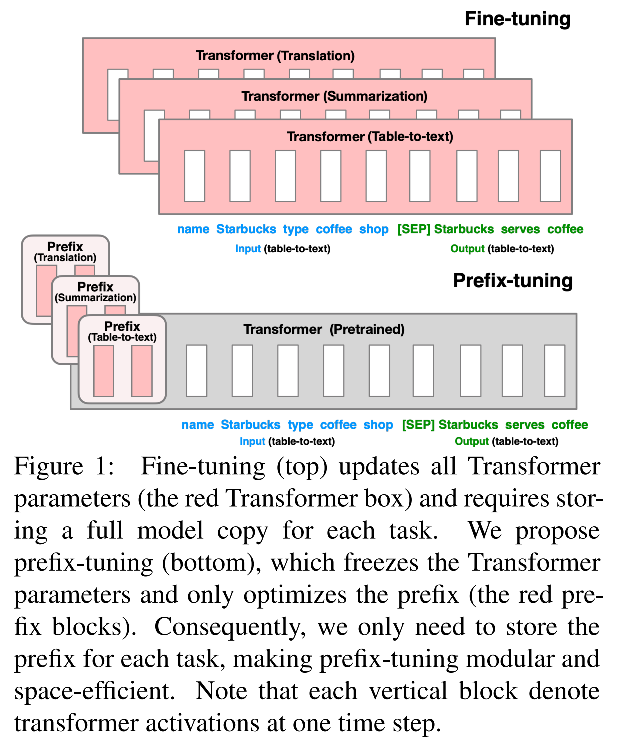

soft prefix prompt tokens hard input sample prompt tokens MLM参数固定

- 使用pre-train -> fine-tune范式将预训练语言模型应用下游任务时,通常需要更新预训练语言模型的参数。对不同任务需要分别fine-tune一次模型,并存储其参数,训练和存储开销昂贵。

- 本文提出为每个任务训练连续的prefix prompt tokens(prefix of input samples),趋势语言模型执行不同任务。

5. PADA: A Prompt-based Autoregressive Approach for Adaptation to Unseen Domains (2021) [pdf]

soft prompt MLM

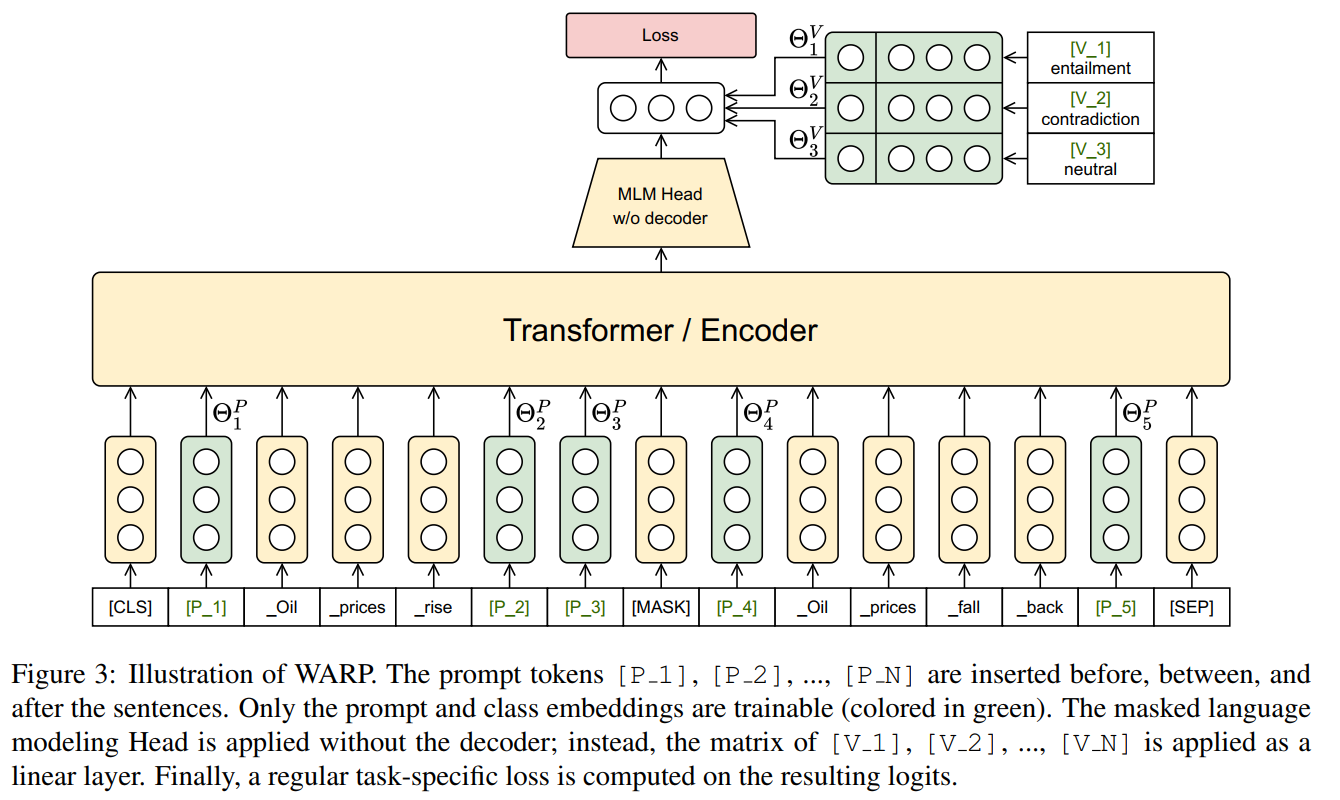

6. WARP: Word-level Adversarial ReProgramming (ACL 2021) [pdf]

soft prompt MLM参数固定,只更新插入的prompt和label

7. Making Pre-trained Language Models Better Few-shot Learners (2021) [pdf]

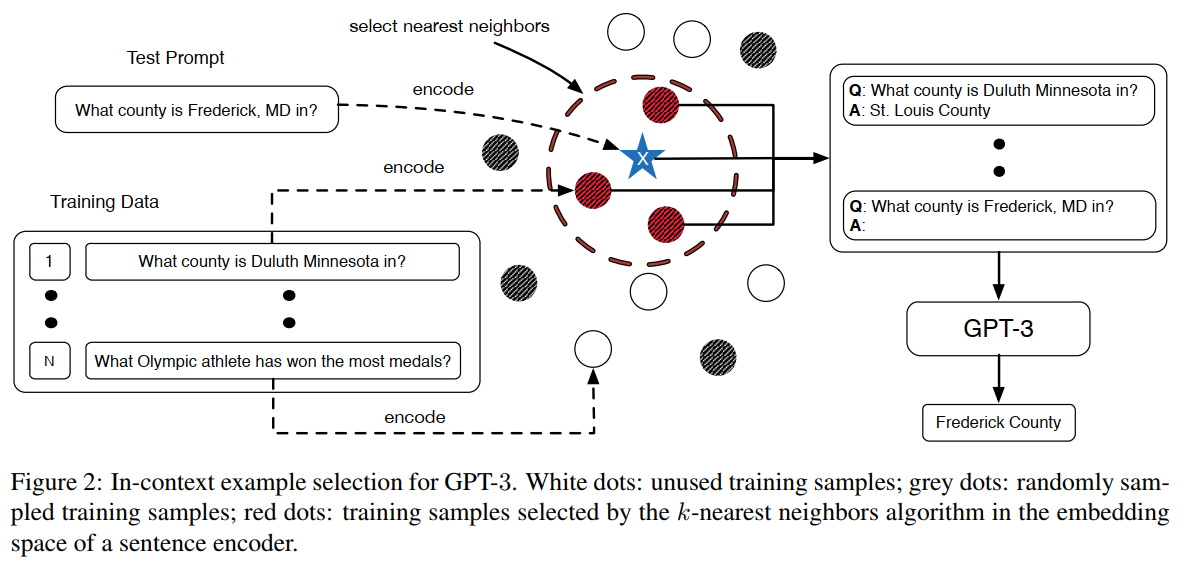

8. What Makes Good In-Context Examples for GPT-3? (2021) [pdf]

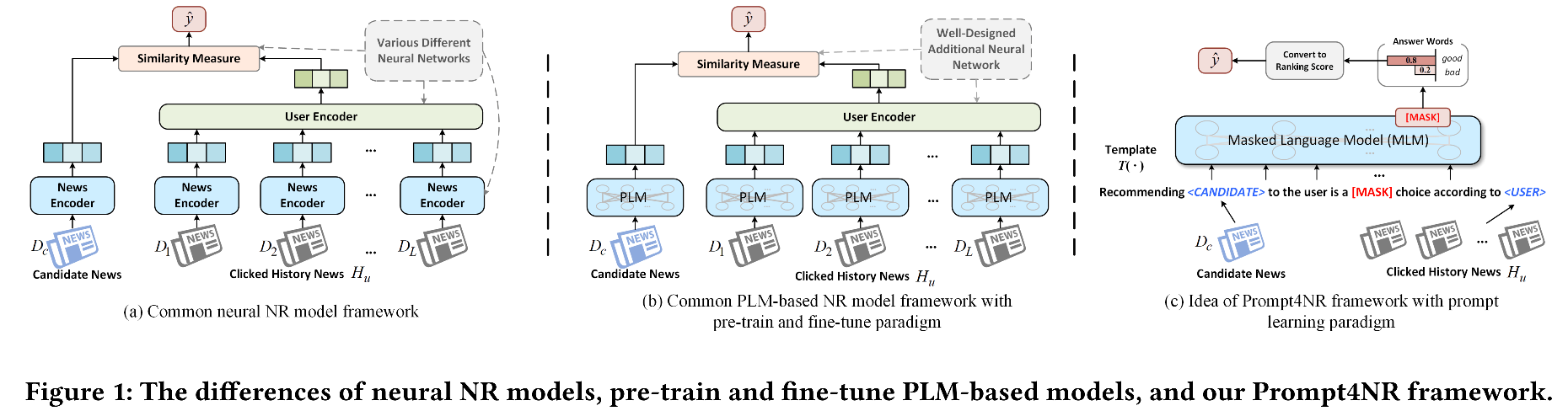

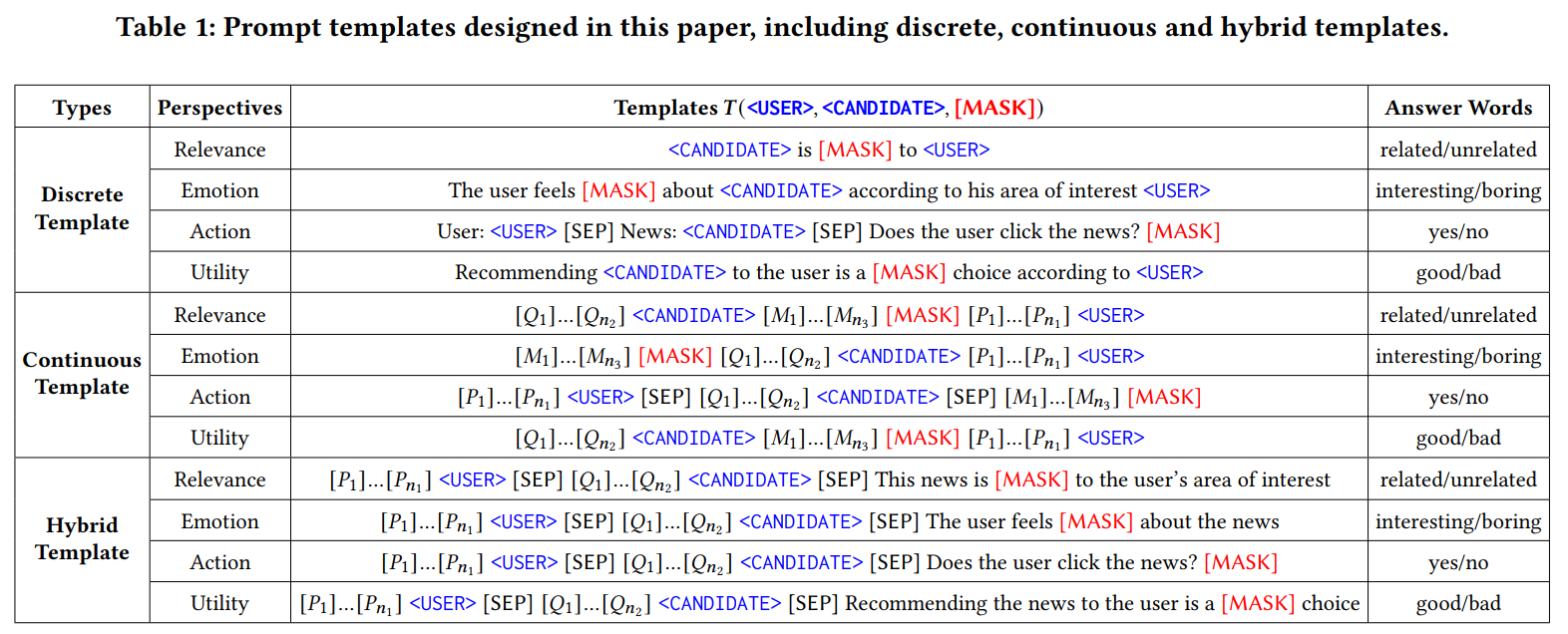

1. Prompt Learning for News Recommendation (SIGIR 2023) [pdf] 👀

soft prompt hard prompt hybrid prompt

- 传统新闻推荐模型:news encoder、user encoder、similarity measure 最近工作引入预训练语言模型,以pre-trian -> fine-tune范式,编码新闻内容,以进行新闻推荐。不足:因为新闻推荐任务和预训练语言模型任务存在gap,当前方法无法充分利用大语言模型的知识。

- prompt learning以pre-train -> prompt -> predict范式将下游任务和预训练语言模型对齐,在诸多NLP任务表现出色。受此启发,本文将prompt learning模式引入新闻推荐。

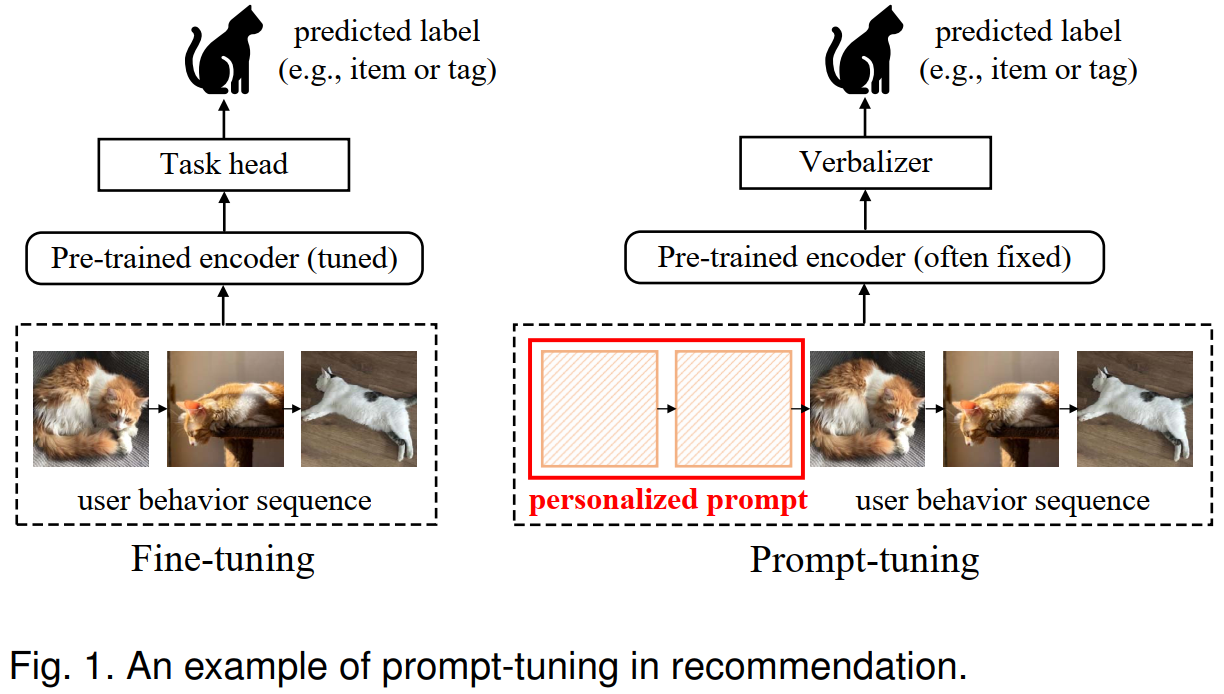

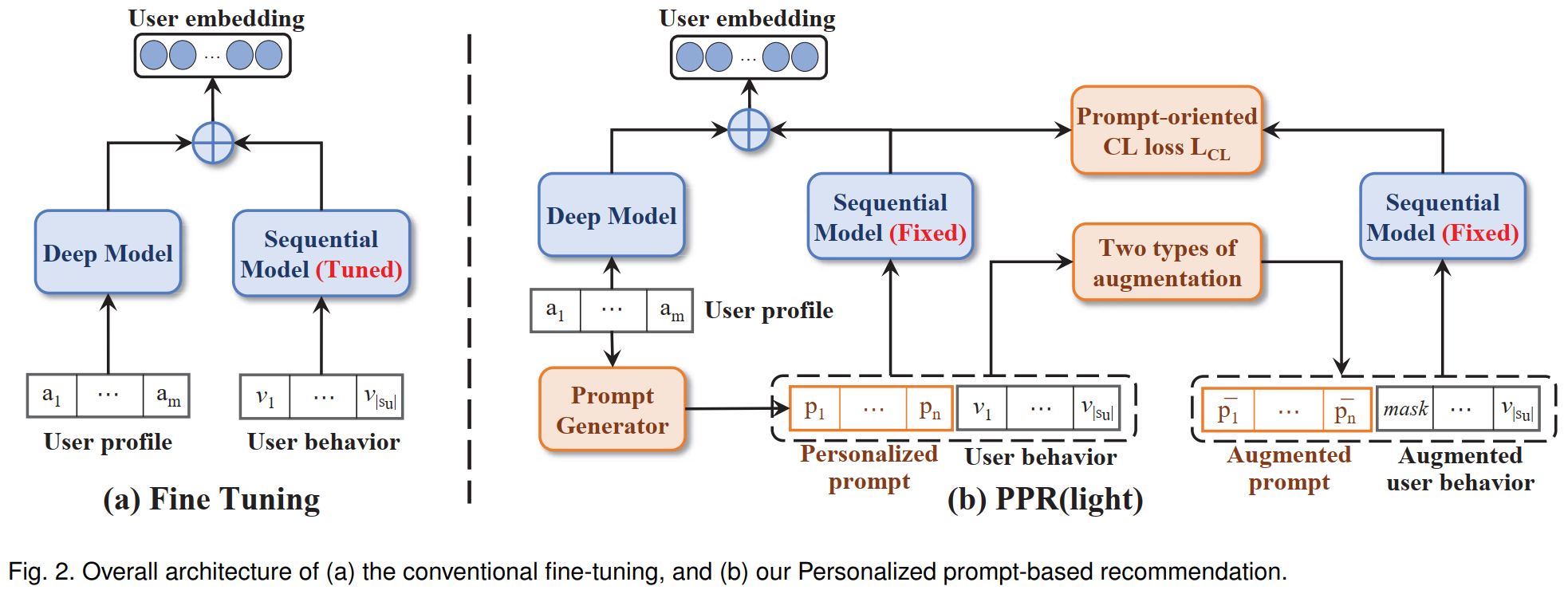

2. Personalized Prompt for Sequential Recommendation (2023) [pdf] 👀

- 随着预训练语言模型的火爆出圈,鉴于其其强大的知识储备、语义理解和语言处理能力,最近相关工作开始将预训练语言模型引入序列推荐。相关研究将用户历史行为视为tokens,作为预训练语言模型的输入,以缓解真实场景下用户行为数据洗漱问题。

- 本文将预训练语言模型引入到序列推荐任务以处理few-shot和zero-shot问题,采用prompt learning范式,将推荐任务和预训练语言模型对齐,以更高效从预训练语言模型提取知识。

- 如何将NLP领域的prompt tuning范式引入推荐任务?

- 如何为推荐系统设计个性化prompts(user-oriented)。

3. Personalized Prompt Learning for Explainable Recommendation (2023) [pdf]

4. GPT4Rec: A Generative Framework for Personalized Recommendation and User Interests Interpretation (2023) [pdf]

5. Large Language Models are Zero-Shot Rankers for Recommender Systems (2023) [pdf]

Testing LLM for Rec