Результат проекта - база данных рецептов для дальнейшего использования при создании приложения.

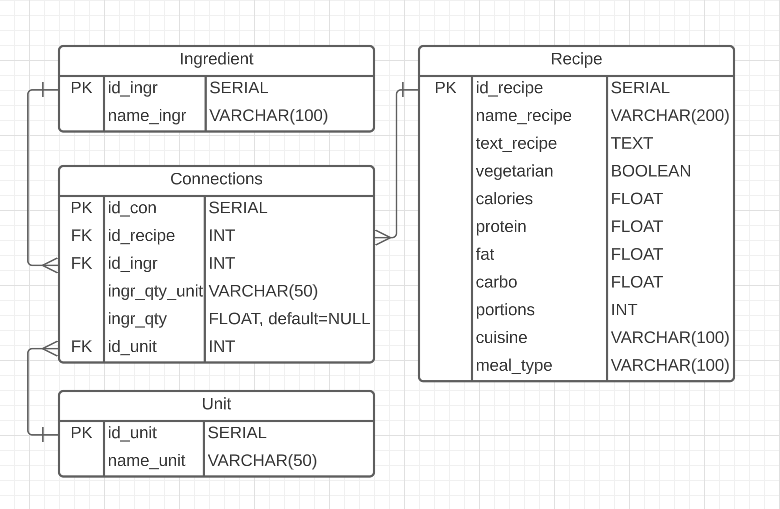

Реализован многопоточный автоматический парсинг сайта с рецептами и занесение структурированных данных в базу данных PostgreSQL.

- 1.1. Сбор ссылок сайта на страницы с рецептами.

- 1.2. Парсинг по ссылкам п. 1.1

- 1.3. Создание датафреймов в соответствии с приведенной выше структурой базы данных.

- 2.1. Создание базы данных PostgreSQL и соответствующих таблиц в ней.

- 2.2. Заполнение базы данными из датафреймов п. 1.3.

Многопоточный автоматический парсинг с использованием Selenium, BeautifulSoup и concurrent реализован в скрипте multigrab_urls.py

Многопоточный автоматический парсинг с использованием Selenium, BeautifulSoup, bleach и concurrent реализован в скрипте scrap_recipes.py.

Реализовано в ноутбуке make_dfs.ipynb

Реализовано в ноутбуке create_db&tables.ipynb

Реализовано в ноутбуке dfs_to_sql.ipynb