文字课程内容正在一节节补充更新,尽可能抽空继续更新正在 AIFoundation,希望您多多鼓励和参与进来!!!

文字课程开源在 AISys,系列视频托管B 站和油管,PPT 开源在 AIFoundation,欢迎取用!!!

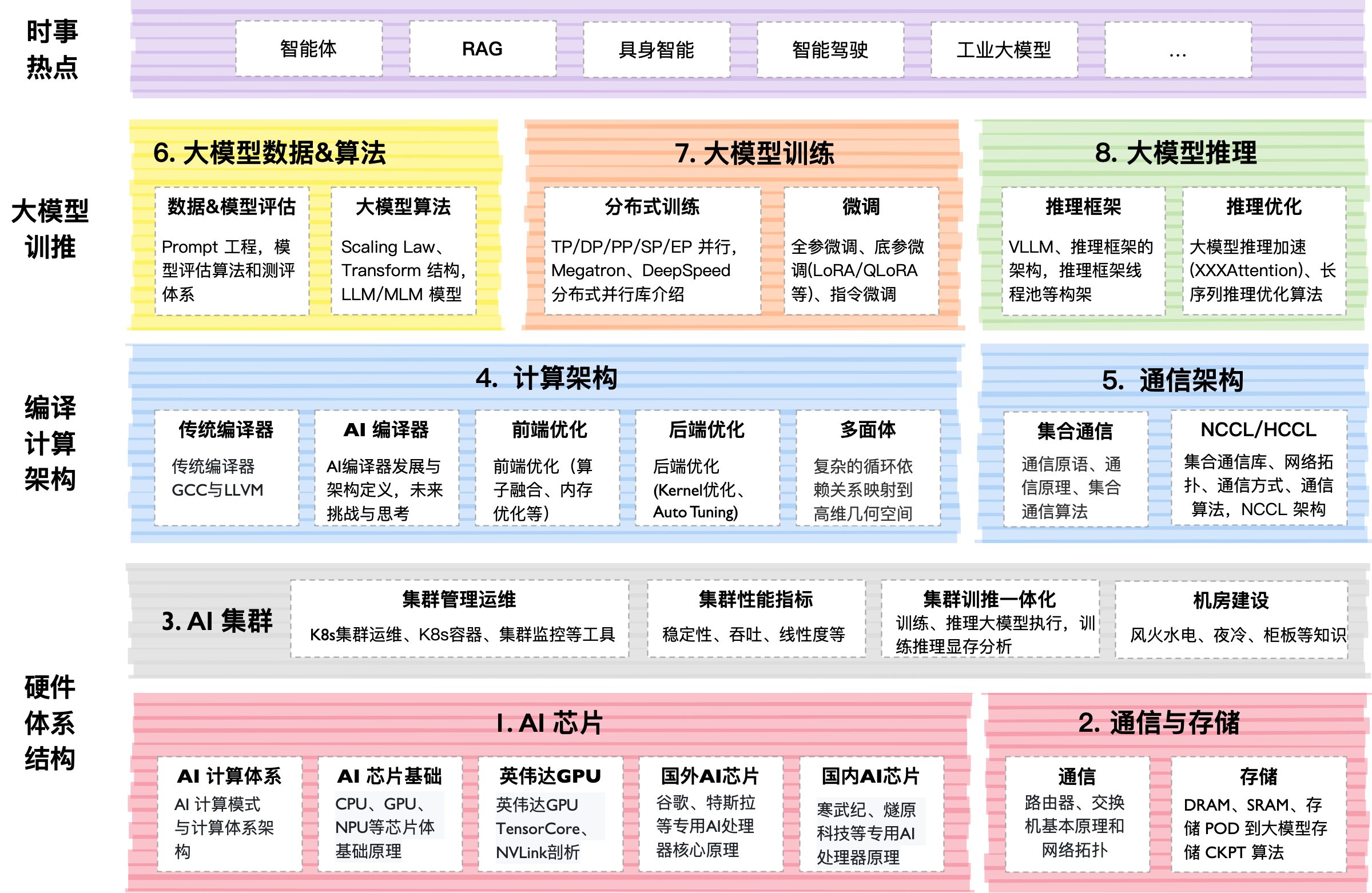

这个开源项目英文名字叫做AIFoundation,中文名字叫做大模型系统。大模型是基于 AI 集群的全栈软硬件性能优化,通过最小的每一块 AI 芯片组成的 AI 集群,编译器使能到上层的 AI 框架,训练过程需要分布式并行、集群通信等算法支持,而且在大模型领域最近持续演进如智能体等新技术。

本开源课程主要是跟大家一起探讨和学习人工智能、深度学习的系统设计,而整个系统是围绕着 ZOMI 在工作当中所积累、梳理、构建 AI 系统全栈的内容。希望跟所有关注 AI 开源课程的好朋友一起探讨研究,共同促进学习讨论。

课程主要包括以下模块,内容陆续更新中,欢迎贡献:

| 序列 | 教程内容 | 简介 | 地址 | 状态 |

|---|---|---|---|---|

| 01 | AI 芯片原理 | AI 芯片主要介绍 AI 的硬件体系架构,包括从芯片基础到 AI 芯片的原理与架构,芯片设计需要考虑 AI 算法与编程体系,以应对 AI 快速的发展。 | [Slides] | DONE |

| 02 | 通信&存储 | 大模型训练和推理的过程中都严重依赖于网络通信,因此会重点介绍通信原理、网络拓扑、组网方案、高速互联通信的内容。存储则是会从节点内的存储到存储 POD 进行介绍。 | [Slides] | 更新中 |

| 03 | AI 集群 | 大模型虽然已经慢慢在端测设备开始落地,但是总体对云端的依赖仍然很重很重,AI 集群会介绍集群运维管理、集群性能、训练推理一体化拓扑流程等内容。 | [Slides] | 更新中 |

| 04 | 计算架构 | [Slides] | 更新中 | |

| 05 | 通信架构 | 通信架构主要是指各种类型的 XCCL 集合通信库,大模型在推理的PD 分离和分布式训练,都对集合通信库有很强烈的诉求,网络模型的参数需要相互传递,因此 XCCL 极大帮助大模型更好地训练和推理。 | [Slides] | DONE |

| 06 | 大模型算法 | Transformer起源于NLP领域,近期**了 CV/NLP/多模态的大模型,我们将深入地探讨 Scaling Law 背后的原理。在大模型算法背后数据和算法的评估也是核心的内容之一,如何实现 Prompt 和通过 Prompt 提升模型效果。 | [Slides] | 更新中 |

| 07 | 大模型训练 | [Slides] | 更新中 | |

| 08 | 大模型推理 | 大模型推理核心工作是优化模型推理,实现推理加速,其中模型推理最核心的部分是Transformer Block。本节会重点探讨大模型推理的算法、调度策略和输出采样等相关算法。 | [Slides] | 更新中 |

| 09 | 热点技术剖析 | 当前大模型技术已进入快速迭代期。这一时期的显著特点就是技术的更新换代速度极快,新算法、新模型层出不穷。因此本节内容将会紧跟大模型的时事内容,进行深度技术分析。 | [Slides] | DONE |

本课程主要为本科生高年级、硕博研究生、AI 系统从业者设计,帮助大家:

-

完整了解 AI 的计算机系统架构,并通过实际问题和案例,来了解 AI 完整生命周期下的系统设计。

-

介绍前沿系统架构和 AI 相结合的研究工作,了解主流框架、平台和工具来了解 AI 系统。

| 编号 | 名称 | 具体内容 |

|---|---|---|

| 1 | AI 计算体系 | 神经网络等 AI 技术的计算模式和计算体系架构 |

| 2 | AI 芯片基础 | CPU、GPU、NPU 等芯片体系架构基础原理 |

| 3 | 图形处理器 GPU | GPU 的基本原理,英伟达 GPU 的架构发展 |

| 4 | 英伟达 GPU 详解 | 英伟达 GPU 的 Tensor Core、NVLink 深度剖析 |

| 5 | 国外 AI 处理器 | 谷歌、特斯拉等专用 AI 处理器核心原理 |

| 6 | 国内 AI 处理器 | 寒武纪、燧原科技等专用 AI 处理器核心原理 |

| 7 | AI 芯片黄金 10 年 | 对 AI 芯片的编程模式和发展进行总结 |

| 编号 | 名称 | 具体内容 |

|---|---|---|

| 1 | 集合通信原理 | 通信域、通信算法、集合通信原语 |

| 2 | 集合通信库 | 深入地剖析 NCCL/HCCL 实现算法、对外 API |

| 编号 | 名称 | 具体内容 |

|---|---|---|

| 1 | 时事热点 | OpenAI o1、WWDC 大会技术洞察 |

| 2 | AI智能体 | AI Agent 智能体的原理、架构 |

| 3 | 自动驾驶 | 端到端自动驾驶和萝卜快跑 |

| 4 | 具身智能 | 具身智能的原理、架构和产业思考 |

| 5 | 生成推荐 | 推荐领域的革命发展历程 |

| 6 | 隐私计算 | 发展过程与 Apple 引入隐私计算 |

这个仓已经到达疯狂的 10G 啦(ZOMI 把所有制作过程、高清图片都原封不动提供),如果你要 git clone 会非常的慢,因此建议优先到 Releases · chenzomi12/AIFoundation 来下载你需要的内容

非常希望您也参与到这个开源课程中,B 站给 ZOMI 留言哦!

欢迎大家使用的过程中发现 bug 或者勘误直接提交代码 PR 到开源社区哦!

请大家尊重开源和 ZOMI 的努力,引用 PPT 的内容请规范转载标明出处哦!