Toda a descrição (passo a passo) deste projeto está disponibilizado neste post: Medium

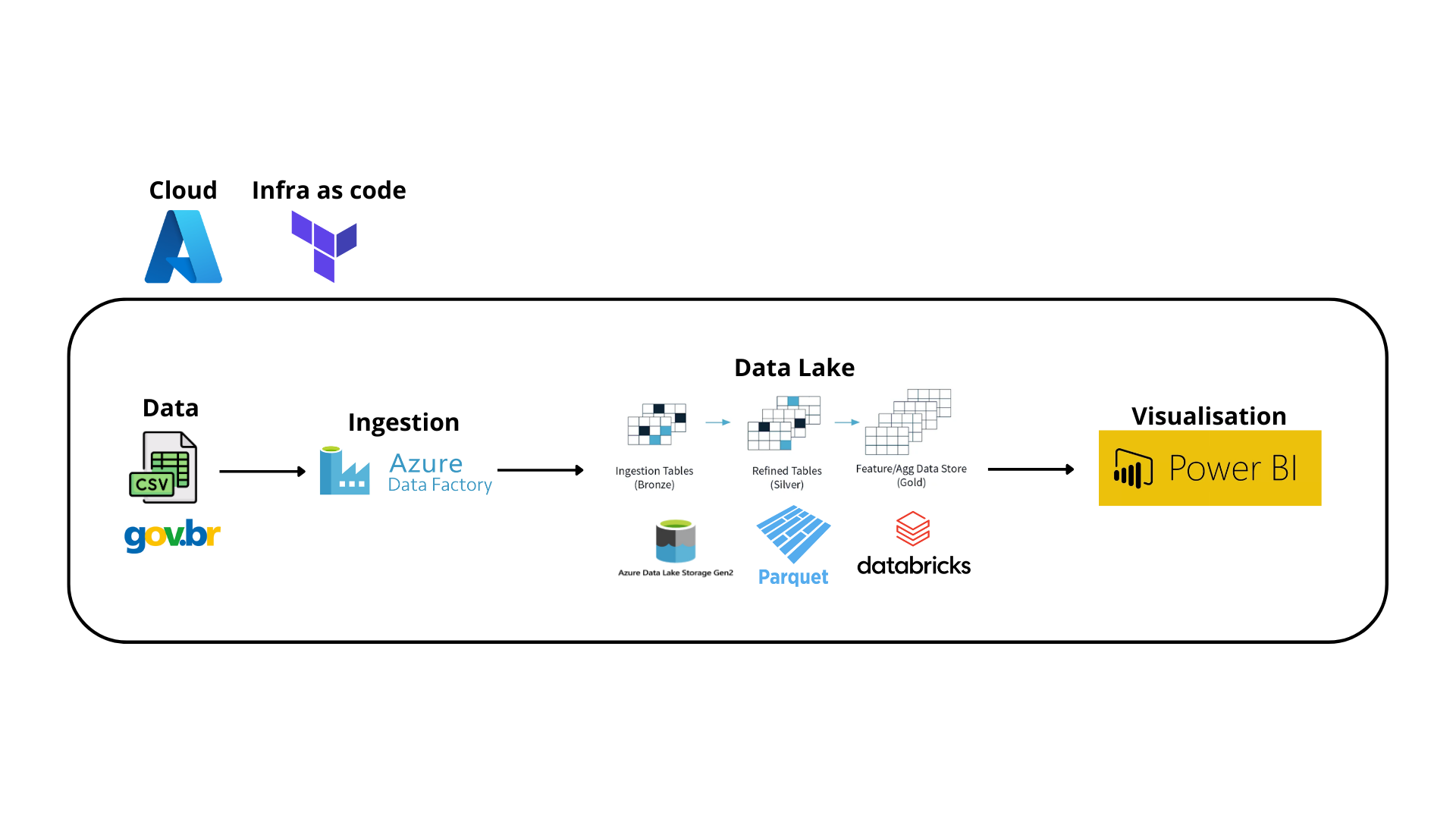

Neste projeto foi construído um Data Pipeline com a utilização de algumas ferramentas incríveis: Terraform, Azure Data Factory, Databricks e Azure Data Lake Gen 2. O principal objetivo deste projeto é por em prática essas ferramentas para a extração, transformação e carregamento (ETL) de uma base de dados disponibilizado pelo governo federal da vacinação da COVID 19.

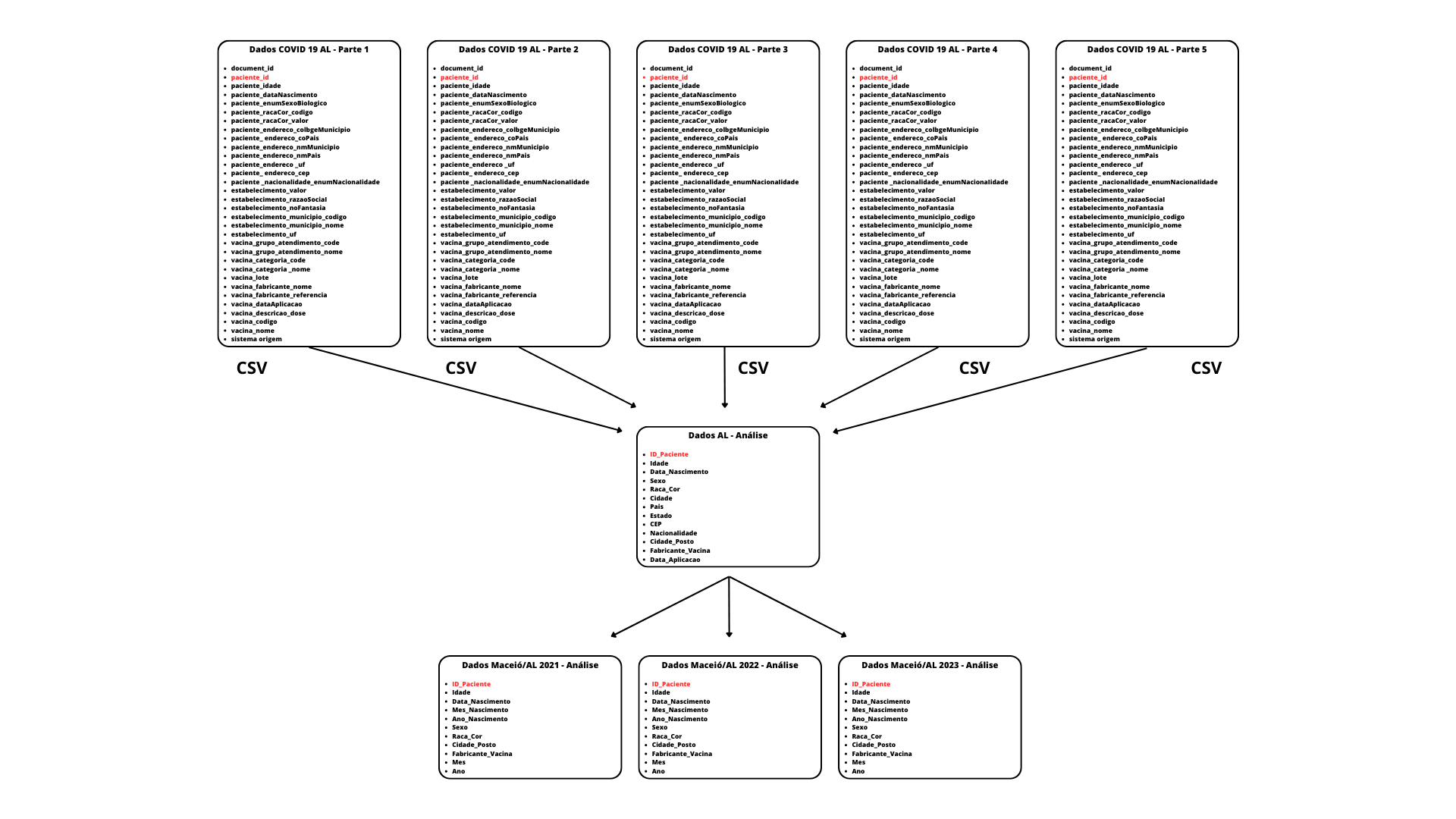

Os dados disponibilizados pelo governo estão em formato CSV e são divididos por estado. Para esta análise foram utilizados os dados do estado de Alagoas que estão estruturados na seguinte maneira:

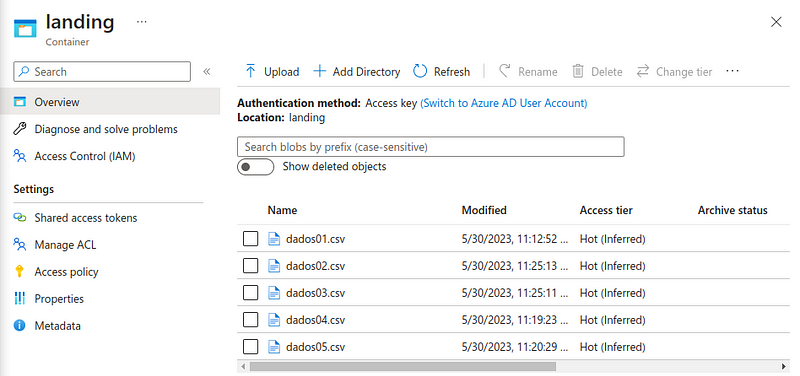

Partindo como base o consumo da base de dados pública da vacinação da COVID 19. A ingestão dos dados foi realizada pelo Azure Data Factory em formato CSV e carregados na camada Landing do diretório da Azure Blob Storage (Data Lake Gen 2).

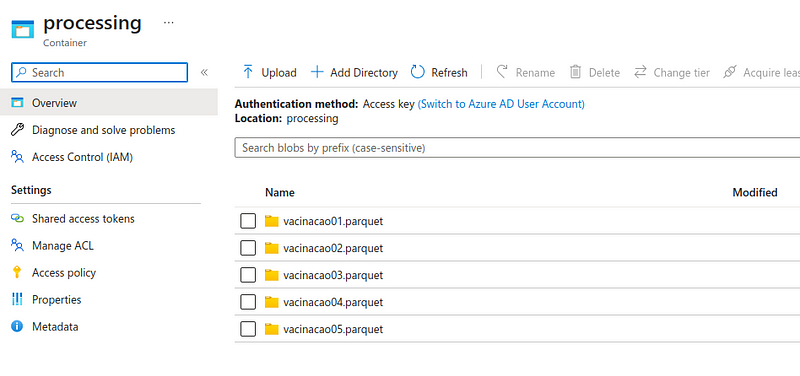

Todo o CSV depositado na camada Landing foi tratado e carregado para as outras camadas (Processing e Curated) no Azure Databricks. No notebook do Databricks é definido primeiramente a montagem do Data Lake (necessário realizar alguns processo de permissões).

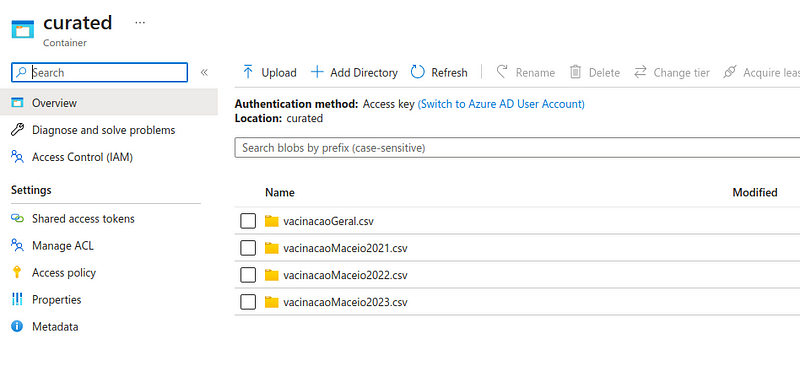

Os dados CSV da camada Landing foram transformados para o formato parquet e carregados na camada Processing e em seguida foram criadas algumas tabelas específicas para análise na Curated zone (consumidas diretamente pelo Power BI).

Todas as features da Azure foram provisionando utilizando infraestrutura como código com o Terraform. Todos os passos para sua execução estão bem descritos no meu Post no Medium.

O processo de ingestão dos dados foi executado com Azure Data Factory da base de dados do governo ao Data Lake (Azure Data Lake Gen2).

Nesta etapa foi efetuado por meio do Databricks a transformação dos dados CSVs para outras camadas (Processing e Curated). Para isso foi criado um notebook disponível neste diretório.

Basicamente todo o conteúdo foi transformado para o formato Parquet e carregado na Processing Zone. Posteriormente foram criadas algumas tabelas específicas para utilização no Power BI => Vacinação Geral e Vacinação em Maceió em 2021, 2022 e 2023.

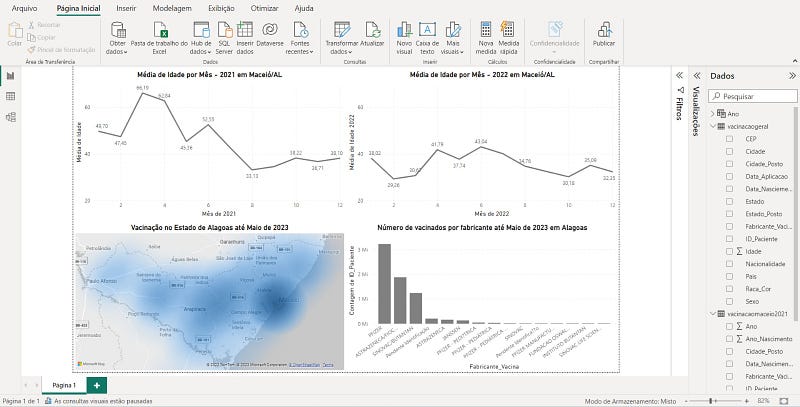

A última etapa deste projeto é a chegada de nossos dados no Power BI. Para isso foi utilizado a opção de carregamento de dados do Azure Databricks do Power BI.

Com a obtenção das tabelas geradas na Curated Zone foi possível desenvolver um simples Dashboard com algumas métricas da vacinação da Covid 19 em Alagoas.