中文说明 | English

持续维护的新浪微博爬虫🚀🚀🚀

UPDATE: weibo.cn的关键词搜索接口已失效(2021.6.6)

该项目分为2个分支,以满足不同的需要

| 分支 | 特点 | 抓取量 |

|---|---|---|

| master | 单账号,单IP,单机器 | 十万级 |

| senior | 账号池,IP池,Docker分布式 | 数亿级(理论无上限) |

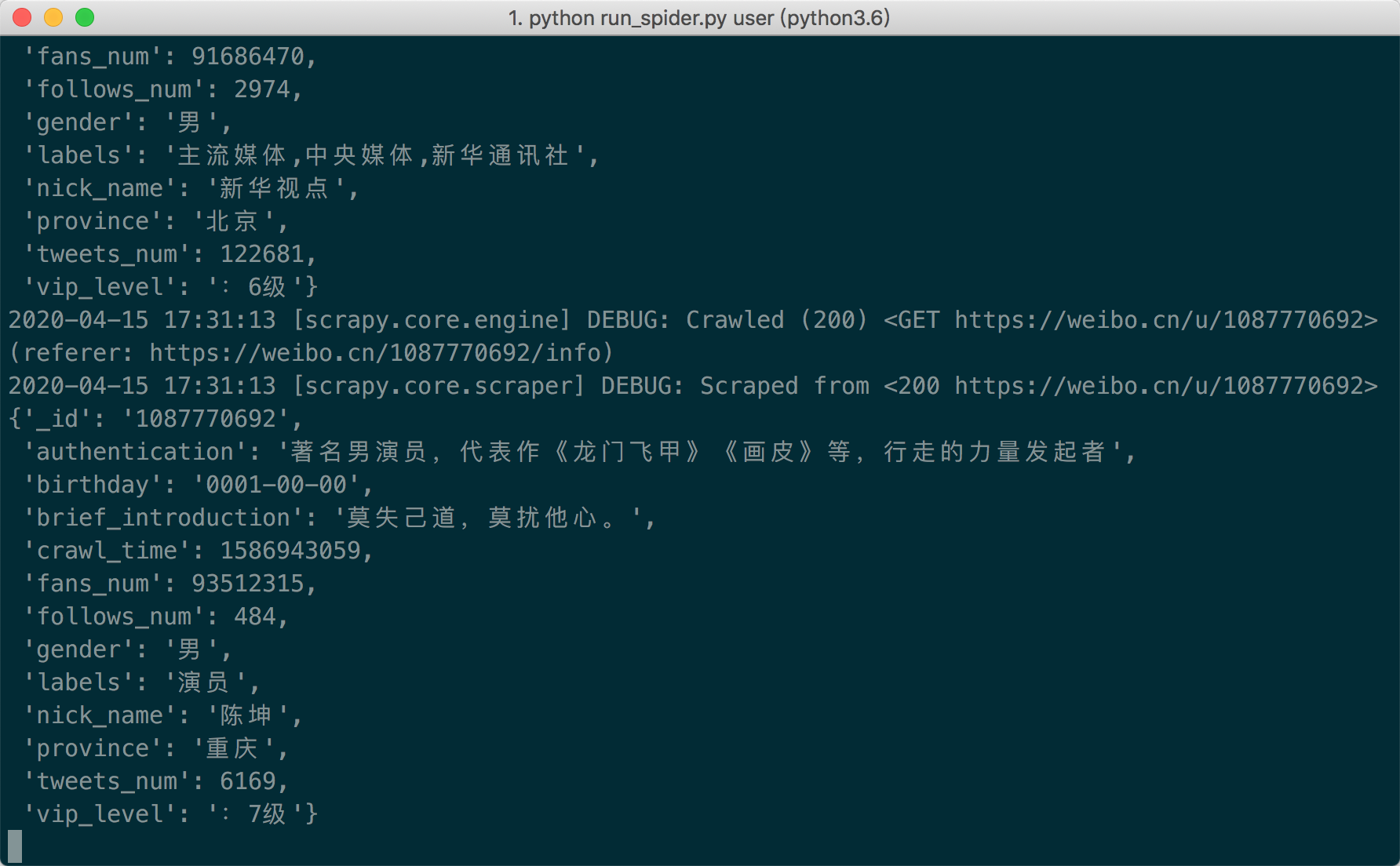

- 用户信息抓取

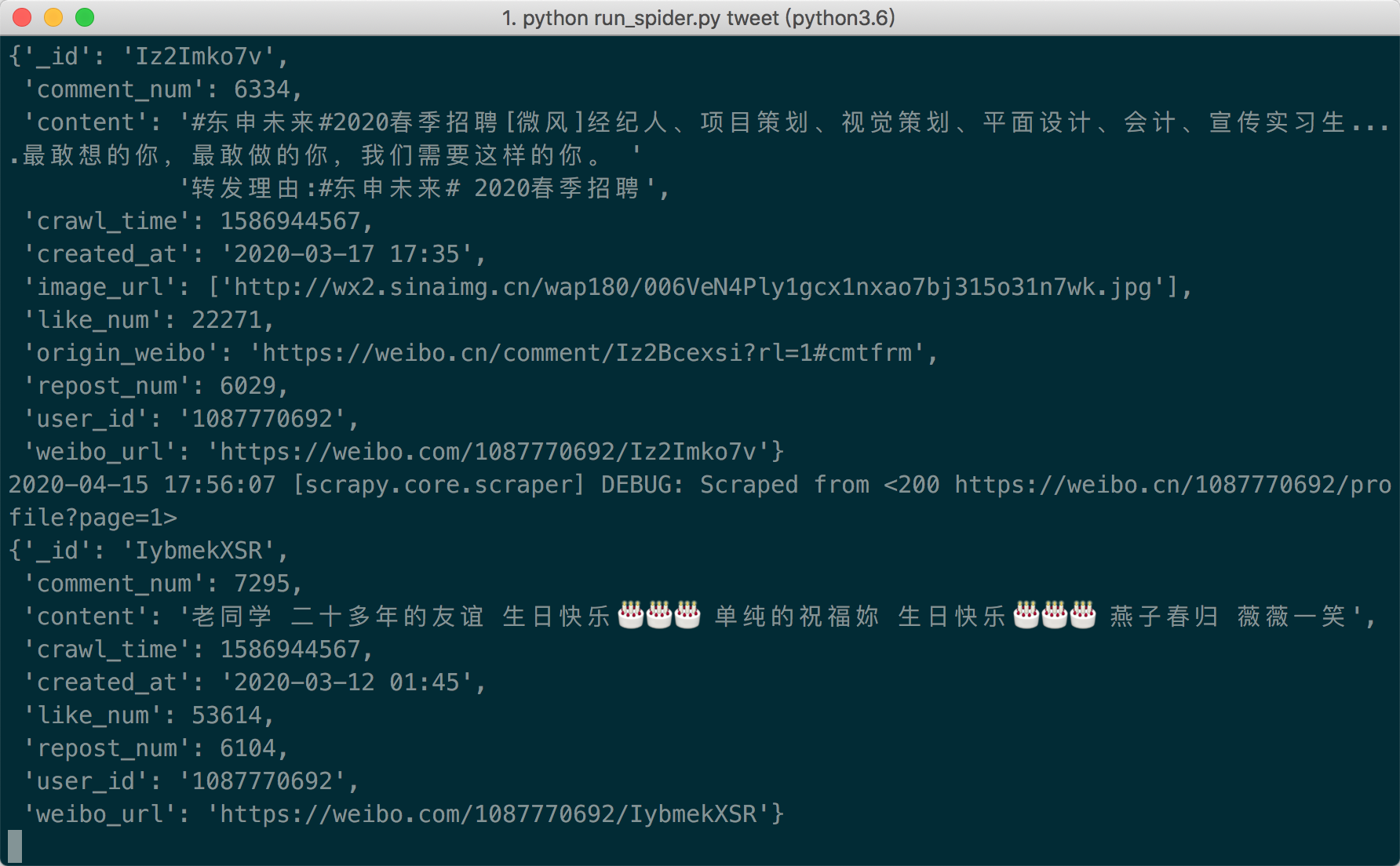

- 用户微博抓取(全量/指定时间段)

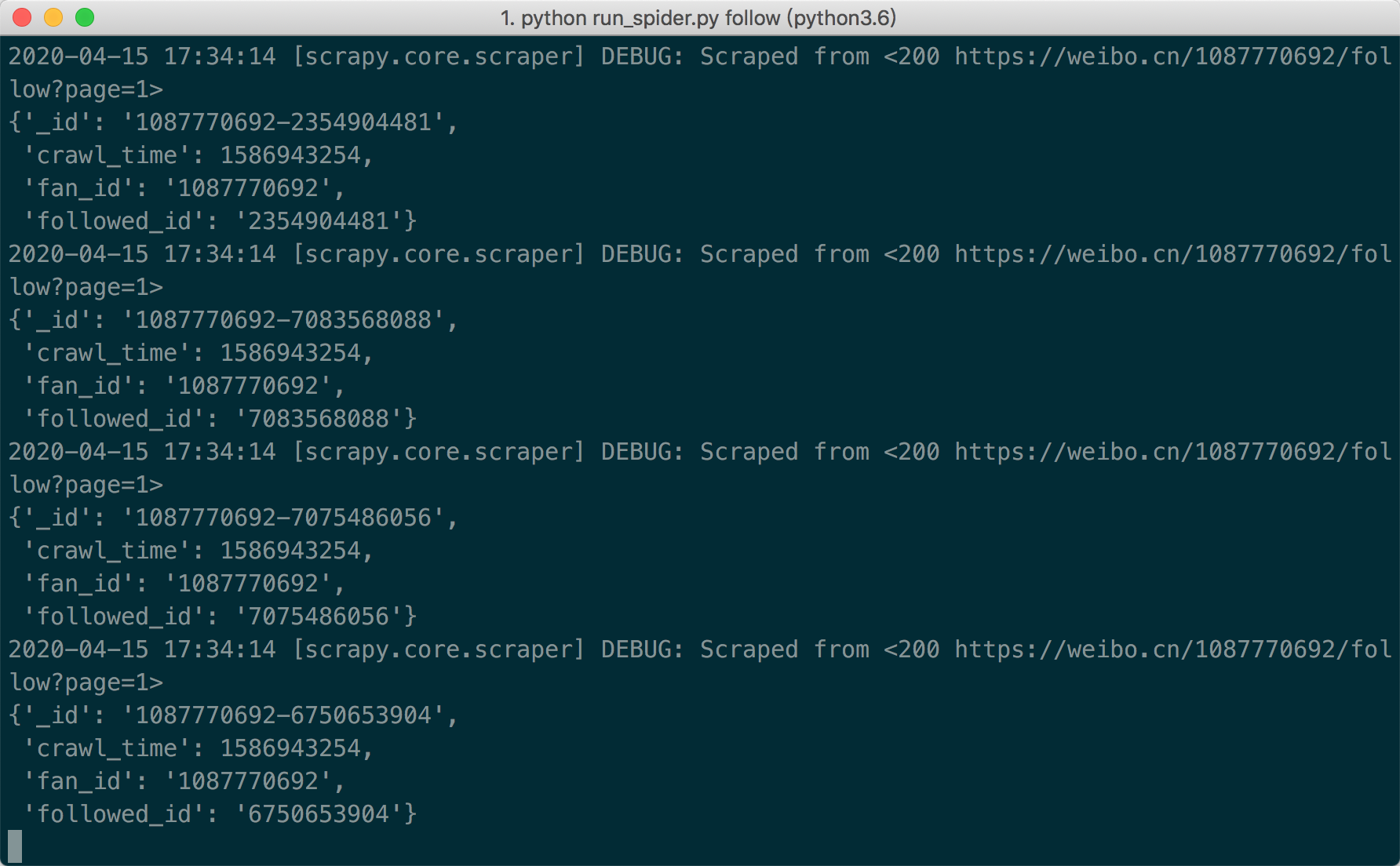

- 用户社交关系抓取(粉丝/关注)

- 微博评论抓取

- 基于关键词和时间段(粒度到小时)的微博抓取

- 微博转发抓取

项目基于weibo.cn站点抓取,抓取的字段非常丰富。具体请移步:数据字段说明

本项目Python版本为Python3.6

git clone git@github.com:nghuyong/WeiboSpider.git --depth 1 --no-single-branch

cd WeiboSpider

pip install -r requirements.txt除此之外,还需要安装mongodb.

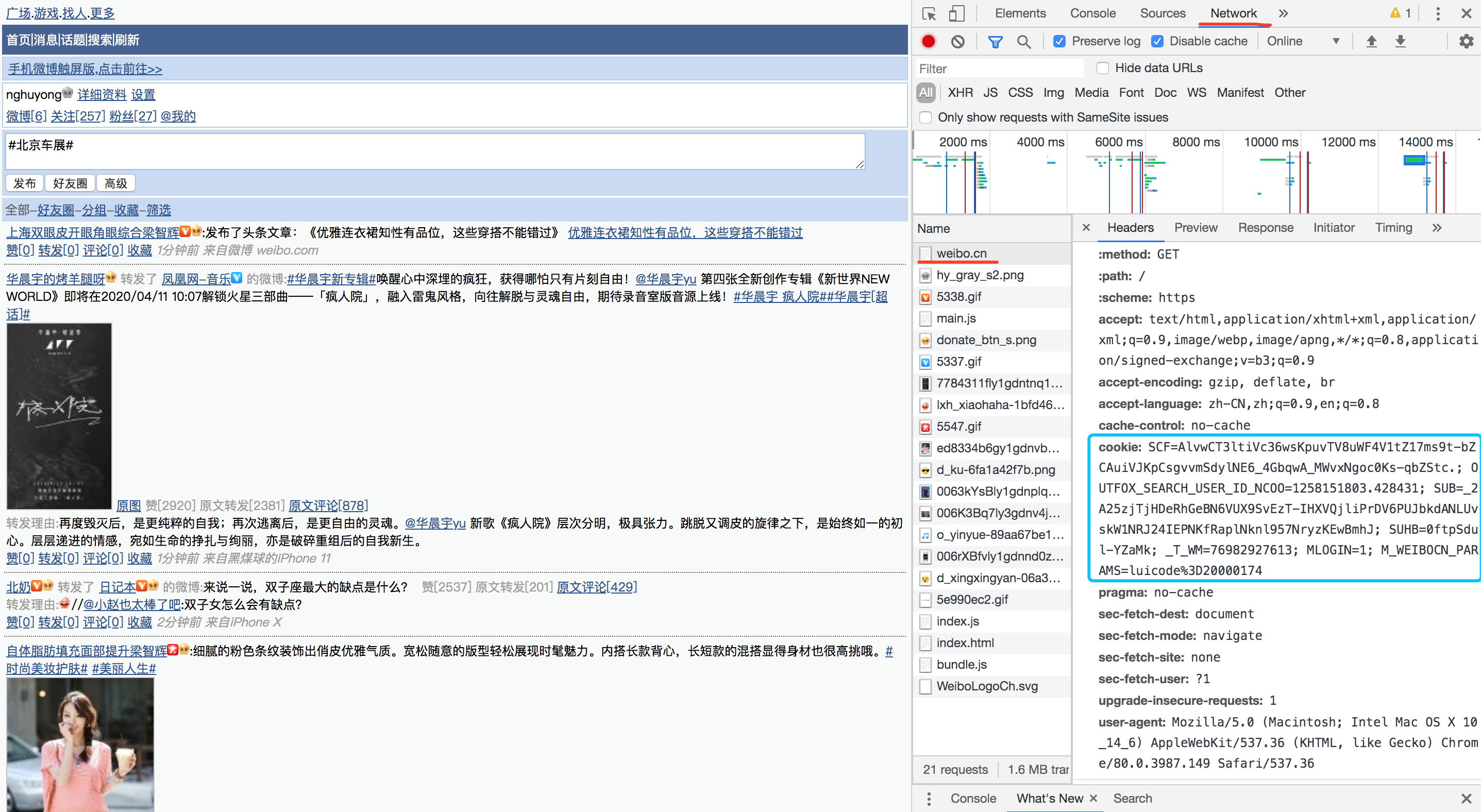

登陆账号,打开浏览器的开发者模式,再次刷新

复制weibo.cn这个数据包,network中的cookie值

将weibospider/settings.py中:

DEFAULT_REQUEST_HEADERS = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.13; rv:61.0) Gecko/20100101 Firefox/61.0',

'Cookie':'SCF=AlvwCT3ltiVc36wsKpuvTV8uWF4V1tZ17ms9t-bZCAuiVJKpCsgvvmSdylNE6_4GbqwA_MWvxNgoc0Ks-qbZStc.; OUTFOX_SEARCH_USER_ID_NCOO=1258151803.428431; SUB=_2A25zjTjHDeRhGeBN6VUX9SvEzT-IHXVQjliPrDV6PUJbkdANLUvskW1NRJ24IEPNKfRaplNknl957NryzKEwBmhJ; SUHB=0ftpSdul-YZaMk; _T_WM=76982927613'

}Cookie字段替换成你自己的Cookie

如果爬虫运行出现403/302,说明账号被封/cookie失效,请重新替换cookie

重写fetch_proxy方法,该方法需要返回一个代理ip

可根据自己实际需要重写./weibospider/spiders/*中的start_requests函数

cd weibospider

python run_spider.py user

python run_spider.py fanpython run_spider.py followpython run_spider.py comment在./weibospider/spiders/tweet.py中start_requests,urls选择init_url_by_user_id()

python run_spider.py tweet在./weibospider/spiders/tweet.py中start_requests,urls选择init_url_by_user_id_and_date()

python run_spider.py tweet在./weibospider/spiders/tweet.py中start_requests,urls选择init_url_by_keywords_and_date()

python run_spider.py tweetpython run_spider.py repost基于该项目已经构建千万级别的微博活跃用户数据集,以及海量的微博舆情数据集,现已公开weibo-public-opinion-datasets

如果您在使用该项目中有任何问题,均可以开issue进行讨论

如果您在社交媒体计算/舆情分析等领域上有好的idea,欢迎一起交流合作: nghuyong@163.com