MASR是一款基于Pytorch实现的自动语音识别框架,MASR全称是神奇的自动语音识别框架(Magical Automatic Speech Recognition),MASR致力于简单,实用的语音识别项目。可部署在服务器,Nvidia Jetson设备,未来还计划支持Android等移动设备。

如果熟悉PaddlePaddle,请优先使用:PPASR

欢迎大家扫码入QQ群讨论,或者直接搜索QQ群号1169600237,问题答案为博主Github的IDyeyupiaoling。

本项目使用的环境:

- Anaconda 3

- Python 3.8

- Pytorch 1.12.1

- Windows 10 or Ubuntu 18.04

- 本项目支持流式识别模型

deepspeech2、deepspeech2_big,非流式模型deepspeech2_no_stream、deepspeech2_big_no_stream。 - 本项目支持两种解码器,分别是集束搜索解码器

ctc_beam_search和贪心解码器ctc_greedy,集束搜索解码器ctc_beam_search准确率更高,但不支持Windows。

- 2022.10.01: 调整数据预处理,此前下载的模型,需要重新下载。

- 2022.09.18: 支持使用WebSocket调用流式识别。

- 2022.08.27: 修改使用kaldi实现

fbank和mfcc预处理方法。 - 2022.08.22: 增加非流式模型

deepspeech2_no_stream和deepspeech2_big_no_stream。 - 2022.08.04: 发布1.0版本,优化实时识别流程。

- 2022.07.12: 完成GUI界面的录音实时识别。

- 2022.06.14: 支持

deepspeech2_big模型,适合WenetSpeech大数据集训练模型。 - 2022.01.16: 支持多种预处理方法。

- 2022.01.15: 支持英文语音识别。

- 2022.01.13: 支持给识别结果加标点符号

- 2021.12.26: 支持pip方式安装。

- 2021.12.25: 初步完成基本程序。

这个是PPSAR的视频教程,项目是通用的,可以参考使用。

本项目支持流式识别模型deepspeech2、deepspeech2_big,非流式模型deepspeech2_no_stream、deepspeech2_big_no_stream。

| 使用模型 | 数据集 | 预处理方式 | 参数大小(M)* |

语言 | 测试集字错率(词错率) | 下载地址 |

|---|---|---|---|---|---|---|

| deepspeech2_big | WenetSpeech (10000小时) | fbank | 167 | 中文 | 0.08944(AIShell的测试集) | 点击下载 |

| deepspeech2 | aishell (179小时) | fbank | 35 | 中文 | 0.08279 | 点击下载 |

| deepspeech2_big | aishell (179小时) | fbank | 167 | 中文 | 0.05912 | 点击下载 |

| deepspeech2_no_stream | aishell (179小时) | fbank | 98 | 中文 | 0.06982 | 点击下载 |

| deepspeech2 | Librispeech (960小时) | fbank | 35 | 英文 | 点击下载 | |

| deepspeech2_big | Librispeech (960小时) | fbank | 167 | 英文 | 0.15533 | 点击下载 |

| deepspeech2_no_stream | Librispeech (960小时) | fbank | 98 | 英文 | 0.09705 | 点击下载 |

说明:

- 这里字错率或者词错率是使用

eval.py程序并使用集束搜索解码ctc_beam_search方法计算得到的。 - 把全部文件复制到项目根目录下。

- 模型名称包含

no_stream为非流式模型,不能用于流式识别。 - 由于算力不足,大部分的模型都没有训练足够轮数,有算力的同学,欢迎提供模型。

- 由于音频的长度不一,所以参数大小也有所变化,以上参数大小为同一音频长度下的结果,仅供对比使用。

有问题欢迎提 issue 交流

python infer_path.py --wav_path=./dataset/test.wav输出结果:

----------- 额外配置参数 -----------

configs: configs/config_zh.yml

is_long_audio: False

model_dir: models/{}_{}/infer/

pun_model_dir: models/pun_models/

real_time_demo: False

to_an: False

use_gpu: True

use_pun: False

wav_path: dataset/test.wav

------------------------------------------------

----------- 配置文件参数 -----------

ctc_beam_search_decoder: {'alpha': 2.2, 'beta': 4.3, 'beam_size': 300, 'num_processes': 10, 'cutoff_prob': 0.99, 'cutoff_top_n': 40, 'language_model_path': 'lm/zh_giga.no_cna_cmn.prune01244.klm'}

dataset: {'batch_size': 32, 'num_workers': 4, 'min_duration': 0.5, 'max_duration': 20, 'train_manifest': 'dataset/manifest.train', 'test_manifest': 'dataset/manifest.test', 'dataset_vocab': 'dataset/vocabulary.txt', 'mean_std_path': 'dataset/mean_std.json', 'noise_manifest_path': 'dataset/manifest.noise'}

decoder: ctc_beam_search

metrics_type: cer

num_epoch: 65

optimizer: {'learning_rate': '5e-5', 'gamma': 0.93, 'clip_norm': 3.0, 'weight_decay': '1e-6'}

preprocess: {'feature_method': 'fbank', 'n_mels': 80, 'n_mfcc': 40, 'sample_rate': 16000, 'use_dB_normalization': True, 'target_dB': -20}

use_model: deepspeech2

------------------------------------------------

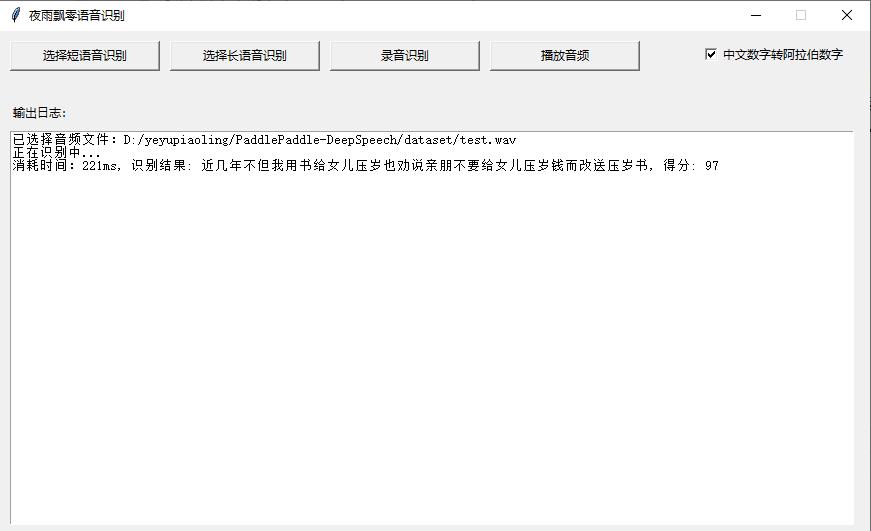

消耗时间:132, 识别结果: 近几年不但我用书给女儿儿压岁也劝说亲朋不要给女儿压岁钱而改送压岁书, 得分: 94

- 长语音预测

python infer_path.py --wav_path=./dataset/test_vad.wav --is_long_audio=True- Web部署

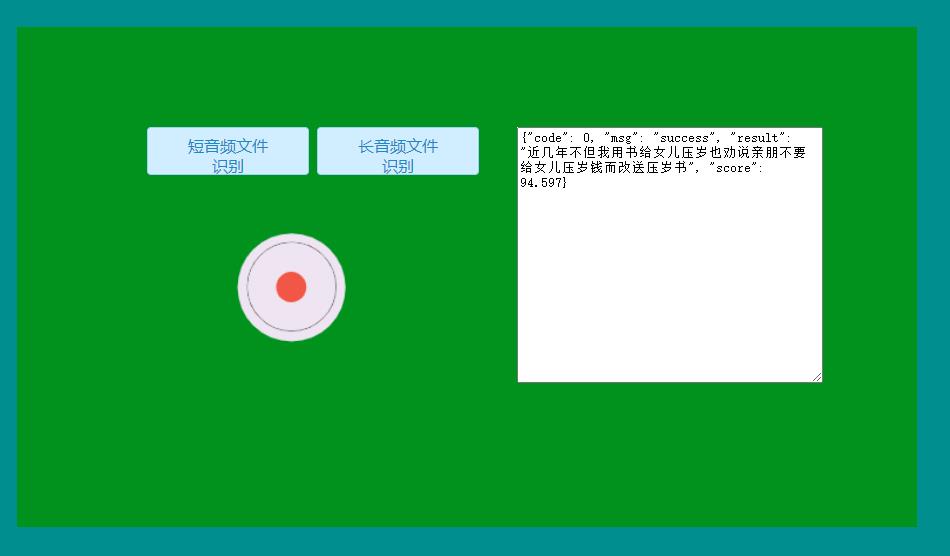

- GUI界面部署

- 基于Pytorch实现的声纹识别:VoiceprintRecognition-Pytorch

- 基于Pytorch实现的分类:AudioClassification-Pytorch

- 基于PaddlePaddle实现的语音识别:PPASR