./img

[TOC]

# 支持stream 的nginx

cd

wget http://nginx.org/download/nginx-1.16.1.tar.gz

tar -zxf nginx-1.16.1.tar.gz -C /usr/local

cd /usr/local/nginx-1.16.1

./configure --prefix=/usr/local/nginx --with-http_stub_status_module --with-http_ssl_module --with-stream

make && make install

/usr/local/nginx/sbin/nginx -v

stream {

upstream myapp{

server IP:9000;

}

server {

listen 20000;

proxy_connect_timeout 5s;

proxy_timeout 5s;

proxy_pass myapp;

}

}

/usr/local/nginx/sbin/nginx -s reloadecho -e "===prepare workspace==="

if [ ! -d "workspace" ]; then

echo "create new workspace"

mkdir workspace

fi

cd workspace

echo -e "===goto current space==="

version=$[$(ls | sort -n | tail -n 1)+1]

mkdir $version

cd $version

echo "Version: $version"

echo "Space: $(pwd)"

cp ../../Dockerfile Dockerfile

cat>core-site.xml<<EOF

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/data/hadoop</value>

</property>

</configuration>

EOF

cat>mapred-site.xml<<EOF

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>\$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:\$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

</configuration>

EOF

cat>yarn-site.xml<<EOF

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>localhost:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>localhost:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>localhost:8031</value>

</property>

</configuration>

EOF

cat>entrypoint.sh<<EOF

/usr/sbin/sshd

if [ ! -d "/data/hadoop" ]; then

hdfs namenode -format

fi

hdfs --daemon start datanode

hdfs --daemon start namenode

\$HADOOP_HOME/sbin/start-yarn.sh

echo "done!"

while true; do sleep 30; done;

EOF

docker build -t hadoop:$version .

docker rm -f hadoop || true

docker run -idt --rm \

-p 9870:9870 \

-p 8088:8088 \

-v /data/hadoop:/data \

--name hadoop \

hadoop:$version

docker logs hadoop -fFROM centos:centos8

# install ssh

RUN \

yum install openssh-server openssh-clients passwd -y; \

sed -i "s/^UsePAM yes/UsePAM no/g" /etc/ssh/sshd_config; \

echo 123456 | passwd root --stdin; \

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa; \

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys; \

chmod 0600 ~/.ssh/authorized_keys; \

ssh-keygen -q -N "" -t rsa -f /etc/ssh/ssh_host_rsa_key; \

ssh-keygen -q -N "" -t ecdsa -f /etc/ssh/ssh_host_ecdsa_key; \

ssh-keygen -q -N "" -t ed25519 -f /etc/ssh/ssh_host_ed25519_key;

# install java

RUN \

yum install wget -y; \

wget https://download.java.net/java/early_access/jdk16/27/GPL/openjdk-16-ea+27_linux-x64_bin.tar.gz ;\

tar -zxf openjdk-16-ea+27_linux-x64_bin.tar.gz -C /usr/local/;

# env java

ENV JAVA_HOME /usr/local/jdk-16

ENV PATH $PATH:$JAVA_HOME/bin

# install hadoop

RUN \

yum install wget -y; \

wget https://mirror.bit.edu.cn/apache/hadoop/common/hadoop-3.3.0/hadoop-3.3.0.tar.gz; \

tar -zxf hadoop-3.3.0.tar.gz -C /usr/local/;

# env hadoop

ENV HADOOP_MAPRED_HOME /usr/local/hadoop-3.3.0

ENV HADOOP_HOME /usr/local/hadoop-3.3.0

ENV PATH $PATH:$HADOOP_HOME/bin

ENV HDFS_NAMENODE_USER root

ENV HDFS_DATANODE_USER root

ENV HDFS_SECONDARYNAMENODE_USER root

ENV YARN_RESOURCEMANAGER_USER root

ENV YARN_NODEMANAGER_USER root

RUN \

sed '1 iexport JAVA_HOME=/usr/local/jdk-16' \

-i $HADOOP_HOME/etc/hadoop/hadoop-env.sh; \

sed '1 iexport HADOOP_HOME=/usr/local/hadoop-3.3.0' \

-i $HADOOP_HOME/etc/hadoop/hadoop-env.sh;

COPY core-site.xml $HADOOP_HOME/etc/hadoop/core-site.xml

COPY mapred-site.xml $HADOOP_HOME/etc/hadoop/mapred-site.xml

COPY yarn-site.xml $HADOOP_HOME/etc/hadoop/yarn-site.xml

COPY entrypoint.sh /entrypoint.sh

CMD ["sh", "/entrypoint.sh"]cd .

mkdir hadoop || true

cd hadoop

cat>hadoop-deployment.yaml<<EOF

apiVersion: apps/v1

kind: Deployment

metadata:

name: hadoop-deployment

labels:

app: hadoop

spec:

replicas: 1

selector:

matchLabels:

app: hadoop

template:

metadata:

labels:

app: hadoop

spec:

containers:

- name: hadoop

image: sequenceiq/hadoop-docker:latest

command: ["/etc/bootstrap.sh"]

args: ["-d"]

ports:

- containerPort: 50070

EOF

cat>hadoop-service.yaml<<EOF

apiVersion: v1

kind: Service

metadata:

name: hadoop-service

spec:

type: NodePort

selector:

app: hadoop

ports:

- port: 50070

targetPort: 50070

nodePort: 30000

EOF

kubectl apply -f hadoop-deployment.yaml

kubectl apply -f hadoop-service.yaml- 高可靠

- 高拓展

- 高效性

- 高容错

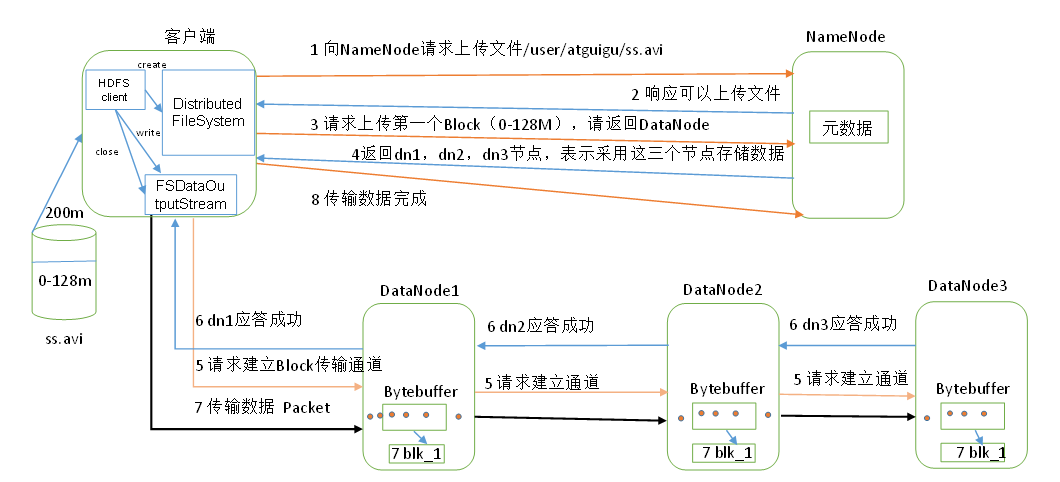

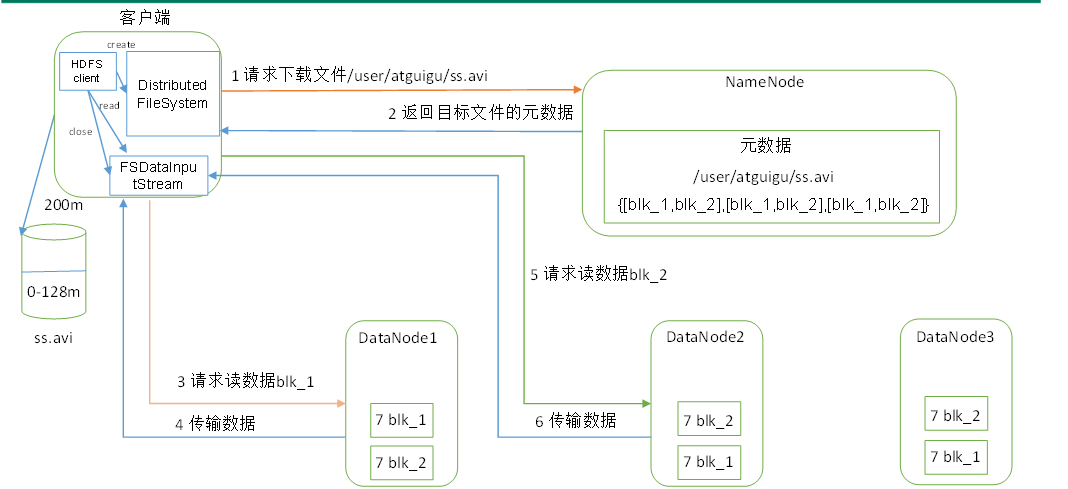

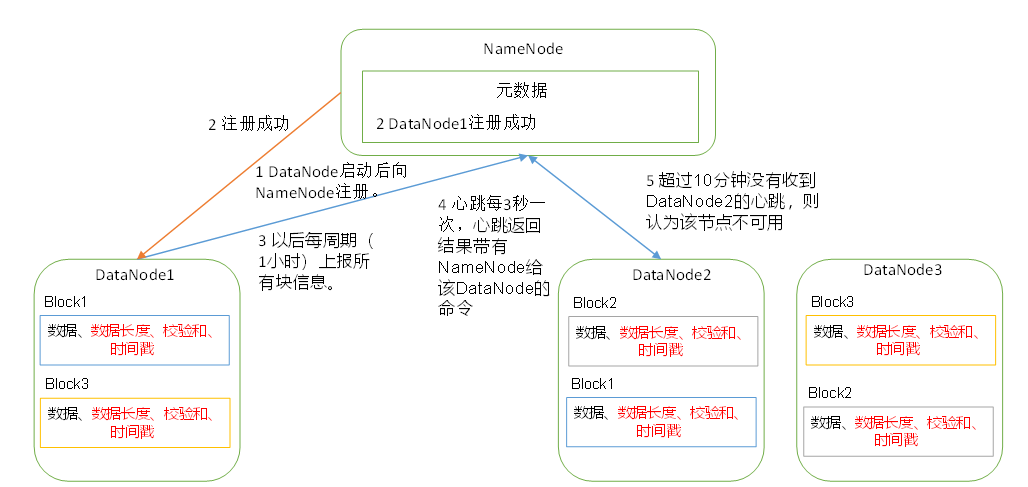

HDFS是分布式文件系统,包含NameNode, DataNode和Secondary NameNode

| 组件 | 功能 |

|---|---|

| NameNode | 储存文件的元数据 |

| DataNode | 储存文件块,校验和 |

| Secondary NameNode | 协助NameNode处理元数据 |

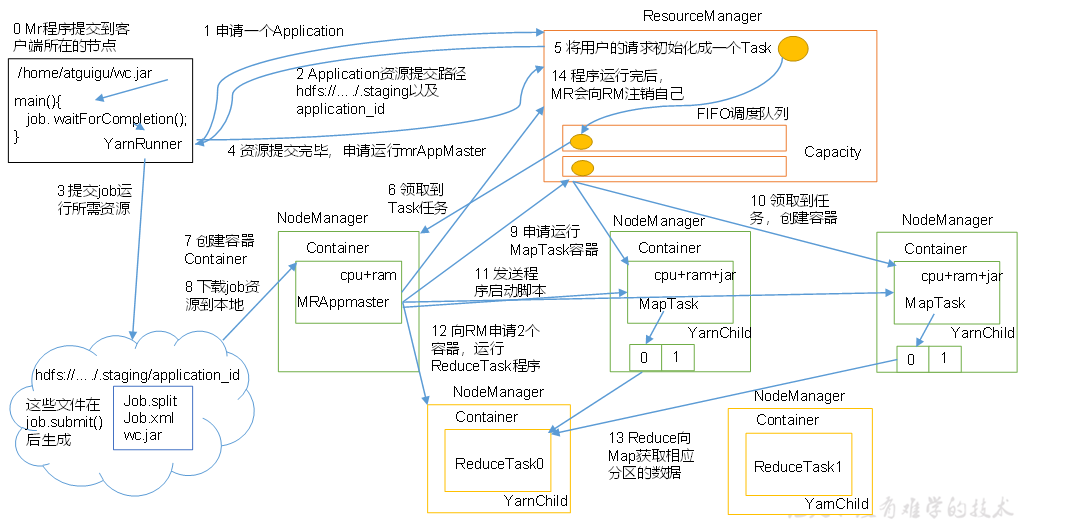

YARN是分布式资源调度器,包含了ResourceManager, NodeManager, ApplicationMaster, Container

| 组件 | 功能 |

|---|---|

| ResourceManager | 处理客户端请求,监控NodeManager, 启动ApplicationMaster, 分配和调度资源 |

| NodeManager | 管理单个节点上的资源,处理ResourceManager和ApplicationMaster的命令 |

| ApplicationMaster | 切分数据,为应用程序申请资源,并分配给任务,处理任务的监控和容错 |

| Container | 代表节点的CPU,内存,磁盘,网络 |

MapReduce是一个计算模型, Map阶段并行处理数据,Reduce阶段对Map汇总

HDFS全称为Hadoop Distributed File System,适用于一次写入,多次读出,不支持修改

文件分块存储,默认是128M,block的寻址时间一般为10ms,寻址时间为传输时间的1%的时候,达到最佳状态,机械硬盘的速率是100M/s, 所以文件分块的大小为100M 较佳,近似到128M. $$ 10ms / 1% \to 1s\ 1s / 100MB/s \to 100MB \ 100MB \to 128MB $$

block太小增加寻址时间,太大会导致数据传输的时间过长,所以block的大小取决于磁盘的传输速率

https://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-common/FileSystemShell.html

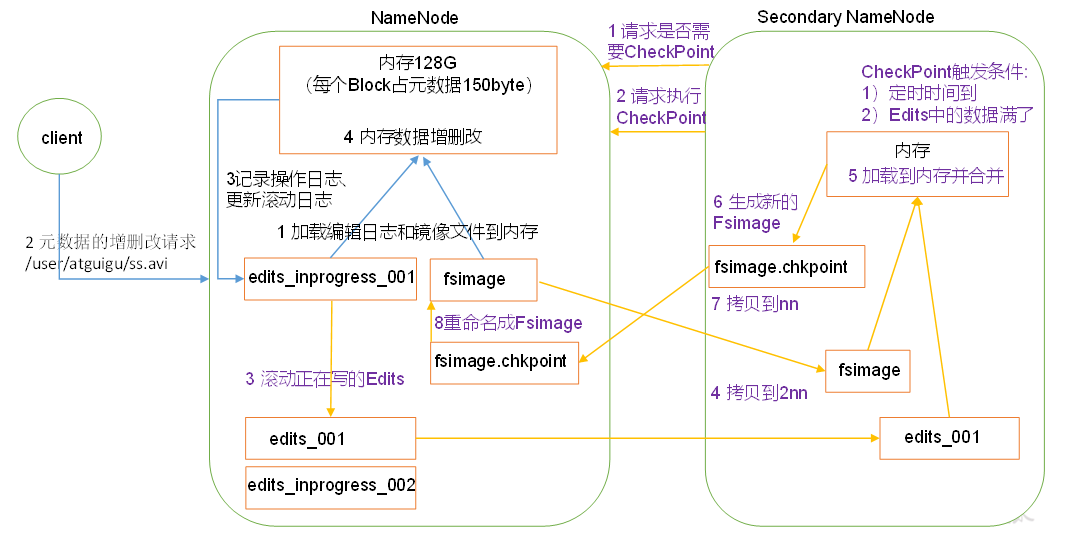

NameNode将内存数据持久化到磁盘中,分为fsimage和edits两个文件,fsimage是老的内存镜像,edits是追加格式的日志,表示着内存的变化情况,随着NameNode工作,edits会越来越大,这时候SecondaryNameNode会协助NameNode将edits与fsimage合并为新的fsimage。 注意下图紫色部分的流程即可

当NameNode不是第一次启动的时候,会加载Fsimage,并执行Edits日志,最后合并,此后开始监听DataNode请求,这个过程中NameNode一直是安全模式,文件系统处于只读状态,如果满足最小副本数,NameNode会在30秒后退出安全模式

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///xxx,file:///xxx</value>

</property>当我们配置了多个目录以后, NameNode的数据会同时存储在这些目录中,这些目录中的内容是一样的,如果一个目录损坏,NameNode会通过另一个目录恢复

超时时间是2 * dfs.namenode.heartbeat.recheck-interval + 10 * dfs.hertbeat.interval

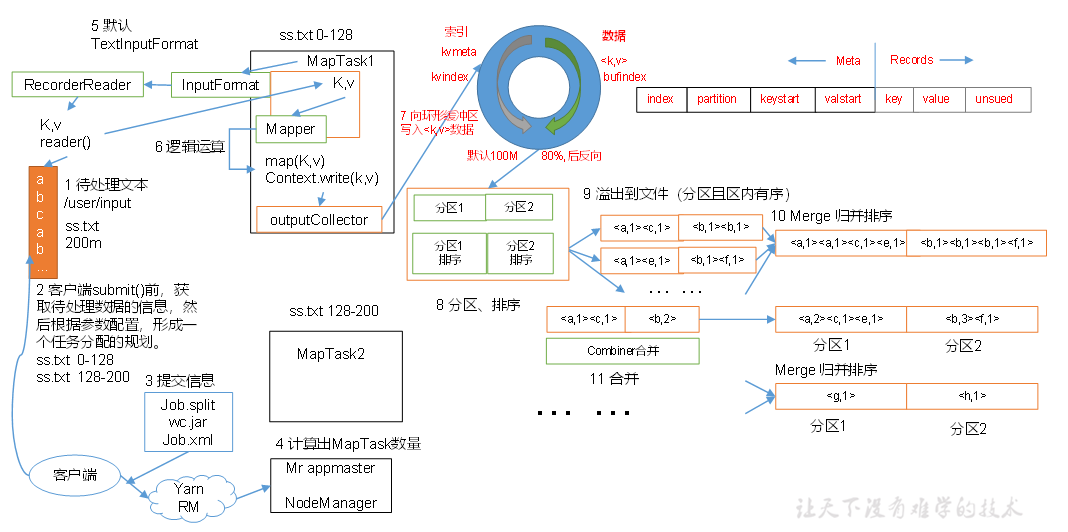

(input) <k1, v1> -> map -> <k2, v2> -> combine -> <k2, v2> -> reduce -> <k3, v3> (output)

InputFormat是执行MapReduce的第一步,他主要用于在从HDFS文件系统输入到MapTask的过程

| 名词 | 解释 |

|---|---|

| 数据块 | Block是HDFS物理上把数据分成的多块 |

| 数据切片 | Split是逻辑上对数据的分片,每个Split由一个MapTask处理 |

| 切片方法 | 备注 |

|---|---|

| TextInputFormat | 按照大小切片,kv分别是行偏移量和行的具体数据 |

| KeyValueTextInputFormat | 按照大小切片,kv是每一行由分隔符分割的左右两部分 |

| NLineInputFormat | 按照行数切片,kv分别是行偏移量和行的具体数据 |

| CombineTextInputFormat | 按照大小拆分大文件,合并小文件,kv分别是行偏移量和行的具体数据 |

当经过了InputFormat以后,数据就进入到了Map阶段,

在这个阶段,Map框架会对每一对KV进行并行处理,并输出为新的KV,

把新的KV写入环形缓冲区,一端写索引,另一端写数据,

直到环形缓冲区达到80%(80MB),Map框架将缓冲区数据排序并写入磁盘文件进行分区

直到文件数量达到一定上限,Map框架将文件排序合并,并进行分区

Map后,需要将数据写入不同的分区,

-

ReduceTask数大于分区数,则最后几个Reduce为空

-

ReduceTask小于分区数大于1,则异常

-

ReduceTask=1,则只有一个输出文件

默认的分区是HashPartitioner

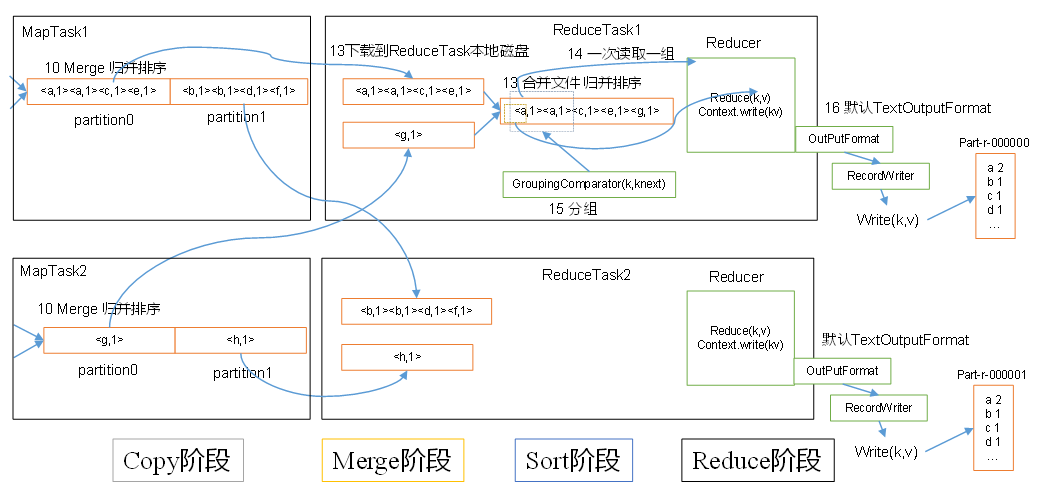

MapReduce两个阶段都会进行排序,不管实际是否需要

- Map: 环形缓冲区 -> 达到80% -> 快排 -> 写入文件 -> Map完成 -> 所有文件归并排序

- Reduce: 远程拷贝文件到内存-> 达到内存阈值-> 写入一个磁盘文件-> 磁盘文件个数达到阈值-> 合并文件 -> 拷贝完成-> 所有数据(磁盘+内存)归并排序

- 部分排序: 输出是多个文件,保证每个文件有序

- 全排序: 输出是一个文件,保证这个文件有序

- 辅助排序:

- 二次排序: 排序中有两个判断条件

实现WriteableCompable接口即可

Combiner就是一个局部的Reduce,他不一定必要,并不通用于所有的MR程序,比如求平均值,但是在局部Reduce不影响全局Reduce的情况下它可以降低网络传输压力

job.setCombinerClass(IntSumReducer.class);往往我们称Map之后,Reduce之前的操作为Shuffle

| OUTPUTFORMAT | 描述 |

|---|---|

| TextOutputFormat | 把结果写成文本行 |

| SequenceFileOutputFormat | 写成二进制文件 |

在Reduce端Join: 用同一个key即可

在Map端Join: 用字典手动Join

支持gzip,bzip,Lzo等压缩方式,可以用于输入文件的解压缩,输出文件的压缩,mapreduce中间文件的压缩

Map端压缩

configuration.setBoolean("mapreduce.map.output.compress",true);

configuration.setClass("mapreduce.map.output.compress.codec",

BZip2Codec.class, CompressionCodec.class)Reduce压缩

FileOutputFormat.setCompressOutput(job,true);

FileOutputormat.setOutputCompressorClass(job,GzipCodec.class);计算机性能: CPU、内存、磁盘、网络

IO: 数据倾斜,小文件多,不可分块的超大文件多,spill次数多,merge次数多

- 输入阶段:合并小文件

- Maper阶段:调整环形缓冲区大小和溢写比例

- Maper阶段:调整合并文件的文件个数阈值

- Maper阶段:使用Combiner

- Reduce阶段:合理设置Map Reduce个数

- Reduce阶段:调整slowstart.completedmaps,提前申请Reduce资源

- Reduce阶段:MapTask机器文件 -> ReduceTask机器Buffer -> 磁盘 -> Reduce, 调整Buffer,让Buffer中保留一定的数据,直接传给Reduce

- 压缩数据

- 开启JVM重用

- FIFIO调度器: 先进先出

- 容量调度器(默认):支持多个队列,每个队列 有一定的资源,各自采用FIFO,对同一个用户的作业所占资源进行限制,安装任务和资源比例分配新的任务,按照任务优先级、提交时间、用户的资源限制、内存限制对队列中的任务排序

- 公平调度器(并发度非常高): 多个队列,每个队列中的job可以并发运行,可以每个job都有资源,哪个job还缺的资源最多,就给哪个job分配资源

当前Job已完成的Task达到5%, 且某任务执行较慢,则开始备份任务 $$ 当前任务完成时刻 = 当前时刻 +(当前时刻 - 任务开始时刻)/ 任务运行进度\ 备份任务完成时刻 = 当前时刻 + 所有任务平均花费时间 $$ 每个任务最多一个备份任务,每个作业也有备份任务上限

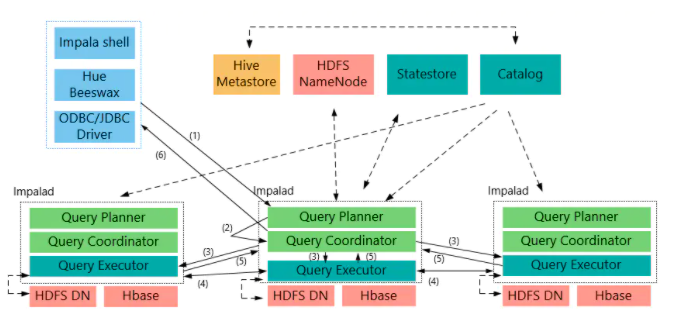

impala提供对HDFS、Hbase数据的高性能、低延迟的交互式SQL查询功能。基于Hive使用内存计算,兼顾数据仓库、具有实时、批处理、多并发等优点。

-

基于内存计算

-

不使用MR

-

C++编写计算层,Java编写编译层

-

兼容大部分HiveSQL

-

支持数据本地计算

-

可以使用Impala JDBC访问

- 对内存依赖很大

- 完全依赖Hive

- 只能读取文本文件,不能读取二进制文件

- 在Impala更新的数据会同步到Hive,但是在Hive更新的数据不会自动同步到Impala

- Impala不支持事务和索引

- Impala可以管理PB级数据,但是关系型数据库只能管理TB

- 使用HDFS,HBase储存数据

- 使用相同的元数据

- 使用类似的SQL词法分析生成执行计划

- Impala生成执行计划树,Hive会生成MR模型

- Impala使用拉的方式,后续节点主动拉取前面节点的数据,是流, Hive使用推的方式,前面的节点执行完成后会将数据主动推送给后面的节点

Impala集群有三个重要的组件,他们分别是Impala Daemon, Impala Statestore和Impala Metastore

Impala Daemon(Impalad)在安装Impala的每个节点上运行, 接受来着各种接口的查询,当一个查询提交到某个Impala Daemon的时候,这个节点就充当协调器,将任务分发到集群

Impala State负责检测每个Impalad的运行状况,如果某个Impala Daemon发生了故障,则这个消息会被通知到所有其他Impla Daemon

Impala Matestore储存表的元数据信息

-

时间函数【时间差】

datediff(now(),to_timestamp(strleft(ftime,10), 'yyyy-MM-dd')) <= 7 -

字符串求和

sum(cast(time as bigint))

https://www.elastic.co/guide/en/elasticsearch/reference/current/elasticsearch-intro.html

docker run -d \

--name elasticsearch \

-p 9200:9200 \

-p 9300:9300 \

-e "discovery.type=single-node" \

elasticsearch:7.10.1; \

docker run -d \

--link elasticsearch:elasticsearch \

-p 5601:5601 \

kibana:7.10.1echo -e "===prepare workspace==="

if [ ! -d "workspace" ]; then

echo "create new workspace"

mkdir workspace

fi

cd workspace

echo -e "===goto current space==="

version=$[$(ls | sort -n | tail -n 1)+1]

mkdir $version

cd $version

echo "Version: $version"

echo "Space: $(pwd)"

echo -e "===deploy to k8s==="

mkdir deploy

cd deploy

cat>elasticsearch-deployment.yaml<<EOF

apiVersion: apps/v1

kind: Deployment

metadata:

name: elasticsearch-deployment

labels:

app: elasticsearch

spec:

replicas: 1

selector:

matchLabels:

app: elasticsearch

template:

metadata:

labels:

app: elasticsearch

spec:

containers:

- name: elasticsearch

image: elasticsearch:7.5.1

imagePullPolicy: IfNotPresent

env:

- name: "discovery.type"

value: "single-node"

ports:

- containerPort: 9200

- containerPort: 9300

resources:

limits:

cpu: 0.3

memory: 2000Mi

requests:

cpu: 0.3

memory: 300Mi

# livenessProbe:

# httpGet:

# path: /

# port: 9200

# initialDelaySeconds: 10

# periodSeconds: 3

- name: kibana

image: kibana:7.5.1

imagePullPolicy: IfNotPresent

env:

- name: "ELASTICSEARCH_HOSTS"

value: "http://127.0.0.1:9200"

ports:

- containerPort: 5601

resources:

limits:

cpu: 0.3

memory: 1000Mi

requests:

cpu: 0.3

memory: 300Mi

#livenessProbe:

# httpGet:

# port: 5601

# initialDelaySeconds: 10

# periodSeconds: 3

EOF

cat>elasticsearch-service.yaml<<EOF

apiVersion: v1

kind: Service

metadata:

name: elasticsearch-service

spec:

type: NodePort

selector:

app: elasticsearch

ports:

- port: 5601

targetPort: 5601

nodePort: 5601

name: kibana-web

- port: 9200

targetPort: 9200

nodePort: 9200

name: es-http

- port: 9300

targetPort: 9300

nodePort: 9300

name: es-tcp

EOF

kubectl apply -f elasticsearch-deployment.yaml

kubectl apply -f elasticsearch-service.yaml

cd ..curl -u 'password' IP:9200换源

https://zhuanlan.zhihu.com/p/61228593

sudo dpkg --remove --force-remove-reinstreq google-chrome-stable

apt-get install firefox这是一个16进制查看工具

# 查看帮助

xxd -h

# 查看文件前100个字节

xxd -l 100 file.bin# 必须安装passwd

yum install openssh-server openssh-clients passwd -y; \

sed -i "s/^UsePAM yes/UsePAM no/g" /etc/ssh/sshd_config; \

echo 123456 | passwd root --stdin; \

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa; \

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys; \

chmod 0600 ~/.ssh/authorized_keys; \

ssh-keygen -q -N "" -t rsa -f /etc/ssh/ssh_host_rsa_key; \

ssh-keygen -q -N "" -t ecdsa -f /etc/ssh/ssh_host_ecdsa_key; \

ssh-keygen -q -N "" -t ed25519 -f /etc/ssh/ssh_host_ed25519_key; \

/usr/sbin/sshd- Dockerfile

FROM centos:centos8

RUN yum install openssh-server openssh-clients passwd -y; \

sed -i "s/^UsePAM yes/UsePAM no/g" /etc/ssh/sshd_config; \

echo 123456 | passwd root --stdin; \

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa; \

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys; \

chmod 0600 ~/.ssh/authorized_keys; \

ssh-keygen -q -N "" -t rsa -f /etc/ssh/ssh_host_rsa_key; \

ssh-keygen -q -N "" -t ecdsa -f /etc/ssh/ssh_host_ecdsa_key; \

ssh-keygen -q -N "" -t ed25519 -f /etc/ssh/ssh_host_ed25519_key;

EXPOSE 22

CMD ["/usr/sbin/sshd", "-D"]- Build

docker build -t sshd:centos8 .- Run

docker run -itd -p 2222:22 sshd:centos8- Connect

ssh localhost -p 2222ssh root@9.135.10.2 -p 36000 -P

xxxxdocker run -it --rm \

-v ${HOME}:/root \

-v $(pwd):/git \

alpine/git \

clone https://github.com/alpine-docker/git.gitwget https://github.com/git/git/archive/v2.29.2.tar.gz; \

tar -zxf v2.29.2.tar.gz; \

rm v2.29.2.tar.gz; \

cd /git-2.29.2; \

yum install -y curl-devel expat-devel gettext-devel \

openssl-devel zlib-devel gcc perl-ExtUtils-MakeMaker; \

make prefix=/usr/local/git all; \

make prefix=/usr/local/git install; \

echo "GIT_HOME=/usr/local/git" >> ~/.bashrc; \

echo "PATH=\$GIT_HOME/bin:\$PATH" >> ~/.bashrc; \

source ~/.bashrc; \

git --version;

修改Git默认编辑器

git config --global core.editor "vim"feat:新功能(feature)

fix:修补bug

docs:文档(documentation)

style: 格式(不影响代码运行的变动)

refactor:重构(即不是新增功能,也不是修改bug的代码变动)

test:增加测试

chore:构建过程或辅助工具的变动git push origin --tags

git clone https://github.com/VundleVim/Vundle.vim.git ~/.vim/bundle/Vundle.vim

echo >~/.vimrc<<EOF

" Vundle set nocompatible

filetype off

set rtp+=~/.vim/bundle/Vundle.vim

call vundle#begin()

Plugin 'VundleVim/Vundle.vim'

Plugin 'The-NERD-Tree'

Plugin 'gdbmgr'

Plugin 'mbbill/undotree'

Plugin 'majutsushi/tagbar'

Plugin 'vim-airline/vim-airline' " 状态栏

Plugin 'vim-airline/vim-airline-themes' "状态栏

Plugin 'cohlin/vim-colorschemes' " 主题

Plugin 'tomasr/molokai' " molokai

Plugin 'jiangmiao/auto-pairs' " 括号补全

Plugin 'plasticboy/vim-markdown'

Plugin 'iamcco/mathjax-support-for-mkdp' " 数学公式

Plugin 'iamcco/markdown-preview.vim' " markdown预览

"Plugin 'Valloric/YouCompleteMe'

"Plugin 'zxqfl/tabnine-vim'

Plugin 'w0rp/ale' " 语法纠错

Plugin 'octol/vim-cpp-enhanced-highlight' " c++语法高亮

Plugin 'Shougo/echodoc.vim' " c++函数提示

Plugin 'Chiel92/vim-autoformat' " c++代码格式化

Plugin 'scrooloose/nerdcommenter' " c++代码注释

Plugin 'ashfinal/vim-colors-violet' " 配色

Plugin 'terryma/vim-multiple-cursors' " vim 多行编辑

Plugin 'mhinz/vim-startify'

call vundle#end()

filetype plugin indent on

set et "tab用空格替换

set tabstop=2

set expandtab

" Tab键的宽度

set softtabstop=2

set shiftwidth=2

" 统一缩进为2

set number

" 显示行号

set history=10000

" 历史纪录数

set hlsearch

set incsearch

" 搜索逐字符高亮

set encoding=utf-8

set fileencodings=utf-8,ucs-bom,shift-jis,gb18030,gbk,gb2312,cp936,utf-16,big5,euc-jp,latin1

" 编码设置

" set mouse=a

" use mouse

set langmenu=zn_CN.UTF-8

set helplang=cn

" 语言设置

set laststatus=2

" 总是显示状态行 就是那些显示 --insert-- 的怪东西

set showcmd

" 在状态行显示目前所执行的命令,未完成的指令片段亦会显示出来

set scrolloff=3

" 光标移动到buffer的顶部和底部时保持3行距离

set showmatch

" 高亮显示对应的括号

set matchtime=1

" 对应括号高亮的时间(单位是十分之一秒)

colorscheme molokai

EOF

vim +PluginInstall +qall/etc/sysconfig/network-scripts/*nmcli c reload

nmcli c up ens32show create table table_name;date_add(date(imp_date), interval 1 week)cat>/etc/docker/daemon.json<<EOF

{

"registry-mirrors": [

"https://dockerhub.woa.com",

"http://docker.oa.com:8080"

],

"insecure-registries" : [

"hub.oa.com",

"docker.oa.com:8080",

"bk.artifactory.oa.com:8080"

],

"exec-opts":["native.cgroupdriver=systemd"]

}

EOF--cpus 0.8

-m 800m

-v /root/.m2:/root/.m2

kubeadm init --pod-network-cidr=10.244.0.0/16

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

kubectl taint nodes --all node-role.kubernetes.io/master-

vim /etc/kubernetes/manifests/kube-apiserver.yaml

#- --service-node-port-range=1000-32000export KUBECONFIG=/etc/kubernetes/admin.conf

sudo kubectl get podscurl -L https://github.com/kubernetes-sigs/metrics-server/releases/download/v0.3.6/components.yaml \

| sed -s 's/k8s.gcr.io/registry.cn-hangzhou.aliyuncs.com\/google_containers/g' \

| kubectl apply -f -# echo "serverTLSBootstrap: true" >> /var/lib/kubelet/config.yaml

systemctl daemon-reload

systemctl restart kubelet.service

kubectl get csr

kubectl certificate approve xxx ???echo "===prepare workspace==="

if [ ! -d "workspace" ]; then

echo "create new workspace"

mkdir workspace

fi

cd workspace

echo "===goto current space==="

version=$[$(ls | sort -n | tail -n 1)+1]

mkdir $version

cd $version

echo "Version: $version"

echo "Space: $(pwd)"

echo "===deploy to k8s==="

mkdir deploy

cd deploy

cat>limitRange.yaml<<EOF

apiVersion: v1

kind: LimitRange

metadata:

name: cpu-min-max-demo-lr

spec:

limits:

- max:

cpu: "800m"

min:

cpu: "200m"

type: Container

EOF

kubectl apply -f limitRange.yaml

cd ..systemctl status kubelet -n 1000

free -m # 看看swap分区是否被打开

swapoff -a

systemctl daemon-reload

systemctl restart kubelet

hostname -f

hostname xxxxxxxkubeadm reset

rm -rf /etc/kubernetes

rm -rf /var/lib/etcd/echo -e "===prepare workspace==="

if [ ! -d "workspace" ]; then

echo "create new workspace"

mkdir workspace

fi

cd workspace

echo -e "===goto current space==="

version=$[$(ls | sort -n | tail -n 1)+1]

mkdir $version

cd $version

echo "Version: $version"

echo "Space: $(pwd)"

echo -e "===set parmas==="

gitPath=xxxx

girBranch=xxxx

# mavenMirror=https://maven.aliyun.com/repository/public

mavenMirror=xxxx

mavenCacheVolume=maven-repo

# mavenImage=maven:3.6.3-openjdk-16

mavenImage=maven:3.6.3-jdk-8

mavenPackageTarget=xxx-start/target/*.jar

# jdkImage=openjdk:16-jdk

jdkImage=openjdk:8-jdk

javaApp=xxxx

echo -e "===get code==="

docker run -i --rm \

-v ${HOME}:/root \

-v $(pwd)/src:/git \

alpine/git \

clone $gitPath .

pwd

echo $girBranch

docker run -i --rm \

-v ${HOME}:/root \

-v $(pwd)/src:/git \

alpine/git \

checkout $girBranch

echo -e "===build target==="

mkdir .m2

cat>.m2/settings.xml<<EOF

<settings>

<mirrors>

<mirror>

<id>proxy</id>

<mirrorOf>central</mirrorOf>

<name>proxy maven</name>

<url>$mavenMirror</url>

</mirror>

</mirrors>

</settings>

EOF

docker volume create --name $mavenCacheVolume

docker run -i --rm \

-v $(pwd)/src:/usr/src/mymaven \

-v $mavenCacheVolume:/root/.m2/repository \

-v $(pwd)/.m2/settings.xml:/root/.m2/settings.xml \

-w /usr/src/mymaven \

$mavenImage \

mvn package -Dmaven.test.skip=true

echo -e "===move jar==="

mkdir image

mv src/$mavenPackageTarget image/main.jar

echo -e "===build image==="

cd image

cat>Dockerfile<<EOF

FROM $jdkImage

COPY main.jar /main.jar

COPY entrypoint.sh /entrypoint.sh

CMD ["sh","entrypoint.sh"]

EOF

cat>entrypoint.sh<<EOF

java -jar -Xmx250m -Xms200m -Dserver.port=80 /main.jar --logger.print-parmas.enable=true

EOF

docker build -t $javaApp:$version .

cd ..

echo -e "===deploy to k8s==="

mkdir deploy

cd deploy

cat>${javaApp}-deployment.yaml<<EOF

apiVersion: apps/v1

kind: Deployment

metadata:

name: ${javaApp}-deployment

labels:

app: $javaApp

spec:

replicas: 1

selector:

matchLabels:

app: $javaApp

template:

metadata:

labels:

app: $javaApp

spec:

containers:

- name: $javaApp

image: $javaApp:$version

imagePullPolicy: IfNotPresent

env:

- name: ENV

value: "env"

ports:

- containerPort: 80

resources:

limits:

cpu: 0.3

memory: 400Mi

requests:

cpu: 0.3

memory: 300Mi

livenessProbe:

httpGet:

path: /swagger-ui/

port: 80

initialDelaySeconds: 100

periodSeconds: 3

strategy: # 策略

type: RollingUpdate # 也可以是Recreate

rollingUpdate:

maxUnavailable: 50% # 滚动更新的时候的最大不可用pod数量, 可以是绝对数字或者比例10%

maxSurge: 50% # 动更新的时候的溢出的pod数量,也可以是绝对数字

progressDeadlineSeconds: 150 # 进度期限秒数,不懂是什么

minReadySeconds: 100 # 最短就绪时间, 容器创建多久以后被视为就绪

revisionHistoryLimit: 3 # 历史修订限制, 保留的rs的数量,这个数量会消耗etcd资源,rs删除了就不能回滚刀那个版本的Deployment了

EOF

cat>${javaApp}-service.yaml<<EOF

apiVersion: v1

kind: Service

metadata:

name: ${javaApp}-service

spec:

type: NodePort

selector:

app: $javaApp

ports:

- port: 80

targetPort: 80

nodePort: 10010

EOF

kubectl apply -f ${javaApp}-deployment.yaml

kubectl apply -f ${javaApp}-service.yaml

cd ..修改文件.idea/workspace.xml

<component name="PropertiesComponent">

<property name="dynamic.classpath" value="true" /> # https://varaneckas.com/jad/

wget https://varaneckas.com/jad/jad158e.linux.static.zip; \

unzip jad158e.linux.static.zip

jad xxx.class

cat xxx.jad-ea

-Dhttp.proxyPort=12639

-Dhttp.proxyHost=127.0.0.1

-Dhttps.proxyPort=12639

-Dhttps.proxyHost=127.0.0.1

-Xmx400m # JVM最大内存

-Xms300m # JVM初始内存

-Xmn200m # 年轻代内存

-Xss128k # 线程堆栈--server.port=80

--jasypt.encryptor.password=xxx

--spring.profiles.active=development

docker run -it --rm \

-v "$(pwd)":/usr/src/mymaven \

-w /usr/src/mymaven \

maven:3.3-jdk-8 \

mvn clean install# 发布

mvn clean javadoc:jar source:jar deploy@Import(XxxServiceImpl.class)

@RunWith(SpringJUnit4ClassRunner.class)

@SpringBootTest(classes = TestRunner.class)

public class ScriptBizServiceTest {

@Autowired

XxxService xxxService;

@MockBean

XxxService xxxService;

} <dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<scope>test</scope>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

<scope>test</scope>

</dependency><plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-source-plugin</artifactId>

<version>3.0.1</version>

<configuration>

<attach>true</attach>

</configuration>

<executions>

<execution>

<phase>compile</phase>

<goals>

<goal>jar</goal>

</goals>

</execution>

</executions>

</plugin>https://maven.apache.org/guides/mini/guide-multiple-repositories.html

Remote repository URLs are queried in the following order for artifacts until one returns a valid result:

- Global

settings.xml - User

settings.xml - Local POM

- Parent POMs, recursively

- Super POM

For each of these locations, the repositories within the profiles are queried first in the order outlined at Introduction to build profiles.

RateLimiter rateLimiter = RateLimiter.create(10);

for (int i = 0; i < 20; i++) {

int finalI = i;

new Thread(new Runnable() {

@Override

public void run() {

int cnt = 0;

while (true) {

if (rateLimiter.tryAcquire()) {

cnt++;

System.out.println("thread: " + finalI + " cnt: " + cnt);

}

}

}

}).start();

}

Thread.sleep(1000 * 100 * 1000);源码流程图:

这个ResultHandler是最常用的一个,我们可以看到他在containingClass被ResponseBody标记或者方法被ResponseBody标记时生效

@Override

public boolean supports(HandlerResult result) {

MethodParameter returnType = result.getReturnTypeSource();

Class<?> containingClass = returnType.getContainingClass();

return (AnnotatedElementUtils.hasAnnotation(containingClass, ResponseBody.class) ||

returnType.hasMethodAnnotation(ResponseBody.class));

}

@Override

public Mono<Void> handleResult(ServerWebExchange exchange, HandlerResult result) {

Object body = result.getReturnValue();

MethodParameter bodyTypeParameter = result.getReturnTypeSource();

return writeBody(body, bodyTypeParameter, exchange);

}ViewResolutionResultHandler支持的attributes比较多,它可以解析CharSequence,Rendering,Model,Map,View等

@Override

public boolean supports(HandlerResult result) {

if (hasModelAnnotation(result.getReturnTypeSource())) {

return true;

}

Class<?> type = result.getReturnType().toClass();

ReactiveAdapter adapter = getAdapter(result);

if (adapter != null) {

if (adapter.isNoValue()) {

return true;

}

type = result.getReturnType().getGeneric().toClass();

}

return (CharSequence.class.isAssignableFrom(type) ||

Rendering.class.isAssignableFrom(type) ||

Model.class.isAssignableFrom(type) ||

Map.class.isAssignableFrom(type) ||

View.class.isAssignableFrom(type) ||

!BeanUtils.isSimpleProperty(type));

}ServerResponseResultHandler只处理返回值为ServerResponse类型的Response,并使用内置的messageWriters和视图解析器来处理他们

@Override

public void afterPropertiesSet() throws Exception {

if (CollectionUtils.isEmpty(this.messageWriters)) {

throw new IllegalArgumentException("Property 'messageWriters' is required");

}

}

@Override

public boolean supports(HandlerResult result) {

return (result.getReturnValue() instanceof ServerResponse);

}

@Override

public Mono<Void> handleResult(ServerWebExchange exchange, HandlerResult result) {

ServerResponse response = (ServerResponse) result.getReturnValue();

Assert.state(response != null, "No ServerResponse");

return response.writeTo(exchange, new ServerResponse.Context() {

@Override

public List<HttpMessageWriter<?>> messageWriters() {

return messageWriters;

}

@Override

public List<ViewResolver> viewResolvers() {

return viewResolvers;

}

});

}git clone https://github.com/spring-projects/spring-boot.git

git config core.longPaths truebeanNameAware可以获得容器中Bean的名称,作用于每一个Bean。当bean被创建的时候设置他的名字,在基本properties填充完成以后,init调用前执行

摘自: spring-beans:5.3.4 org.springframework.beans.factory.BeanNameAware

Set the name of the bean in the bean factory that created this bean.

Invoked after population of normal bean properties but before an init callback such as {@link InitializingBean#afterPropertiesSet()} or a custom init-method.

package com.example.demo;

import org.springframework.beans.factory.BeanNameAware;

import org.springframework.stereotype.Component;

@Component

public class BeanNameAwareDemo implements BeanNameAware {

@Override

public void setBeanName(String name) {

System.out.println(name);

}

}输出:

beanNameAwareDemo注入beanFactory

package com.example.demo;

import org.springframework.beans.BeansException;

import org.springframework.beans.factory.BeanFactory;

import org.springframework.beans.factory.BeanFactoryAware;

import org.springframework.stereotype.Component;

@Component

public class BeanFactoryAwareDemo implements BeanFactoryAware {

@Override

public void setBeanFactory(BeanFactory beanFactory) throws BeansException {

System.out.println(beanFactory);

}

}类比beanFactory

package com.example.demo;

import org.springframework.beans.BeansException;

import org.springframework.context.ApplicationContext;

import org.springframework.context.ApplicationContextAware;

import org.springframework.stereotype.Component;

@Component

public class ApplicationContextAwareDemo implements ApplicationContextAware {

@Override

public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

System.out.println(applicationContext);

}

}这是使用国际化用到的

package com.example.demo;

import java.util.Locale;

import lombok.extern.slf4j.Slf4j;

import org.springframework.context.MessageSource;

import org.springframework.context.MessageSourceAware;

import org.springframework.stereotype.Component;

@Slf4j

@Component

public class MessageSourceAwareDemo implements MessageSourceAware {

@Override

public void setMessageSource(MessageSource messageSource) {

String hello = messageSource.getMessage("hello", null, Locale.CHINA);

log.info(hello);

}

}2021-03-05 13:36:38.263 INFO 17836 --- [ main] com.example.demo.MessageSourceAwareDemo : 你好呀小老弟用于发布事件

package com.example.demo;

import org.springframework.context.ApplicationEventPublisher;

import org.springframework.context.ApplicationEventPublisherAware;

import org.springframework.stereotype.Component;

@Component

public class ApplicationEventPublisherAwareDemo implements ApplicationEventPublisherAware {

@Override

public void setApplicationEventPublisher(ApplicationEventPublisher applicationEventPublisher) {

applicationEventPublisher.publishEvent("hi");

}

}用于获取静态文件内容

package com.example.demo;

import java.io.IOException;

import java.io.InputStream;

import lombok.extern.slf4j.Slf4j;

import org.apache.commons.io.IOUtils;

import org.springframework.context.ResourceLoaderAware;

import org.springframework.core.io.ResourceLoader;

import org.springframework.stereotype.Component;

@Slf4j

@Component

public class ResourceLoaderAwareDemo implements ResourceLoaderAware {

@Override

public void setResourceLoader(ResourceLoader resourceLoader) {

try {

InputStream inputStream =

resourceLoader.getResource("classpath:/messages_zh_CN.properties").getInputStream();

IOUtils.readLines(inputStream).forEach(log::info);

} catch (IOException ioException) {

log.error("", ioException);

}

}

}2021-03-05 13:56:08.067 INFO 17700 --- [ main] com.example.demo.MessageSourceAwareDemo : 你好呀小老弟@ConfigurationProperties 不能缺少下面这个依赖,否则不会自动处理配置的提示

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-configuration-processor</artifactId>

<optional>true</optional>

<scope>compile</scope>

</dependency>import com.fasterxml.jackson.databind.DeserializationFeature;

import com.fasterxml.jackson.databind.ObjectMapper;

import feign.codec.Decoder;

import feign.codec.Encoder;

import java.util.Arrays;

import lombok.extern.slf4j.Slf4j;

import org.springframework.beans.factory.ObjectFactory;

import org.springframework.boot.autoconfigure.http.HttpMessageConverters;

import org.springframework.cloud.openfeign.support.ResponseEntityDecoder;

import org.springframework.cloud.openfeign.support.SpringDecoder;

import org.springframework.cloud.openfeign.support.SpringEncoder;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.http.MediaType;

import org.springframework.http.converter.HttpMessageConverter;

import org.springframework.http.converter.json.MappingJackson2HttpMessageConverter;

@Slf4j

@Configuration

public class CustomFeignConfig {

@Bean

public Decoder feignDecoder() {

MappingJackson2HttpMessageConverter jacksonConverter =

new MappingJackson2HttpMessageConverter(customObjectMapper());

jacksonConverter.setSupportedMediaTypes(Arrays.asList(

MediaType.ALL

));

ObjectFactory<HttpMessageConverters> objectFactory =

() -> new HttpMessageConverters(jacksonConverter);

return new ResponseEntityDecoder(new SpringDecoder(objectFactory));

}

@Bean

public Encoder feignEncoder() {

MappingJackson2HttpMessageConverter jacksonConverter =

new MappingJackson2HttpMessageConverter(customObjectMapper());

jacksonConverter.setSupportedMediaTypes(Arrays.asList(

MediaType.ALL

));

ObjectFactory<HttpMessageConverters> objectFactory =

() -> new HttpMessageConverters(jacksonConverter);

return new SpringEncoder(objectFactory);

}

public ObjectMapper customObjectMapper() {

ObjectMapper objectMapper = new ObjectMapper();

//Customize as much as you want

objectMapper.configure(DeserializationFeature.ACCEPT_EMPTY_STRING_AS_NULL_OBJECT, true);

return objectMapper;

}

@Bean

public Logger.Level logger() {

return Logger.Level.FULL;

}

}https://cloud.tencent.com/developer/article/1465749

依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-validation</artifactId>

</dependency>使用方案

@Null 验证对象是否为null

@NotNull 验证对象是否不为null, 无法查检长度为0的字符串

@NotBlank 检查约束字符串是不是Null还有被Trim的长度是否大于0,只对字符串,且会去掉前后空格.

@NotEmpty 检查约束元素是否为NULL或者是EMPTY.

Booelan检查

@AssertTrue 验证 Boolean 对象是否为 true

@AssertFalse 验证 Boolean 对象是否为 false

长度检查

@Size(min=, max=) 验证对象(Array,Collection,Map,String)长度是否在给定的范围之内

@Length(min=, max=) Validates that the annotated string is between min and max included.

日期检查

@Past 验证 Date 和 Calendar 对象是否在当前时间之前

@Future 验证 Date 和 Calendar 对象是否在当前时间之后

@Pattern 验证 String 对象是否符合正则表达式的规则

数值检查

建议使用在Stirng,Integer类型,不建议使用在int类型上,因为表单值为“”时无法转换为int,但可以转换为Stirng为"",Integer为null

@Min 验证 Number 和 String 对象是否大等于指定的值

@Max 验证 Number 和 String 对象是否小等于指定的值

@DecimalMax 被标注的值必须不大于约束中指定的最大值. 这个约束的参数是一个通过BigDecimal定义的最大值的字符串表示.小数存在精度

@DecimalMin 被标注的值必须不小于约束中指定的最小值. 这个约束的参数是一个通过BigDecimal定义的最小值的字符串表示.小数存在精度

@Digits 验证 Number 和 String 的构成是否合法

@Digits(integer=,fraction=) 验证字符串是否是符合指定格式的数字,interger指定整数精度,fraction指定小数精度。 @Range(min=, max=) Checks whether the annotated value lies between (inclusive) the specified minimum and maximum. @Range(min=10000,max=50000,message=“range.bean.wage”) private BigDecimal wage;

@Valid 递归的对关联对象进行校验, 如果关联对象是个集合或者数组,那么对其中的元素进行递归校验,如果是一个map,则对其中的值部分进行校验.(是否进行递归验证)

@CreditCardNumber信用卡验证

@Email 验证是否是邮件地址,如果为null,不进行验证,算通过验证。

@ScriptAssert(lang= ,script=, alias=)

@URL(protocol=,host=, port=,regexp=, flags=)各个bean详细的功能详见[Spring Webflux 5.3.2](#Spring Webflux 5.3.2)

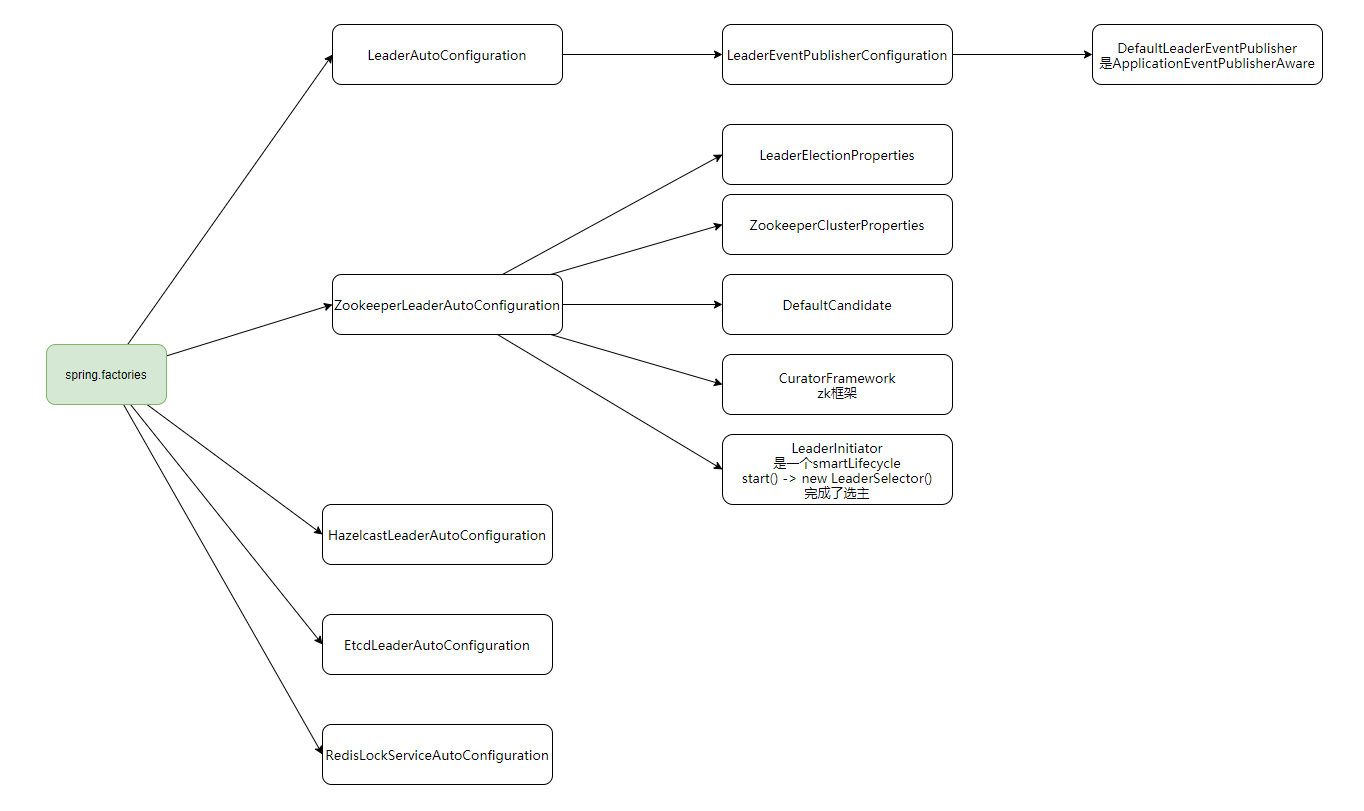

Spring Cloud Cluster提供了分布式系统中集群的特性,例如选主,集群持久化信息储存,全局锁和一次性token

以下是Spring Cloud Cluster 1.0.1的Spring Boot 自动装配流程,其中的zk模式主要用到了第三方框架CuratorFramework

package com.example.demo;

import java.util.ArrayList;

import java.util.List;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import org.springframework.cloud.gateway.event.RefreshRoutesEvent;

import org.springframework.cloud.gateway.route.RouteDefinition;

import org.springframework.cloud.gateway.route.RouteDefinitionRepository;

import org.springframework.context.ApplicationEventPublisher;

import org.springframework.context.ApplicationEventPublisherAware;

import org.springframework.web.bind.annotation.DeleteMapping;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.PutMapping;

import org.springframework.web.bind.annotation.RequestBody;

import org.springframework.web.bind.annotation.RestController;

import reactor.core.publisher.Flux;

import reactor.core.publisher.Mono;

// 动态路由

// https://zhuanlan.zhihu.com/p/125018436

@RestController

@SpringBootApplication

public class DemoApplication implements RouteDefinitionRepository, ApplicationEventPublisherAware {

public static void main(String[] args) {

SpringApplication.run(DemoApplication.class, args);

}

// event publisher

ApplicationEventPublisher applicationEventPublisher;

@Override

public void setApplicationEventPublisher(ApplicationEventPublisher applicationEventPublisher) {

this.applicationEventPublisher = applicationEventPublisher;

}

// router

List<RouteDefinition> memery = new ArrayList<>();

private void refreshRoute() {

applicationEventPublisher.publishEvent(new RefreshRoutesEvent(this));

}

@PutMapping

Mono<Void> putRoute(@RequestBody Mono<RouteDefinition> o) {

return o.flatMap(routeDefinition -> {

memery.add(routeDefinition);

refreshRoute();

return Mono.empty();

});

}

@PostMapping

Mono<Void> postRoute(@RequestBody Mono<RouteDefinition> o) {

return o.flatMap(routeDefinition -> {

for (int i = 0; i < memery.size(); i++) {

if (memery.get(i).getId().equals(routeDefinition.getId())) {

memery.set(i, routeDefinition);

}

}

refreshRoute();

return Mono.empty();

});

}

@DeleteMapping

Mono<Void> deleteRoute(@RequestBody Mono<String> o) {

return o.flatMap(id -> {

memery.removeIf(routeDefinition -> routeDefinition.getId().equals(id));

refreshRoute();

return Mono.empty();

});

}

@GetMapping

Mono<List<RouteDefinition>> getRoute(){

return Mono.just(memery);

}

@Override

public Flux<RouteDefinition> getRouteDefinitions() {

return Flux.fromIterable(memery);

}

@Override

public Mono<Void> save(Mono<RouteDefinition> route) {

return Mono.empty();

}

@Override

public Mono<Void> delete(Mono<String> routeId) {

return Mono.empty();

}

}GET http://localhost:52834/test

###

PUT http://localhost:52834

Content-Type: application/json

{

"id": "test",

"predicates": [

{

"name": "Path",

"args": {

"pattern": "/test"

}

}

],

"filters": [

{

"name": "RewritePath",

"args": {

"regexp": "/test",

"replacement": "/s"

}

}

],

"uri": "http://www.baidu.com",

"order": 0

}

###

GET http://localhost:52834

###

GET http://localhost:52834/testhttps://segmentfault.com/a/1190000023095631

对于所有的容器化开发,我们的时区都需要设置

-v /etc/localtime:/etc/localtime

docker run -itd \

--restart=always \

--name xxx \

-v /src/xxx:/src/xxx \

-v /etc/localtime:/etc/localtime \

-v /root/.ssh:/root/.ssh \

-p 3000:3000 \

node:14.4.0

# 这个时区设置添加到启动程序中

# process.env.TZ = 'Asia/Shanghai';# docker 参数

-m 800m

--cpus 1

-v /root/.m2/:/root/.m2

-p 8080:8080 -p

--net docker-net

--ip 192.168.11.2FROM maven:3.6.3-jdk-8

COPY . /src

WORKDIR /src

CMD ["sh", "dockerEntryPoint.sh"]mvn -v

echo "package"

mvn clean package -Dmaven.test.skip=true

echo "start java application ... "

#java -jar -agentlib:jdwp=transport=dt_socket,server=n,address=10.40.28.63:5005,suspend=y main.jar

java -jar \

-agentlib:jdwp=transport=dt_socket,server=y,suspend=n,address=5005 \

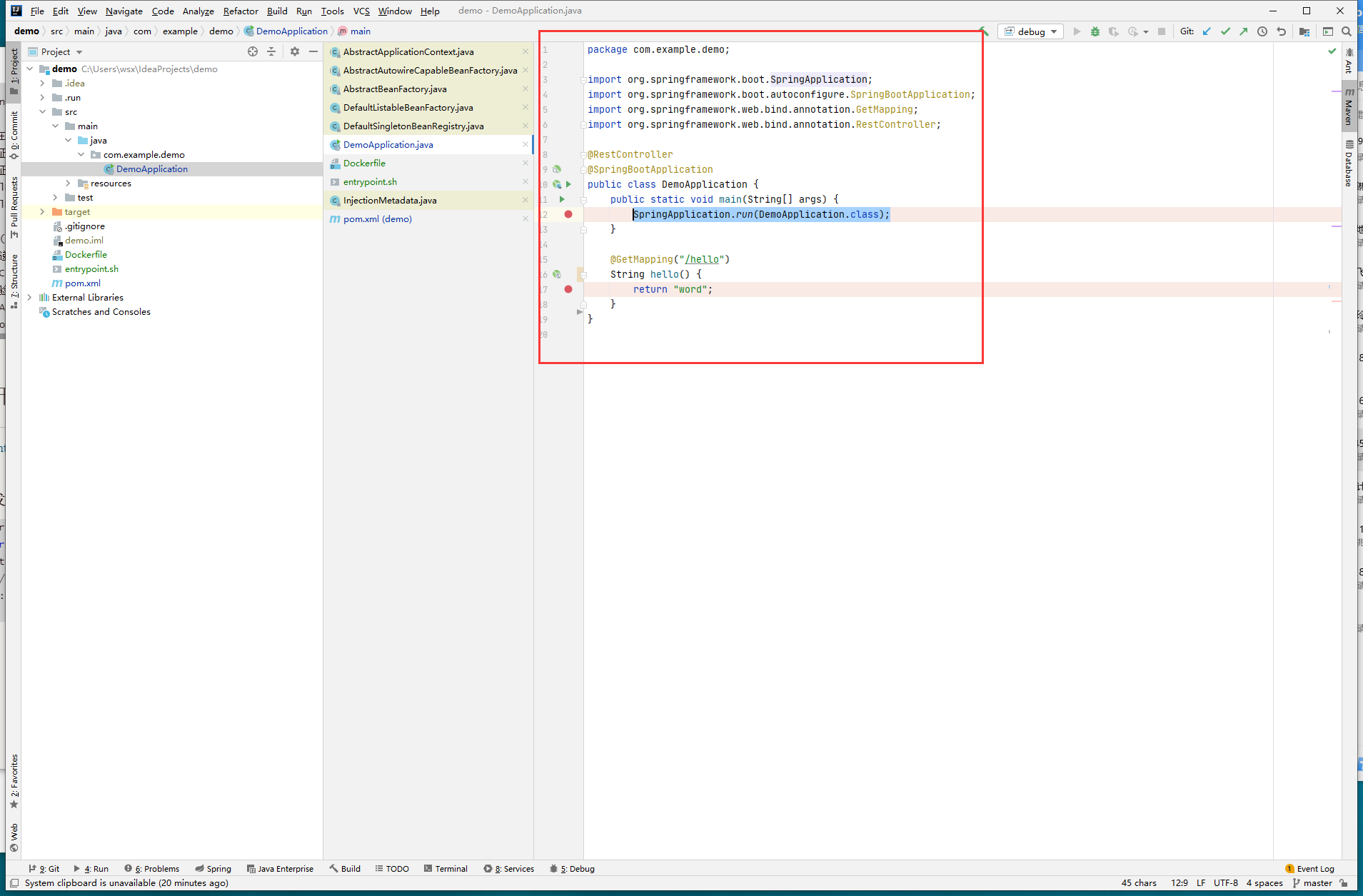

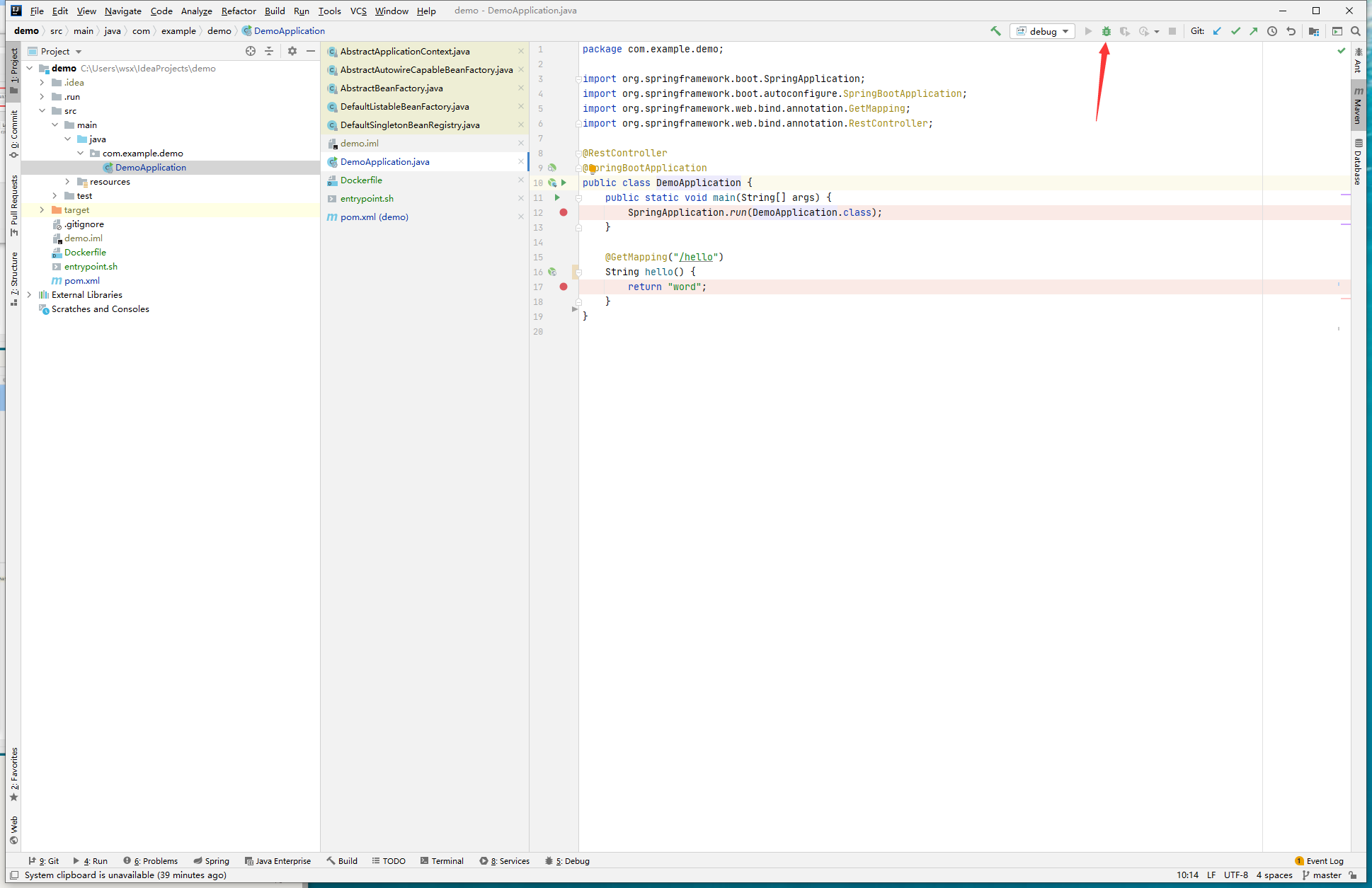

*.jar第一步,开发一个Spring程序

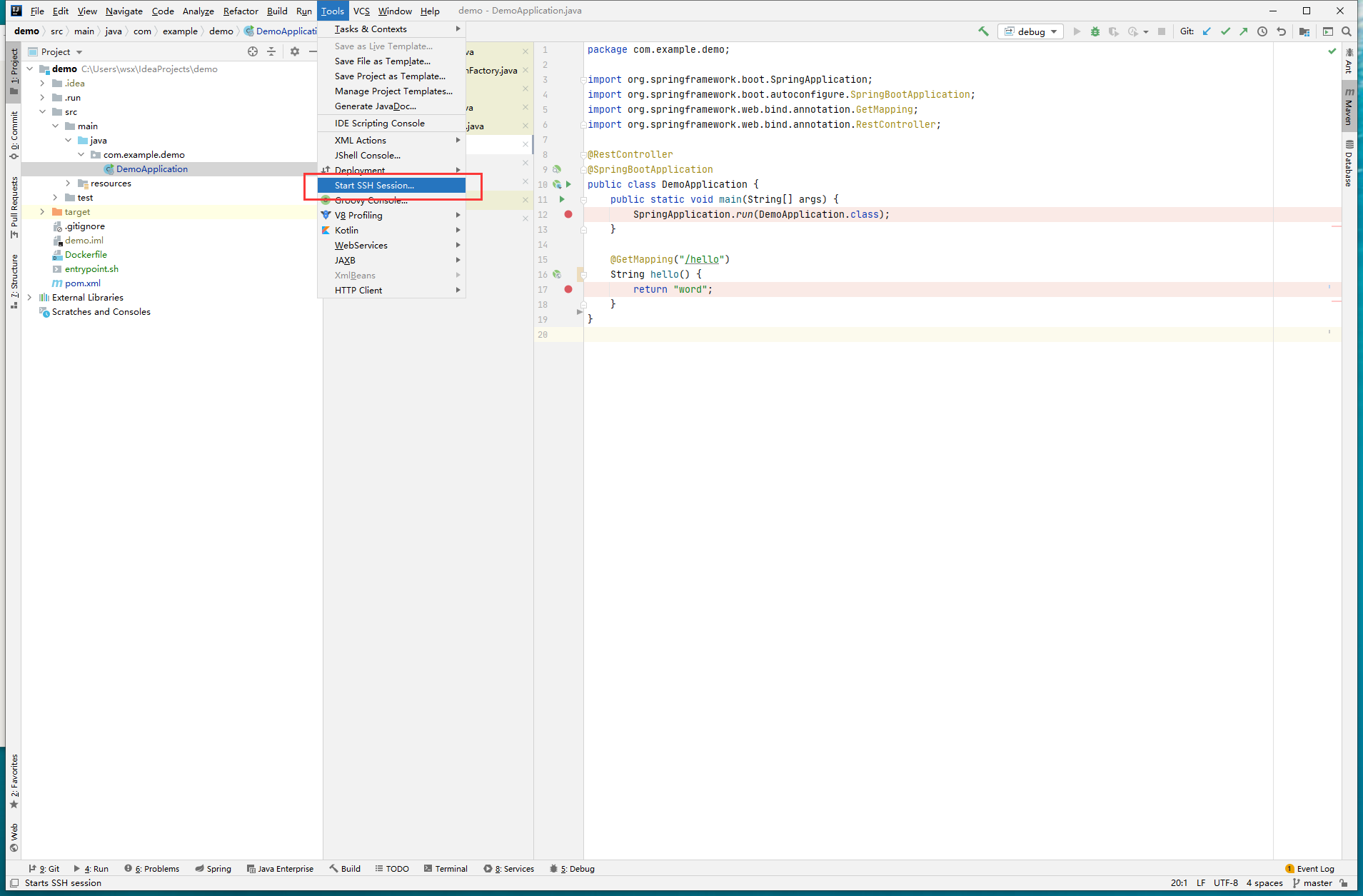

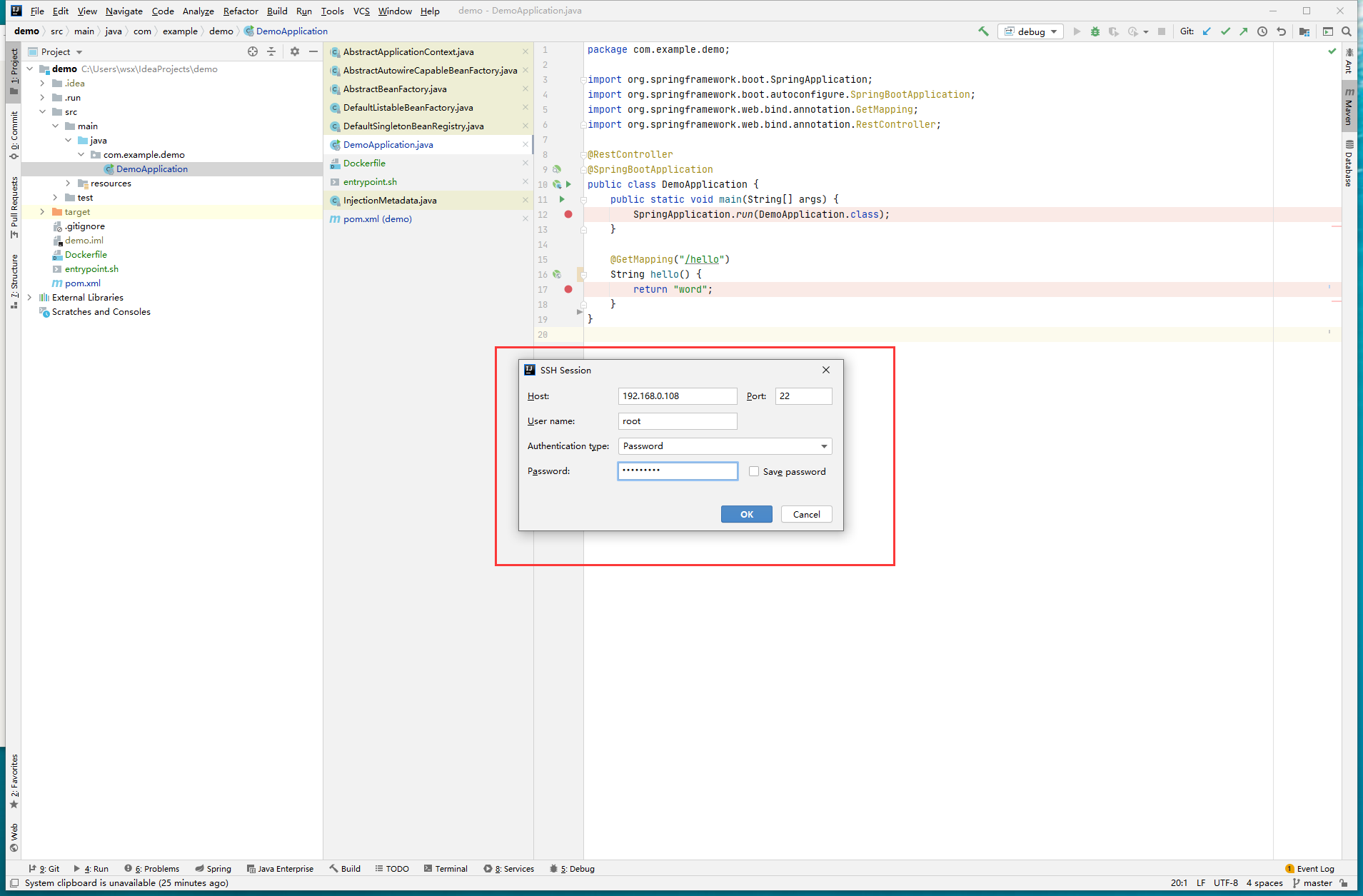

第二步,连接远端Centos

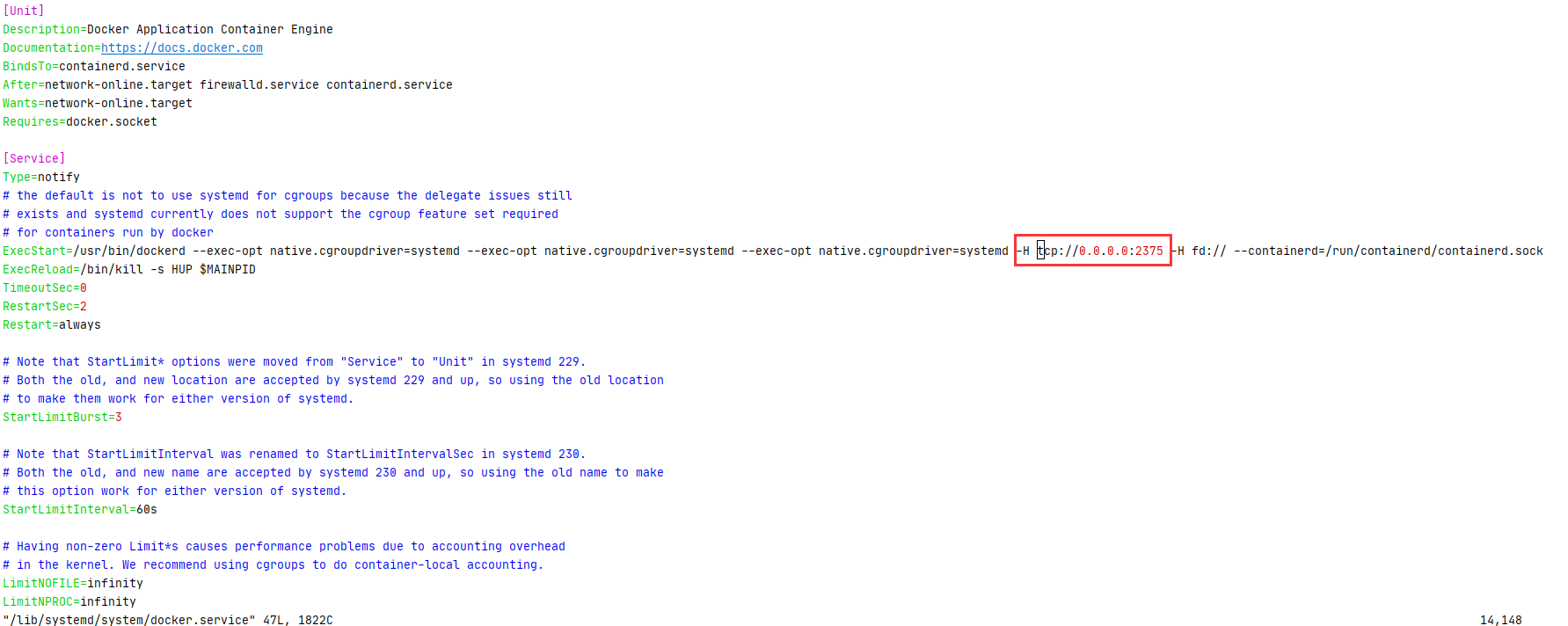

第三步修改docker启动参数并重启docker

vim /lib/systemd/system/docker.service 增加 -H tcp://0.0.0.0:2375

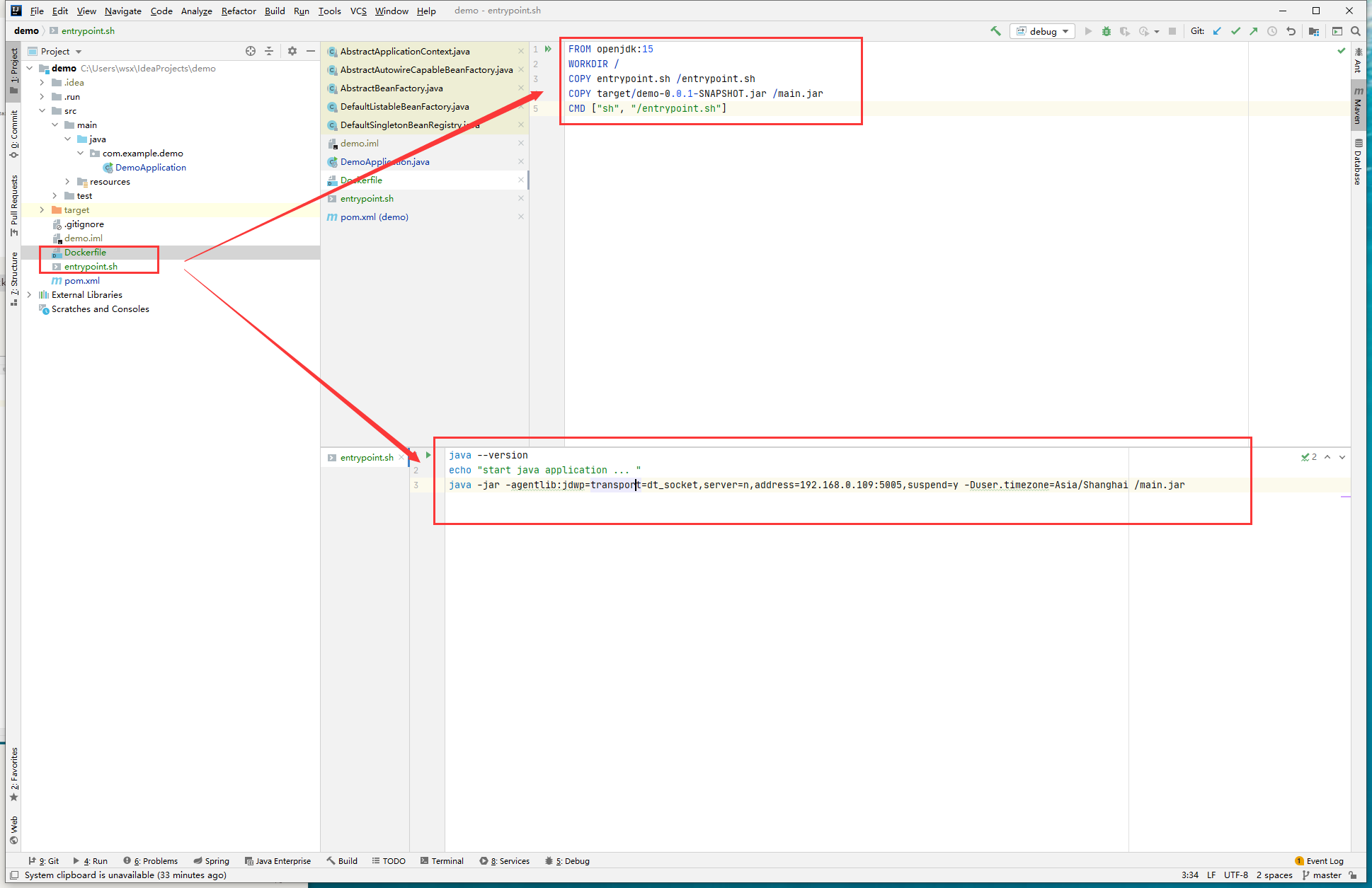

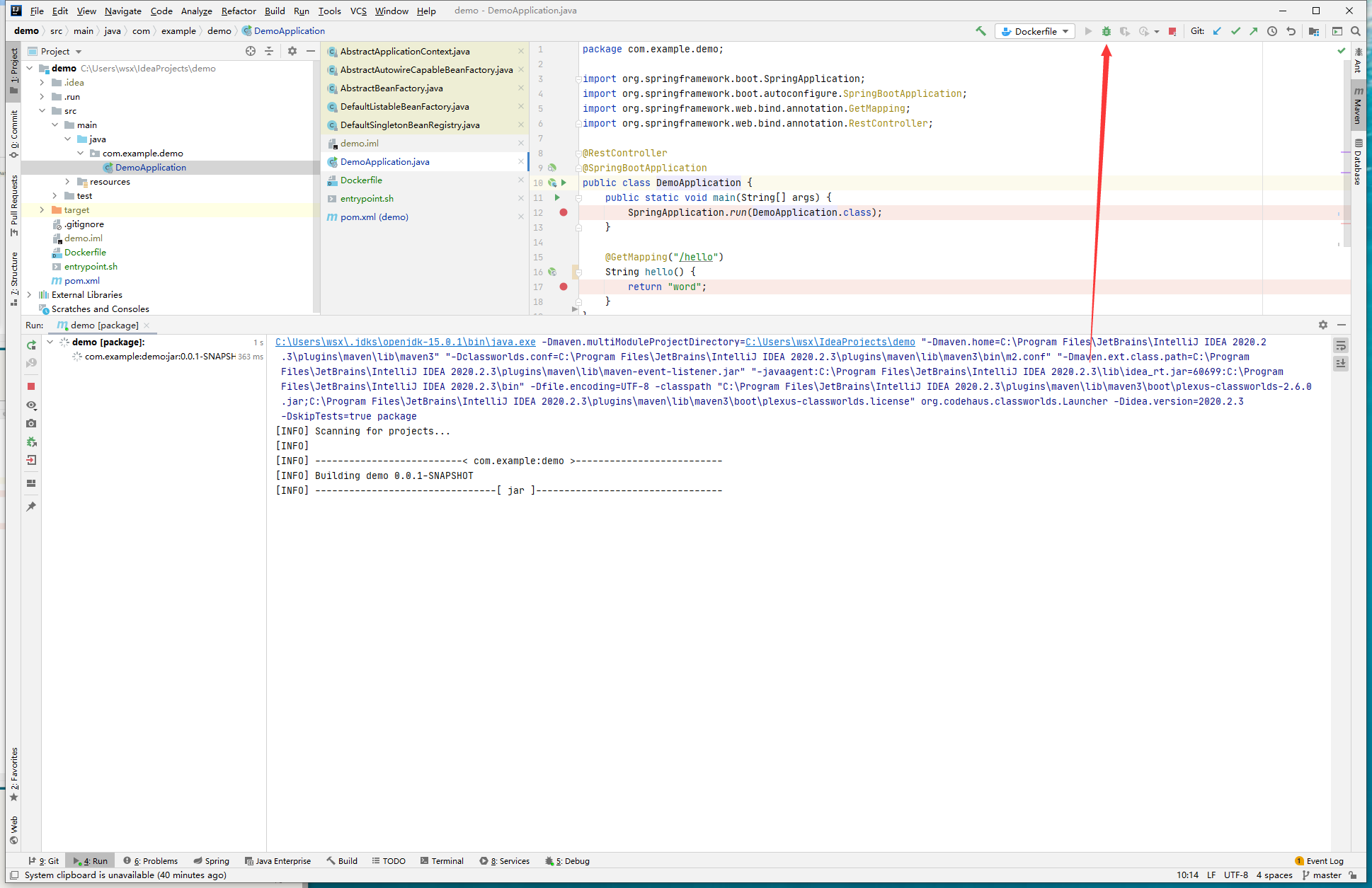

systemctl daemon-reload && systemctl restart docker && systemctl status docker第四步创建Dockerfile以及entrypoint.sh

注意Dockerfile中移动的jar包是编译产物

注意entrypoint.sh中的address后是自己本地机器的ip

FROM openjdk:15

WORKDIR /

COPY entrypoint.sh /entrypoint.sh

COPY target/demo-0.0.1-SNAPSHOT.jar /main.jar

CMD ["sh", "/entrypoint.sh"]java --version

echo "start java application ... "

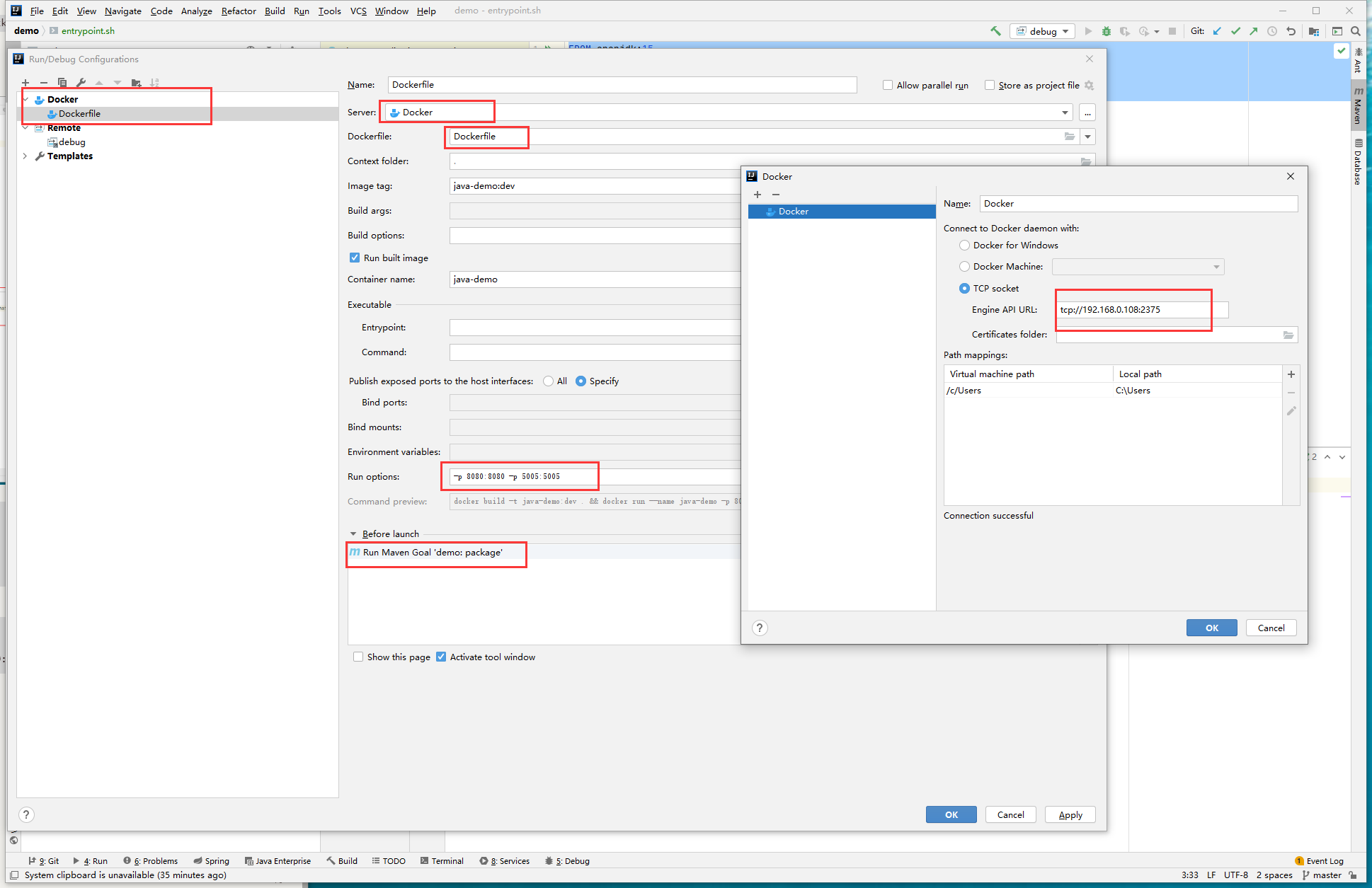

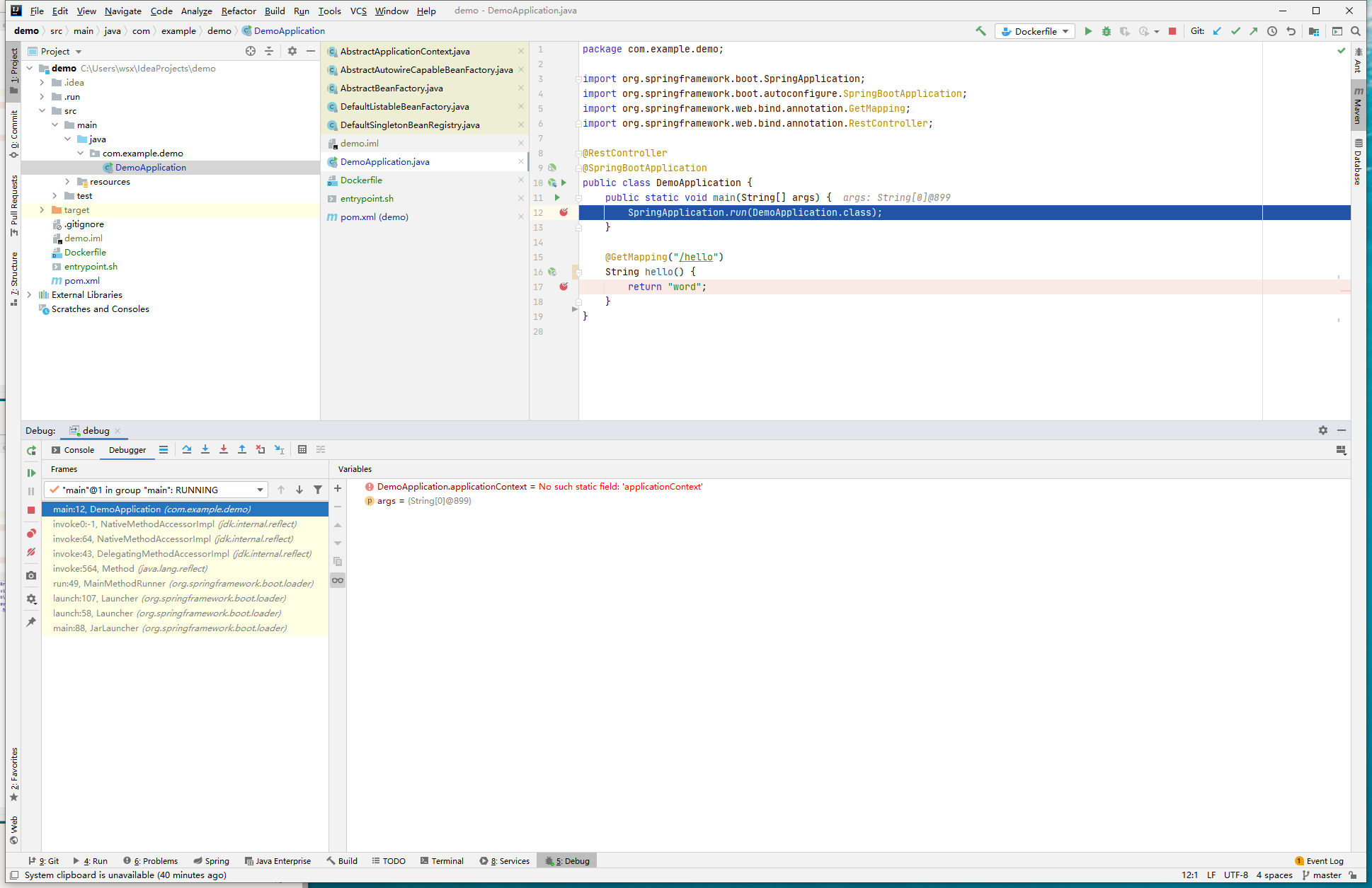

java -jar -agentlib:jdwp=transport=dt_socket,server=n,address=192.168.0.109:5005,suspend=y -Duser.timezone=Asia/Shanghai /main.jar第五步创建Docker启动配置和Debug启动配置

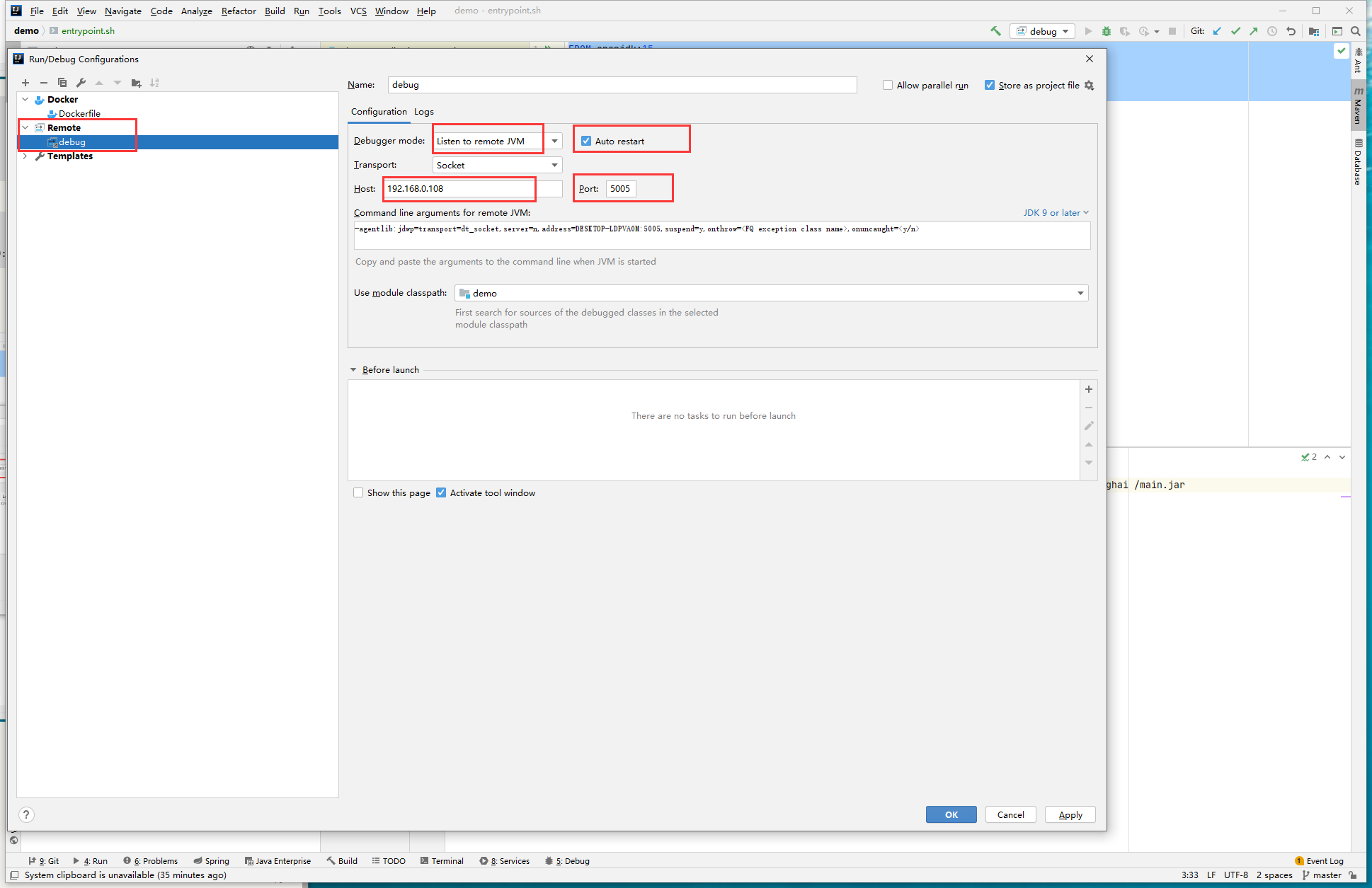

注意Dockerfile的Before lanch前加上 mvn package

注意Debug的Host为远程ip

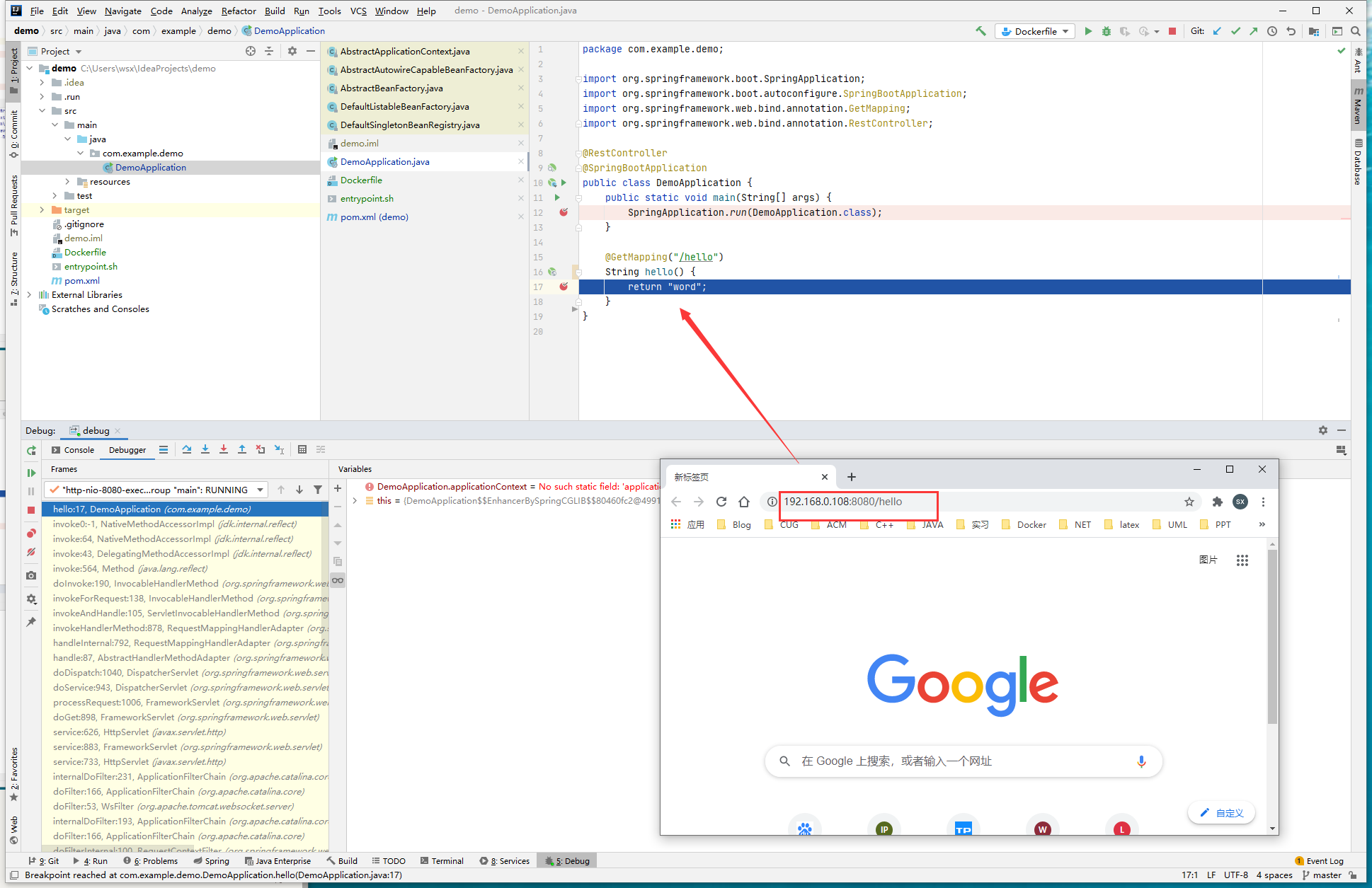

第六步先启动远程调试,后启动docker build

第七步: enjoy it

hexo_post

势能分析是一种常用的数据结构时间复杂度分析的手段,我们常常会定义一个势能函数,用于评价数据结构某个状态的势能,把每个操作的时间复杂度加上操作导致的势能变化作为摊还复杂度,如果经过了一系列操作以后,势能不减少,这一系列操作的时间复杂度之和不大于这一系列操作的摊还复杂度之和。

我们对一个初始数据结构$D_0$执行$n$个操作,对于每个$i=1,2,...,n$令$C_i$为第$i$个操作的实际代价,令$D_i$为在数据结构$D_{i-1}$上执行第$i$个操作后得到的结果数据结构,势能函数$\Phi$将每个数据结构$D_i$映射到一个实数$\Phi(D_i)$,此值即为关联到数据结构$D_i$的势,第$i$个操作的摊还代价$\hat{C_i}=C_i+\Phi(D_i)-\Phi(D_{i-1})$,则$n$个操作的总摊还代价为$\sum_{i=1}^n\hat{C_i}=\sum_{i=1}^n{C_i}+\Phi(D_n)-\Phi(D_0)$,如果势能函数满足$\Phi(D_n)\ge\Phi(D_0)$,则总摊还代价$\sum_{i=1}^n\hat{C_i}$是总实际代价$\sum_{i=1}^nC_i$的一个上界

笔者在此不会做势能分析,能进行势能分析的东西太多了,例如splay、pairing heap、fibonacci heap、link cut tree等等,我们将其留在后边的博文中详细介绍。

hadoop = common+hdfs+mapreduce+yarn

工具、rpc通信

分布式文件系统,一个文件分成多个128Mb的文件,存储在多个节点,为了保证分区容错性,存有备份,默认为3。主从架构。

用来记录各个文件的block的编号、各个block的位置、抽象目录树 处理读写请求 可以有多个namenode

用来备份namenode,当namenode宕机的时候,帮助namenode恢复

用来储存数据

如果一个datanode挂了,就再开一个datanode,然后吧挂了的数据通过备份推出来存进去,如果之前那个挂了的又活了,则选择一个节点删掉。副本过多将导致维护成本提高

- 可构建在廉价机器上

- 高容错性 : 自动恢复

- 不支持数据修改(尽管支持改名和删除)

- 延迟高

- 不擅长存储小文件,寻址时间长,空间利用低

资源调度、管理框架

- resourcemanager 统筹资源

- nodemanager 资源调度

分布式计算框架

Zookeeper是一个为分布式应用提供一致性服务的软件,是Hadoop项目的一个子项目,是分布式应用程序协调服务

这里有一个下载地址,

也可以brew install zookeeper安装

还可以docker pull zookeeper安装

我们这里采取docker的方式

docker run -d -p 2181:2181 --name zookeeper --restart always zookeeper

docker exec -it zookeeper bash

./bin/zkCli.sh然后我们能看到下面的输出, 我只截取前几行

Connecting to localhost:2181

2020-04-17 07:54:30,252 [myid:] - INFO [main:Environment@98] - Client environment:zookeeper.version=3.6.0--b4c89dc7f6083829e18fae6e446907ae0b1f22d7, built on 02/25/2020 14:38 GMT

...输入quit可以退出

嘿嘿嘿

在conf目录下有配置文件zoo_sample.cfg和log4j.properties,他们分别是zoo的配置文件模版和日志配置,我们可以将zoo_sample.cfg改为zoo.cfg,这个才是Zookeeper默认的配置文件,其中有几个地方比较重要

| 配置 | 作用 |

|---|---|

| tickTime=2000 | 这个是心跳时间间隔,单位是毫秒 |

| dataDir= | Zookeeper保存数据的目录,默认将日志也保存在其中 |

| clientPort=2181 | 客户端连接Zookeeper服务器的端口 |

| initLimit=5 | 当客户端超过5个心跳间隔仍然与服务器连接失败,则认为他宕机 |

| synLimit=2 | Leader和Follower之间发送消息的响应、请求时间长度不能超过的心跳间隔 |

| server.1=192.168.211.1:2888:3888 | server.A=B:C:D, A是数字表示服务器编号,B是这个服务器的ip,C是服务器于集群leader交流信息的端口,D是Leader宕机以后选举新Leader的端口 |

Zookeeper会维护一个层次数据结构,他就像一个文件系统一样, 凑合着看吧

graph LR;

a((/)) --> b((/NameService));

a((/)) --> c((/Configuration));

a((/)) --> d((/GroupMembers));

a((/)) --> e((/Apps));

b((/NameService)) --> b1((/Server1))

b((/NameService)) --> b2((/Server2))

- 所有的目录项都被叫做znode,这个zndoe是被他所在的路径唯一标识,

- znode分4类,EPHEMERAL or PERSISTENT, SEQUENTIAL or N

- 大部分znode都可以有子节点,都可以储存数据, 只有EPHEMERAL不可以有子节点

- znode储存的数据可以拥有版本号

- EPHEMERAL 是临时节点,服务器客户端用心跳机制来保证长连接,如果客户端宕机,这个节点会被删除

- znode可以被监控,是一种观察者模式,客户端可以在目录上注册观察,当目录发生变化,客户端会得到通知

Zookeeper的数据分为两个部分,一部分是内存数据,另一部分是磁盘数据,内存数据提供对外服务,磁盘数据用来恢复内存数据,用来在集群汇总不同节点间数据的同步,磁盘数据包括快照和事务日志,快照是粗粒度,事务日志是细粒度。

先加载快照然后加载日志

基于阈值,引入随机因素,我们要避免所有节点同时制造快照,这会导致消耗大量磁盘IO和CPU,降低对外服务能力,参见一个公式

事务日志是不断写入的,会触发底层磁盘IO,为了减少分配磁盘块对写入的影响,Zookeeper使用预分配的策略,每次分配64MB,当这64MB的空间被使用到只剩下4KB的时候,就开始再次分配空间了

**过半:**当leader广播一个事务消息以后,收到了半数以上的ack,就认为集群中所有的节点都收到了消息,leader不会等待剩余节点的ack,直接广播commit消息,提交事务,选举投票中也是如此

Zookeeper集群中有3种角色

| 角色 | 任务 |

|---|---|

| leader | 一个集群只有一个leader,通过选举产生,负责所有事务的写操作,保证集群事务处理的顺序性 |

| follower | 处理非事务请求,转发事务给leader,参与leader选举投票, |

| observer | 提供读取服务,不参与投票 |

- 集群在半数以下节点宕机的情况下,能够正常对外提供服务

- 客户端的写请求全部转交给leader处理,以确保变更能实时同步到所有的follower和observer

- leader宕机或者整个集群重启的时候,要确保在leader上提交的事务最终被所有服务器提交,确保只在leader上提出单未被提交的事务被丢弃

当集群中的服务器初始化启动或者运行期无法与leader保持连接的时候,会触发选主,投票者们混线传递投票的信息,包含了被推举的leader的服务id、事务zxid、逻辑时钟、选举状态,显然要选举事务zxid最大的那个,如果事务id相同,就选择服务id最大的那个

广播的时候每当外边传入的(id,zxid)比自己内存中的要优的时候,就更新自己的数据,然后向外广播[^理解zookeeper选举机制]

这里有一个有意思的东西,我们什么时候选举结束呢?

当一个(id,zxid)被超过半数的节点所选举的时候,它就有力担当leader,为什么是半数?因为Zookeeper集群的每一条事务,都是在超过半数ack的情况下才能被leader提交,所以如果一个节点在半数中为最优,那么它一定是最优者之一

这就好比一个数列,数列中的最大值的数量超过了半数,那么该序列的任何一个元素个数超过一半的子序列的最值,一定等于整个序列的最值。比方有一个序列[1,2,3,5,5,5,5], 你在其中选择至少4个数,那么他们中的最大值一定是5,其实就是鸽巢原理

另一方面选主的时候,每个节点都是三个线程,一个负责接收投票并放入队列,另一个用于发送投票信息,还有一个用于外部投票同自己的信息比较,选出新的结果

这里的数据不一致可能有两种,要么比leader旧,要么比leader新,旧的话同步即可,新的话撤销这个未提交的事务即可, 两个不一致性的原因这里有谈到[^分析Zookeeper的一致性原理]

事务由leader发起,follower执行,然后返回ack,最终由leader决定是否提交。

路径就是名字

我们的集群,每台机器都有自己的配置文件,这会非常难以维护,实际上我们会把配置文件储存在Zookeeper的某个目录节点中,让集群的每台机器都注册该节点的观察,当配置文件发生改变的时候,这些机器都会的得到通知,然后从Zookeeper更新自己的配置文件。

我们的集群需要有一个总管知道集群中每台机器的状态,当一些机器发生故障或者新添加机器的时候,总管必须知道,这就可以用Zookeeper管理

甚至当总管宕机以后,Zookeeper能够重新选出总管,总管会在Zookeeper中创建一个EPHEMERAL类型的目录节点,每个Server会注册这个节点的watch,总管死去的时候,这个目录会被删除,所有的子节点都会收到通知,这时大家都知道总管宕机了,集群默认会选择接待你编号最小的Server作为新的Master。

同样,我们让第一个创建某目录成功的机器获得锁,其他机器在其子目录下创建新的目录节点,当它需要释放锁的时候,只需要删除目录,然后让子节点中编号最小的节点作文新的目录获得锁,其他节点继续跟随即可。

同步队列,即当所有成员达到某个条件是,才能以前向后执行,我们创建一个同步目录,每当一个成员满足条件,就去Zookeeper上注册节点,如果当前节点的个数达到n,就创建start节点,否则注册watch,等待start节点被创建,当其被创建就会收到通知,然后执行自己的事情

FIFO队列, 如生产者消费者模型,创建子目录/queue,当生产者生产出东西的时候,在/queue上创建新节点,当消费者需要消费的时候,从当前目录去除编号最小的节点即可

Docker下安装zookeeper(单机 & 集群) ZooKeeper学习 一:安装 zookeeper使用和原理探究 分布式服务框架 Zookeeper — 管理分布式环境中的数据 mac安装的docker替换镜像 Zookeeper持久化原理 ZooKeeper 技术内幕:数据的存储(持久化机制) Zookeeper-持久化 分析Zookeeper的一致性原理 理解zookeeper选举机制

mkdir ~/DockerDesktop

mkdir ~/DockerDesktop/Zookeeper

cd ~/DockerDesktop/Zookeepermkdir node1

mkdir node1/data

mkdir node1/datalog

cp -r node1 node2

cp -r node1 node3

cp -r node1 node4

cp -r node1 node5vim docker-compose.ymlversion: '3'

services:

Zookeeper1:

image: zookeeper

hostname: Zookeeper1

volumes: # 挂载数据

- ~/DockerDesktop/Zookeeper/node1/data:/data

- ~/DockerDesktop/Zookeeper/node1/datalog:/datalog

environment:

ZOO_MY_ID: 1

ZOO_SERVERS: server.1=Zookeeper1:2888:3888;2181 server.2=Zookeeper2:2888:3888;2181 server.3=Zookeeper3:2888:3888;2181 server.4=Zookeeper4:2888:3888;2181 server.5=Zookeeper5:2888:3888;2181

networks:

default:

ipv4_address: 172.17.1.1

Zookeeper2:

image: zookeeper

hostname: Zookeeper2

volumes: # 挂载数据

- ~/DockerDesktop/Zookeeper/node2/data:/data

- ~/DockerDesktop/Zookeeper/node2/datalog:/datalog

environment:

ZOO_MY_ID: 2

ZOO_SERVERS: server.1=Zookeeper1:2888:3888;2181 server.2=Zookeeper2:2888:3888;2181 server.3=Zookeeper3:2888:3888;2181 server.4=Zookeeper4:2888:3888;2181 server.5=Zookeeper5:2888:3888;2181

networks:

default:

ipv4_address: 172.17.1.2

Zookeeper3:

image: zookeeper

hostname: Zookeeper3

volumes: # 挂载数据

- ~/DockerDesktop/Zookeeper/node3/data:/data

- ~/DockerDesktop/Zookeeper/node3/datalog:/datalog

environment:

ZOO_MY_ID: 3

ZOO_SERVERS: server.1=Zookeeper1:2888:3888;2181 server.2=Zookeeper2:2888:3888;2181 server.3=Zookeeper3:2888:3888;2181 server.4=Zookeeper4:2888:3888;2181 server.5=Zookeeper5:2888:3888;2181

networks:

default:

ipv4_address: 172.17.1.3

Zookeeper4:

image: zookeeper

hostname: Zookeeper4

volumes: # 挂载数据

- ~/DockerDesktop/Zookeeper/node4/data:/data

- ~/DockerDesktop/Zookeeper/node4/datalog:/datalog

environment:

ZOO_MY_ID: 4

ZOO_SERVERS: server.1=Zookeeper1:2888:3888;2181 server.2=Zookeeper2:2888:3888;2181 server.3=Zookeeper3:2888:3888;2181 server.4=Zookeeper4:2888:3888;2181 server.5=Zookeeper5:2888:3888;2181

networks:

default:

ipv4_address: 172.17.1.4

Zookeeper5:

image: zookeeper

hostname: Zookeeper5

volumes: # 挂载数据

- ~/DockerDesktop/Zookeeper/node5/data:/data

- ~/DockerDesktop/Zookeeper/node5/datalog:/datalog

environment:

ZOO_MY_ID: 5

ZOO_SERVERS: server.1=Zookeeper1:2888:3888;2181 server.2=Zookeeper2:2888:3888;2181 server.3=Zookeeper3:2888:3888;2181 server.4=Zookeeper4:2888:3888;2181 server.5=Zookeeper5:2888:3888;2181

networks:

default:

ipv4_address: 172.17.1.5

networks: # 自定义网络

default:

external:

name: net17docker-compose up -d

我们不难发现Zookeeper5成为了集群的leader,其他都都成为了follower

Zookeeper5_1 | 2020-04-18 09:53:01,840 [myid:5] - INFO [QuorumPeer[myid=5](plain=0.0.0.0:2181)(secure=disabled):QuorumPeer@863] - Peer state changed: leading - broadcast

Zookeeper3_1 | 2020-04-18 09:53:01,871 [myid:3] - INFO [QuorumPeer[myid=3](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@476] - Configuring CommitProcessor with readBatchSize -1 commitBatchSize 1

Zookeeper1_1 | 2020-04-18 09:53:01,874 [myid:1] - INFO [QuorumPeer[myid=1](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@476] - Configuring CommitProcessor with readBatchSize -1 commitBatchSize 1

Zookeeper1_1 | 2020-04-18 09:53:01,876 [myid:1] - INFO [QuorumPeer[myid=1](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@438] - Configuring CommitProcessor with 1 worker threads.

Zookeeper3_1 | 2020-04-18 09:53:01,875 [myid:3] - INFO [QuorumPeer[myid=3](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@438] - Configuring CommitProcessor with 1 worker threads.

Zookeeper4_1 | 2020-04-18 09:53:01,874 [myid:4] - INFO [QuorumPeer[myid=4](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@476] - Configuring CommitProcessor with readBatchSize -1 commitBatchSize 1

Zookeeper4_1 | 2020-04-18 09:53:01,882 [myid:4] - INFO [QuorumPeer[myid=4](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@438] - Configuring CommitProcessor with 1 worker threads.

Zookeeper2_1 | 2020-04-18 09:53:01,890 [myid:2] - INFO [QuorumPeer[myid=2](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@476] - Configuring CommitProcessor with readBatchSize -1 commitBatchSize 1

Zookeeper2_1 | 2020-04-18 09:53:01,897 [myid:2] - INFO [QuorumPeer[myid=2](plain=0.0.0.0:2181)(secure=disabled):CommitProcessor@438] - Configuring CommitProcessor with 1 worker threads.

Zookeeper1_1 | 2020-04-18 09:53:01,909 [myid:1] - INFO [QuorumPeer[myid=1](plain=0.0.0.0:2181)(secure=disabled):RequestThrottler@74] - zookeeper.request_throttler.shutdownTimeout = 10000

Zookeeper4_1 | 2020-04-18 09:53:01,915 [myid:4] - INFO [QuorumPeer[myid=4](plain=0.0.0.0:2181)(secure=disabled):RequestThrottler@74] - zookeeper.request_throttler.shutdownTimeout = 10000

Zookeeper3_1 | 2020-04-18 09:53:01,921 [myid:3] - INFO [QuorumPeer[myid=3](plain=0.0.0.0:2181)(secure=disabled):RequestThrottler@74] - zookeeper.request_throttler.shutdownTimeout = 10000

Zookeeper2_1 | 2020-04-18 09:53:01,928 [myid:2] - INFO [QuorumPeer[myid=2](plain=0.0.0.0:2181)(secure=disabled):RequestThrottler@74] - zookeeper.request_throttler.shutdownTimeout = 10000

Zookeeper1_1 | 2020-04-18 09:53:02,053 [myid:1] - INFO [QuorumPeer[myid=1](plain=0.0.0.0:2181)(secure=disabled):QuorumPeer@863] - Peer state changed: following - broadcast

Zookeeper4_1 | 2020-04-18 09:53:02,056 [myid:4] - INFO [QuorumPeer[myid=4](plain=0.0.0.0:2181)(secure=disabled):QuorumPeer@863] - Peer state changed: following - broadcast

Zookeeper3_1 | 2020-04-18 09:53:02,063 [myid:3] - INFO [QuorumPeer[myid=3](plain=0.0.0.0:2181)(secure=disabled):QuorumPeer@863] - Peer state changed: following - broadcast

Zookeeper2_1 | 2020-04-18 09:53:02,068 [myid:2] - INFO [QuorumPeer[myid=2](plain=0.0.0.0:2181)(secure=disabled):QuorumPeer@863] - Peer state changed: following - broadcast

Kafka是一个分布式的基于发布/订阅模式的消息队列,应用于大数据实时处理领域

主要是解耦和削峰

- 解耦

- 可恢复,如果系统中一部分组件失效,加入队列的消息仍然可以在系统恢复后被处理

- 削峰

- 灵活,可动态维护消息队列的集群

- 异步

一对一,消费者主动拉取消息,收到后清除

一对多,消费者消费后,消息不会清除,当然也不是永久保留,

分两种,一个是发布者主动推送,另一个是消费者主动拉取,Kafka就是消费者主动拉取,

| 推送 | 拉取 |

|---|---|

| 不好照顾多个消费者的接受速度 | 主动拉取,由消费者决定 |

| 消费者要每过一段时间就询问有没有新消息,长轮询 |

Kafka Cluster 中有多个 Broker Broker中有多个Topic Partion 每个Topic的多个Parttition,放在多个Broker上,可以提高Producer的并发,每个Topic Partition在其他Cluster上存有副本,用于备份,他们存在leader和follower,我们只找leader,不找follower

Topic是分区的,每个分区都是有副本的,分为leader和follower

消费者存在消费者组,一个分区只能被同一个组的某一个消费者消费,我们主要是把一个组当作一个大消费者,消费者组可以提高消费能力,消费者多了整个组的消费能力就高了,消费组中消费者的个数不要比消息多,不然就是浪费资源

Kafka利用Zookeeper来管理配置 0.9前消费者把自己消费的位置信息储存在Zookeeper中 0.9后是Kafka自己储存在某个主题中(减少了消费者和zk的连接)

官网下载Kafka

brew install kafka

docker pull wurstmeister/kafka

这里我依然选择docker安装,

mkdir ~/DockerDesktop

mkdir ~/DockerDesktop/Kafka

cd ~/DockerDesktop/Kafka

mkdir node1 node2 node3 node4 node5

vim docker-compose.yml

version: '3'

services:

Kafka1:

image: wurstmeister/kafka

hostname: Kafka1

environment:

KAFKA_ADVERTISED_HOST_NAME: Kafka1

KAFKA_ADVERTISED_PORT: 9092

KAFKA_ZOOKEEPER_CONNECT: Zookeeper1:2181,Zookeeper2:2181,Zookeeper3:2181,Zookeeper4:2181,Zookeeper5:2181

volumes:

- ~/DockerDesktop/Kafka/node1:/kafka

external_links:

- Zookeeper1

- Zookeeper2

- Zookeeper3

- Zookeeper4

- Zookeeper5

networks:

default:

ipv4_address: 172.17.2.1

Kafka2:

image: wurstmeister/kafka

hostname: Kafka2

environment:

KAFKA_ADVERTISED_HOST_NAME: Kafka2

KAFKA_ADVERTISED_PORT: 9092

KAFKA_ZOOKEEPER_CONNECT: Zookeeper1:2181,Zookeeper2:2181,Zookeeper3:2181,Zookeeper4:2181,Zookeeper5:2181

volumes:

- ~/DockerDesktop/Kafka/node2:/kafka

external_links:

- Zookeeper1

- Zookeeper2

- Zookeeper3

- Zookeeper4

- Zookeeper5

networks:

default:

ipv4_address: 172.17.2.2

Kafka3:

image: wurstmeister/kafka

hostname: Kafka3

environment:

KAFKA_ADVERTISED_HOST_NAME: Kafka3

KAFKA_ADVERTISED_PORT: 9092

KAFKA_ZOOKEEPER_CONNECT: Zookeeper1:2181,Zookeeper2:2181,Zookeeper3:2181,Zookeeper4:2181,Zookeeper5:2181

volumes:

- ~/DockerDesktop/Kafka/node3:/kafka

external_links:

- Zookeeper1

- Zookeeper2

- Zookeeper3

- Zookeeper4

- Zookeeper5

networks:

default:

ipv4_address: 172.17.2.3

Kafka4:

image: wurstmeister/kafka

hostname: Kafka4

environment:

KAFKA_ADVERTISED_HOST_NAME: Kafka4

KAFKA_ADVERTISED_PORT: 9092

KAFKA_ZOOKEEPER_CONNECT: Zookeeper1:2181,Zookeeper2:2181,Zookeeper3:2181,Zookeeper4:2181,Zookeeper5:2181

volumes:

- ~/DockerDesktop/Kafka/node4:/kafka

external_links:

- Zookeeper1

- Zookeeper2

- Zookeeper3

- Zookeeper4

- Zookeeper5

networks:

default:

ipv4_address: 172.17.2.4

Kafka5:

image: wurstmeister/kafka

hostname: Kafka5

environment:

KAFKA_ADVERTISED_HOST_NAME: Kafka5

KAFKA_ADVERTISED_PORT: 9092

KAFKA_ZOOKEEPER_CONNECT: Zookeeper1:2181,Zookeeper2:2181,Zookeeper3:2181,Zookeeper4:2181,Zookeeper5:2181

volumes:

- ~/DockerDesktop/Kafka/node5:/kafka

external_links:

- Zookeeper1

- Zookeeper2

- Zookeeper3

- Zookeeper4

- Zookeeper5

networks:

default:

ipv4_address: 172.17.2.5

networks:

default:

external:

name: net17执行下面的指令,Kafka集群开始运行

docker-compose up

看到了输出

Kafka3_1 | [2020-04-18 10:26:27,441] INFO [Transaction Marker Channel Manager 1002]: Starting (kafka.coordinator.transaction.TransactionMarkerChannelManager)

Kafka4_1 | [2020-04-18 10:26:27,451] INFO [ExpirationReaper-1005-AlterAcls]: Starting (kafka.server.DelayedOperationPurgatory$ExpiredOperationReaper)

Kafka5_1 | [2020-04-18 10:26:27,473] INFO [TransactionCoordinator id=1001] Starting up. (kafka.coordinator.transaction.TransactionCoordinator)

Kafka5_1 | [2020-04-18 10:26:27,524] INFO [TransactionCoordinator id=1001] Startup complete. (kafka.coordinator.transaction.TransactionCoordinator)

Kafka5_1 | [2020-04-18 10:26:27,554] INFO [Transaction Marker Channel Manager 1001]: Starting (kafka.coordinator.transaction.TransactionMarkerChannelManager)

Kafka1_1 | [2020-04-18 10:26:27,635] INFO [TransactionCoordinator id=1003] Starting up. (kafka.coordinator.transaction.TransactionCoordinator)

Kafka1_1 | [2020-04-18 10:26:27,644] INFO [TransactionCoordinator id=1003] Startup complete. (kafka.coordinator.transaction.TransactionCoordinator)

Kafka1_1 | [2020-04-18 10:26:27,669] INFO [Transaction Marker Channel Manager 1003]: Starting (kafka.coordinator.transaction.TransactionMarkerChannelManager)

Kafka2_1 | [2020-04-18 10:26:27,748] INFO [ExpirationReaper-1004-AlterAcls]: Starting (kafka.server.DelayedOperationPurgatory$ExpiredOperationReaper)

Kafka4_1 | [2020-04-18 10:26:27,753] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

Kafka3_1 | [2020-04-18 10:26:27,843] INFO [ExpirationReaper-1002-AlterAcls]: Starting (kafka.server.DelayedOperationPurgatory$ExpiredOperationReaper)

Kafka4_1 | [2020-04-18 10:26:27,882] INFO [SocketServer brokerId=1005] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

Kafka4_1 | [2020-04-18 10:26:27,945] INFO Kafka version: 2.4.1 (org.apache.kafka.common.utils.AppInfoParser)

Kafka4_1 | [2020-04-18 10:26:27,950] INFO Kafka commitId: c57222ae8cd7866b (org.apache.kafka.common.utils.AppInfoParser)

Kafka4_1 | [2020-04-18 10:26:27,955] INFO Kafka startTimeMs: 1587205587891 (org.apache.kafka.common.utils.AppInfoParser)

Kafka4_1 | [2020-04-18 10:26:27,976] INFO [KafkaServer id=1005] started (kafka.server.KafkaServer)

Kafka2_1 | [2020-04-18 10:26:27,989] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

Kafka1_1 | [2020-04-18 10:26:28,076] INFO [ExpirationReaper-1003-AlterAcls]: Starting (kafka.server.DelayedOperationPurgatory$ExpiredOperationReaper)

Kafka3_1 | [2020-04-18 10:26:28,095] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

Kafka2_1 | [2020-04-18 10:26:28,190] INFO [SocketServer brokerId=1004] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

Kafka2_1 | [2020-04-18 10:26:28,239] INFO Kafka version: 2.4.1 (org.apache.kafka.common.utils.AppInfoParser)

Kafka2_1 | [2020-04-18 10:26:28,241] INFO Kafka commitId: c57222ae8cd7866b (org.apache.kafka.common.utils.AppInfoParser)

Kafka2_1 | [2020-04-18 10:26:28,243] INFO Kafka startTimeMs: 1587205588196 (org.apache.kafka.common.utils.AppInfoParser)

Kafka2_1 | [2020-04-18 10:26:28,244] INFO [KafkaServer id=1004] started (kafka.server.KafkaServer)

Kafka3_1 | [2020-04-18 10:26:28,253] INFO [SocketServer brokerId=1002] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

Kafka3_1 | [2020-04-18 10:26:28,292] INFO Kafka version: 2.4.1 (org.apache.kafka.common.utils.AppInfoParser)

Kafka3_1 | [2020-04-18 10:26:28,295] INFO Kafka commitId: c57222ae8cd7866b (org.apache.kafka.common.utils.AppInfoParser)

Kafka3_1 | [2020-04-18 10:26:28,297] INFO Kafka startTimeMs: 1587205588257 (org.apache.kafka.common.utils.AppInfoParser)

Kafka3_1 | [2020-04-18 10:26:28,313] INFO [KafkaServer id=1002] started (kafka.server.KafkaServer)

Kafka1_1 | [2020-04-18 10:26:28,327] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

Kafka5_1 | [2020-04-18 10:26:28,365] INFO [ExpirationReaper-1001-AlterAcls]: Starting (kafka.server.DelayedOperationPurgatory$ExpiredOperationReaper)

Kafka1_1 | [2020-04-18 10:26:28,533] INFO [SocketServer brokerId=1003] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

Kafka1_1 | [2020-04-18 10:26:28,582] INFO Kafka version: 2.4.1 (org.apache.kafka.common.utils.AppInfoParser)

Kafka1_1 | [2020-04-18 10:26:28,582] INFO Kafka commitId: c57222ae8cd7866b (org.apache.kafka.common.utils.AppInfoParser)

Kafka1_1 | [2020-04-18 10:26:28,584] INFO Kafka startTimeMs: 1587205588534 (org.apache.kafka.common.utils.AppInfoParser)

Kafka1_1 | [2020-04-18 10:26:28,607] INFO [KafkaServer id=1003] started (kafka.server.KafkaServer)

Kafka5_1 | [2020-04-18 10:26:28,931] INFO [/config/changes-event-process-thread]: Starting (kafka.common.ZkNodeChangeNotificationListener$ChangeEventProcessThread)

Kafka5_1 | [2020-04-18 10:26:29,129] INFO [SocketServer brokerId=1001] Started data-plane processors for 1 acceptors (kafka.network.SocketServer)

Kafka5_1 | [2020-04-18 10:26:29,218] INFO Kafka version: 2.4.1 (org.apache.kafka.common.utils.AppInfoParser)

Kafka5_1 | [2020-04-18 10:26:29,218] INFO Kafka commitId: c57222ae8cd7866b (org.apache.kafka.common.utils.AppInfoParser)

Kafka5_1 | [2020-04-18 10:26:29,220] INFO Kafka startTimeMs: 1587205589130 (org.apache.kafka.common.utils.AppInfoParser)

Kafka5_1 | [2020-04-18 10:26:29,222] INFO [KafkaServer id=1001] started (kafka.server.KafkaServer)

同时我们在Zookeeper集群也看到了输出

Zookeeper1_1 | 2020-04-18 10:26:09,983 [myid:1] - WARN [QuorumPeer[myid=1](plain=0.0.0.0:2181)(secure=disabled):Follower@170] - Got zxid 0x500000001 expected 0x1

Zookeeper1_1 | 2020-04-18 10:26:09,990 [myid:1] - INFO [SyncThread:1:FileTxnLog@284] - Creating new log file: log.500000001

Zookeeper5_1 | 2020-04-18 10:26:09,988 [myid:5] - INFO [SyncThread:5:FileTxnLog@284] - Creating new log file: log.500000001

Zookeeper2_1 | 2020-04-18 10:26:10,002 [myid:2] - WARN [QuorumPeer[myid=2](plain=0.0.0.0:2181)(secure=disabled):Follower@170] - Got zxid 0x500000001 expected 0x1

Zookeeper2_1 | 2020-04-18 10:26:10,045 [myid:2] - INFO [SyncThread:2:FileTxnLog@284] - Creating new log file: log.500000001

Zookeeper4_1 | 2020-04-18 10:26:10,059 [myid:4] - WARN [QuorumPeer[myid=4](plain=0.0.0.0:2181)(secure=disabled):Follower@170] - Got zxid 0x500000001 expected 0x1

Zookeeper1_1 | 2020-04-18 10:26:10,087 [myid:1] - INFO [CommitProcessor:1:LearnerSessionTracker@116] - Committing global session 0x500000589e20000

Zookeeper5_1 | 2020-04-18 10:26:10,092 [myid:5] - INFO [CommitProcessor:5:LeaderSessionTracker@104] - Committing global session 0x500000589e20000

Zookeeper2_1 | 2020-04-18 10:26:10,093 [myid:2] - INFO [CommitProcessor:2:LearnerSessionTracker@116] - Committing global session 0x500000589e20000

Zookeeper3_1 | 2020-04-18 10:26:10,071 [myid:3] - WARN [QuorumPeer[myid=3](plain=0.0.0.0:2181)(secure=disabled):Follower@170] - Got zxid 0x500000001 expected 0x1

Zookeeper4_1 | 2020-04-18 10:26:10,098 [myid:4] - INFO [SyncThread:4:FileTxnLog@284] - Creating new log file: log.500000001

Zookeeper3_1 | 2020-04-18 10:26:10,109 [myid:3] - INFO [SyncThread:3:FileTxnLog@284] - Creating new log file: log.500000001

Zookeeper1_1 | 2020-04-18 10:26:10,113 [myid:1] - INFO [CommitProcessor:1:LearnerSessionTracker@116] - Committing global session 0x100000589b30000

Zookeeper2_1 | 2020-04-18 10:26:10,126 [myid:2] - INFO [CommitProcessor:2:LearnerSessionTracker@116] - Committing global session 0x100000589b30000

Zookeeper2_1 | 2020-04-18 10:26:10,141 [myid:2] - INFO [CommitProcessor:2:LearnerSessionTracker@116] - Committing global session 0x200000589b20000

Zookeeper4_1 | 2020-04-18 10:26:10,144 [myid:4] - INFO [CommitProcessor:4:LearnerSessionTracker@116] - Committing global session 0x500000589e20000

Zookeeper3_1 | 2020-04-18 10:26:10,137 [myid:3] - INFO [CommitProcessor:3:LearnerSessionTracker@116] - Committing global session 0x500000589e20000

Zookeeper1_1 | 2020-04-18 10:26:10,171 [myid:1] - INFO [CommitProcessor:1:LearnerSessionTracker@116] - Committing global session 0x200000589b20000

Zookeeper3_1 | 2020-04-18 10:26:10,199 [myid:3] - INFO [CommitProcessor:3:LearnerSessionTracker@116] - Committing global session 0x100000589b30000

Zookeeper4_1 | 2020-04-18 10:26:10,176 [myid:4] - INFO [CommitProcessor:4:LearnerSessionTracker@116] - Committing global session 0x100000589b30000

Zookeeper4_1 | 2020-04-18 10:26:10,202 [myid:4] - INFO [CommitProcessor:4:LearnerSessionTracker@116] - Committing global session 0x200000589b20000

Zookeeper3_1 | 2020-04-18 10:26:10,203 [myid:3] - INFO [CommitProcessor:3:LearnerSessionTracker@116] - Committing global session 0x200000589b20000

Zookeeper4_1 | 2020-04-18 10:26:10,204 [myid:4] - INFO [CommitProcessor:4:LearnerSessionTracker@116] - Committing global session 0x200000589b20001

Zookeeper4_1 | 2020-04-18 10:26:10,209 [myid:4] - INFO [CommitProcessor:4:LearnerSessionTracker@116] - Committing global session 0x200000589b20002

Zookeeper2_1 | 2020-04-18 10:26:10,224 [myid:2] - INFO [CommitProcessor:2:LearnerSessionTracker@116] - Committing global session 0x200000589b20001

Zookeeper3_1 | 2020-04-18 10:26:10,227 [myid:3] - INFO [CommitProcessor:3:LearnerSessionTracker@116] - Committing global session 0x200000589b20001

Zookeeper3_1 | 2020-04-18 10:26:10,241 [myid:3] - INFO [CommitProcessor:3:LearnerSessionTracker@116] - Committing global session 0x200000589b20002

Zookeeper2_1 | 2020-04-18 10:26:10,243 [myid:2] - INFO [CommitProcessor:2:LearnerSessionTracker@116] - Committing global session 0x200000589b20002

Zookeeper5_1 | 2020-04-18 10:26:10,245 [myid:5] - INFO [CommitProcessor:5:LeaderSessionTracker@104] - Committing global session 0x100000589b30000

Zookeeper5_1 | 2020-04-18 10:26:10,260 [myid:5] - INFO [CommitProcessor:5:LeaderSessionTracker@104] - Committing global session 0x200000589b20000

Zookeeper5_1 | 2020-04-18 10:26:10,270 [myid:5] - INFO [CommitProcessor:5:LeaderSessionTracker@104] - Committing global session 0x200000589b20001

Zookeeper5_1 | 2020-04-18 10:26:10,307 [myid:5] - INFO [CommitProcessor:5:LeaderSessionTracker@104] - Committing global session 0x200000589b20002

Zookeeper1_1 | 2020-04-18 10:26:10,403 [myid:1] - INFO [CommitProcessor:1:LearnerSessionTracker@116] - Committing global session 0x200000589b20001

Zookeeper1_1 | 2020-04-18 10:26:10,407 [myid:1] - INFO [CommitProcessor:1:LearnerSessionTracker@116] - Committing global session 0x200000589b20002

开始操作

docker exec -it kafka_Kafka1_1 bash

cd /opt/kafka/bin

ls

我们可以看到一大堆东西

connect-distributed.sh kafka-console-producer.sh kafka-log-dirs.sh kafka-server-start.sh windows

connect-mirror-maker.sh kafka-consumer-groups.sh kafka-mirror-maker.sh kafka-server-stop.sh zookeeper-security-migration.sh

connect-standalone.sh kafka-consumer-perf-test.sh kafka-preferred-replica-election.sh kafka-streams-application-reset.sh zookeeper-server-start.sh

kafka-acls.sh kafka-delegation-tokens.sh kafka-producer-perf-test.sh kafka-topics.sh zookeeper-server-stop.sh

kafka-broker-api-versions.sh kafka-delete-records.sh kafka-reassign-partitions.sh kafka-verifiable-consumer.sh zookeeper-shell.sh

kafka-configs.sh kafka-dump-log.sh kafka-replica-verification.sh kafka-verifiable-producer.sh

kafka-console-consumer.sh kafka-leader-election.sh kafka-run-class.sh trogdor.sh

指定Zookeeper1,看看消息,结果啥都没有,因为kafka中没有消息

kafka-topics.sh --zookeeper Zookeeper1:2181 --list创建主题, --topic 定义topic名字,--replication-factor定义副本数量,--partitions定义分区数量, 我们创建3个副本一个分区的主题first

kafka-topics.sh --zookeeper Zookeeper1:2181 --create --replication-factor 3 --partitions 1 --topic first看到输出

Created topic first.然后使用kafka-topics.sh --zookeeper Zookeeper1:2181 --list就可以看到输出了一个first

first现在我们回到docker外面的宿主机的终端

cd ~/DockerDesktop/Kafka

ls node1/kafka-logs-Kafka1/ node2/kafka-logs-Kafka2 node3/kafka-logs-Kafka3 node4/kafka-logs-Kafka4 node5/kafka-logs-Kafka5得到了输出,由此可见,我们的node3,node4,node5上分别保留了first的副本,这里还有一个细节,我们现在是在kafka1上执行的命令,这也能说明我们的集群是搭建成功了的

node1/kafka-logs-Kafka1/:

cleaner-offset-checkpoint log-start-offset-checkpoint meta.properties recovery-point-offset-checkpoint replication-offset-checkpoint

node2/kafka-logs-Kafka2:

cleaner-offset-checkpoint log-start-offset-checkpoint meta.properties recovery-point-offset-checkpoint replication-offset-checkpoint

node3/kafka-logs-Kafka3:

cleaner-offset-checkpoint first-0 log-start-offset-checkpoint meta.properties recovery-point-offset-checkpoint replication-offset-checkpoint

node4/kafka-logs-Kafka4:

cleaner-offset-checkpoint first-0 log-start-offset-checkpoint meta.properties recovery-point-offset-checkpoint replication-offset-checkpoint

node5/kafka-logs-Kafka5:

cleaner-offset-checkpoint first-0 log-start-offset-checkpoint meta.properties recovery-point-offset-checkpoint replication-offset-checkpoint

然后我们回到docker中,多来几次

kafka-topics.sh --zookeeper Zookeeper2:2181 --create --replication-factor 3 --partitions 1 --topic second

kafka-topics.sh --zookeeper Zookeeper3:2181 --create --replication-factor 3 --partitions 1 --topic third

kafka-topics.sh --zookeeper Zookeeper4:2181 --create --replication-factor 3 --partitions 1 --topic four

kafka-topics.sh --zookeeper Zookeeper5:2181 --create --replication-factor 3 --partitions 1 --topic five最后再查看宿主机中的磁盘映射,这里一切正常,并且访问zookeeper集群中的任意一台机器都可行

node1/kafka-logs-Kafka1/:

cleaner-offset-checkpoint log-start-offset-checkpoint recovery-point-offset-checkpoint second-0

five-0 meta.properties replication-offset-checkpoint third-0

node2/kafka-logs-Kafka2:

cleaner-offset-checkpoint log-start-offset-checkpoint recovery-point-offset-checkpoint second-0

four-0 meta.properties replication-offset-checkpoint

node3/kafka-logs-Kafka3:

cleaner-offset-checkpoint five-0 log-start-offset-checkpoint recovery-point-offset-checkpoint

first-0 four-0 meta.properties replication-offset-checkpoint

node4/kafka-logs-Kafka4:

cleaner-offset-checkpoint five-0 meta.properties replication-offset-checkpoint third-0

first-0 log-start-offset-checkpoint recovery-point-offset-checkpoint second-0

node5/kafka-logs-Kafka5:

cleaner-offset-checkpoint four-0 meta.properties replication-offset-checkpoint

first-0 log-start-offset-checkpoint recovery-point-offset-checkpoint third-0全删掉

kafka-topics.sh --delete --zookeeper Zookeeper1:2181 --topic first

kafka-topics.sh --delete --zookeeper Zookeeper1:2181 --topic second

kafka-topics.sh --delete --zookeeper Zookeeper1:2181 --topic third

kafka-topics.sh --delete --zookeeper Zookeeper1:2181 --topic four

kafka-topics.sh --delete --zookeeper Zookeeper1:2181 --topic five看到输出,在我的集群中,我发先几秒钟后,就被删干净了

Topic first is marked for deletion.

Note: This will have no impact if delete.topic.enable is not set to true.为了后续的操作,我们重新创建一个新的主题

kafka-topics.sh --zookeeper Zookeeper5:2181 --create --replication-factor 3 --partitions 2 --topic first随便起一台Kafka1, 作为生产者, 这里可以用localhost是因为他自己就是集群的一部分

kafka-console-producer.sh --topic first --broker-list localhost:9092再起另外一台Kafka2作为消费者,这台就开始等待了

kafka-console-consumer.sh --topic first --bootstrap-server localhost:9092在生成者中输出>hello I am producer, 我们就能在消费者中看到,那么过时的消费者怎么办呢?我们使用上面的指令再起一台消费者Kafka3, 发现他并不能收到hello那条消息了,在生成者中输入>this is the second msg,发现kafka2和kafka3都可以收到消息,然后我们使用下面的指令再其一台Kafka4,等待片刻,发现kafka4收到了所有的消息

kafka-console-consumer.sh --topic first --bootstrap-server localhost:9092 --from-beginning在宿主机中输入

ls node1/kafka-logs-Kafka1/ node2/kafka-logs-Kafka2 node3/kafka-logs-Kafka3 node4/kafka-logs-Kafka4 node5/kafka-logs-Kafka5得到输出,可以看到offsets是轮流保存的, 因为分区是为了负载均衡,而备份是为了容错

node1/kafka-logs-Kafka1/:

__consumer_offsets-14 __consumer_offsets-29 __consumer_offsets-4 __consumer_offsets-9 log-start-offset-checkpoint replication-offset-checkpoint

__consumer_offsets-19 __consumer_offsets-34 __consumer_offsets-44 cleaner-offset-checkpoint meta.properties

__consumer_offsets-24 __consumer_offsets-39 __consumer_offsets-49 first-1 recovery-point-offset-checkpoint

node2/kafka-logs-Kafka2:

__consumer_offsets-0 __consumer_offsets-20 __consumer_offsets-35 __consumer_offsets-5 log-start-offset-checkpoint replication-offset-checkpoint

__consumer_offsets-10 __consumer_offsets-25 __consumer_offsets-40 cleaner-offset-checkpoint meta.properties

__consumer_offsets-15 __consumer_offsets-30 __consumer_offsets-45 first-0 recovery-point-offset-checkpoint

node3/kafka-logs-Kafka3:

__consumer_offsets-13 __consumer_offsets-28 __consumer_offsets-38 __consumer_offsets-8 log-start-offset-checkpoint replication-offset-checkpoint

__consumer_offsets-18 __consumer_offsets-3 __consumer_offsets-43 cleaner-offset-checkpoint meta.properties

__consumer_offsets-23 __consumer_offsets-33 __consumer_offsets-48 first-0 recovery-point-offset-checkpoint

node4/kafka-logs-Kafka4:

__consumer_offsets-1 __consumer_offsets-21 __consumer_offsets-36 __consumer_offsets-6 first-1 recovery-point-offset-checkpoint

__consumer_offsets-11 __consumer_offsets-26 __consumer_offsets-41 cleaner-offset-checkpoint log-start-offset-checkpoint replication-offset-checkpoint

__consumer_offsets-16 __consumer_offsets-31 __consumer_offsets-46 first-0 meta.properties

node5/kafka-logs-Kafka5:

__consumer_offsets-12 __consumer_offsets-22 __consumer_offsets-37 __consumer_offsets-7 log-start-offset-checkpoint replication-offset-checkpoint

__consumer_offsets-17 __consumer_offsets-27 __consumer_offsets-42 cleaner-offset-checkpoint meta.properties

__consumer_offsets-2 __consumer_offsets-32 __consumer_offsets-47 first-1 recovery-point-offset-checkpoint查看zk中的数据,起一台zk,执行zkCli.sh, 再执行ls /, 其中除了zookeeper文件以外,其他的数据都是Kafka的,部分终端显示如下

Welcome to ZooKeeper!

2020-04-19 07:03:58,554 [myid:localhost:2181] - INFO [main-SendThread(localhost:2181):ClientCnxn$SendThread@1154] - Opening socket connection to server localhost/127.0.0.1:2181.

2020-04-19 07:03:58,557 [myid:localhost:2181] - INFO [main-SendThread(localhost:2181):ClientCnxn$SendThread@1156] - SASL config status: Will not attempt to authenticate using SASL (unknown error)

JLine support is enabled

2020-04-19 07:03:58,638 [myid:localhost:2181] - INFO [main-SendThread(localhost:2181):ClientCnxn$SendThread@986] - Socket connection established, initiating session, client: /127.0.0.1:41878, server: localhost/127.0.0.1:2181

2020-04-19 07:03:58,690 [myid:localhost:2181] - INFO [main-SendThread(localhost:2181):ClientCnxn$SendThread@1420] - Session establishment complete on server localhost/127.0.0.1:2181, session id = 0x1000223de0e000b, negotiated timeout = 30000

WATCHER::

WatchedEvent state:SyncConnected type:None path:null

[zk: localhost:2181(CONNECTED) 0] ls /

[admin, brokers, cluster, config, consumers, controller, controller_epoch, isr_change_notification, latest_producer_id_block, log_dir_event_notification, zookeeper]

面向主题,消息按照主题分类,生产者生产消息,消费者消费消息

topic是逻辑概念, partition是物理概念,因为文件夹是用topic+parttiton命名的 查看first-0的文件内容, 0000.log实际上存的是数据,不是日志

bash-4.4# ls