A curated list of language moment retrieval and related area. :-)

从CVPR16开始,学术界开始关注phrase grounding(i.e. object referring),即给一个query,在image中找到找个query对应的object。2017,2018年,大家也逐渐开始关注video中类似的grounding问题,可以被总结为 Grounding Actions and Objects by Language in Videos。Grounding这个词可能不完全准确,很多论文对这个任务都有不同的定义,如Localizing Moments in Video with Natural Language、Retrieval via Natural Language Queries等等。这里统一简写为Language Moment Retrieval。(这里默认针对视频任务)

以下论文总结主要分成两部分:

-

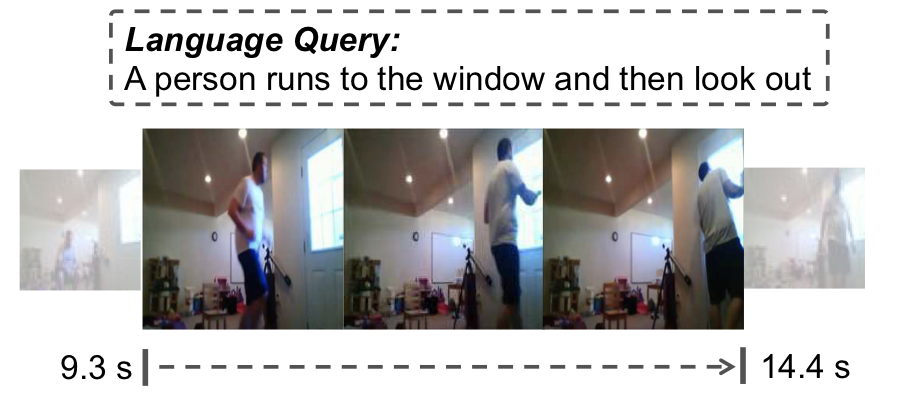

Temporal Activity Localization by Language:给定一个query(包含对activity的描述),找到对应动作(事件)的起止时间;

-

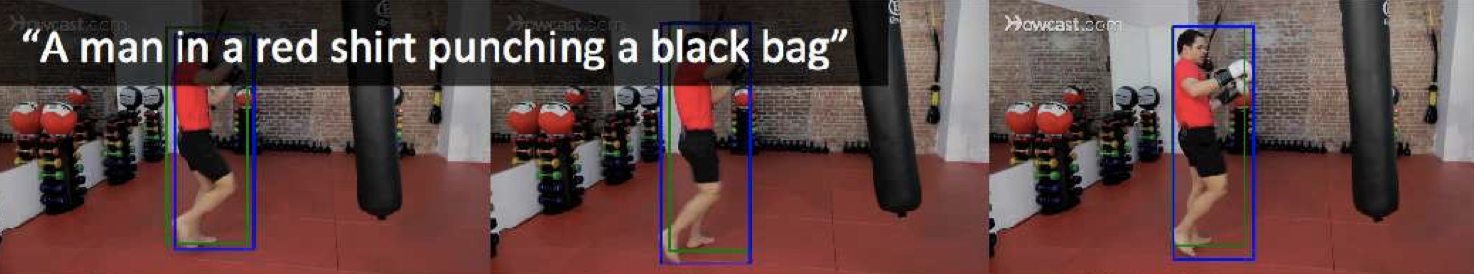

Spatio-temporal object referring by language: 给定一个query(包含对object/person的描述),在时空中找到连续的bounding box (也就是一个tube)。

Markdown format:

- [Paper Name](link) - Author 1 et al, `Conference Year`. [[code]](link)- Apr. 03 Just started.

- None.

-

Visual Semantic Search: Retrieving Videos via Complex Textual Queries - Dahua Lin et al,

CVPR 2014.

- None

- None

-

Where to Play: Retrieval of Video Segments using Natural-Language Queries - S. Lee et al,

arXiv 2017. -

Localizing Moments in Video with Natural Language - Lisa Anne Hendricks et al,

ICCV 2017. [code]简介

RGB与Optical Flow同时作为输入,损失函数为inter-intra video ranking loss。

标了一个新数据集,DiDeMo(把video切成了连续的长度为5s的片段,即 0s-5s 是第一个片段,5s-10s是第二个...,然后为这5s的片段添加语句描述,这样做其实降低了localization的难度,退化成了一个有限集合的retrieval问题)。DiDeMo中描述句的特性主要包含三个方面:相机视角(zoom,pan,cameraman)、时间关系(after,first)和空间关系(left,bottom)。且动词所占比例较多,这种设计**基于在定位过程中对算法行为的理解是非常重要的。

Moment Context Network(MCN)对于复杂的描述仍定位困难,如“dog stops, then starts rolling around again”,如何更好的推理语言描述中的语义是一个潜在的改进方向。

-

TALL: Temporal Activity Localization via Language Query - Jiyang Gao et al,

ICCV 2017. [code].简介

整个流程分为三步:

- C3D生成 visual feature;

- skip-thought / LSTM生成sentence embedding;

- 将两部分的feature融合在一起 然后生成alignment score和boundary offset。alignment score代表了输入的query和clip是否匹配,boundary offset调整了 输入clip的边界。

数据集方面:

- 基于TACoS提供了Charades的语句标注,名为Charades-STA2;

- 新数据集,DiDeMo(把video切成了连续的长度为5s的片段,即 0s-5s 是第一个片段,5s-10s是第二个...,然后为这5s的片段添加语句描述,这样做其实降低了localization的难度,退化成了一个有限集合的retrieval问题);

- Activitynet-Caption也提供了时序的语句标注,这个数据集本来是为dense video captioning准备的,但也可以用来做language based localization这个问题。

-

Spatio-temporal Person Retrieval via Natural Language Queries - M. Yamaguchi et al,

ICCV 2017. [code]

-

Find and Focus: Retrieve and Localize Video Events with Natural Language Queries - Dian Shao et al,

ECCV 2018.简介

港中文的工作。

Find and Focus(FIFO)模型整体分为两个部分:

- Find:top-level matching(paragraph vs video),可以非常高效地滤除数据库中不相关的视频;

- Focus:part-level association,以句为单位定位视频片段。

在定位过程中,得到双流特征后,用基于语义的TAG(Temporal Actionness Grouping)生成Clip Proposal,将Sentences与Clip之间的Cross-domain Matching问题转换为Linear Programming问题。

数据集采用ActivityNet Captions和Modified LSMDC。一些实验结果如下:

-

Object Referring in Videos with Language and Human Gaze - A. B. Vasudevan et al,

CVPR 2018. [code]. -

Actor and Action Video Segmentation from a Sentence - Kirill Gavrilyuk et al,

CVPR2018.

- MAN: Moment Alignment Network for Natural Language Moment Retrieval via Iterative Graph Adjustment - Da Zhang et al,

CVPR 2019. - Peeking into the Future: Predicting Future Person Activities and Locations in Videos - Junwei Liang et al,

CVPR 2019.

- None.

- None.

- None.

To the extent possible under law, muketong all copyright and related or neighboring rights to this work.