收录实现中文版ChatGPT的各种开源技术路线,数据及其他资料

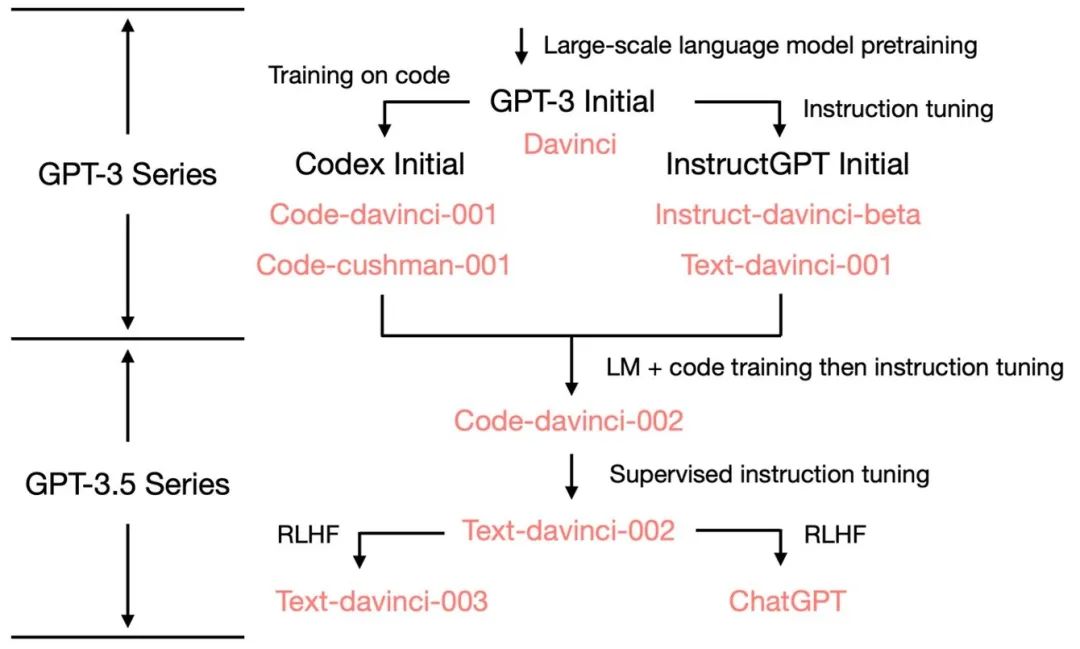

Three steps to ChatGPT:

- LLM-pretrain

- Instruction tuning and code continual pretrain

- RLHF (SFT, RM, PPO-RL)

具体技术可参考 dalinvip/Awesome-ChatGPT

- BELLE指令微调数据集(1.5M)

- BELLE10M中文数据集, 包含0.25M数学指令数据集和0.8M多轮任务对话数据集

- InstructionWild: Colossal AI 收集的中英双语数据集(104K)

- GPT-4-LLM: GPT-4标注的中英双语指令微调数据,prompt来自Stanford Alpaca。

- ShareGPT: ChatGPT用户分享的聊天数据,大部分为英文数据,插件维护者目前已经关闭了公开获取数据的接口。

- CAMEL: 对话式指令跟随数据集,并将英文数据翻译到10种包含中文的不同语言。

- OASST1: OpenAssistant Conversations,一个人工生成的、人工注释的助理式对话语料库,由 35 种不同语言的 161,443 条消息组成。包含少量中文语料。

参照Stanford Alpaca(SFT only),对BLOOMZ和LLAMA进行微调。

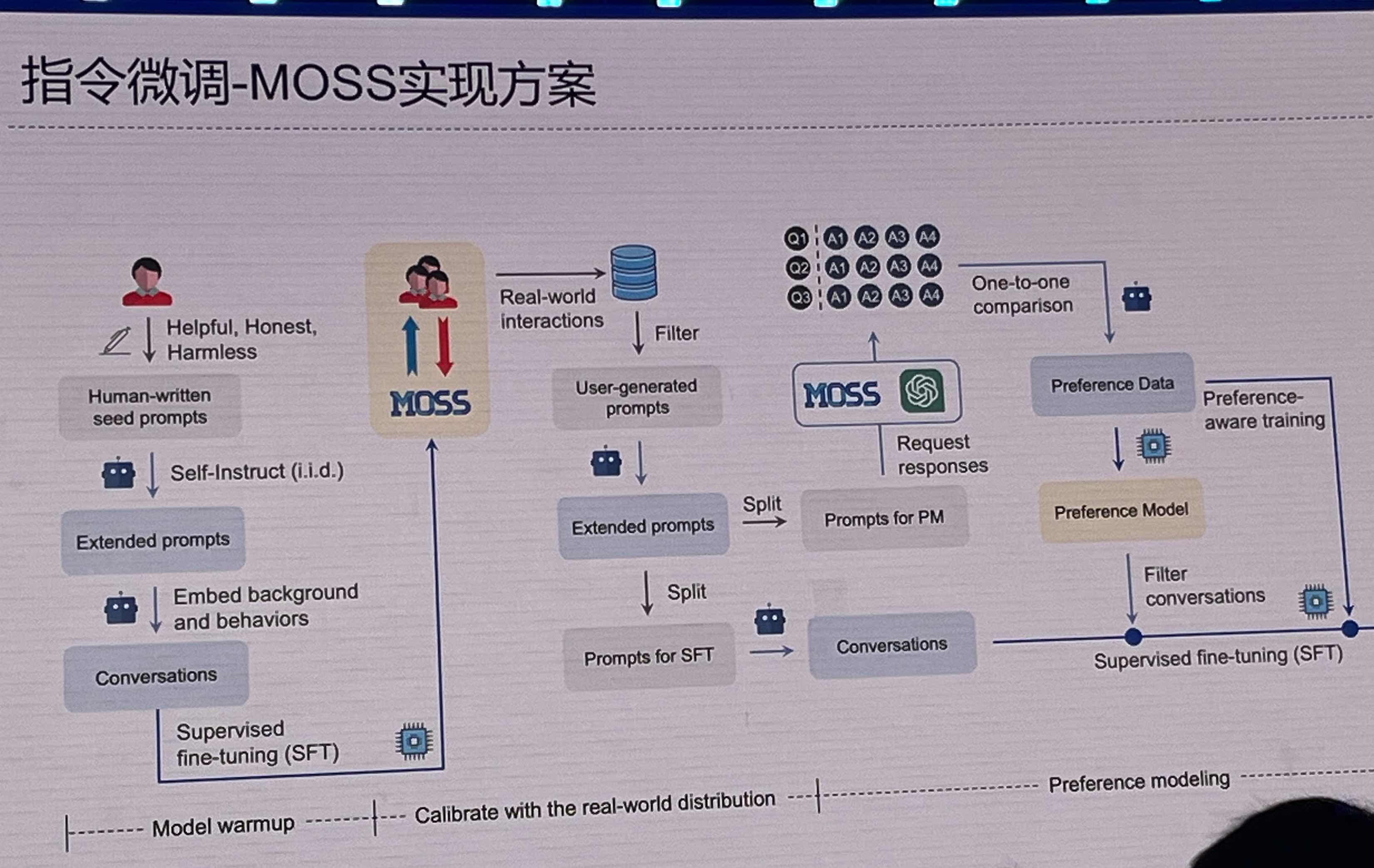

复旦大学团队研发的实现方案,图来自邱老师的分享。(Backbone为20B大模型)

清华大学团队基于GLM的实现方案,其6B模型已公布权重。

Colossal-AI实现RLHF for LLM方案(基于LLaMA)。

微软基于DeepSpeed开源的简单、快速且经济实惠的RLHF训练方案。

LLaMA: Open and Efficient Foundation Language Models,Facebook/Meta开源的LLM,中文词表较小。

Huggingface开源的LLM模型。

清华大学开源的使用自回归填空目标进行预训练的通用语言模型GLM

其余优秀开源项目,大部分为纯英文

- Stanford Alpaca: LLAMA-7B SFT

- Vicuna: LLAMA-7b&13B SFT,数据来自ShareGPT

- Baize: LLAMA聊天微调,数据采集自ChatGPT self-chat

- LoRA: popular低成本LLM参数高效微调方案,已集成到PEFT

- self-instruct: 低成本收集指令微调数据

- UltraChat: ChatGPT生成的多轮对话数据集,目前只包含英文。

- Dolly: 基于EleutherAI/pythia-12b的指令微调,包含首个开源的人工标注指令微调数据集。

- Open-Assistant: 一个旨在让每个人都能访问基于聊天的大型语言模型的项目。

如果你创建或发现了任何关于实现中文ChatGPT的优秀资源,请创建Issue或PR来贡献这个仓库!

If you created or found any awesome resource about Chinese ChatGPT, feel free to create issues or PRs to contribute to this repository!