使用 PaddlePaddle 实现基于深度神经网络的中文分词引擎

BiLSTM+CRF

Python 3.5+

从 PYPI 安装:

pip install paddle_tokenizer或者本地安装:

pip install -e ./下载 release 中的模型文件,解压缩后将目录 test.inference.model 放置到本项目的根目录下即可。

见 人民日报语料处理工具集,将 conll 格式的 train.txt 和 test.txt 放到 data 目录下。

python -m paddle_tokenizer.train在 2017 款 MacBook Pro (2.5 GHz Intel Core i7) 上训练耗时约十分钟。

from paddle_tokenizer.server import server

result = server("王小明在北京的清华大学读书。")

print(result)输出:

['王', '小明', '在', '北京', '的', '清华', '大学', '读书', '。']

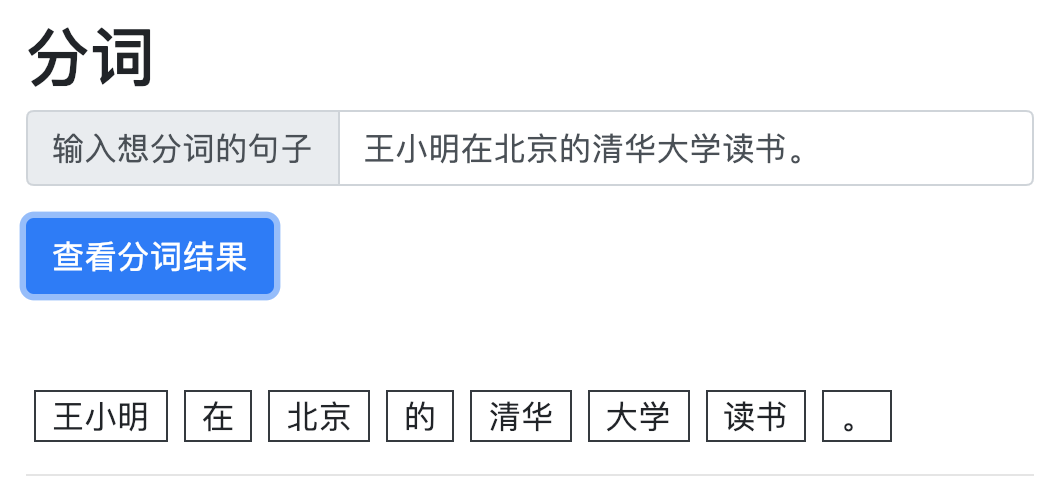

为了更好的展现推理效果,本项目将 PaddleTokenizer 做成了 Server+Browser 的 demo 形式

python ./http_server.py将会在在 localhost:5000 启动一个 HTTP 服务器,用户可以通过该 HTTP 端口使用 PaddleTokenizer,注意该网址只提供 API 不提供界面。

bash ./UI.sh将会在 localhost:8000 启动前端服务器,用户可以访问该网址,

打开页面:http://127.0.0.1:8000 即可,效果如下:

AGPL-3.0