https://cloud.google.com/sdk/docs/install?hl=ko

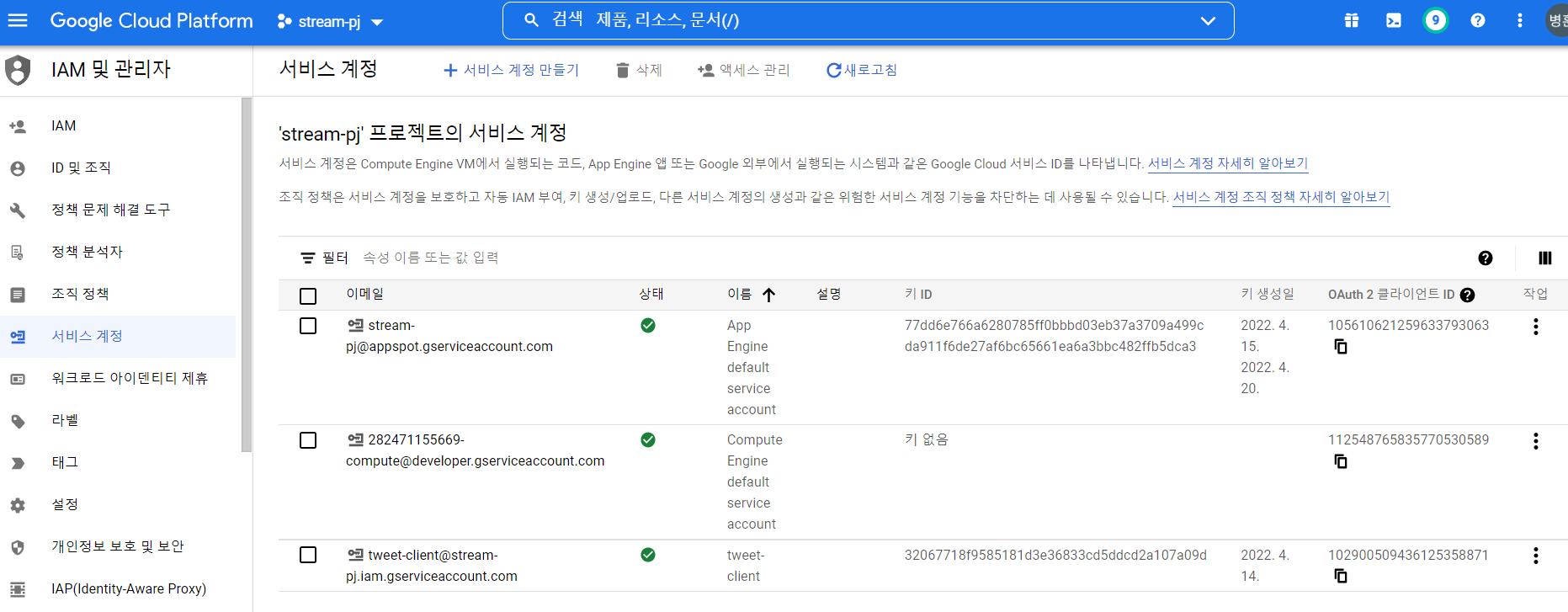

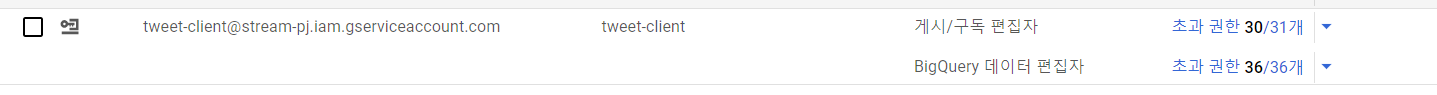

- pub/sub 편집, BigQuery 편집 권한 부여

- 권한 확인

https://docs.tweepy.org/ko/v3.9.0/getting_started.html

https://developer.twitter.com/en

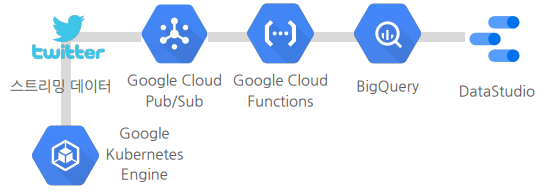

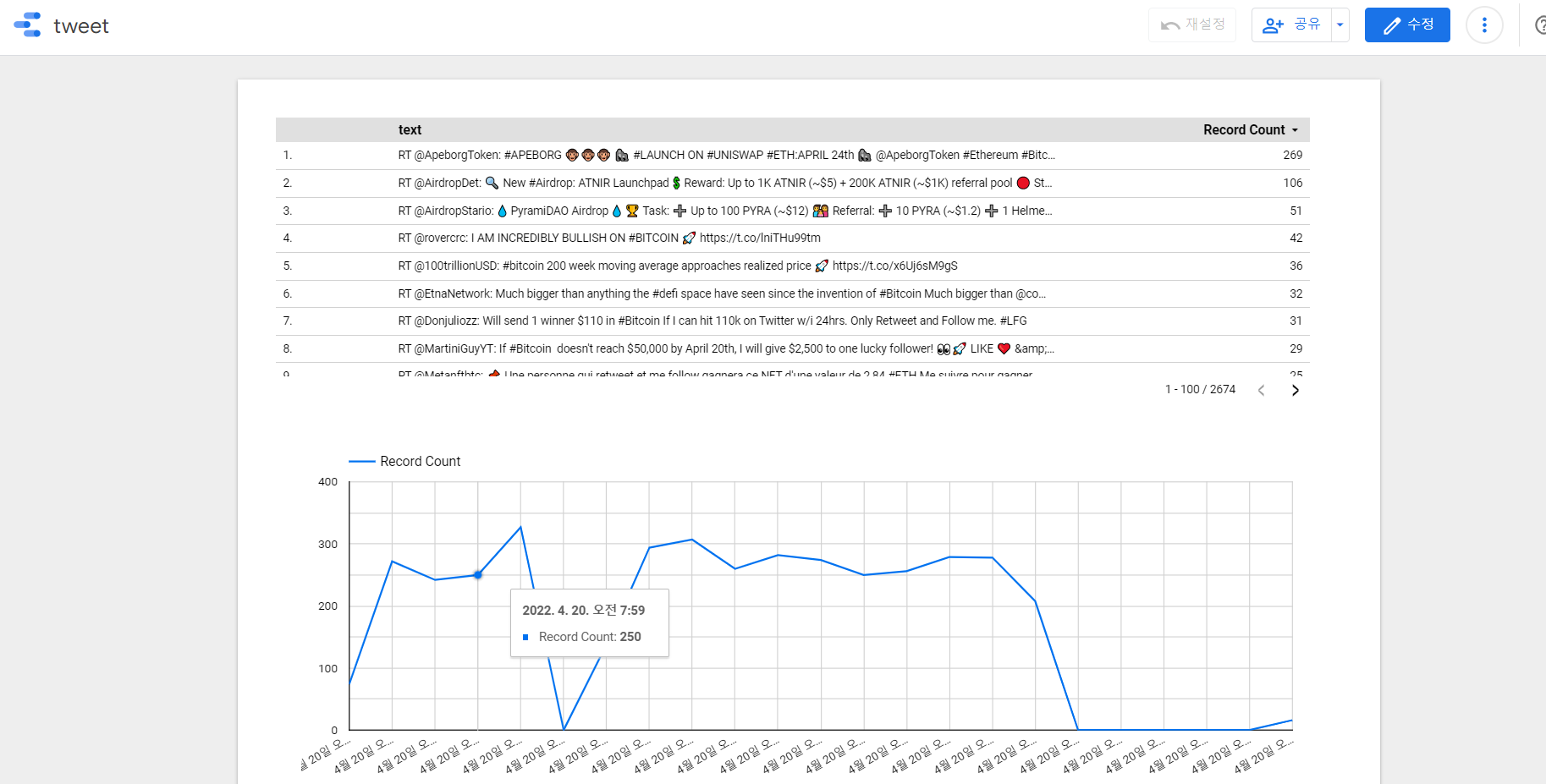

- developer를 통해 project와 key를 생성하고 tweepy API를 통해 트위터의 메세지를 실시간으로 수집

- bitcoin tag로 검색된 트윗 수집

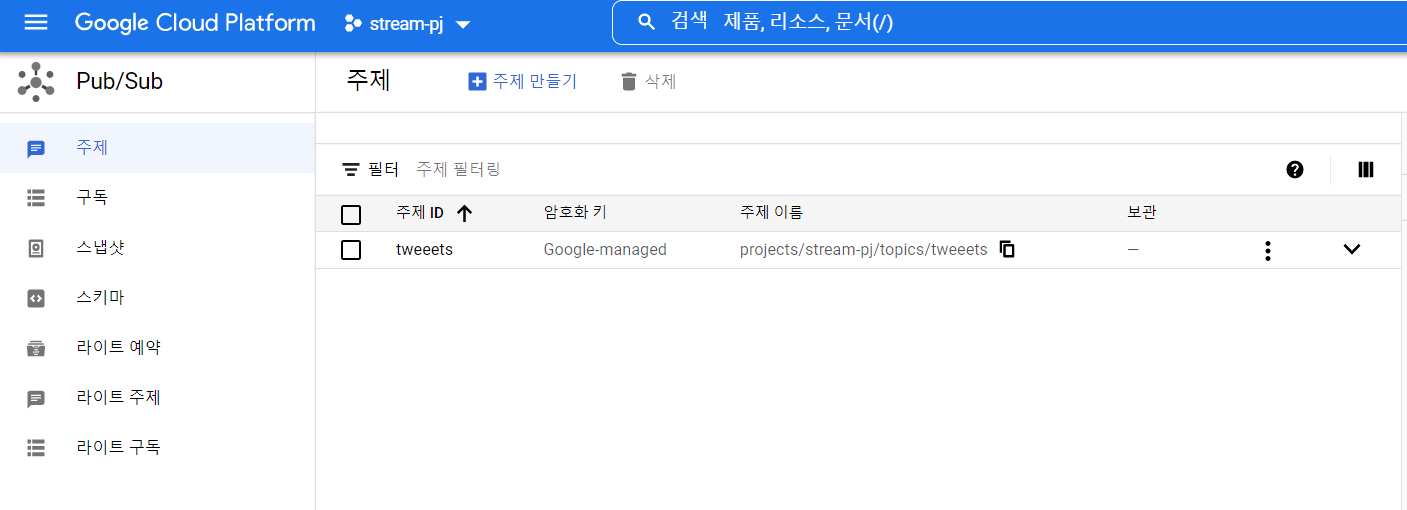

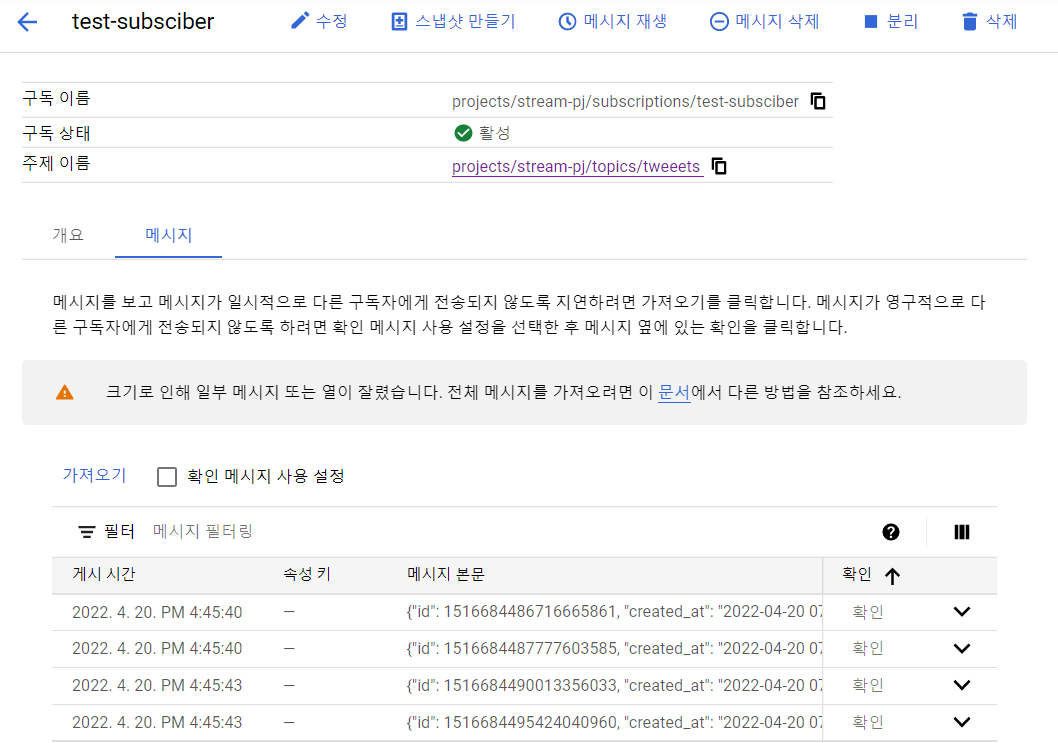

- 완전관리형 실시간 메시징 서비스

- 데이터를 수집하고 배포하는 스트리밍 분석 및 데이터 통합 파이프라인에 사용됨

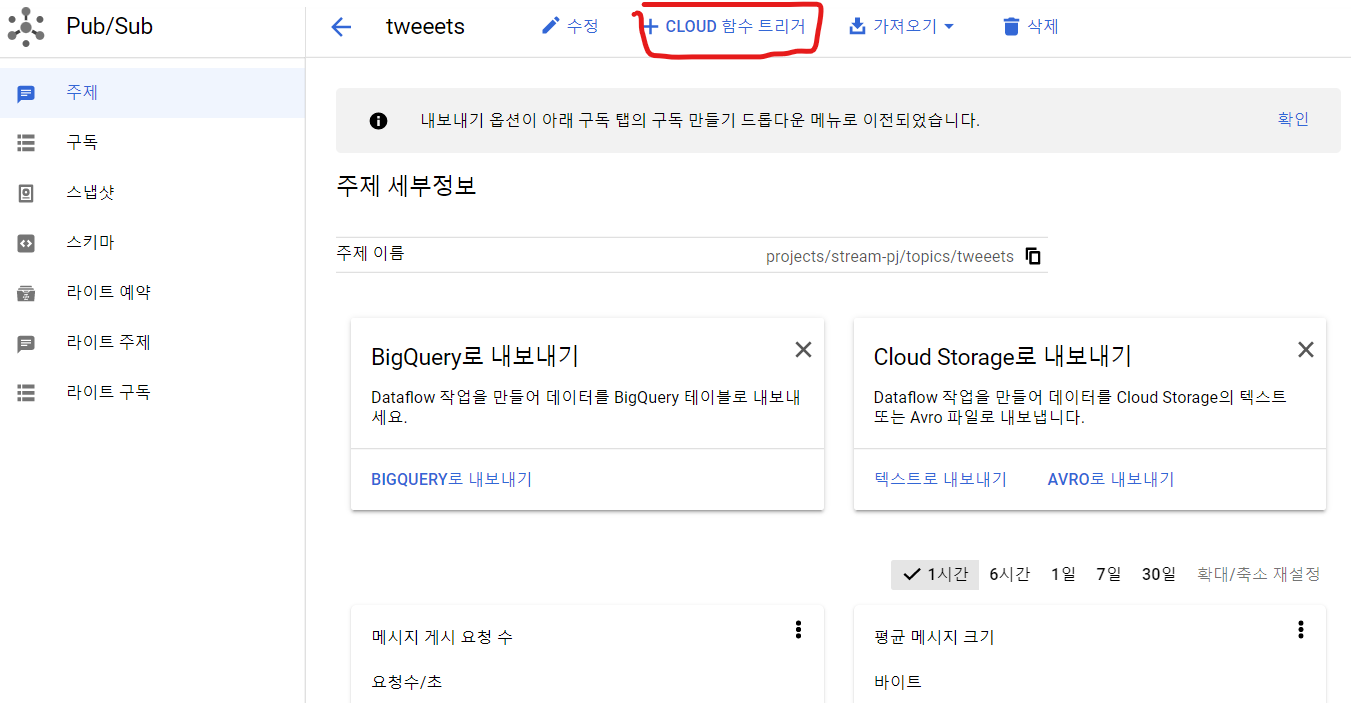

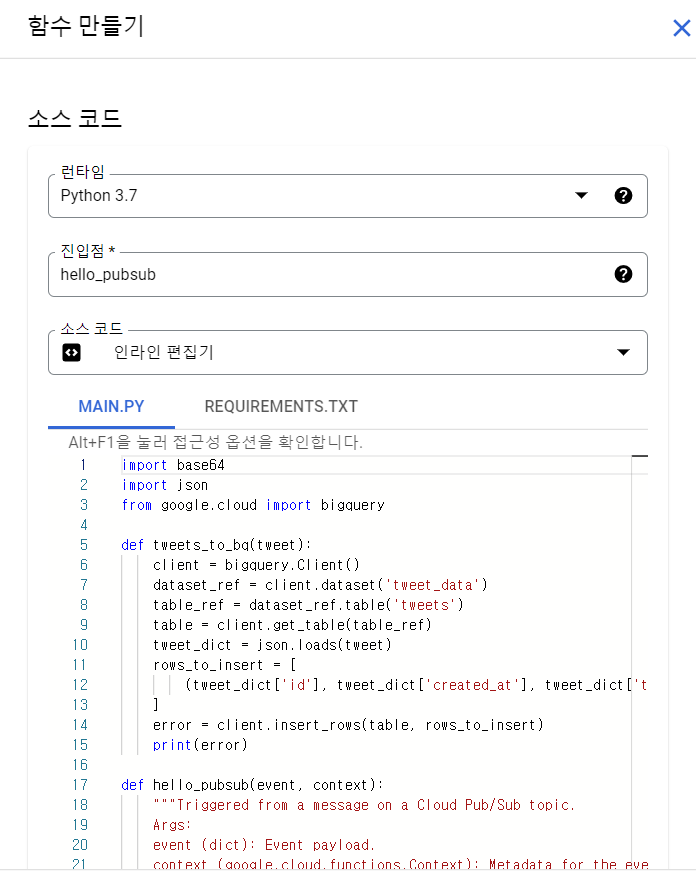

- 서비리스 제품, function 단위로 서버없이 사용가능

- 트리거 조건과 코드를 설정해놓으면, 원하는 동작을 자동으로 수행

- publish에 tweet이 들어왔을때 모아서 bigQuery로 넣는다.

-

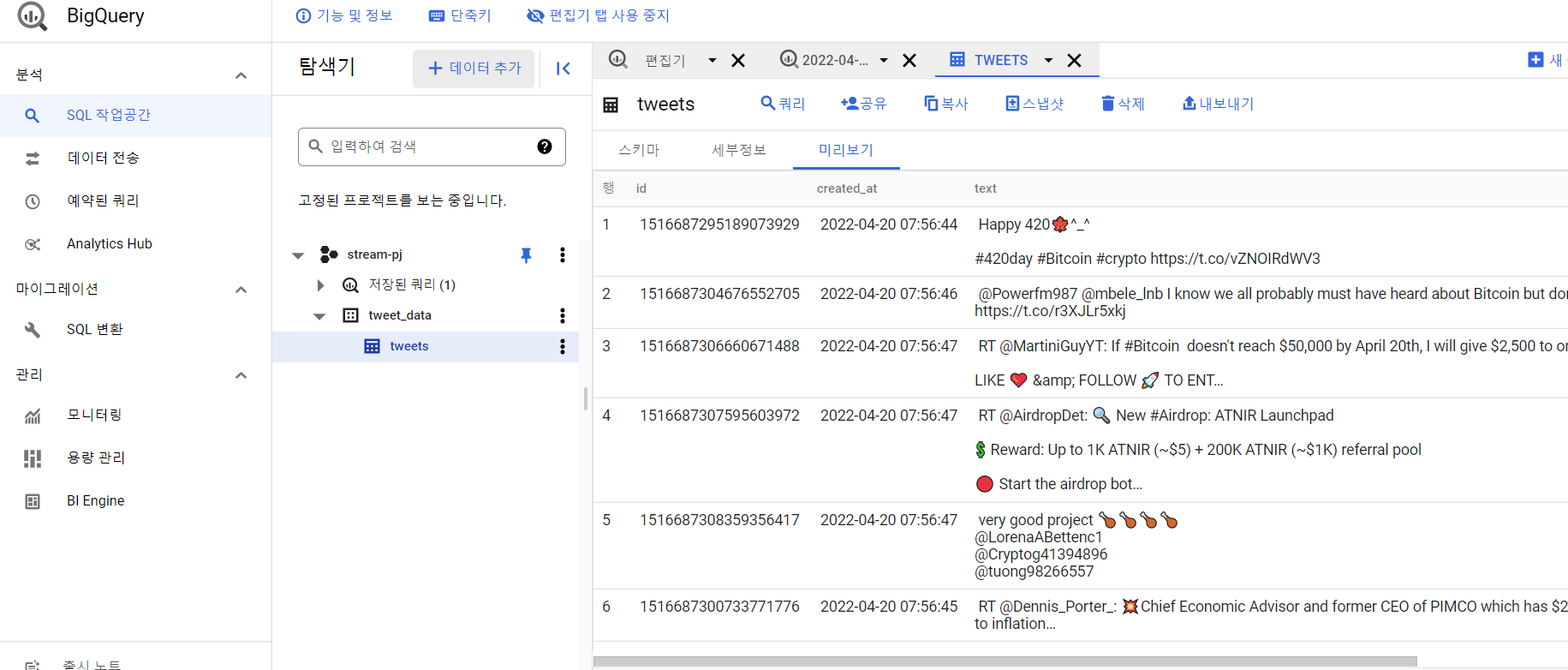

완전관리형 SQL데이터웨어하우스

-

매우큰데이터도매우저렴하게저장,빠른속도로처리가능

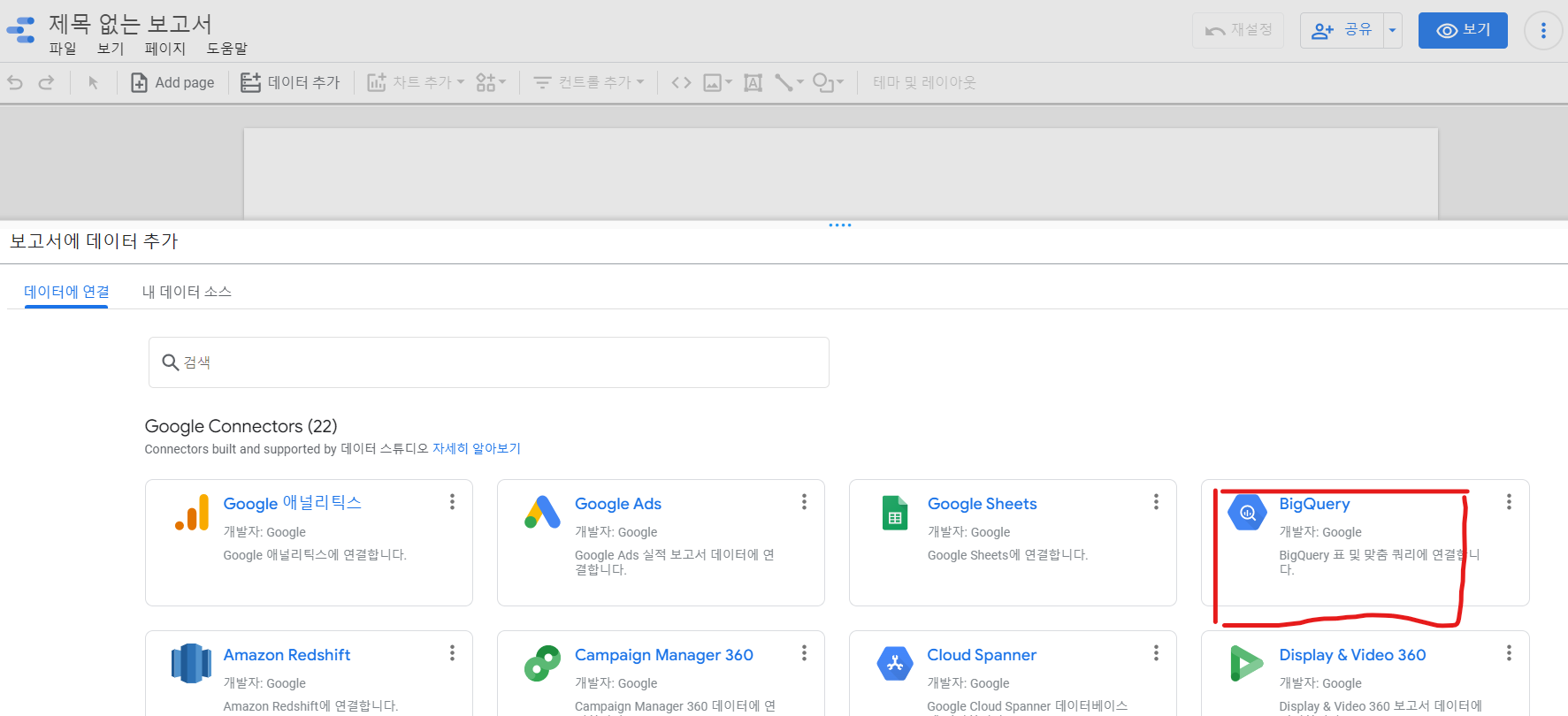

- 다양한 소스를 연결할 수 있는 대시보드 서비스

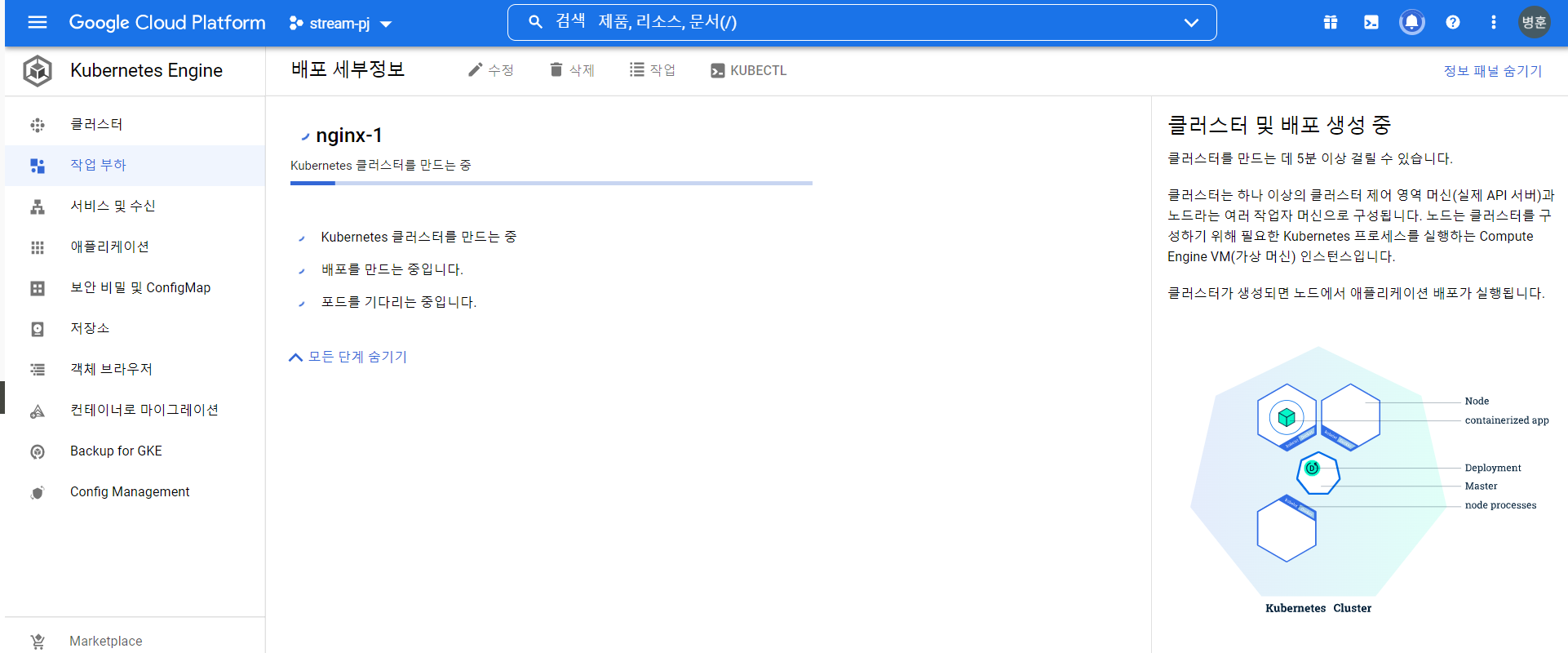

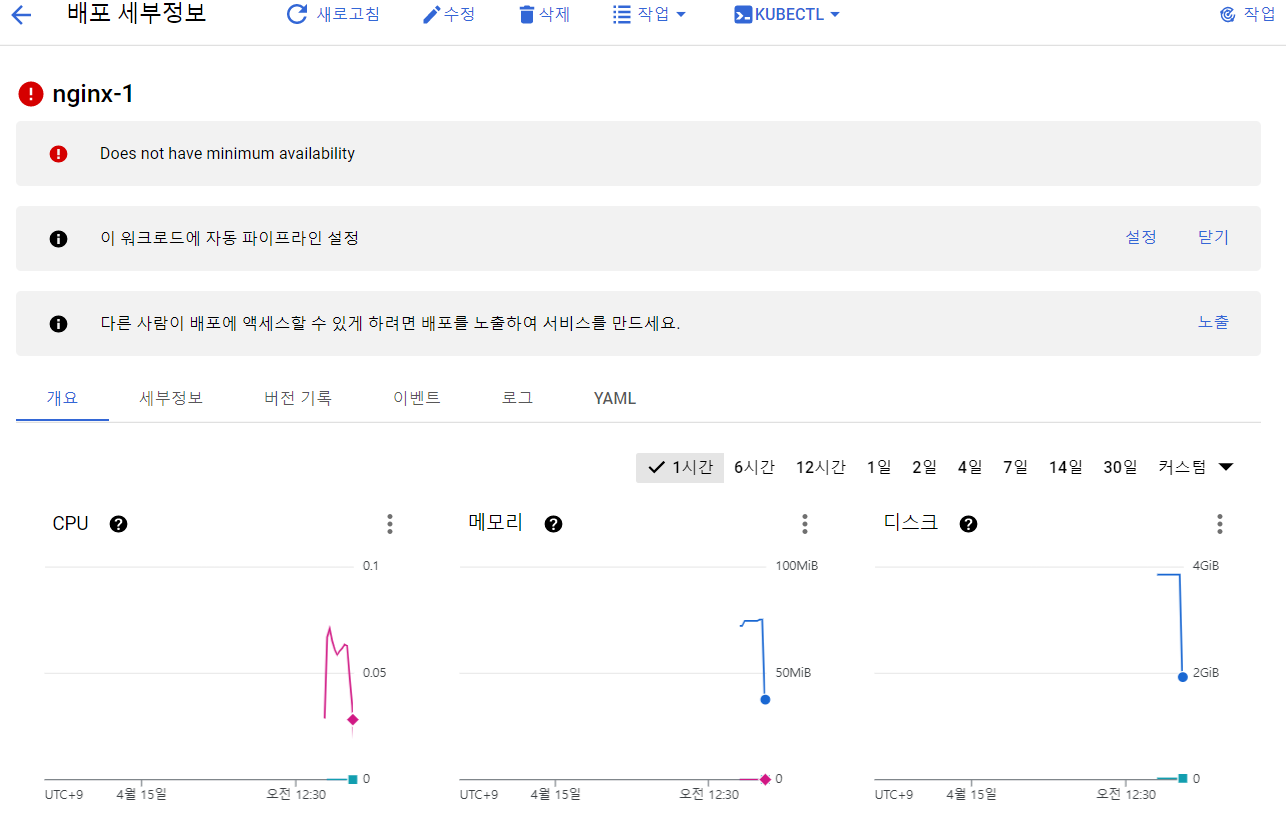

- 컨테이너를 쉽고 빠르게 배포/확장하고 관리를 자동화해주는 오픈소스 플랫폼

https://cloud.google.com/container-registry/docs/advanced-authentication#gcloud-helper

https://cloud.google.com/container-registry/docs/advanced-authentication#gcloud-helper

docker build -t tweet .

gcloud auth configure-docker

docker push gcr.io/[project_name]/tweet