京东官网 - https://www.jd.com

| Author | Gobi Xu |

|---|---|

| xusanity@aliyun.com |

- 这是个demo,需要什么类目,什么字段请自行增减

- 请求时不需要携带cookies(即不需要先登录),过程相对轻松

- 需要爬取的数据通过请求地址携带参数即可得到

pip install scrapy

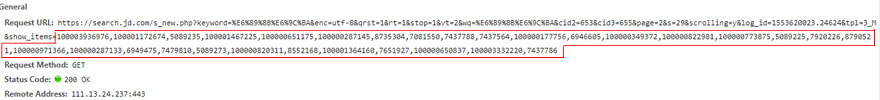

- 商品列表页后半部分是异步加载的

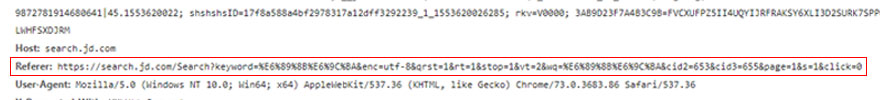

商品列表页的每一页都有60个商品,但是请求商品列表页时,只会显示前30个商品,剩下的30个商品是下滑商品列表页时异步加载出来的,使用抓包的方法可以截取到剩下的30个商品的请求地址,请求地址尾部包含了前30个商品的商品id,头部信息里的Referer为商品列表页的请求地址

- 请求地址的参数

商品列表页一共100页。第一页的请求地址中page参数为1,第一页的剩下30个商品的请求地址中page参数为2。第二页的请求地址中page参数为3,第二页的 剩下30个商品的请求地址中page参数为4....以此类推

📞手机

- 商品id (id)

- 商品标题 (title)

- 商品详情页网址 (url)

- 商品的网店名称 (shop_name)

- 商品价格 (price)

- 商品牌子 (brand)

- 商品型号 (model)

- 商品评论数量 (comment_count)

- 商品好评数 (good_count)

- 商品中评数 (general_count)

- 商品差评数 (poor_count)

- 商品展示数 (show_count)

- 对应的spider里有大量注释,请放心食用:meat_on_bone:

- 对应的类目在items.py里

- 如有任何问题都可以邮箱:email:联系我,我会尽快回复你。