LLMEval-3聚焦于专业知识能力评测,涵盖哲学、经济学、法学、教育学、文学、历史学、理学、工学、农学、医学、军事学、管理学、艺术学等教育部划定的13个学科门类、50余个二级学科,共计约20W道标准生成式问答题目(后续我们将继续收集题目将总题库扩充至100W)。

题目来源主要包括大学本科课后作业、大学本科期中期末考试、研究生入学考试等。为了尽可能的防止参与评测的大模型在预训练阶段引入大比例原始评测数据,LLMEval-3评测题目来源尽可能为非互联网公开渠道,数据格式为PDF和Word文件,经过一定的OCR识别与数据清洗之后,将题目进行格式化处理。针对于不同的题型,提供给待测试模型标准接口,实现全流程自动化。

与其他知识评测所采用的选择题模式不同,LLMEval-3中所有问题将统一处理为生成式知识问答形式,并尽可能包含多种题型,包括简答,计算、判断、辨析、写作等。相较于具有标准格式的选择题,LLMEval-3所采用的生成式知识问答,能够更好地反映用户实际需求以及模型语言能力。

防止作弊是LLMEval-3考虑的重要因素。现有公开评测基准存在测试题库泄露的问题,因此可能出现“刷榜”、“刷分”等不公平现象,在LLMEval-3中,每个参与评测的系统需要完成从总题库中随机抽样的1000题,针对同一机构的模型,确保每次评测题目不重复。评测过程将采用在线方式,一轮评测中题目的发送串行进行,即下一题的发送将会视上一道题目的回答情况而定,避免恶意爬取行为。

本轮评测采用自动评测方法打分,现在使用的评测模型是GPT4 Turbo。每道题得分的范围为0-3分。评分聚焦于回答的核心正确性和解释正确性,其中核心正确性作为衡量分数的主要指标。采用评测prompt如下所示:

Please evaluate the following response from the LLM regarding a discipline-specific question based on the following criteria. You must score it on a scale of 0, 1, 2 or 3 stars:

Overall Rating:

0 stars indicate wrong answer with a wrong explanation

1 star indicates wrong answer but a partially reasonable explanation

2 stars indicate a correct answer with a partially reasonable explanation

3 stars indicate a correct answer with a reasonable explanation

User: {question}

LLM:{answer_from_llm}

The correct answer to user’s question is: {correct_answer}

You must provide your feedback in the following format:

{"Overall Rating":numbers of its stars(int)}

为了规避由随机抽样1000题引入的系统偏差,LLMEval-3使用相对分数和绝对分数两个指标。

模型的相对分数定义为其绝对分数相比于GPT-3.5-turbo以及GPT-4在相同题目上取得的绝对分数的分位并映射到

模型的绝对分数是指模型在

为了清晰横向比较不同模型的学科能力,在现阶段评测中,我们在10个学科大类,每类学科抽取接近10%的题目进行评测,分别计算各个模型的相对得分、绝对得分与各学科得分。模型后面的数字代表着评测次数,以最优的结果为准,默认为1。

经过实验,我们采用GPT-4 Turbo(即gpt4-1106-preview)作为新的评测基准,新一期测试结果如下。全部模型采用GPT-4 Turbo进行评测,并将GPT-4 Turbo作为新的相对分数基准。

| 模型名称 | 访问方式 | 发布机构 | 评测日期 | 相对分数-GPT4 Turbo | 相对分数-GPT3.5 | 绝对分数 |

|---|---|---|---|---|---|---|

| GPT4 Turbo(gpt-4-1106-preview) | API | OpenAI | 2023.11.18 | 100 | 141.81 | 73.6 |

| gpt-4-0125-preview | API | OpenAI | 2024.1.28 | 97.28 | 137.96 | 71.6 |

| Baidu4.0 | API | 百度 | 2023.11.1 | 95.56 | 135.52 | 70.33 |

| Yi-34B-Chat | API | 零一万物 | 2023.12.1 | 89.27 | 126.59 | 65.70 |

| Baidu3.5 | API | 百度 | 2023.11.1 | 87.95 | 124.73 | 64.73 |

| ChatGLM-pro | API | Tsinghua&Zhipu.AI | 2023.11.1 | 87.95 | 124.73 | 64.73 |

| gpt4-0613 | API | OpenAI | 2023.9.29 | 84.19 | 119.4 | 61.97 |

| 讯飞星火大模型v3.0 | API | 科大讯飞 | 2023.11.7 | 83.51 | 118.43 | 61.47 |

| Nanbeige-plus(2) | API | NanBeiGe LLM Lab | 2023.12.1 | 86.68 | 117.47 | 61.00 |

| Baichuan2-13B-Chat | 权重 | Baichuan | 2023.9.29 | 74.18 | 105.2 | 54.6 |

| Gemini Pro | API | 2024.1.10 | 74.05 | 104.95 | 54.5 | |

| Qwen-plus | API | Alibaba Cloud | 2023.11.1 | 72.01 | 102.12 | 53.0 |

| Qwen-turbo | API | Alibaba Cloud | 2023.11.1 | 70.97 | 100.64 | 52.23 |

| Nanbeige-16B | API | NanBeiGe LLM Lab | 2023.10.23 | 70.56 | 100.06 | 51.93 |

| GPT-3.5-turbo | API | OpenAI | 2023.9.29 | 70.52 | 100 | 51.9 |

| minimax-abab5 | 权重 | minimax | 2023.11.1 | 70.43 | 99.87 | 51.83 |

| Mixtral--8x7B-Instruct | 权重 | Mistral AI | 2024.1.10 | 65.76 | 93.26 | 48.4 |

| ChatGLM2-6B | 权重 | Tsinghua&Zhipu.AI | 2023.9.29 | 53.85 | 76.36 | 39.63 |

| ziya_v1.1-13b | 权重 | IDEA研究院 | 2023.9.29 | 51.13 | 72.51 | 37.63 |

| InternLM-Chat-7B | 权重 | Shanghai AI Laboratory&Sense Time | 2023.9.29 | 49.28 | 69.88 | 36.27 |

| Linly-Chinese-LLaMA-2-13B-hf | 权重 | 大数据系统计算技术国家工程实验室 | 2023.10.3 | 47.15 | 66.86 | 34.7 |

| BELLE-Llama2-13B-chat-0.4M | 权重 | LianjiaTech | 2023.10.1 | 46.15 | 65.45 | 33.97 |

| Llama-2-7b-chat-hf | 权重 | Meta | 2023.9.29 | 32.11 | 45.54 | 23.63 |

各学科分数如下:

| 模型名称 | 绝对分数 | 工学 | 经济学 | 教育学 | 法学 | 文学 | 管理学 | 理学 | 历史学 | 医学 | 军事学 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| GPT4 Turbo(gpt-4-1106-preview) | 73.6 | 6.97 | 8.17 | 8.33 | 7.8 | 6.0 | 7.57 | 8.13 | 7.0 | 6.43 | 7.2 |

| gpt-4-10125-preview | 71.6 | 6.9 | 7.4 | 8.03 | 7.3 | 6.0 | 7.47 | 7.63 | 6.87 | 6.33 | 7.67 |

| Baidu4.0 | 70.33 | 7.27 | 7.23 | 7.67 | 7.43 | 5.63 | 6.47 | 6.8 | 7.63 | 7.8 | 6.4 |

| Yi-34B-Chat | 65.70 | 5.77 | 6.63 | 7.37 | 7.53 | 5.47 | 5.77 | 5.47 | 7.47 | 6.3 | 7.93 |

| Baidu3.5 | 64.73 | 6.2 | 6.7 | 7.8 | 6.83 | 5.2 | 5.5 | 6.0 | 7.23 | 6.57 | 6.7 |

| ChatGLM-pro | 64.73 | 5.9 | 7.07 | 7.03 | 7.9 | 5.43 | 6.33 | 5.0 | 6.67 | 5.97 | 7.43 |

| gpt4-0613 | 61.97 | 6.5 | 6.73 | 6.6 | 6.73 | 5.43 | 6.1 | 6.47 | 5.3 | 5.2 | 6.9 |

| 讯飞星火大模型v3.0 | 61.47 | 5.77 | 6.5 | 7.27 | 7.3 | 5.7 | 5.9 | 5.03 | 6.5 | 5.23 | 6.27 |

| Nanbeige-plus | 61.00 | 5.78 | 5.57 | 6.77 | 7.37 | 5.37 | 5.93 | 5.45 | 6.3 | 5.67 | 6.77 |

| Baichuan2-13B-Chat | 54.6 | 4.47 | 5.53 | 7.4 | 6.9 | 4.63 | 4.8 | 4.33 | 6.23 | 4.6 | 5.7 |

| Gemini Pro | 54.5 | 4.87 | 5.43 | 7.07 | 6.43 | 5.10 | 4.5 | 4.65 | 6.33 | 4.42 | 5.7 |

| Qwen-plus | 53.0 | 4.4 | 5.1 | 6.53 | 6.53 | 5.0 | 4.77 | 4.87 | 5.17 | 5.13 | 5.5 |

| Qwen-turbo | 52.23 | 4.1 | 6.07 | 6.63 | 6.43 | 4.43 | 4.53 | 4.97 | 5.27 | 4.37 | 5.43 |

| Nanbeige-16B | 51.93 | 4.37 | 5.3 | 6.5 | 6.3 | 3.97 | 4.7 | 4.07 | 5.9 | 4.73 | 6.1 |

| GPT-3.5-turbo | 51.9 | 4.97 | 5.37 | 6.4 | 6.47 | 4.43 | 4.67 | 5.43 | 4.2 | 4.37 | 5.6 |

| minimax-abab5 | 51.83 | 3.87 | 5.63 | 6.87 | 6.97 | 4.33 | 4.4 | 2.93 | 6.13 | 4.27 | 6.43 |

| Mixtral--8x7B-Instruct | 48.4 | 4.27 | 5.47 | 6.47 | 6.4 | 3.13 | 4.5 | 5.07 | 3.57 | 4.37 | 5.17 |

| ChatGLM2-6B | 39.63 | 2.33 | 3.77 | 5.97 | 6.13 | 2.83 | 3.83 | 2.6 | 3.8 | 4.0 | 4.37 |

| ziya_v1.1-13b | 37.63 | 2.77 | 3.97 | 5.17 | 5.33 | 2.8 | 3.77 | 2.53 | 3.7 | 3.03 | 4.57 |

| InternLM-Chat-7B | 36.27 | 2.63 | 3.67 | 4.87 | 5.57 | 3.17 | 3.33 | 2.33 | 4.03 | 3.13 | 3.53 |

| Linly-Chinese-LLaMA-2-13B-hf | 34.7 | 2.2 | 3.77 | 4.5 | 5.0 | 2.43 | 3.33 | 2.53 | 3.9 | 2.5 | 4.53 |

| BELLE-Llama2-13B-chat-0.4M | 33.97 | 2.57 | 3.07 | 4.93 | 4.73 | 2.83 | 3.8 | 2.43 | 3.33 | 2.4 | 3.87 |

| Llama-2-7b-chat-hf | 23.63 | 1.53 | 3.43 | 3.0 | 3.73 | 1.73 | 2.43 | 1.97 | 2.17 | 0.8 | 2.83 |

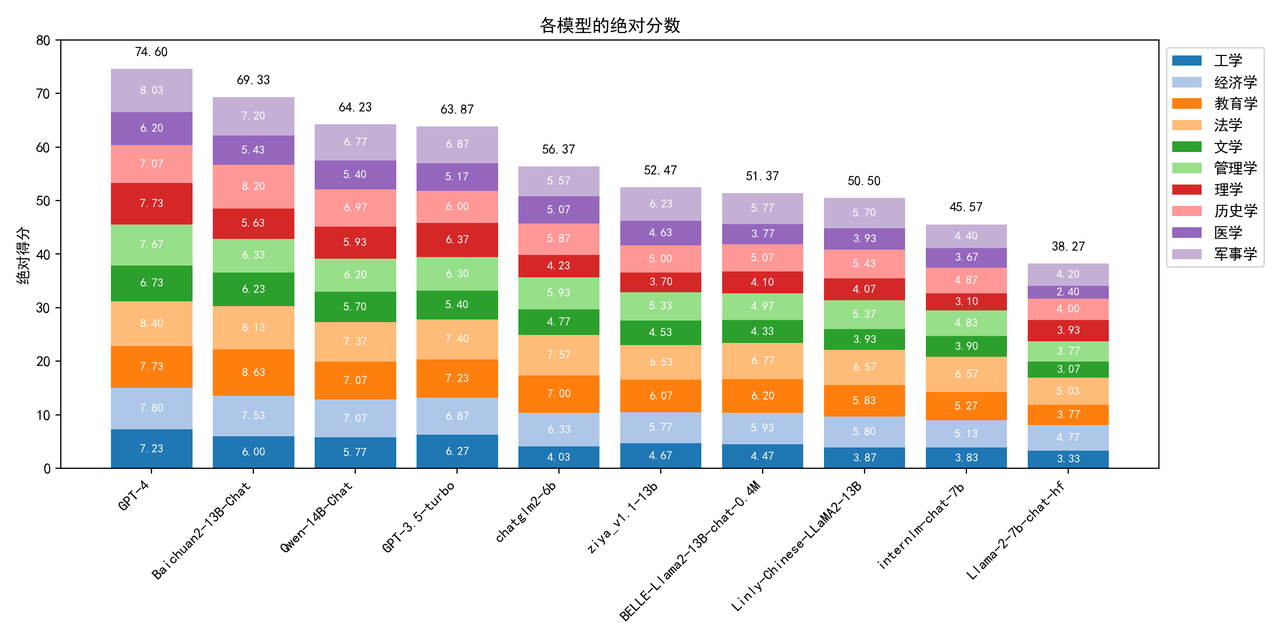

我们基于初次采用gpt4-0613作为评测模型及基准模型的结果进行了系统性分析,模型在各学科上绝对分数的分布如下:

可以看到,在本科程度的知识问答上,即便是GPT-4也只能达到74.60的绝对分数,仍有非常大的提升空间。国内开源模型在最近3个月有大幅度提升,Baichuan2-13B-Chat以及Qwen-14B-Chat都高于GPT-3.5-turbo的效果。由于LLaMA-2-7B-Chat在中文上的训练数量较少,对于中文的问题回答能力较弱。

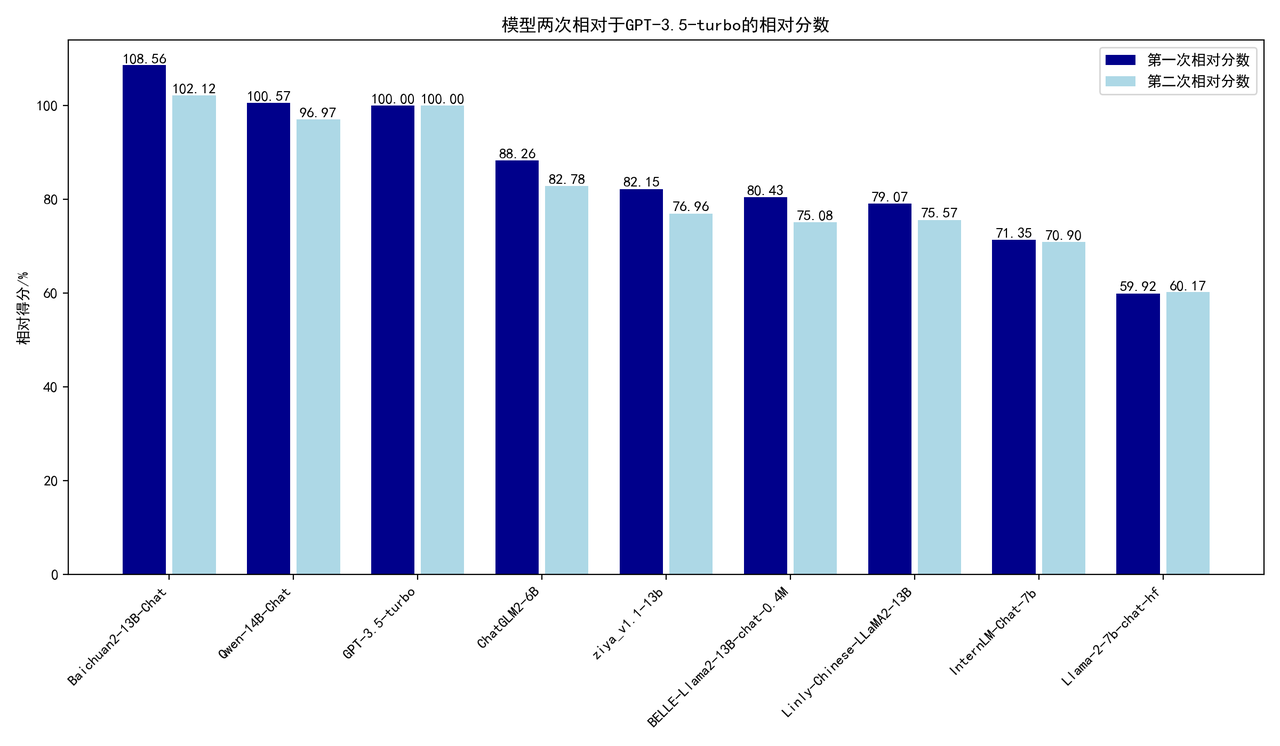

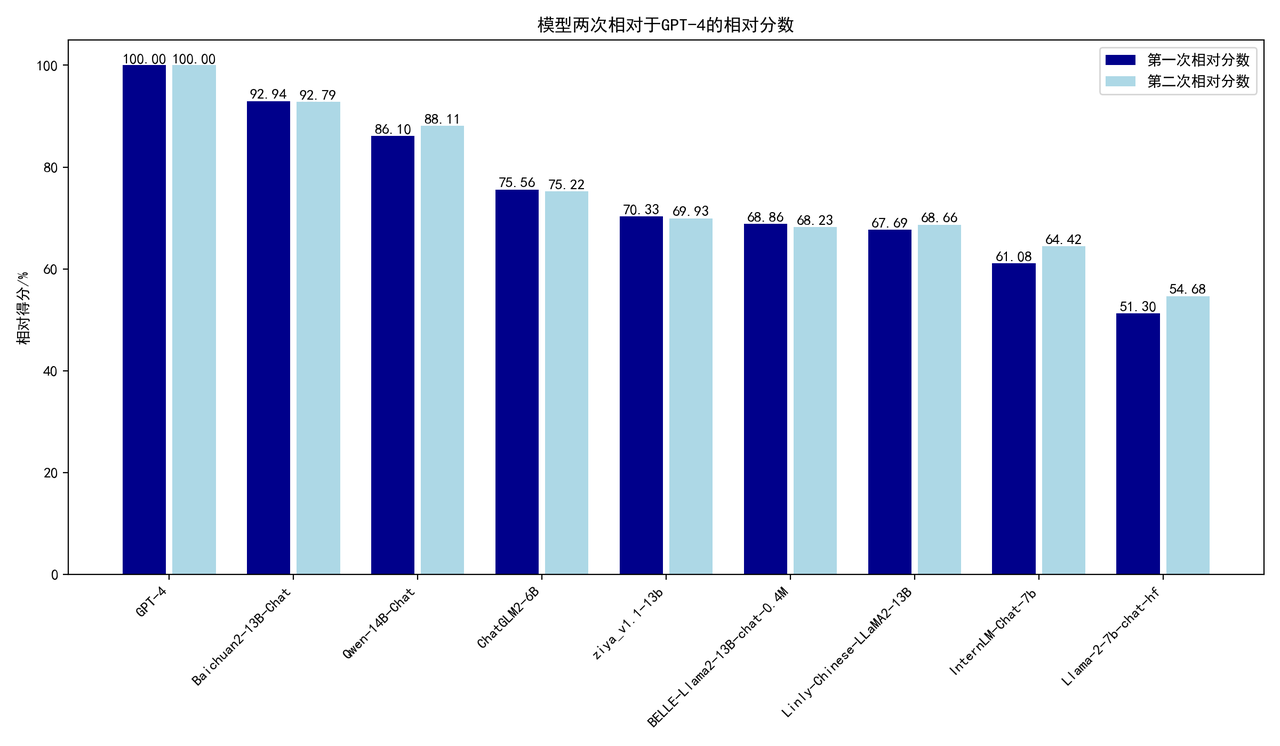

为了验证使用相对分数的可靠性,LLMEVAL-3对现阶段所有评测的模型进行了两次完整的评测流程,对两次抽样评测的结果进行了分析,结果如下:

模型两次相对于GPT-3.5-turbo的相对分数

模型两次相对于GPT-4的相对分数

根据实验结果,可以发现以GPT-4作为计算相对分数的基准模型比GPT-3.5-turbo的稳定性更好,结果更为客观。大部分模型相对GPT-4分数的二次相对偏差小于5%,说明了随机抽样的均匀性与多次抽样之间分布的一致性,相对分数更高的模型两次评测的相对分数偏差越小。相较于直接使用绝对分数来说,采用相对分数可以更有效地减少抽样带来的系统偏差。

本项目已经向公众开放,欢迎参与我们的评测。http://llmeval.com/

机构评测需要进行认证,注册完账户以后,请联系管理员认证并申请评测权限。

如无特殊情况,在评测完成之后,相关结果都会添加在排行榜上。

Email: mingzhang23@m.fudan.edu.cn

Wechat: zanyingluan