Códigos desenvolvidos durante a pesquisa de doutorado para avaliação do programa de combate à dengue.

- Autor: Fernando Xavier

- Orientador: Antonio Mauro Saraiva

- Instituição: Escola Politécnica da Universidade de São Paulo

- Data da Defesa: 01/09/2023

- Texto completo: Link da tese

- Vídeo da defesa: YouTube

- Período: 2015 - 2019

- Região: 645 municípios do estado de São Paulo

- Principais referenciais téoricos: Donabedian, Saúde Planetária

- Linguagem de programação: Python

- Ambiente de desenvolvimento: Google Colab

- Armazenamento: Google Drive, MySQL, PostgreSQL, BigQuery

| Categoria | Fonte | Acesso |

|---|---|---|

| Ações | SUCEN | Restrito |

| Clima | WorldClim | Historical climate data |

| PIB | IBGE | PIB Municípios |

| Investimentos | SIOPS | Municípios/Série Histórica de Indicadores |

| IDHM | IPEA | Bases |

| Casos | DATASUS | SINAN |

| Unidades Básicas de Saúde | DATASUS | Estabelecimentos |

| Infestação | SUCEN | Restrito |

| Profissionais de Saúde | DATASUS | CNES |

| Uso do Solo | MapBiomas | Estatísticas |

| População Urbana | SNIS | Municípios/Informações e indicadores municipais consolidados |

| Água e Esgoto | SNIS | Água e Esgotos/Informações e indicadores agregados |

Analiação dos componentes do modelo de Donabedian de acordo com o contexto.

Painel BI para monitoramento contínuo de indicadores baseados no modelo de Donabedian.

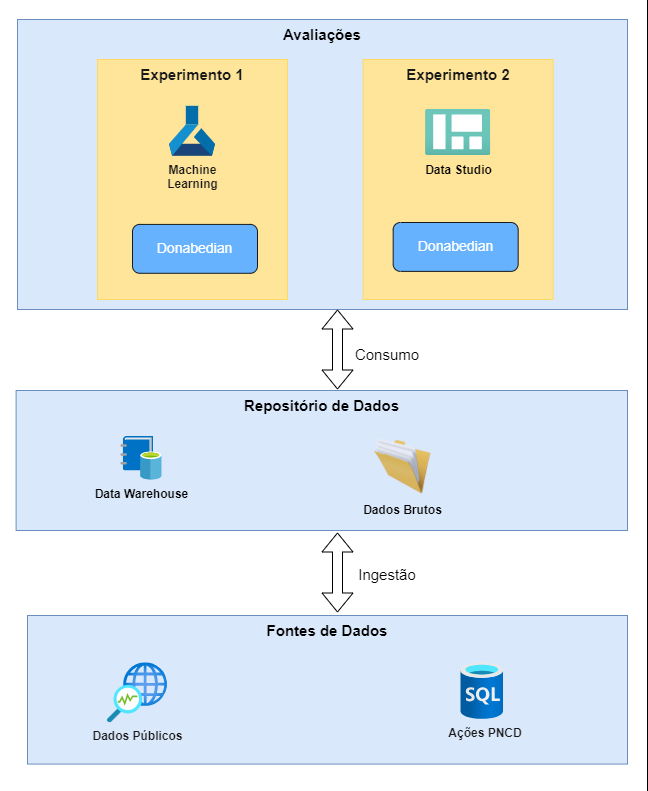

O ciclo de vida dos dados para esta pesquisa foi baseado em um processo ELT (extract-load-transform) que, no contexto de um Data Lake, inverte as etapas de carga e transformação de um tradicional processo de ETL (extract-transform-load). Assim, os dados são armazenados no seu estado original em um Data Lake e transformados de acordo com seus usos.

A coleta foi realizada de fontes de dados públicas e privadas e armazenadas em um repositório. No contexto desta pesquisa, apenas para fins experimentais, o repositório dos dados brutos foi o Google Drive. Em seguida, já na etapa de transformação, os dados foram agregados em indicadores e armazenados em um Data Warehouse, para o qual foi utilizado o ambiente Google BigQuery.

Por fim, os dados foram consumidos pelos dois experimentos descritos anteriormente, com utilização de scripts Python (no Experimento 1) e da ferramenta Google Looker (para o Experimento 2). Para mais detalhes do processo, consultar a tese.

- Suba os arquivos desejados com a mesma estrutura de pastas (caso contrário, lembre-se de ajustar referências, caso necessário)

- Faça uma cópia do arquivo .env-template e renomeie-o como .env, indicando os valores das variáveis para o seu ambiente

- Crie um arquivo chamado caminho_env.txt na raiz do Google Drive e aponte para o caminho do arquivo .env criado

- Suba os arquivos desejados com a mesma estrutura de pastas (caso contrário, lembre-se de ajustar referências, caso necessário)

- Faça uma cópia do arquivo .env-template e renomeie-o como .env, indicando os valores das variáveis para o seu ambiente

- Crie um arquivo chamado caminho_env.txt na raiz do projeto e aponte para o caminho do arquivo .env criado

- Lembrar de remover as referências de conexão para o Google Drive