此存储库旨在通过整和开源工具,降低在本地运行生成式模型的复杂度,同时提高可用性。

-

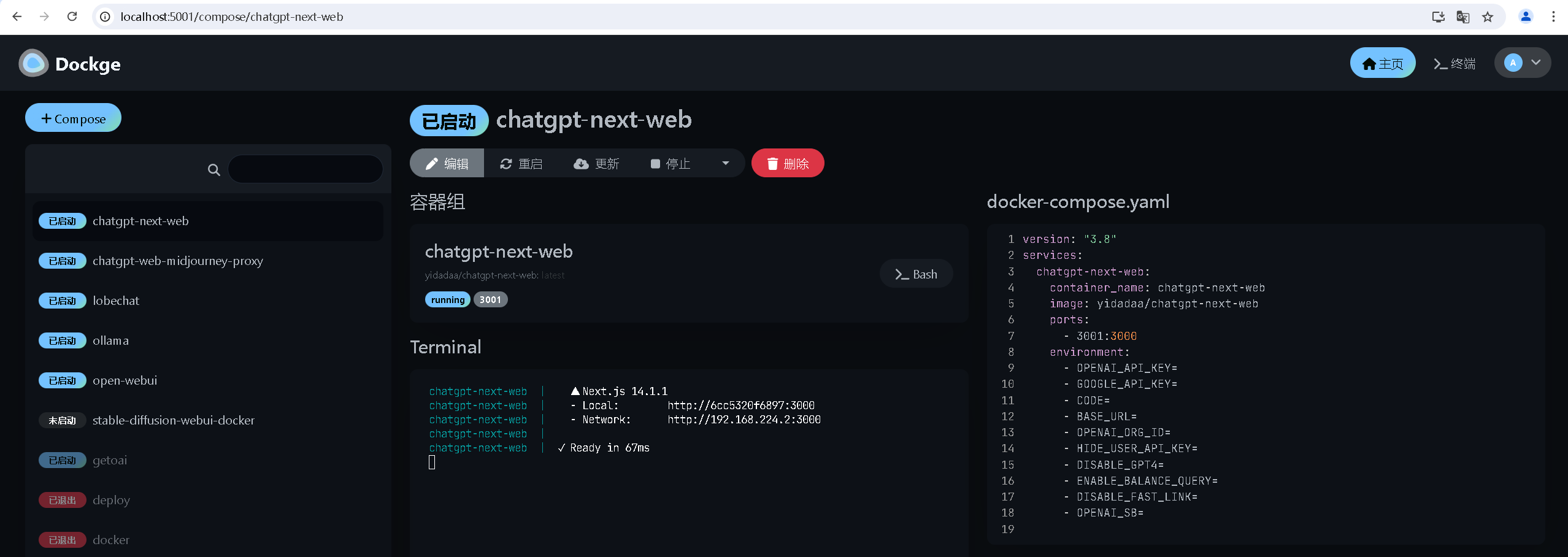

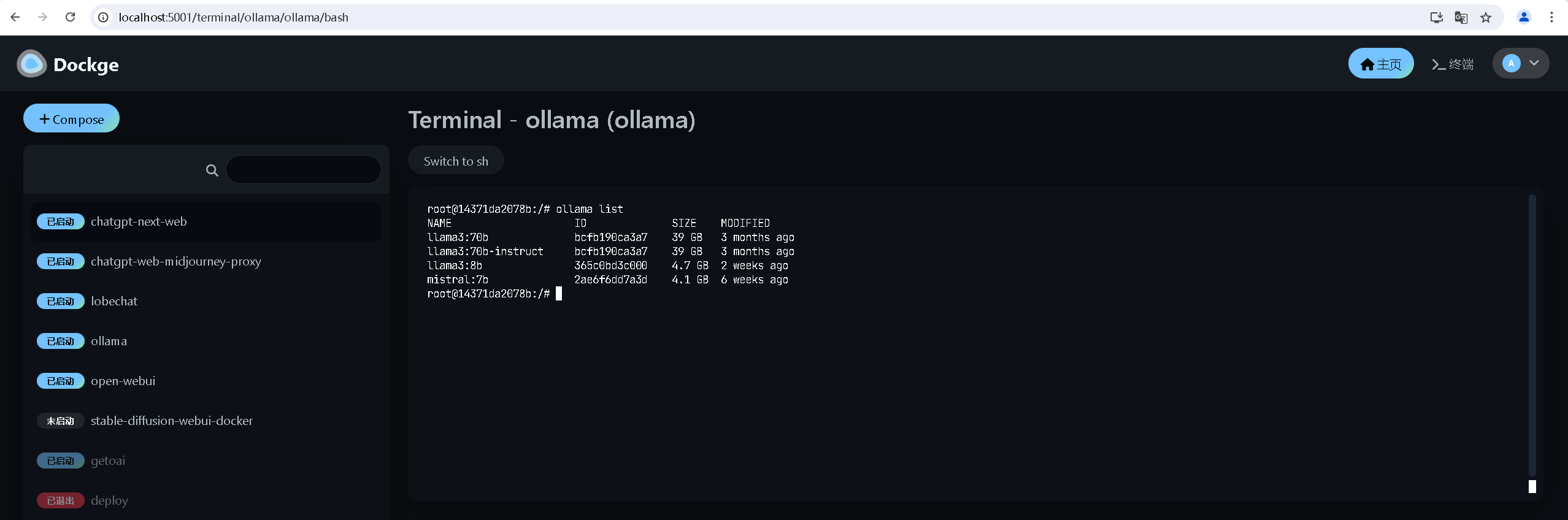

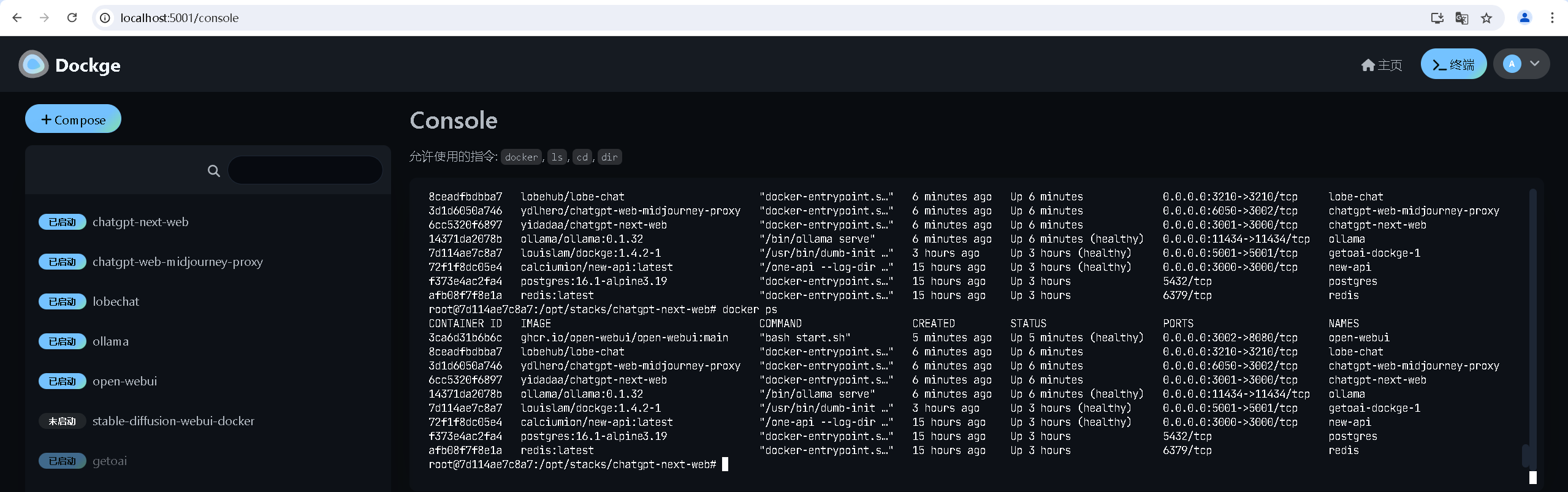

使用 Dockge、Helm Dashboard 等可视化工具管理本地和远程工作负载。

-

使用 Ollama、stable-diffusion-webui-docker、midjourney-proxy 等模型管理和 Api 代理工具。

-

ChatUI 和模型 Api 服务,预置到 Dockge 中纳管,用户只需通过 WebUI 即可管理绝大部分服务,实现开箱即用。

理论上 Windows、Linux、MacOS 都支持。

x86 和 ARM 也基本支持。

目前仅测试过 Nvidia GPU(NVIDIA GeForce RTX 2080 Ti) 和 CPU。

AMD、Apple、Intel 等 GPU 未进行过测试,兼容性请以对应模型工具为准。

Windows 下 Docker Desktop 容器性能损耗严重,尤其是大型模型加载期间。

如对性能有严格要求,建议使用 Linux 环境,将其添加为 Dockge 代理,即可通过 Dockge 管理。

或者使用非容器化方式运行,这不在仓库支持范围,但是依然可以使用提供的 New-api 管理 api 部分。

| 支持 | 模型工具 | New-api | Dockge | Helm Dashboard |

|---|---|---|---|---|

| ✔️ | Ollama | ✔️ | ✔️ | ✖️ |

| ✔️ | stable-diffusion-webui-docker | ✔️ | ✔️ | ✖️ |

| ✔️ | midjourney-proxy | ✔️ | ✔️ | ✖️ |

| 支持 | ChatUI | New-api | Dockge | Helm Dashboard |

|---|---|---|---|---|

| ✔️ | chatgpt-next-web | ✔️ | ✔️ | ✖️ |

| ✔️ | chatgpt-web-midjourney-proxy | ✔️ | ✔️ | ✖️ |

| ✔️ | lobechat | ✔️ | ✔️ | ✖️ |

-

GPU(可以使用 CPU,但是会非常慢)

-

可访镜像仓库

-

可访问模型仓库,部分服务初始化会下载文件或模型

克隆本存储库,克隆完成后,进入文件夹

cd getoai

复制一份配置文件

cp .env.example .env

修改 .env 文件

# ⚠️ Stacks directory (MUST)

# FULL path only. No relative path (MUST)

# Git_DIR + volumes\dockge\opt\stacks

# eg: D:\getoai\volumes\dockge\opt\stacks

OPT_STACKS_DIR=D:\getoai\volumes\dockge\opt\stacks

启动服务

docker-compose up -d

访问服务,设置管理员密码

-

dockge:http://localhost:5001

-

new-api:http://localhost:3000 (初始管理员 admin/admin)

可通过 Dockge 创建 模型和 ChatUI 工作负载,通过 New-api 管理 Api 。

Dockge 页面图片