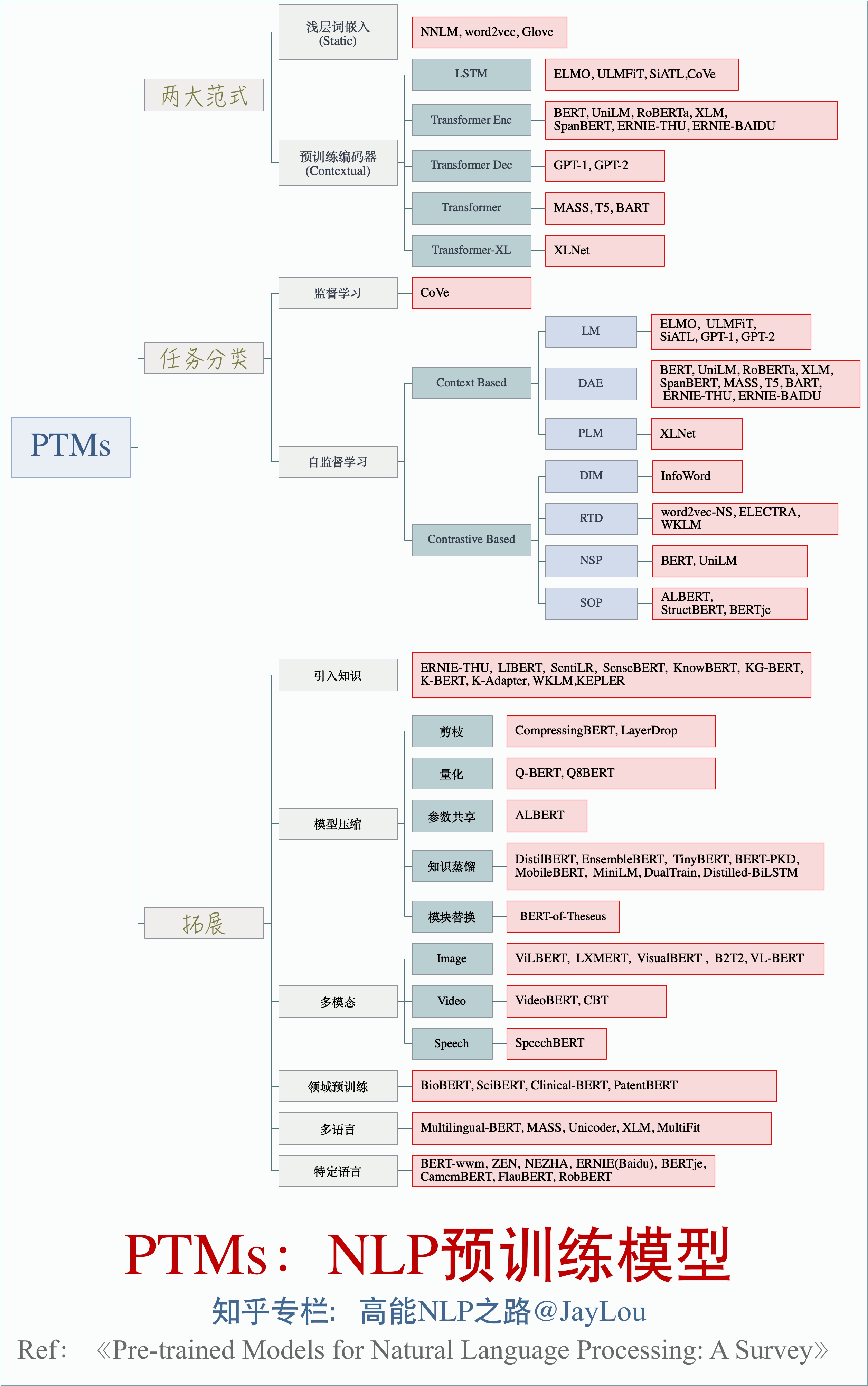

PTMs: Pre-trained-Models in NLP

NLP预训练模型的全面总结(持续更新中)

置顶

知乎文章1: 全面总结!PTMs:NLP预训练模型 ➡️➡️ 图片下载

知乎文章2:nlp中的预训练语言模型总结

知乎文章3:nlp中的词向量对比

1、论文汇总:

PTMs-Papers:

- https://github.com/thunlp/PLMpapers

- https://github.com/tomohideshibata/BERT-related-papers

- https://github.com/cedrickchee/awesome-bert-nlp

- https://bertlang.unibocconi.it/

- https://github.com/jessevig/bertviz

2. PTMs单模型解读

- 自监督学习:Self-Supervised Learning 入门介绍

- 自监督学习:Self-supervised Learning 再次入门

- 词向量总结:nlp中的词向量对比:word2vec/glove/fastText/elmo/GPT/bert

- 词向量总结:从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史

- ELMo解读:关于ELMo的若干问题整理记录

- BERT解读: Bert时代的创新:Bert应用模式比较及其它

- XLNET解读:XLNet:运行机制及和Bert的异同比较

- XLNET解读:XLnet:比Bert更强大的预训练模型

- RoBERTa解读:RoBERT: 没错,我就是能更强——更大数据规模和仔细调参下的最优BERT

- 预训练语言模型总结:nlp中的预训练语言模型总结(单向模型、BERT系列模型、XLNet)

- 预训练语言模型总结:8篇论文梳理BERT相关模型进展与反思

- ELECTRA解读: ELECTRA: 超越BERT, 19年最佳NLP预训练模型

- 模型压缩 LayerDrop:结构剪枝:要个4层的BERT有多难?

- 模型压缩 BERT-of-Theseus:bert-of-theseus,一个非常亲民的bert压缩方法

- 模型压缩 TinyBERT:比 Bert 体积更小速度更快的 TinyBERT

- 模型压缩总结:BERT 瘦身之路:Distillation,Quantization,Pruning

(持续更新中...)