人生苦短, 我用Python!

| Bilibili | 豆瓣 | 优酷 | Pixiv |

| 网易云 | 微博 | 知乎 | 百度 |

| 微软 | 其他 |

- [Usage]:

python danmu.py $url - [Example]:

python danmu.py https://www.bilibili.com/video/av9933492/

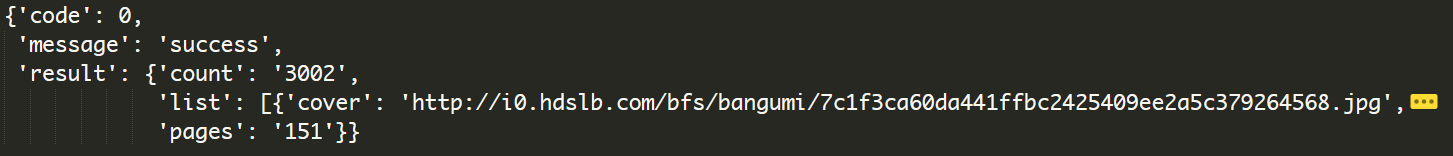

需要传递的参数及说明如下所示, 由于 tag_id 的可选项太多, 暂时没有考虑

data = {

'page':1, # 第几页

'page_size':20, # 每页的数量

'version':0, # 类型: 全部 正片 剧场版 其他 [0 - 4]

'is_finish':0, # 状态: 全部 完结 连载 [0 2 1]

'start_year':0, # 时间: 全部 某一年 [0 xxxx]

'tag_id':'', # 风格

'index_type':1, # 排序方式: 更新时间 追番人数 开播时间 [0 - 2]

'index_sort':0, # 排序类型: 递减 递增 [0 - 1]

'area':0, # 地区: 全部 日本 美国 其他 [0 2 3 4]

'quarter':0 # 季度: 全部 1月 4月 7月 10月 [0 - 4]

}

- [Usage]:

python bangumi_index.py [-t <type> | -a <area> | -e <state> | -m <time> | -s <season> |--tag <style> | --index_type <index_type> | --index_sort <index_sort>] - 返回的

Json文件

list中一项

- 网易云获取歌曲

API为http://music.163.com/song/media/outer/url?id={song_id}.mp3 - 只需要传入对应歌曲的

song_id即可

- 使用前需要更新问题

id, 填入Cookie,include应该不需要更新

- 返回未验证方式是因为没有给headers传递

X-API-VERSION,X-UDID,authorization等参数 - 问题来自知乎一位朋友问我, 因此做的比较粗糙, 没有详细提取数据, 仅将答主提取出来

- 得到的一些答主 数据

- [Usage]:

python danmu.py $pid - [Example]:

python getTiebaPics.py 2271504759

- [Usage]:

python3 getBaiduPics.py [Word] [pages = 1] - [Example]:

python3 getBaiduPics.py 猫 30 - 注: 图片将保存在关键词的同名目录下。

爬取煎蛋网妹子图

- 有时间将爬取专辑的函数加上