w10scan是一款全自动搜索互联网漏洞的工具。利用搜索到的url或全自动的超级爬虫获取大量链接,使用定向插件获得漏洞。这一切都是全自动的,用户只需要在web界面上增加插件,设置参数,查看结果。分布式 任务下发模式

受到Autosploit的启发,一款自动漏洞搜寻工具,但是利用方式和Autosploit大不一样,Autosploit基于metasploit与shodan结合。但w10scan使用自己的w10scan超级爬虫,对网站进行深度优先级爬行,一直递归重复获取更多网址,当然,w10scan的超级爬虫可以指定获取的域名方式以及关键字方式。漏洞利用使用w9scan的改良版本,通过一些特定漏洞以及CMS对应漏洞结合的方式获取情报信息。

写此工具的目的仅是为了好玩,获取的什么情报,资产也是为了好玩。我也很想开源展示效果,但是由于我国法律不允许,可能仅开源部分代码,此github也是仅在无聊的时候记录日志。

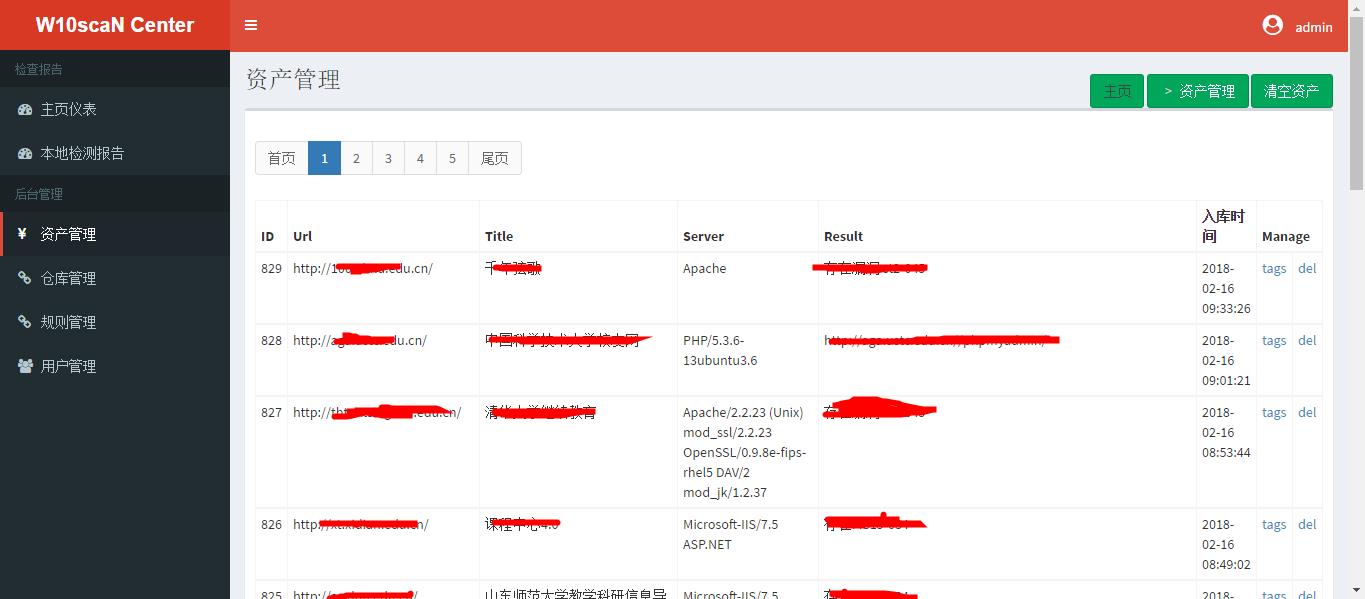

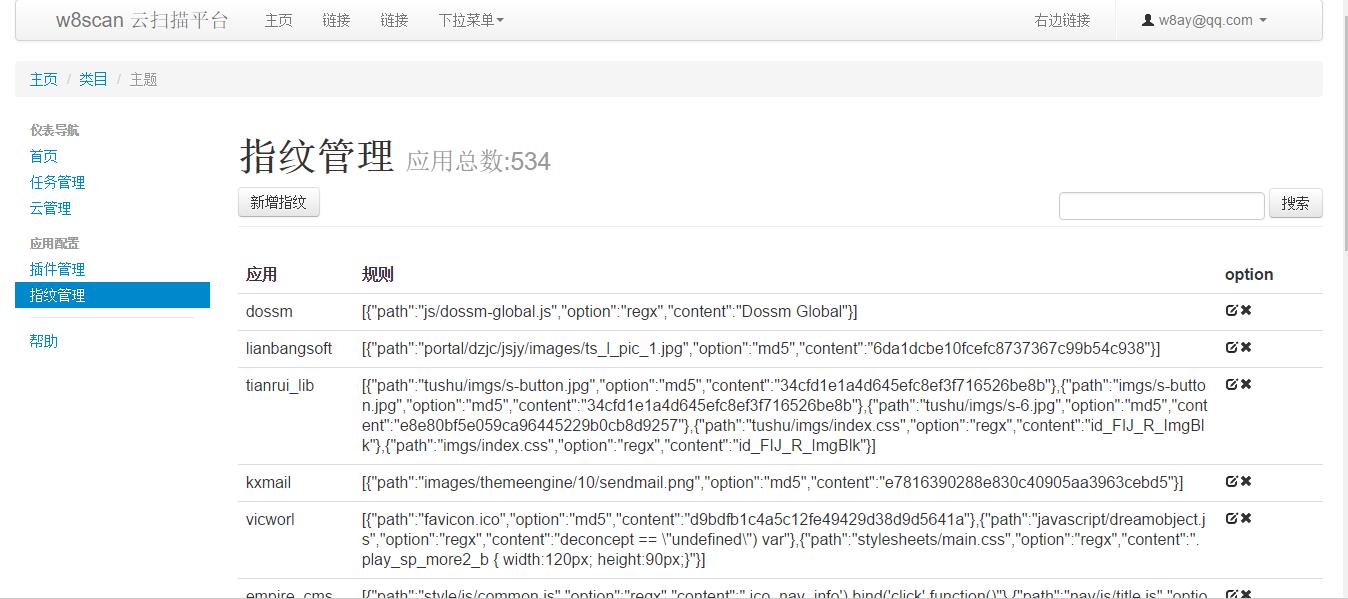

Po个demo图:

与w8scan的指纹平台和插件平台联动,w10scan的插件指纹平台就不自己写了,直接调用w8scan平台的数据。

- 2018-6-25 一个新的想法

- 架构为一个网页端多个客户端,分布式扫描

- 网页端下发域名和IP

- 自动收集域名扫描,暴露出公共的接口,可以让其他软件调用该接口扫描。

- 客户端扫描以下

- 扫描域名

- 识别脚本语言,若为php则增加识别版本

- 识别server

- 识别waf?有,入库,扫描完毕,无?继续扫描,传入ip,检测IP是否已扫描,未扫描则启动“扫描IP”服务。

- git svn扫描

- 备份文件扫描

- 目录扫描

- 常见文件扫描

- cms扫描

- 扫描IP

- 开放端口扫描 + 分析指纹

- 开放端口弱口令扫描

- 扫描域名

- 细节

- 字典优化:目录扫描,字典扫描增加计数字段dict_count用于计数,当我们的关键词命中时,对应的dict_count+1,每次使用字典时候,通过order by dict_count desc提权关键词,生成关键词命中次数降序的字典。文件扫描,cms指纹同理。

- 架构为一个网页端多个客户端,分布式扫描

- 2018-4-2 扫描流程加入CMS识别 + 自动漏洞利用,IP端口分析调用nmap。waf信息,IP端口信息,CMS信息都将入库,统计图表展示。漏洞信息,发现的漏洞类型也分类,统计成图表。虽然目前整个系统看起来没什么作用,但感觉还是很高大上的~

- 2018-3-4 目前完整的扫描流程已经确定:

1. 大批量信息收集,资产信息:IP,子域名

2. 过滤不能访问的和有waf的

3. Fuzz批量测试

4. 爬虫爬取相关链接

5. SQL注入,XSS批量测试

批量的SQL注入已经初显成效,但还需要优化,用的普通取文本md5判断注入,准备看看SQLMAP中检测注入是如何进行的。 - 2018-2-22 第一批加入的3w网址扫完了,得出了300+漏洞信息,本来想着改改线程池重写的,现在觉得没必要,服务器宽带在那还能怎么优化呢。现在主要就是想加各种插件,调用sqlmapapi云云之类的。最近三个项目

w8scanw9scanw10scan一起开工,这个写累了就跑那个,很有趣! - 大年初三:测试版没有崩溃了,但是速度太慢了,一晚上才跑7000+网址,准备重写线程池在跑

- 大年初一:之前的demo版在腾讯云的小水管上跑了一晚上扫了1w+网址,得出了500多个漏洞信息,现在的改良版却扫个千把链接就崩溃了,很无奈。还有半个小时就大年初二,给最终版本喂了8000 URL,扫扫看吧。之前不觉得问题,现在觉得1M的小水管扫太慢了,线程50都Hold不住嘛??