- 因子图部分链接尚未补充完全TODO List

-

因子图部分超链接

-

强化学习部分目录结构调整

-

机器学习其他待苏然添加

《Bishop Pattern Recognition and Machine Learning》 by Christopher M. Bishop

《PRML:模式识别与机器学习(中文版)》 by 马春鹏

《Deep Learning》 by Ian Goodfellow, Yoshua Bengio, Aaron Courville

《深度学习-中文》 by Ian Goodfellow, Yoshua Bengio, Aaron Courville Git Hub开源翻译

《神经网络与深度学习》 by 邱锡鹏

《Reinforcement Learning: An Inroduction》 by Richard S. Sutton, Andrew G. Barto [website]

简短翻译版-强化学习导论.pdf 来自 网友

《Algorithms for Reinforcement Learning》 by Csaba Szepesv´ari

《A Concise Introduction to Decentrakuzed POMDPs》 by Oliehoed, Amato

基于SMAC的PYMARL平台 GitHub 地址https://github.com/oxwhirl/pymarl

百度PaddlePaddle工程师实训教程--视频https://www.bilibili.com/video/BV1yv411i7xd

Baidu AI-Studio课程

项目代码PRAL GitHub

POMDPs介绍--Pages

Deep Reinforcement Learning: An Overview

Multi-agent reinforcement learning: An overview. Buşoniu L, Babuška R, De Schutter B.

An overview of recent progress in the study of distributed multi-agent coordination. Cao Y, Yu W, Ren W, et al.

- Q-Learning--Q-learning

- DQN----Human-level Control Through Deep Reinforcement Learning

- VDN----Value-Decomposition Networks For Cooperative

- DRQN---Deep Recurrent Q-Learning for Partially Observable MDPs

- QMIX---Monotonic Value Function Factorisation for Deep Multi-Agent Reinforcement Learning

- ROMA---Multi-Agent Reinforcement Learning with Emergent Roles

- COMA----Counterfactual Multi-Agent Policy Gradients

- IQL-----Independent Q-Learning

- QTRAN---Learning to Factorize with Transformation for Cooperative Multi-Agent Reinforcement Learning

-

智能体、环境、策略、奖励、状态转移概念

-

马尔可夫决策过程(MDP)、部分可观测马尔可夫决策过程(POMDP)、分布式部分马尔可夫决策过程(Dec-POMDP)

-

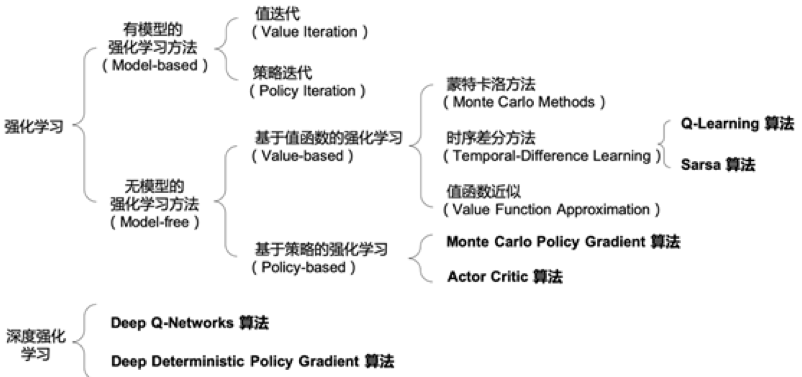

强化学习算法分类

- Model-Free和Model-Based

- Policy-Based和Value-Based

- On-Policy和Off-Policy

- 对比及介绍:https://www.cnblogs.com/liuxgblog/p/14698204.html

-

强化学习算法测试环境

Gym

安装及使用:openAI Gym介绍.pptx openai gym.docx

MPE

安装及使用:https://github.com/openai/multiagent-particle-envs

星际争霸

-

动态规划算法

-

蒙特卡罗算法

-

时序差分学习方法

Sarsa 和Q-learning:https://zhuanlan.zhihu.com/p/46850008

-

策略梯度

特点:处理连续动作和随机策略

介绍:Policy Gradient Methods for Reinforcement Learning with Function Approximation

-

Reinforce算法

-

带基线的Reinforce算法

特点:减少方差

-

Actor-Critic算法

特点:使用Q函数减少方差

介绍:Policy Gradient Methods for Reinforcement Learning with Function Approximation

-

A2C

特点:使用优势函数减少方差

-

A3C

特点:多线程

介绍:Asynchronous Methods for Deep Reinforcement Learning.

以上三节参考:强化学习value-based&policy-based.pptx

-

DQN

-

Nature DQN

-

Double DQN (DDQN)

-

Dueling DQN

介绍:Dueling Network Architectures for Deep Reinforcement Learning

DQN及其变体介绍:https://zhuanlan.zhihu.com/p/106411995

-

DPG

-

DDPG

-

MADDPG

介绍:multi-agent actor-critic for mixed cooperative-competitive environments

-

多智能体协作

PRIMAL: Pathfinding via Reinforcement and Imitation Multi-Agent Learning

CM3:cooperative_multi_goal_multi_stage_multi_agent_reinforcement_learning

-

信用分配

Counterfactual multi-agent policy gradients

Force-Based Algorithm for Motion Planning of Large Agent

NIPS-2003-all-learning-is-local-multi-agent-learning-in-global-reward-games-Paper

Sequential Q-Learning With Kalman Filtering for Multirobot Cooperative Transportation

| 相关网页 |

|---|

| 概率图的推断——变量消除、信念传播、因子图、道德图、联结树 |

| 以一个例子讲述因子图为何以及如何进行计算。 |

| 因子图与和积算法简介(CSDN) |

| 出自论文factor graph and sum-product algorithm |

| 因子图与和积算法简介(知乎) |

| 出自论文factor graph and sum-product algorithm与上一个链接内容相比,对因子图定义的形式化描述更多。 |

| 相关论文 |

|---|

| An introduction to factor graph |

| 本文讲述因子图的发展过程,并给出两种形式的因子图:标准形式、Forney形式。 介绍了LDPC码、卡尔曼滤波等应用与因子图上的例子。 |

| 因子图与和积算法简介(CSDN) |

| 出自论文factor graph and sum-product algorithm。 |

| 因子图与和积算法简介(知乎) |

| 出自论文factor graph and sum-product algorithm。与上一个链接内容相比,对因子图定义的形式化描述更多。 |

| SRTP因子图项目报告 |

|---|

| 课题名为:“实现信息融合的因子图可视化设计”。描述了因子图定义以及各种算法,并进行仿真实验设计 |

| Max-product for maximum weight matching Convergence correctness and LP duality |

| 本文介绍最大积算法并证明其在循环图中的正确性和收敛性 |

| Message-passing algorithms for inference |

| 本文描述了一系列信念传播算法,包括最小和算法、基于自由能的BP算法、“tree-reweighted"BP算法等。 |

| Understanding Belief Propogation |

| Loopy belief propagation based data association for extended target tracking |

| 本文提出一种多扩展目标跟踪数据关联的图形模型公式,并且可以通过循环信念传播来求解 |

| Metacademy课程:循环信念传播与变分推理 |

| metacademy是一个网站,其可以看作机器学习和人工智能的知识图谱 |

| [word文档]LBP论文笔记 |

| 简单介绍了LBP算法,并简单推导了Loopy belief propagation based data association for extended target tracking中的部分因子图 |

| 因子图与和积算法-matlab代码实现 |

| 此文档先对因子图与和计算法进行讲解,其出自An introduction to factor graph。文档基于因子图给出奇偶校验、马尔可夫链、卡尔曼滤波的matlab实现 |

| Julia中文社区 |

| Julia的package查询网站 |

| 可查询Julia支持的所有第三方package,并且可以查询其版本更新情况与package间依赖关系 |

| Julia中镜像站的使用 |

| 教授如何在Julia中用**镜像源进行package下载 |

| [论文]julia in machine learning |

| 本文简单介绍了Julia语言,并于传统的python、matlab进行比较 |

| [word文档]Julia安装流程 |

| 对网上的安装流程做出总结,给出了几个可行的安装方法 |

| forneylab的简单demo |

| forneylab在github上的开源地址 |

| [论文]A factor graph approach to automated design of Bayesian |

| 本文介绍其开发的ForneyLab工具箱 |

| [论文]A message passing approach for multiple maneuvering target tracking |

| 本文提出一种BP与MF结合的消息传递算法。用BP解决硬约束问题、用MF得到复杂模型下的消息传递更新 |

| [论文]Merging Belief Propagation and the Mean Field Approximation: A Free Energy Approach |

| 本文展示如何在与BP对应的因子图中包含硬约束 |

| [论文]Sequential Particle-Based Sum-Product Algorithm for Distributed Inference in Wireless Sensor Networks |

| 本文提出一种基于粒子的和积算法并且降低其复杂度为线性的 |

| [论文]Understanding and Accelerating Particle-Based Variational Inference |

| [ppt文档]Understanding and Accelerating Particle-Based Variational Inference的讲解 |

| [论文]Nonparametric belief propagation |

| 本文提出一种基于因子图上和积算法规则的粒子滤波算法 |

| [论文]Nonparametric belief propagation for self-localization of sensor networks |

| 本文将NBP算法用于协同网络上的多目标定位 |

| [论文]A comparison of parametric and sample-based message representation in cooperative localization |

| 本文提出了基于无线网络上的和积算法实现 |

| [论文]Cooperative localization using posterior linearization belief propagation |

| 本文提出一种无线网络协同定位中的后验线性化信念传播算法:PLBP |

| [论文]A comparison of parametric and sample-based message representation in cooperative localization |

| 本文提出了一种基于因子图的TOA定位算法 |

| [rar文件]PLBP算法的代码实现? |